|

|

Edito

Avons-nous conscience des conséquences du libre accès des jeunes enfants aux écrans ?

Depuis quelques mois, plusieurs études scientifiques sérieuses sont venues révéler de manière concordante les conséquences physiologiques, psychiques et relationnelles, jusqu’alors sous estimées, d’une exposition des jeunes enfants et adolescents aux nombreux écrans qui peuplent leur environnement.

Une étude publiée dans la revue scientifique Nature en mai 2017 a montré que les tout-petits (de 6 à 36 mois) exposés aux écrans en fin de journée ont une durée de sommeil sensiblement réduite, à cause de la lumière bleue émise par les smartphones et tablettes. Celle-ci perturbe la synthèse de mélatonine, une hormone-clé dans le déclenchement du sommeil (Voir Nature).

L'excès d'exposition aux écrans aurait également des effets néfastes sur la vue des adolescents : 48 % de ceux qui passent plus de huit heures par jour sur un écran développeraient une « myopie fonctionnelle » (déficit d'accommodation à la vue de loin). La Fédération française de cardiologie pousse pour sa part un cri d’alarme sur les ravages à terme de la sédentarité liée aux écrans. Elle souligne que moins du quart des 6-17 ans atteignent les 60 minutes d’activité physique quotidienne recommandées par l’OMS, avec à la clé une forte augmentation des adolescents en surpoids et une hausse sensible des risques de diabète et de maladies cardiovasculaires à l’âge adulte.

David Thivel, membre du conseil scientifique de l’Observatoire national de l’activité physique et de la sédentarité (Onaps), confirme cette évolution préoccupante et souligne que la surconsommation d’écrans chez les jeunes favorise une consommation excessive d’aliments à densité énergétique élevée et réduit le temps de sommeil, ce qui induit un état de fatigue chronique que connaissent bien et constatent nombre d’enseignants…

Il y a quelques jours, une étude de l’Université du Colorado à Boulder a par ailleurs montré que les enfants d'âge préscolaire exposés à la lumière durant la nuit n'ont pratiquement plus de mélatonine. Ces travaux montrent en effet qu’une seule heure d’exposition à la lumière avant l’heure du coucher diminue considérablement les niveaux d'hormone du sommeil (Voir The Physiological Society).

Dans cette étude, les chercheurs ont prélevé régulièrement des échantillons de salive sur dix enfants pour mesurer leur taux de mélatonine. Après avoir passé pendant une semaine la journée dans un environnement de faible luminosité, les enfants ont été invités à jouer avec des carreaux magnétiques sur une table lumineuse durant une heure. A l’issue de ce temps de jeu, ces chercheurs ont à nouveau mesuré les niveaux de mélatonine, pour les comparer à ceux pris la nuit précédente. Ils ont ainsi pu constater que les niveaux de cette hormone avaient diminué de 88 % après l'exposition des enfants à la lumière vive ; ces travaux ont par ailleurs montré que ces niveaux très réduits de mélatonine persistaient plus d’une heure après l'extinction de la lumière ; ce qui confirme l’hypothèse d’un important retard d’endormissement provoqué par l’exposition nocturne aux écrans.

Cette étude rappelle enfin que la mélatonine n’intervient pas seulement pour réguler le sommeil, mais joue également un rôle important dans d'autres processus métaboliques, comme la régulation de la température corporelle, de la pression sanguine, ou encore le cycle du glucose, une raison supplémentaire, selon ces chercheurs, d’éviter l’exposition à la lumière chez les jeunes enfants, et de supprimer les écrans numériques, juste avant le coucher.

Outre les effets délétères sur la santé, de plus en plus de professionnels s'inquiètent des retards de langage ou troubles du comportement associés à une exposition précoce et excessive aux écrans. D'après une étude de l'Université de Toronto publiée en mai 2017, plus un enfant passe de temps devant un écran, plus il a de retard dans l'apprentissage du langage.

Dans cette étude dirigée par Catherine Birken et réalisée sur des enfants âgés de 6 mois à 2 ans et suivis entre 2011 et 2015, les chercheurs ont suivi 894 binômes parents-enfants dans lesquels ces derniers étaient âgés de six mois à deux ans. Les parents de 20 % des bébés laissaient ces derniers devant un écran pendant environ 30 minutes mais 69 % des sujets n’étaient pas du tout exposés à une tablette ou à un smartphone.

Chez les plus petits, chaque demi-heure passée passivement devant un écran entraînerait une augmentation de 49 % du risque de retard dans l’apprentissage du langage. Ces travaux ont conduit les pédiatres canadiens à recommander aux parents de ne pas exposer les enfants de moins de trois ans à un smartphone ou à une tablette. Ces recherches sont corroborées par ceux de la chercheuse Linda Pagani, réalisés à partir d’une cohorte d’enfants nés en 1997. Ces recherches montrent en effet que les bébés les plus exposés aux écrans, à l’âge de deux ans et demi, deviennent à cinq ans « moins aptes aux mathématiques et la lecture, moins persévérants et moins habiles socialement ».

Selon Michel Desmurget, chercheur en neurosciences, « La frénésie numérique actuelle affecte négativement les résultats scolaires, le langage, la concentration et le goût de l'effort ». Ce spécialiste rappelle qu’à quatre ans, un enfant sans télévision et évoluant dans une famille favorisée aura partagé 45 millions de mots avec ses proches. Mais si le même enfant regarde régulièrement la télévision, ce nombre diminue de 40 % et tombe alors au même niveau que s’il avait été élevé dans une famille défavorisée…

Ces différents travaux et études ont conduit les professionnels de la santé et de la petite enfance à publier récemment une Tribune remarquée dans le journal « Le Monde », dans laquelle ils alertent l’opinion publique des graves effets d’une exposition massive et précoce des bébés et des jeunes enfants aux différents écrans : smartphone, tablette, ordinateur, console, télévision.

Dans ce texte, plusieurs éminents spécialistes et chercheurs, parmi lesquels Sabine Duflo, psychologue, Sylvie Dieu-Osika, pédiatre à l’hôpital Jean Verdier de Bondy, Eric Osika, pédiatre à l’hôpital Ste Camille de Bry-sur-Marne ; Anne Lefebvre, psychologue clinicienne en pédopsychiatrie, Christian Zix, neuropédiatre, directeur médical du CAMSP de St-Avold (Moselle) et Lise Barthélémy, pédopsychiatre à Montpellier, s’interrogent sur l’impact neurocérébral et psychologique d’une surexposition des tout petits aux écrans.

Ces spécialistes soulignent qu’ils voient de plus en plus en consultations de jeunes enfants stimulés principalement par les écrans, qui, à 3 ans, ne les regardent pas quand ils s’adressent à eux, ne communiquent pas, et sont très agités ou, au contraire très passifs. Mais ces médecins et chercheurs évoquent également l’observation de troubles encore plus graves chez certains enfants surexposés aux écrans, troubles qui seraient proches de ceux caractérisant certaines formes d’autisme : absence de langage, troubles de l’attention, incapacité d’orienter son regard vers l’adulte.

Leur hypothèse pour expliquer ces phénomènes inquiétants est que l’omniprésence des écrans vient casser le lien relationnel et affectif qui se construit normalement entre le bébé et ses parents. Trop soumis aux écrans, il semblerait que certains enfants ne parviennent plus à développer l’ensemble des liens sensoriels, affectifs et cognitifs, impliquant les regards, les gestes et la voix, qui sont nécessaires pour construire harmonieusement leur autonomie et leurs échanges symboliques avec les adultes.

Heureusement, cette situation semble réversible et les signataires de cette tribune insistent sur le fait que lorsque ces enfants retrouvent un bas niveau d’exposition aux écrans, leur appétence pour le jeu et la communication verbale revient, ainsi que leur curiosité pour leur environnement.

Pour prévenir ces troubles et retards du développement chez les bébés et les jeunes enfants, ces spécialistes souhaitent que des campagnes nationales d’information, conçues en toute indépendance des puissants groupes de l’industrie numérique, soient menées et diffusées, avec le soutien des pouvoirs publics, de la communauté médicale et des familles dans tous les lieux de la petite enfance ; ils préconisent également que des recherches indépendantes soient menées pour mieux comprendre et évaluer les nombreux effets neurocérébraux, psychologiques, affectifs et cognitifs de l’exposition aux écrans des tous petits.

Dans un remarquable petit essai intitulé « Du livre et des écrans », le psychanalyste Serge Tisseron, qui travaille depuis de nombreuses années sur les effets de l’image, de la mutation numérique et de la réalité virtuelle sur les enfants et adolescents, rappelle que le jeune enfant a d’abord besoin d’éprouver physiquement le monde qui l’entoure et de tisser des liens symboliques forts et stables avec ses parents et les adultes qu’il côtoie. Il doit également apprendre à se repérer dans une temporalité qu’il ne maîtrise pas immédiatement et qu’il va peu à peu explorer grâce aux livres d’images et aux histoires que lui racontent ses parents. Ce n’est qu’une fois cette étape fondamentale franchie qu’il est prêt à « affronter », avec la médiation de ses parents, les écrans et qu’il peut alors en tirer un réel bénéfice en termes de plasticité psychique, d’acquisition de connaissances et de créativité.

Il ne s’agit donc pas de tomber dans un débat manichéen ou de s’enfermer dans un conservatisme stérile et vain, en refusant d’exploiter les immenses potentialités qu’offre la révolution numérique pour l’épanouissement des enfants et leur développement cognitif, mais d’apprendre à maîtriser la puissance de ces nouveaux outils, et à en inscrire l’accès et l’utilisation dans un cadre relationnel, affectif et symbolique qui en exprime les aspects positifs et ne conduise pas à une réduction dévastatrice de la pensée, de l’imaginaire et de l’intérêt pour autrui.

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

la Food and Drug Administration (FDA), l'autorité de santé américaine, a donné son feu vert à la commercialisation, aux États-Unis, d'une intelligence artificielle capable de diagnostiquer une rétinopathie diabétique... sans intervention d'un médecin.

La rétinopathie diabétique est une grave maladie de l'œil qui touche 50 % des patients diabétiques de type 2. Concrètement, l'excès de sucre dans le sang fragilise la paroi des capillaires oculaires, ce qui peut conduire à l'éclatement des vaisseaux sanguins rétiniens : sans traitement, le risque de cécité est très élevé.

Baptisé IDx-DR, ce logiciel innovant est capable de détecter la maladie en prenant des photos très précises de la rétine du patient. Doté d'une intelligence artificielle, IDx-DR ne se contente pas de prendre les photos : il les analyse ensuite pour établir un diagnostic en totale autonomie.

« Le IDx-DR est le premier appareil autorisé à la commercialisation qui fournit une décision de dépistage sans qu'un clinicien interprète également l'image ou les résultats, ce qui le rend utilisable par des professionnels de santé qui ne sont normalement pas impliqués dans les soins oculaires », a expliqué la FDA dans son communiqué.

L'autorisation de la FDA se fonde sur une étude clinique portant sur 900 patients diabétiques. Dans près de 90 % des cas, le IDx-DR a réalisé le bon diagnostic, que le patient soit ou non atteint d'une rétinopathie diabétique. En revanche, les autorités sanitaires précisent que l'intelligence artificielle ne fonctionnera pas sur les patients ayant bénéficié d'un traitement au laser, sur les femmes enceintes ou encore sur les patients souffrant d'une perte de vision persistante.

Article rédigé par Georges Simmonds pour RT Flash

FDA

|

|

| ^ Haut |

|

|

|

|

|

|

La Commission européenne a proposé de remplacer d'ici deux ans les cartes d'identité encore sous format papier par des cartes munies d'une puce informatique, sur laquelle devront figurer d'ici maximum cinq ans les empreintes digitales du titulaire.

Sur les 26 Etats membres de l'Union qui délivrent des cartes d'identité à leurs ressortissants, la détention de ce document n'est obligatoire que dans 15 d'entre eux. On estime que 80 millions d'Européens sont actuellement titulaires d'une carte non lisible par machine et dépourvue d'identifiants biométriques, comme c'est le cas par exemple en Italie.

Or, améliorer les éléments de sécurité des cartes d'identité permettrait d'endiguer l'utilisation de documents frauduleux dont les terroristes et les criminels peuvent se servir pour entrer dans l'UE à partir d'un pays tiers, a souligné le commissaire aux Affaires intérieures, Dimitris Avramopoulos.

La Commission veut rendre les données biométriques obligatoires pour les pays qui délivrent des cartes d'identité, de sorte que celles des citoyens de l'UE (âgés de plus de 12 ans) et les titres de séjour des membres de la famille ressortissants de pays tiers comportent des empreintes digitales et des images faciales qui seront stockées sur une puce intégrée dans les documents.

Les nouvelles règles prévoient un retrait des cartes non conformes soit à la date de leur expiration soit, au plus tard, dans un délai de cinq ans, ou de seulement deux ans pour les cartes moins sécurisées (c'est-à-dire non lisibles par machine). En Belgique, le ministre de l'Intérieur Jan Jambon a annoncé récemment un projet prévoyant qu'à partir de l'an prochain, la puce électronique de chaque carte d'identité ou carte d'étranger contienne une image numérisée des empreintes de deux doigts.

Ces données ne seraient conservées que le temps nécessaire à la fabrication de la carte d'identité et seraient retirées de la banque de données après trois mois maximum. Mais la Commission pour la protection de la vie privée a rendu un avis négatif sur ce projet. La proposition de l'exécutif européen devrait donner de l'eau au moulin de M. Jambon.

Cette proposition va plus loin que les cartes d'identité.

Dans le but de tarir les sources de financement des terroristes et criminels, la Commission avance une nouvelle directive qui prévoira un accès direct - mais au cas par cas - des autorités répressives et des bureaux de recouvrement aux informations bancaires des registres nationaux, afin d'identifier les banques dans lesquelles un suspect de terrorisme ou de criminalité grave est titulaire d'un ou de plusieurs comptes. Elle prévoit aussi une coopération plus étroite entre les services répressifs et les cellules nationales de renseignement financier.

Article rédigé par Georges Simmonds pour RT Flash

Le Vif

|

|

|

|

|

|

|

|

|

Le premier hôpital intelligent doté de l’intelligence artificielle a ouvert ses portes à Guangzhou. Selon la direction du deuxième hôpital général provincial du Guangdong, « l’intelligence artificielle peut aider les patients en leur donnant des recommandations, en prenant rendez-vous et en effectuant des paiements via le compte WeChat de l’établissement ».

De plus, grâce à la reconnaissance faciale sur WeChat, les patients peuvent établir leur profil médical, ce qui permet aux médecins d’accéder à toutes les informations, facilitant le diagnostic, qui est soumis à un système intelligent venant en soutien aux médecins, afin de les aider dans la prescription de médicaments.

Selon le directeur adjoint de l’hôpital, Li Guanming, l’IA réduit de 50 % le temps de passage des patients en consultation et permet de diagnostiquer environ 90 % des maladies traitées dans les cliniques communautaires. En effet, en 2017, un logiciel basé sur l’Intelligence artificielle a été créé par des scientifiques chinois, contenant des modèles de diagnostics concernant plus de 30 maladies telles que la tuberculose et la dépression.

Le logiciel a été intégré dans un robot-médecin, qui a la capacité de diagnostiquer des milliers de maladies possibles, avec une marge d’erreur faible. Ainsi, sur la base des tests réalisés dans plusieurs hôpitaux, le taux de diagnostics corrects du robot-médecin est 20 % supérieur à celui des vrais médecins. Cela s’explique par le fait que le robot-médecin assimile de manière constante un flux important d’informations, tirant des leçons des expériences et des diagnostics réalisés.

D’autant plus que le robot possède une base de données contenant des millions de cas cliniques. « Il est conçu pour être généraliste. Toutes les semaines ou toutes les deux semaines, il peut apprendre à diagnostiquer une nouvelle maladie », a indiqué Peng Shaoliang, directeur adjoint du Centre national du super-calcul de Changsha.

« Ce robot-médecin doté d’intelligence artificielle aidera les médecins plus qu’il ne les remplacera », a indiqué Kang Xixiong, directeur du département de diagnostics de laboratoire clinique, de l’Université médicale de la Capitale, ajoutant que « pour les établissements médicaux chinois, notamment ceux des régions défavorisées, le médecin IA sera un bon assistant ».

L'objectif du conseil scientifique chinois est qu'à l'horizon 2020, les grands centres hospitaliers du pays disposent d'outils d'IA capables de diagnostiquer de manière exacte 95 % des pathologies courantes, avec moins de 1 % de "faux négatif" et moins de 5 % de "faux positifs".

Article rédigé par Georges Simmonds pour RT Flash

OpenGov

|

|

|

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

C'est une grosse boîte à roulettes qui arrive à hauteur des genoux, elle est équipée d'une trappe pour pouvoir y mettre ses courses. Jusque-là rien d'exceptionnel... sauf qu'il s'agit d'un robot capable de suivre un client à la trace à travers tout le centre commercial. "Pour qu'il me suive comme un petit chien c'est très simple", explique Vincent Talon, directeur de Twinswheel, la star-up qui a créé le robot. "Il suffit d'appuyer sur un bouton. La caméra 3D et le radar font une image de vous et le robot reconnaît votre silhouette et votre forme puis il vous suit à une distance de 5 à 10 mètres".

Pour l'instant, il s'agit uniquement d'une expérimentation le temps d'un week-end : "On a trouvé intéressant de faire un test dans le centre commercial", explique Sarah Zerouali, directrice d'Italie Deux. "C'est un vrai service que l'on pourrait proposer demain. Le robot est très interagissant, il pourrait aider notamment les personnes âgées". Après ce week-end de test, la directrice envisage de retenter l'expérience prochainement.

Cette machine fait ses premiers pas en France, mais à l'étranger elle est déjà utilisée à des fins professionnelles. On retrouve notamment le petit robot à la poste Suisse et dans certaines usines Nissan aux États-Unis. Twinswheel a lancé le projet de ce robot autonome il y a seulement deux ans, en 2016, il n'y a donc pas encore de production à grande échelle. Cela se ressent sur le prix de la machine : comptez entre 45 000 et 65 000 euros pour l'instant. Mais ce coût devrait drastiquement baisser avec le temps. À terme, la start-up espère pouvoir commercialiser le robot pour environ 10 000 euros.

Twinswheel travaille toujours sur sa machine et de nombreuses améliorations sont prévues dans les mois qui viennent. Cet été, la version améliorée du robot devrait permettre de le commander par la voix. Il sera aussi capable de reconnaître certains gestes de la main, par exemple un geste pour lui montrer qu'il doit attendre à un endroit précis.

Article rédigé par Georges Simmonds pour RT Flash

France Bleu

|

|

| ^ Haut |

|

|

|

|

|

|

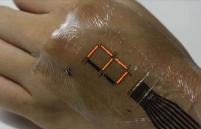

Aujourd’hui, la réalité virtuelle ou augmentée s’appuie principalement sur des technologies de détection optique des parties mobiles du corps pour l’interaction avec des objets virtuels. Cependant, elle nécessite souvent des dispositifs encombrants et sa résolution n’est pas suffisante pour des mouvements fins comme ceux des doigts par rapport à la paume d’une main par exemple.

Pour aller au-delà, des chercheurs de laboratoires allemands et autrichiens, dans le cadre du programme européen SMART, se sont attachés à trouver une solution qui s’appuie sur la sensibilité magnétique et qui colle littéralement à la peau. Le concept et sa mise en œuvre pourraient révolutionner l’emploi de la réalité augmentée pour de nombreuses applications allant du suivi de mouvement en robotique à la médecine régénérative ou aux jeux vidéos.

Les capteurs sont intégrés entre deux feuillets d’une peau électronique ultrafine. Cette peau est constituée de deux films ultraminces (1,7 µm chacun) de polyimide. Extensible, souple et imprimable, ce film peut s’appliquer sur n’importe quelle partie de la main sans gêne importante pour le porteur.

Il peut aussi être intégré à des matériaux souples comme les textiles et il supporte une température maximale de 344°C. Si les chercheurs ont assez rapidement réussi à réaliser un capteur magnétosensible qui s’intégrait à leur film et qui permettait de détecter les objets environnants, ils ont eu plus de mal à passer l’obstacle du positionnement spatial. Mais ils y sont finalement parvenus et ont démontré la faisabilité grâce à deux expériences décrites dans un article paru dans Science Advances de fin janvier 2018 où leur dispositif permet d’interagir avec des objets virtuels qui ne sont pas dans la ligne visuelle directe du manipulateur.

Dans la première expérience, un aimant permanent est fixé au bout du doigt d’une personne. Sur son autre main, un serre-poignet élastique contient le dispositif des chercheurs muni d’un capteur 2D. Quand le bout du doigt s’approche du serre-poignet, le capteur peut déterminer l’angle d’approche, cet angle est converti en un caractère prédéfini (un chiffre par exemple). Les différentes positions du doigt procurent donc différents caractères et peuvent être transformées en un clavier activable à distance.

La deuxième expérience a démontré la possibilité de régler l’intensité d’une ampoule virtuelle via une manipulation sans contact. La peau électronique a été placée dans la paume de la main. Un aimant permanent fait office de bouton virtuel. Quand la main fait un mouvement, comme pour faire tourner un variateur dans un sens ou dans l’autre, le capteur transforme le changement dans les champs magnétiques en information pour augmenter ou diminuer l’intensité lumineuse de l’ampoule virtuelle.

Article rédigé par Georges Simmonds pour RT Flash

Techniques de l'Ingénieur

|

|

|

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Une étude du Crigen (Engie lab) a comparé les performances de dix solutions d’énergie EnR et conventionnelles en vue d’atteindre 20 % de moins que le niveau RT 2012. Les calculs ont été effectués sur des cas concrets (un R+2 de 18 logements et un R+4 de 34 logements) dans trois zones climatiques différentes, du Sud au Nord de la France.

Les résultats sont sans appel : le solaire thermique permet d'économiser de 51 % à 68 % sur l'eau chaude sanitaire (ECS), ce qui représente 18 kWh de consommation en énergie primaire en moyenne sur la France. Face aux autres EnR, le solaire thermique s’impose globalement comme la seule solution capable d’abaisser de 20 % (soit 40 kWh/m2 par an) la consommation en énergie primaire, sans travaux d’isolation supplémentaires.

En considérant les coûts sur 20 ans, la chaleur solaire revient moins chère que les solutions traditionnelles, voire que d’autres solutions faisant appel à des énergies renouvelables. Elle se positionne donc comme la meilleure des énergies les plus rentables sur le long terme. En comparaison avec d’autres solutions conventionnelles, le solaire s’affirme aussi comme la plus rentable du marché en rénovation, grâce notamment au soutien du Fonds chaleur.

Une étude I-Care & Consult démontre également que le solaire thermique s’impose aussi dans la durée, comme sur la compétitivité. Il semble que, dès à présent, cette solution est rentable grâce à la taxe carbone. En effet, sur 20 ans, en intégrant les coûts d’installation, d’exploitation et de maintenance, elle s’avère moins chère qu’une solution classique fonctionnant à 100 % au gaz ou au fioul.

Article rédigé par Georges Simmonds pour RT Flash

Batirama

|

|

| ^ Haut |

|

|

|

|

|

|

On le sait, le stockage efficace, à grande échelle, pour un coût raisonnable de l’énergie produite par des éoliennes et des panneaux solaires représente encore un sérieux obstacle au développement des énergies vertes.

Mais cette situation va sans doute changer : Kemwatt a présenté le premier prototype industriel de batterie, baptisé « Redox Flow ». C’est la première batterie organique non corrosive de dimension industrielle. Elle a nécessité deux années de développement et ouvre la voie à des solutions de stockage simples, fiables, peu coûteuses et durables.

Cette innovation apporte donc une réponse majeure pour l’expansion des énergies renouvelables qui butaient jusqu’alors sur cette impossibilité de stockage de l’énergie. A terme, cela pourrait permettre d’électrifier des micro-réseaux, comme des villages africains non électrifiés mais très ensoleillés. 10KWh ainsi stockés correspondent à la consommation d’une lampe allumée pendant 10 jours sans interruption.

En plus d’être innovante technologiquement, la batterie développée par Kemwatt est une solution durable. Stocker et restituer de grandes quantités d’énergie plus proprement est en effet le défi des énergies renouvelables, particulièrement aujourd’hui où elles deviennent compétitives face aux énergies fossiles et nucléaires. La batterie « Redox Flow » apporte une solution majeure en stockant proprement de nombreuses heures de production d’énergie.

En général, le stockage dans ce type de batterie se fait de manière chimique, avec des matières corrosives baignant en milieu acide, générateur de fuites mettant à mal la fiabilité du système, sa durée de vie, sa sécurité et l’environnement. Mais là où la batterie Redox Flow Organique innove, c’est qu’elle résout ce problème grâce à une chimie basique, c’est dire neutre et non-corrosive, utilisant des molécules naturelles, avec des électrolytes biodégradables et recyclables, permettant des applications à grande échelle, qu’elles soient industrielles ou non.

Et selon François Huber, le président de Kemwatt, ces systèmes « apporteront une solution énergétique propre et moderne à plus d’un milliard de personnes qui n’ont pas accès à l’électricité ». Avec sa technologie brevetée, Kemwatt vise le marché mondial du stockage stationnaire de l’énergie. Kemwatt a reçu plusieurs récompenses dont le 1er prix mondial de l’innovation dans la catégorie stockage d’Energie, le 6 avril dernier. L’entreprise devrait déployer commercialement son offre sur à partir de 2019.

Article rédigé par Georges Simmonds pour RT Flash

RCF

|

|

|

|

|

|

|

|

|

L'essor du véhicule électrique va poser des problèmes croissants : nécessité d'ouvrir de nouvelles centrales électriques, recours aux énergies fossiles pour faire face à la demande, risques de coupure lors des pics de consommation. Pour Mitsubishi : c'est une erreur !

Intégrée au sein de l’Alliance Renault-Nissan-Mitsubishi depuis octobre 2016, la marque aux trois diamants annonce une stratégie d’électrification ambitieuse qui va même au-delà de l’automobile.

Pour commencer, tous les modèles de sa gamme auront une déclinaison électrifiée, que ce soit du 100 % électrique (pour les petits modèles) ou de l’hybride rechargeable, comme l’Outlander PHEV, pour les gros SUV.

Pour assumer pleinement ce nouveau rôle, une nouvelle version sera commercialisée début 2019. Avec un nouveau moteur thermique essence 2.4 à cycle Atkinson, une batterie de capacité supérieure et des moteurs électriques plus puissants, il affichera des performances à la hausse, une autonomie électrique plus importante (sans doute 60 km) et devrait rester, selon Mitsubishi, en dessous des 50 g/km de CO2.

Mitsubishi part d’un constat d’ailleurs valable pour tous les véhicules : ils ne roulent pas 95 % du temps. Si pendant cette durée un véhicule électrique est branché sur un réseau compatible "smart grid", c’est-à-dire qui peut fournir du courant au véhicule mais aussi en récupérer, le véhicule en question fonctionne comme une unité de stockage et de distribution.

10 000 Outlander PHEV connectés au réseau représentent ainsi une puissance de 1 GW, soit l’équivalent d’un petit réacteur nucléaire, utilisable lors des pics de consommation par exemple. La voiture électrique est aussi un moyen efficace pour stocker l’énergie produite par les sources renouvelables (éolien, solaire…), par nature intermittentes. Grâce au rachat de l’énergie stockée dans les batteries, cela peut même être une source de revenus plus rentable qu’une batterie à poste fixe puisque l’automobile ne nécessite pas, dans ce cas précis, d’investissement supplémentaire.

Mais on peut aussi utiliser plus simplement son Outlander pour alimenter sa propre maison ou des appareils électriques. Tous les modèles disposent en effet d’une prise AC 230 V-1500 W. Mitsubishi précise qu’avec le plein d’essence et une batterie chargée on dispose de dix jours d’autonomie électrique avec une consommation moyenne de 100 W.

Article rédigé par Georges Simmonds pour RT Flash

L'Argus

|

|

|

|

|

|

|

|

|

Chaque année, 9 millions de tonnes de déchets plastiques non traités sont rejetés dans les océans, ce qui entraîne une importante pollution planétaire et perturbe de plus en plus les écosystèmes marins. En 2016, en analysant des échantillons de sol d’une usine de recyclage de plastique, une équipe de biologistes japonais de l’Université de Kyoto a découvert l’existence d’une bactérie nommée « Ideonella sakaiensis ».

La particularité de cette dernière réside dans le fait qu’elle ait évolué afin de pouvoir dégrader et utiliser le plastique PET (téréphtalate d’éthylène) comme source de carbone et d’énergie. En étudiant Ideonella sakaiensis et ses mécanismes cellulaires, les scientifiques ont accidentellement synthétisé une nouvelle enzyme bien plus performante que celle utilisée par la bactérie et qui pourrait offrir une véritable solution à la déferlante plastique actuelle.

Comme le souligne John McGreehan, biologiste structural à l’Université de Portsmouth (Royaume-Uni), « Cette découverte non anticipée suggère qu’il est possible d’améliorer davantage ces enzymes, nous rapprochant d’une solution de recyclage pour chaque montagne de déchets plastiques ».

L'équipe de McGreehan, incluant des chercheurs de l’US Department of Energy’s National Renewable Energy Laboratory (NREL), ont synthétisé la nouvelle enzyme en étudiant la structure cristalline de la PETase – l’enzyme permettant à Ideonella sakaiensis de dissoudre le plastique PET.

Là où la PETase de Ideonella sakaiensis permet une dégradation en quelques semaines maximum, la nouvelle PETase améliorée ramène ce délai à quelques jours. « Après seulement 96h, nous pouvons clairement voir au microscope électronique que la PETase dégrade le PET ; et nous la testons avec de véritables déchets plastiques, tels que ceux trouvés dans les océans ou les décharges » indique le biologiste Bryon Donohoe (NREL).

Les auteurs ont tenté de modifier la PETase pour la rapprocher du mécanisme enzymatique de la cutinase – une enzyme dégradant la cutine, un biopolymère lipidique présent chez les plantes et dont la structure ressemble à celle du PET. En raccourcissant les liaisons entre les sites actifs de la PETase, ils se sont aperçus que la catalyse du plastique obtenu était bien plus performante que prévu.

Un important travail attend encore les scientifiques avant que cette nouvelle enzyme puisse être produite en masse et permette véritablement d’offrir une méthode de recyclage à grande échelle. Cependant, maintenant que l’on connaît son fonctionnement, son utilisation n’est plus qu’une question de temps.

Article rédigé par Georges Simmonds pour RT Flash

Trust My Science

|

|

|

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Selon deux études convergentes publiées dans la revue Nature, le changement climatique en cours se traduit par un affaiblissement de la circulation de ces courants connus sous l'acronyme d'AMOC (circulation méridienne de retournement de l'Atlantique).

Cet affaiblissement des courants est le fruit de la fonte de la banquise, des glaciers et de plates-formes glaciaires, qui libèrent de l'eau douce, moins dense que l'eau salée, dans l'Atlantique Nord. "L'eau douce affaiblit l'AMOC car elle empêche les eaux de devenir assez denses pour couler", explique à l'AFP David Thornalley, de l'University College London, co-auteur d'une des études.

Cette circulation permanente des eaux marines consiste en une remontée des eaux chaudes des zones tropicales de l'Atlantique vers le Nord grâce au Gulf Stream, réchauffant au passage l'Europe de l'Ouest. Une fois dans l'Atlantique Nord, ces eaux refroidissent, deviennent plus denses et plus lourdes et coulent sous des eaux plus chaudes pour repartir vers le sud.

"Si le système continue de faiblir, cela pourrait perturber les conditions météorologiques depuis les États-Unis et l'Europe jusqu'au Sahel et provoquer une hausse plus rapide du niveau des mers sur la côte est des États-Unis", avertit le Woods Hole Oceanographic Institution, qui a participé aux recherches.

Ces courants marins transportent aussi d'une zone à l'autre des nutriments, de l'oxygène, des larves de coraux ou encore de poissons. Ils contribuent également à la capacité des océans à absorber et à stocker du dioxyde de carbone (CO2), principal responsable du réchauffement climatique.

Dans la première étude, David Thornalley et son équipe ont étudié les grains de sable déposés par les courants sur les fonds marins au fil du temps. Plus les grains de sable retrouvés dans les sédiments étaient gros, plus forts devaient être les courants qui les ont transportés. Les résultats révèlent que l'AMOC a été relativement stable entre l'an 400 et 1850 et a commencé à s'affaiblir au début de l'ère industrielle.

La seconde étude s'est penchée sur les températures de la surface de l'océan et en déduit que l'AMOC a décliné d'environ 15 % au cours des cinquante dernières années, probablement à cause du changement climatique dû à des activités humaines même s'il est difficile de connaître avec certitude le rôle joué par le réchauffement climatique.

"Le fait que l'AMOC soit resté faible et se soit affaibli au cours du 20e siècle, avec un déclin notable à partir de 1950 environ, est très certainement lié à des facteurs humains", estime David Thornalley.

Les études ne disent pas si ce système de courants va continuer à perdre de sa puissance. Si c'est le cas, les conséquences possibles seraient plus de tempêtes l'hiver en Europe ou un déplacement vers le Sud de la ceinture tropicale de pluies.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

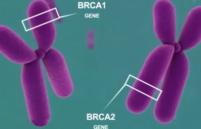

Dans le cadre du "Cancer Genome Atlas", l'un des plus grands projets internationaux de recherche sur le cancer, des chercheurs ont réussi à déchiffrer le code génétique de 33 types différents de tumeurs. Grâce aux données recueillies sur 11 000 patients, les experts ont fourni une feuille de route pour définir un traitement plus efficace et développer de nouveaux médicaments.

Le résultat de leur recherche est étonnant : les tumeurs présentes dans les différentes parties du corps, autrefois traitées comme des maladies distinctes, ont des similitudes moléculaires qui pourraient donc les rendre vulnérables aux médicaments déjà sur le marché.

Ainsi, les tumeurs des cellules qui tapissent le poumon, la vessie et la tête, autrefois traitées comme des maladies distinctes, présentent en fait des caractéristiques communes : "En étudiant leurs caractéristiques moléculaires, nous savons maintenant que de tels cancers sont étroitement liés", souligne le Docteur Li Ding, l'un des principaux auteurs du projet.

Au-delà de simplement définir le cancer par sa localisation, comme le sein ou la peau, cette recherche va permettre de reclasser les types de cancers existants. La découverte de cette composition moléculaire pourrait donc conduire à des "changements radicaux" dans la façon dont les médicaments sont choisis pour chaque patient.

Les chercheurs ont aussi constaté qu'environ 8 % des mutations cancérigènes étaient héritées de l'ADN parental, et non causées par les rayons du soleil ou le tabagisme. D'après la Fondation contre le Cancer, ceux reconnus comme héréditaires sont le cancer du sein, de l'ovaire, de l'intestin, mais aussi le mélanome (une forme de cancer de la peau) et certains cancers de la prostate.

Article rédigé par Georges Simmonds pour RT Flash

Le Vif

|

|

| ^ Haut |

|

|

|

|

|

|

L'ostéoporose cortisonique est la plus fréquente des complications des traitements par corticoïdes de plus de 3 mois, et la plus fréquente des ostéoporoses chez la personne jeune. Le risque de fractures de fragilité osseuse sous corticoïdes est estimé à 5 % par an si rien n’est fait pour les prévenir.

Dans une nouvelle étude, un anticorps monoclonal spécifique de l’os, le denosumab, qui est un anti-RANK anti-ostéoporotique, est équivalent voire supérieur au traitement de référence, le risédronate, qui est un bisphosphonate déjà ancien et peu puissant. A 12 mois, le denosumab, une injection sous-cutanée à 60 mg tous les 6 mois, est supérieur au risedronate, un comprimé à 5 mg par jour. Chaque groupe de malades prenait en même temps un placebo de l’autre traitement pour rendre la comparaison plus fiable.

La densité minérale osseuse à la colonne lombaire, au lieu de baisser sous corticoïde, augmente de 4,4 % sous denosumab versus 2,3 % sous risedronate chez les personnes sous traitement corticoïde chronique. Chez celles qui ont initié le traitement corticoïde au cours des 3 mois, les mêmes mesures sont respectivement de 3,8 % versus 0,8 %.

Cette étude réalisée dans plusieurs centres en Europe a testé avec de bonnes garanties de méthodologie (tirage au sort et double aveugle) l’intérêt d’une molécule anti-ostéoporotique, le denosumab, qui est un anticorps monoclonal anti-RANK, c’est-à-dire qu’il bloque spécifiquement les cellules qui sont chargées de la résorption de l’os (les ostéoclastes).

Cette étude a été réalisée sur 2 ans dans une large population de personnes à risque d’ostéoporose et traitées par des corticoïdes à une dose équivalente de 7,5 mg par jour de prednisone pendant plus, ou moins, de 3 mois.

Les résultats qui sont présentés sont les mesures à 12 mois de la densitométrie osseuse, mesure qui est fortement corrélée à la fracture de fragilité osseuse. Il faut attendre les résultats définitifs à 24 mois pour vérifier si cette amélioration de la densité osseuse se traduit également par une diminution du nombre de fractures, mais cela fait peu de doute.

Article rédigé par Georges Simmonds pour RT Flash

The Lancet

|

|

|

|

|

|

|

|

|

On sait depuis quelques années que l’apparition de métastases n’est pas liée uniquement aux propriétés intrinsèques des cellules métastasiques, mais aussi aux conditions environnementales, et notamment aux pressions mécaniques qui s’exercent sur elles. Des travaux ont par exemple déjà montré que ces cellules s’adaptent à la rigidité d’un tissu pour mieux l’envahir. Cette fois, une équipe Inserm vient de prouver que leur dissémination est associée à la force du flux sanguin.

Pour étudier ce phénomène, les chercheurs ont travaillé in vivo avec des embryons de poisson zèbre. "Ce modèle est simple et possède une vascularisation stéréotypée, il permet d’injecter des cellules métastasiques et d’observer par microscopie leur devenir dans l’espace et dans le temps. Il permet également de modifier le flux sanguin en injectant différentes substances qui régulent l’activité cardiaque", détaille Jacky Goetz, responsable de ces travaux.

Les chercheurs ont montré que la vitesse de déplacement des cellules métastasiques ralentit au niveau des capillaires, des zones fortement ramifiées avec des virages, des bifurcations, où le flux sanguin est lui-même ralenti. Là, les cellules s’arrêtent préférentiellement à certains endroits que les chercheurs ont appelé des points chauds (hotspots). Ils ont en outre observé qu’il est possible de déplacer ces hotspots en jouant sur la force du flux sanguin. Une observation cohérente avec le fait que, chez les patients, les métastases apparaissent préférentiellement dans des organes présentant un réseau vasculaire très ramifié et complexe comme les poumons, le foie ou encore le cerveau.

Mais pour être agressive, la cellule ne doit pas seulement s’arrêter : elle doit aussi se lier à la paroi vasculaire et la traverser. Là encore, la force du flux joue un rôle déterminant. L'étude montre qu'en modifiant ce flux, on constate qu’une certaine vitesse de flux doit être respectée pour permettre l’adhésion des cellules métastasiques aux cellules endothéliales. Cette adhésion implique une protéine exprimée par les cellules métastasiques, l’integrine ß1. Des expériences conduites chez la souris ont montré que si elles en sont dépourvues, elles restent mobiles dans la circulation.

Enfin, une fois liées à la paroi, les cellules doivent être expulsées du système vasculaire. Ce phénomène s’appelle l’extravasation. Là encore, il faut conserver une certaine force du flux afin d’obtenir un remodelage des cellules endothéliales autour de la cellule tumorale, nécessaire à l’expulsion. "Si le flux est trop faible, la sortie n’a pas lieu et les métastases ne peuvent se former", explique Jacky Goetz.

Dans un second temps, en collaboration avec une équipe allemande, les chercheurs ont confirmé l’association entre débit sanguin et régions métastasiques dans le cerveau d’une centaine de patients atteints de différents cancers. Pour cela, ils ont utilisé la tomodensitométrie afin de réaliser une cartographie du degré de perfusion dans tout le cerveau, renseignant sur la force du débit sanguin.

Ils ont alors constaté une corrélation entre la force de celui-ci et la localisation préférentielle de métastases repérée par IRM. Dès lors, ces travaux pourraient-ils permettre de trouver des solutions pour réduire le risque de métastase en cas de cancer ? "Il serait malheureusement trop complexe de jouer sur la force du flux sanguin pour limiter ce risque", reconnaît Jacky Goetz.

"En revanche, nous nous intéressons de près à l’étape de remodelage de l’endothélium au moment de l’extravasation des cellules tumorales. Des traitements existent pour limiter la croissance des vaisseaux en cas de cancer, afin d’asphyxier la tumeur. Et ils altèrent ce remodelage. Par conséquent nous regardons actuellement s’ils peuvent inhiber l’étape d’extravasation. A priori, cela réduirait le risque d’apparition de métastases", espère-t-il.

Article rédigé par Georges Simmonds pour RT Flash

Inserm

|

|

|

|

|

|

|

|

|

Dans le cancer de la prostate, quand il n’est pas accessible à un traitement curatif, chirurgical ou en radiothérapie, et qu’il n’est pas encore métastasé, le traitement repose sur la castration chirurgicale ou chimique. Certains malades sont cependant résistants, secondairement ou d’emblée, mais l’objectif est de retarder l’apparition de métastases.

Chez les hommes souffrant d'un cancer de la prostate non métastatique, mais résistant à la castration, l’apalutamide réduit de 72 % le risque de métastases ou de décès.

Ces données suggèrent que l’apalutamide pourrait être un nouveau standard de traitement chez les hommes résistant à la castration et à haut risque de métastases, métastases qui sont les principales pourvoyeuses de souffrances et de réduction de l’espérance de vie.

L’apalutamide est un inhibiteur compétitif de nouvelle génération qui se fixe directement sur le récepteur aux androgènes. Il est en cours de développement pour le traitement des hommes atteints de cancer de la prostate non encore métastasé. Il empêche la liaison des androgènes aux récepteurs aux androgènes sur les cellules cancéreuses et l’activation de ces cellules (transcription de l'ADN médiée par le récepteur androgène).

La médiane de survie sans métastase fait plus que doubler puisqu’elle est de 40,5 mois dans le bras apalutamide contre 16,2 mois dans le bras placebo (HR, 0,28, IC 95%, 0,23-0,35, P <0,0001). Sur la base de ces données, la FDA a accordé un examen prioritaire à l'apalutamide pour prescription dans ce contexte.

L'essai SPARTAN a évalué l'innocuité et l'efficacité de l'apalutamide par rapport au placebo chez 1207 patients atteints de cancer de la prostate à haut risque, résistant à la castration, et non encore métastatique : tous ces malades avaient un taux d'antigène prostatique spécifique en augmentation rapide, malgré une suppression androgénique en continu. Les malades devaient donc avoir un temps de doublement du PSA ≤ 10 mois, car des données antérieures ont montré que ce sont les patients les plus à risque de développer des métastases et de mourir.

80 % des hommes sous placebo ayant progressé et 56 % des patients sous apalutamide ont été traités ultérieurement pour leur cancer de la prostate. Les chercheurs ont noté que la survie sans progression est plus longue chez les patients traités par apalutamide. « Les résultats de cette étude suggèrent qu'il pourrait enfin y avoir un traitement prometteur pour prolonger leur qualité et leur espérance de vie », a déclaré le Professeur Sumanta K. Pal.

Article rédigé par Georges Simmonds pour RT Flash

NEJM

|

|

|

|

|

|

|

|

|

Pour rester en forme, l'OMS, recommande de pratiquer au moins 150 minutes par semaine d'activité physique modérée à vigoureuse pendant des périodes de 10 minutes ou plus. Mais ce modèle n'est pas toujours facile à observer par les personnes âgées.

Heureusement, une étude anglaise publiée dans le Journal Britannique de la Médecine Sportive vient de montrer que, pour les seniors, c'est bien le volume global d’activité qui est le plus important, et pas la fréquence ou l’intensité des exercices. Ainsi, il n’est pas nécessaire, en particulier à l’âge avancé, de pratiquer l’exercice sur des séances de 10 minutes ou plus, voire de 30 minutes par jour, comme le stipulent les recommandations.

L'étude montre en effet qu'une simple pratique de quelques minutes d'exercices modérés est déjà associée à une forte réduction du risque de décès chez les hommes âgés. L'important, selon ces recherches, serait en fait d'arriver à cumuler au moins 2 h 30 d'activités physiques hebdmadaires.

Pour démontrer leur théorie, les chercheurs ont analysé les données de 7.735 participants à la la British Regional Heart Study et âgés de 40 à 59 ans, au départ de l’étude, dans les années 1978-80. En 2010-2012, soit 30 années plus tard, les 3.137 participants survivants ont été invités à subir un examen médical comprenant un examen physique, des questions sur leur mode de vie, leur sommeil et l’existence d’un diagnostic de maladie cardiaque.

Ces recherches très rigoureuses montrent que chaque tranche de 30 minutes supplémentaires d'activité quotidienne, même de faible intensité, est associée à une réduction de 17 % du risque de décès. Cette association persiste même après la prise en compte des facteurs de mode de vie dont le temps de sédentarité.

Article rédigé par Georges Simmonds pour RT Flash

BJSM

|

|

|

|

|

|

|

|

|

Des chercheurs de l’Université du Michigan (États-Unis) ont montré que le fait d'évoluer dans des endroits où la puissance de l’éclairage est insuffisante affecterait notre mémoire et notre capacité d’apprentissage.

Dans le cadre de ces recherches, les scientifiques ont travaillé sur une population de rats musqués. Selon les résultats, les individus soumis à des lumières de faible intensité ont vu baisser de 30 % la capacité de leur hippocampe, cette zone du cerveau assurant un rôle central dans la mémoire et la navigation spatiale. En effet, il s’avère que les rats se sont montrés moins performants dans ces domaines après cette « sous-exposition », et ce même concernant des tâches pour lesquelles ces derniers avaient reçu un entraînement.

A l’opposé, les rats ayant reçu suffisamment de lumière, c’est-à-dire à une intensité plus forte, ont vu leurs capacités cognitives s’améliorer. Par ailleurs, les scientifiques ont tenté d’exposer à des lumières fortes les rats préalablement sous-exposés, et ceux-ci ont retrouvé leurs capacités originelles. Ceci signifie donc que les effets néfastes d’un éclairage trop insuffisant sont réversibles.

Selon les chercheurs, le manque d’intensité au niveau de l’éclairage aurait pour effet de ralentir la production d’orexine, un neurotransmetteur du cerveau situé dans l’hypothalamus. Ce dernier assure le maintien de l’éveil et l’inhibition du sommeil paradoxal, et son dysfonctionnement peut entraîner la narcolepsie.

Ainsi, la prochaine étape pour les chercheurs sera de comprendre s’il est possible de remplacer l’exposition à un éclairage intense directement par des injections d’orexine. Dans le cas où ces injections s’avéreraient efficaces, une des applications pourrait concerner les personnes aveugles ou malvoyantes, chez qui il serait possible de développer de meilleures facultés de mémorisation et d’orientation dans l’espace.

Article rédigé par Georges Simmonds pour RT Flash

Science Daily

|

|

|

|

|

|

|

|

|

Les immunothérapies sont des traitements qui stimulent les cellules immunitaires du patient afin qu'elles attaquent la tumeur. Elles peuvent s'avérer très efficaces contre le mélanome – une forme courante et agressive de cancer de la peau – mais ne fonctionnent pas chez tous patients, sans qu'on sache exactement pourquoi.

Afin d’améliorer le taux de succès, les chercheurs tentent d'identifier les facteurs qui rendent possible une immunothérapie efficace, aussi bien que ceux qui la limitent. Le but ultime est d'ouvrir de nouvelles voies à des immunothérapies plus largement efficaces contre le mélanome, et potentiellement contre d'autres types de cancers.

Certaines cellules immunitaires, appelées lymphocytes T CD8 (ou lymphocytes T cytotoxiques), sont capables de reconnaître et de tuer les cellules du mélanome, et possèdent donc la capacité d'éradiquer la tumeur. Les immunothérapies stimulent les lymphocytes T CD8 afin qu'elles attaquent plus vigoureusement la tumeur. Mais l'activité des lymphocytes T CD8 peut être inhibée par d'autres cellules immunitaires présentes dans la tumeur.

En étudiant un sous-groupe de patients atteints de mélanomes, des chercheurs dirigés par Michele De Palma de l'EPFL et Daniel Speiser de l'Université de Lausanne ont identifié les coupables : des macrophages générant une résistance à un traitement de pointe, connu sous le nom d’immunothérapie anti-PD-1.

« L'existence de cellules immunitaires qui soit exécutent, soit inhibent les réponses cytotoxiques immunitaires, est un élément essentiel si l'on veut limiter les effets potentiellement délétères d'une réponse immunitaire non-contrôlée – une situation susceptible de conduire à une auto-immunité ou à des dommages aux organes », dit Michele De Palma. « Le problème est que les tumeurs détournent ces mécanismes de régulation à leur propre profit, afin de pouvoir croître largement hors du contrôle du système immunitaire ».

En analysant des échantillons obtenus sur des tumeurs de patients, Daniel Speiser et ses collègues ont découvert que les lymphocytes T CD8 diffusent des signaux qui attirent indirectement les marcophages vers les tumeurs, établissant ainsi ce qu'ils appellent une « liaison dangereuse » dans le mélanome.

« C'est une sorte de cercle vicieux », explique Speiser. « Le bon côté de la médaille, c'est que les lymphocytes T CD8 sont activés par certains antigènes tumoraux et génèrent une réponse immunitaire potentiellement bénéfique contre la tumeur. Le mauvais côté est que, lorsqu'ils sont activés, les lymphocytes T CD8 provoquent la production d'une protéine dans le mélanome, appelée CSF1, qui attire les macrophages ». De fait, les mélanomes qui attirent beaucoup de lymphocytes T CD8 finissent souvent par contenir de nombreux macrophages, ce qui peut affaiblir l'immunité de l'immunothérapie PD-1.

Un fois recrutés en masse vers la tumeur, les macrophages suppriment les lymphocytes T CD8 et réduisent la réponse immunitaire tumorale. Mais lorsque les scientifiques ont utilisé un médicament destiné à éliminer les macrophages dans les modèles de mélanome expérimentaux, ils ont constaté que l'efficacité de l'immunothérapie à inhibiteurs du checkpoint PD-1 était grandement améliorée.

Ces découvertes plaident en faveur de tests cliniques d'agents capables de désorganiser les macrophages en combinaison avec l'immunothérapie PD-1 chez des patients dont les mélanomes contiennent un nombre élevé de lymphocytes T CD8 et de macrophages.

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

|

|

|

|

|

|

|

Une équipe de recherche d'UCLA, en Californie, a étudié les conséquences d'un comportement sédentaire sur quelques-unes des fonctions vitales d'hommes et de femmes d'âge moyen, ainsi que de personnes âgées. Les conclusions sont édifiantes : non seulement les sujets restant trop longtemps assis accroissent leur risque de maladie cardiaque, de diabète ou de décès prématuré, mais cette sédentarité provoque de surcroît des effets néfastes sur le cerveau.

La position assise aurait notamment une influence sur la mémoire puisqu'elle contribuerait à affiner considérablement le lobe temporal médian, 2 % de lobe temporal en moins par heure en position assise. Âgées de 45 à 75 ans, les personnes observées ont confié rester assises chaque jour pendant une durée variant de 3 à 15 heures.

D'après l'équipe de recherche, à chaque heure passée quotidiennement en position assise correspond un désépaississement de 2 % de ce lobe temporal médian. Autrement dit, explique la biostatisticienne Prabha Siddarth, "Passer 5 heures en position assise revient à perdre 10 % d'épaisseur" par rapport à quelqu'un qui ne s'assiérait jamais. Aucun lien de corrélation n'a en revanche été trouvé entre le degré d'activité physique des personnes et l'état de leur lobe temporal.

L'idée selon laquelle une quantité suffisante de sport pourrait compenser les dommages de la sédentarité est donc fausse dans le cas du cerveau. « Nous n'essayons pas de dire que l'activité physique est inutile », précise Prabha Siddarth. Il serait possible d'enrayer les effets de la position assise en prenant régulièrement des pauses, ajoute la chercheuse, pour qui la continuité de la station assise constitue le principal problème.

Siddarth ajoute que de nombreuses recherches restent à mener sur le sujet, notamment sur l'intensité intellectuelle des activités menées par les personnes lorsqu'elles sont assises. Réfléchir à un problème complexe sur sa chaise de bureau ou regarder une émission de C8 dans son canapé n'a sans doute pas les mêmes effets à long terme sur le cerveau, mais cela reste à établir précisément.

Article rédigé par Georges Simmonds pour RT Flash

UPI

|

|

|

|

|

|

|

|

|

Selon une vaste méta-analyse, reprenant 83 études réalisées sur près de 600 000 buveurs d’alcool de 19 pays, des chercheurs britanniques sont arrivés à la conclusion que la limite acceptable de consommation quotidienne d’alcool devrait être d’environ 100 grammes par semaine, soit l’équivalent d’environ un verre de vin par jour.

Pour les chercheurs, 100 g constitue le niveau de consommation hebdomadaire qui représente le moins de risque de mortalité lié à l’apparition de maladies cardiovasculaires. Une consommation d’alcool trop élevée augmente aussi les risques de maladies du foie, des intestins, du cerveau (démence) et de certains cancers, rappellent les auteurs de l’étude.

D’après l’article signé par une coalition de chercheurs dirigée par l’épidémiologiste britannique Angela Wood, de l’Université Cambridge, une personne âgée d’une quarantaine d’années pourrait prolonger sa vie de deux à cinq ans en réduisant sa consommation d’alcool à l’équivalent d’un verre par jour. Plus précisément, à l'âge de 40 ans, on diminue son espérance de vie de six mois en consommant de 7 à 15 verres d'alcool par semaine, d'un à deux ans avec une consommation de 15 à 25 verres, et de quatre à cinq ans avec plus de 25 verres par semaine.

Article rédigé par Georges Simmonds pour RT Flash

The Lancet

|

|

|

|

|

|

|

|

|

Décidément la nature est une source inépuisable d'inspiration pour la recherche. Cette fois, se sont les yeux du papillon Morpho qui ont inspiré les recherches d'une équipe de scientifiques américaine dirigée par Viktor Gruev (Université Urbana-Champaign dans l'Illinois) par l’Université Saint-Louis. Les yeux composés de l’animal contiennent des nanostructures optiques qui lui permettent de détecter des informations multi spectrales.

Les chercheurs américains se sont inspirés de ce système de vision naturel pour mettre au point une caméra capable de fournir simultanément des images dans le visible et dans le proche infrarouge. A l’échelle nanométrique, ils ont créé un motif dont chaque pixel est composé de couches alternatives de SiO2 et TiO2.

Ces deux matériaux diélectriques agissent comme des filtres qui laissent passer certaines longueurs d’ondes et en réfléchissent d’autres. En modifiant l’épaisseur et la périodicité de ces couches, il est possible de créer des pixels sensibles aux différentes longueurs d’onde. L’ensemble a été déposé sur un unique détecteur, un semi-conducteur à base de silicium.

Les caméras multi spectrales sont principalement utilisées en médecine oncologique où les chirurgiens doivent éliminer toute la tumeur sans atteindre les tissus sains. Pour ça, ils ont besoin d’identifier avec précision à la fois les structures anatomiques mais aussi les marqueurs fluorescents qui ciblent les cellules cancéreuses. Les instruments utilisés actuellement sont composés de plusieurs éléments optiques comme des séparateurs de faisceaux et des lentilles relais qui permettent de séparer les longueurs d’onde visibles et infrarouges pour les envoyer sur différents détecteurs.

Des variations de température peuvent affecter ces dispositifs qui ne fournissent pas toujours des images parfaitement alignées. Avec leur nouvelle structure, les scientifiques ont pu intégrer les détecteurs de lumière et les dispositifs optiques sur une même unité. Leur caméra bio-inspirée présente une précision spatiale sept fois supérieure à celle des dispositifs actuels. Elle permet une bonne détection de la fluorescence même sous un fort éclairage chirurgical. Et sa petite taille et son poids (une vingtaine de grammes) permettent d’envisager son utilisation pour des endoscopies.

Article rédigé par Georges Simmonds pour RT Flash

OSA

|

|

|

|

|

|

|

|

|

Une équipe américaine dirigée par Robert Hamson, du Centre médical de l’Université Wake Forest Baptist, a mis au point une prothèse équipée de capteurs directement implantés dans le cerveau. Celle-ci a été expérimentée sur 17 patients épileptiques, volontaires, pour essayer de réactiver chez eux des souvenirs oubliés.

La prothèse prend la forme de plusieurs micro-électrodes dont la tâche est de reproduire l’activité cérébrale. Une fois implantée dans la zone de l’hippocampe, elle va stimuler certains neurones pour déclencher leur activité. Cette partie du cerveau est connue pour héberger les souvenirs mais également la mémoire spatiale.

Les premières observations sont pour le moins intéressantes. Dans leur publication, les chercheurs du Centre médical de l’Université Wake Forest Baptist annoncent que la mémoire des sujets de l’expérience s’est améliorée de 35 % à 37 %, des résultats probants non seulement pour la mémoire à court terme mais également sur le long terme.

Pour parvenir à ce résultat, les chercheurs ont présenté plusieurs images aux patients afin qu’ils les retiennent. Un électro-encéphalogramme va ensuite suivre l’activité cérébrale au moment même où ces images sont montrées. Cela permet aux chercheurs de capturer l’instant pendant lequel une information est bel et bien enregistrée par le cortex.

Une fois cette empreinte renseignée, des images identiques ont été présentées aux mêmes patients mais avec, cette fois-ci, une prothèse neuronale. En stimulant ces zones du cerveau hébergeant le souvenir, les cobayes se sont souvenus des mêmes photographies. Ils avaient en quelque sorte ravivé des souvenirs enfouis.

Cette première médicale est le signe qu’il sera possible, à terme, d’utiliser les interfaces homme-machine pour améliorer les capacités cognitives du cortex cérébral. Ces travaux vont dans un premier temps servir dans le secteur de la santé mais pourraient également être utilisés dans d’autres domaines comme l’éducation ou la formation.

Article rédigé par Georges Simmonds pour RT Flash

IOP Science

|

|

|

|

|

|

|

|

|

Faut-il plutôt consommer des protéines animales ou végétales ? Pour répondre à cette question, une étude a été menée par des chercheurs californiens de Loma Linda University et par des chercheurs français de lINRA. Elle confirme la relation entre les protéines animales et le risque accru de maladies cardiaques alors que les protéines végétales sont confirmées comme bénéfiques à la santé cardiaque.

Alors que de précédentes études ont examiné les différences entre protéines animales et végétales, cette étude qui a choisi de mieux caractériser les protéines de viande et les protéines de noix et de grains ainsi que d'autres aliments suggère qu'il y a plus d'hétérogénéité dans la famille des protéines, que la catégorisation binaire « végétales » ou « animales ».

L'analyse menée sur les données alimentaires et les antécédents cardiovasculaires de 81.000 participants révèle que les personnes consommant de grandes quantités de protéines animales encourent un risque accru de 60 % de maladie cardiovasculaire alors que les personnes consommant de grandes quantités de protéines de noix et de grains entiers, bénéficient dune réduction de 40 % de ce risque.

De très nombreuses études ont déjà associé les graisses alimentaires et le risque de maladie cardiovasculaire, mais ici, il sagit bien des protéines qui peuvent, elles-aussi, avoir des effets indépendants importants sur le risque. Si l'ajout de noix et de graines dans le régime alimentaire protège contre les maladies cardiaques et vasculaires, alors que les viandes rouges augmentent le risque, cest également en raison du type de protéines. On « parle » de « mauvaises graisses » dans les viandes et de « graisses utiles » dans les noix ; ces résultats suggèrent de prendre également en compte les effets biologiques des protéines dans ces aliments.

Article rédigé par Georges Simmonds pour RT Flash

International Journal of Epidemiology

|

|

|

|

|

|

|

|

|

Comme vient encore de le montrer la dernière édition 2018 du congrés annuel de l'ASCO, l'immunothérapie s'affirme comme la nouvelle voie royale pour combattre efficacement de nombreux cancers. Des chercheurs américains de l'Université de Pennsylvanie, en collaboration avec des scientifiques suisses de l'Université de Vaud, ont mis au point et testé un vaccin thérapeutique prometteur contre le cancer de l'ovaire. Conçu à partir des propres cellules du système immunitaire des patientes, ce vaccin d'un nouveau genre est personnalisé, indique l'étude américano-suisse qui a inclus 25 patientes dans un essai clinique pilote. Ces cellules, dites "cellules dendritiques", ont été ensuite exposées en laboratoire in vitro aux cellules cancéreuses des patientes caractérisées par un ensemble de mutations uniques.

L'objectif était ensuite de ré-injecter ces cellules dans l'organisme des participantes pour déclencher une réaction immunitaire plus large permettant aux cellules immunitaires, les lymphocytes T, de mieux identifier et tuer les cellules cancéreuses. Le vaccin a été administré toutes les trois semaines, parfois jusqu'à 6 mois, précise l'étude conduite par l'Université de Pennsylvanie, à Philadelphie, et le Centre hospitalier universitaire vaudois (CHUV), à Lausanne.

"Ce vaccin semble être sûr pour les patients et suscite une large immunité anti-tumorale. Nous pensons qu'il justifie un nouveau test sur des cohortes plus larges" explique Janos L. Tanyi, professeur d'obstétrique et gynécologie à l'Université de Pennsylvanie et auteur de l'étude.

"Environ la moitié des patientes vaccinées ont bien répondu et ont eu tendance à vivre beaucoup plus longtemps sans progression de la tumeur", selon l'étude qui montre un taux de survie à deux ans de 100 % chez les femmes qui ont bien répondu au vaccin contre 25 % chez celles qui n'ont pas bénéficié du vaccin.

L'étude souligne le cas spécifique d'une femme de l'étude âgée de 46 ans, atteinte d'un cancer de l'ovaire de stade 4 au moment d'intégrer l'essai clinique. "Elle a reçu 28 doses de son vaccin personnalisé sur une période de deux ans et est ensuite restée sans maladie pendant cinq ans", selon les auteurs de l'étude. A plus long terme, les chercheurs espèrent améliorer l'efficacité de leur vaccin en le combinant avec d'autres traitements anti-cancéreux.

Article rédigé par Georges Simmonds pour RT Flash

Science Translational Medicine

|

|

|

|

|

|

|

|

|

Dans la lutte contre le lupus, déroutante maladie auto immune, l'étude pivot internationale de phase III du Lupuzor vient de s'achever avec des résultats positifs : ce candidat-médicament a été efficace pour 68,8 % des patients ayant suivi la phase d'essai jusqu'au bout. Le Lupuzor est le premier traitement spécifique non immunosuppresseur contre le lupus, une maladie auto-immune handicapante qui touche 5 millions de personnes dans le monde. Ce médicament a été découvert par l'équipe de Sylviane Muller, chercheuse CNRS alors au Laboratoire d'immunopathologie et chimie thérapeutique du CNRS à Strasbourg.

Débutée en décembre 2015 aux Etats-Unis, l'étude-pivot internationale de phase III du Lupuzor a été étendue ensuite en Europe et menée sur 202 patients répartis en deux groupes : le premier s'est vu administrer le Lupuzor, tandis que le deuxième recevait un placebo. L'ensemble des patients recevait également d'autres médicaments comme des stéroïdes, des antipaludéens, du méthotrexate, etc.

Parmi eux, 153 ont mené l'essai clinique à son terme. Malgré ce nombre relativement limité, cette phase d'essai a permis de démontrer l'efficacité du peptide découvert par Sylviane Muller, chercheuse au CNRS : le Lupuzor, associé aux traitements de fond, s'est montré efficace pour 68,8 % des patients qui le recevaient. A noter que 59,2 % des patients recevant le placebo et les traitements de fond ont également réagi positivement, un taux particulièrement élevé.

Le Lupuzor s'avère donc au moins aussi efficace que le seul traitement existant à ce jour. Mais contrairement à celui-ci, le Lupuzor n'est pas immunodépresseur, il ne diminue pas les défenses immunitaires des patients : la phase III a confirmé son innocuité exceptionnelle, aucun effet indésirable grave n'ayant été signalé.

Autre résultat encourageant : le Lupuzor a démontré un taux de réponse de 61,5 % pour les patients possédant des autoanticorps anti-dsDNA (un biomarqueur reconnu pour le lupus érythémateux systémique), contre 47,3 % avec le placebo. De plus, 7,6 % des patients du groupe LupuzorTM ayant des anti-dsDNA positifs sont entrés en rémission complète (anti-dsDNA absents et absence de signes cliniques), ce qui n'a été le cas d'aucun patient du groupe placebo.

Enfin, ces résultats renforcent l'intérêt potentiel de ce candidat-médicament dans le traitement d'autres maladies auto-immunes comme le syndrome de Sjögren (maladie des yeux secs) ou la maladie de Crohn (une maladie auto-immune à l'origine d'une inflammation chronique de l'intestin).

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

|

|

|

|

|

|

|

Une équipe de recherche franco-américaine conduite par le Professeur Leboulch (CEA/Facultés de médecine de l'Université Paris-Sud) a réussi, après 20 ans de travail, à mettre au point une thérapie génique efficace contre la bêta-thalassémie. Cette maladie génétique est rare en France, avec environ 600 malades, mais elle est bien plus fréquente au sein de certaines populations dans le pourtour méditerranéen, en Asie ou encore en Afrique noire.

Elle est provoquée par un défaut dans un gène qui perturbe la production de l’hémoglobine et qui se traduit par des globules rouges qui ne font plus assez bien leur travail et provoquent des anémies plus ou moins sévères, qu’il faut compenser par des transfusions.

Les premiers résultats d’un essai clinique, publiés le jeudi 19 avril dans la revue New England Journal of Medicine, prouvent l’efficacité d’un traitement de thérapie génique, où les mutations qui provoquent la maladie ont été corrigées dans les cellules des malades. En 2010, un premier malade avait été soigné avec cette technique, et l’essai clinique qui vient de se dérouler sur 22 malades prouve que ce succès n’était pas un cas isolé. Douze d’entre eux n’ont plus du tout besoin de transfusion sanguine, et trois autres ont pu réduire la fréquence de ces injections de globules rouges.

Avant de recevoir la dernière phase du traitement, le malade doit subir une cure de chimiothérapie, qui va venir tuer ses cellules de moelle osseuse "malades". Une fois injectées dans le sang du patient, ces cellules corrigées vont ensuite pouvoir prendre le relais et se multiplier, pour produire dans l’organisme des cellules sanguines fonctionnant normalement.

Pour 12 des 22 patients traités, les cellules génétiquement corrigées qu’ils ont reçues se sont bien implantées et ont permis de produire suffisamment d’hémoglobine saine pour qu’ils n’aient plus besoin de recevoir des transfusions sanguines régulières. Les malades qui ont reçu le traitement vont être suivis durant des années, notamment pour s’assurer que la modification génétique n’augmente pas chez eux les risques de cancers.

Une thérapie génique avec le même vecteur viral est également à l’essai sur une autre maladie de l’hémoglobine, la drépanocytose, où un gène défectueux produit des malformations des globules rouges. Le premier succès, sur un enfant de 13 ans, a été publié par les mêmes équipes scientifiques l’année dernière.

Article rédigé par Georges Simmonds pour RT Flash

Medical Xpress

|

|

|

|

|

|

|

|

|

Une équipe belge de recherche, dirigée par Ievgenia Pastushenko et Cédric Blanpain (Université Libre de Bruxelles) vient d'identifier, pour la première fois, les états de transition cellulaires survenant au cours de la progression du cancer et les sous-populations de cellules tumorales responsables de métastases dans les cancers.

Ces scientifiques ont étudié des modèles de cancers de la peau et du sein présentant une transition épithélio-mésenchymateuse : dans ce processus, les cellules tumorales épithéliales (qui forment les parois du tissu) perdent leur adhérence et acquièrent de nouvelles propriétés, comme une plus grande capacité de migration métastatique et une résistance au traitement médicamenteux.

Dans leur étude, les chercheurs ont découvert l'existence d'au moins 7 sous-populations cellulaires représentant différents états de transition épithélio-mésenchymateuse : de complètement épithéliales à complètement mésenchymateuses, passant par des états hybrides intermédiaires.

Ils ont également démontré que toutes les populations de cellules tumorales ne sont pas fonctionnellement équivalentes et ne possèdent pas les mêmes capacités métastatiques : les cellules tumorales avec un phénotype épithélio-mésenchymateuse hybride sont les plus métastatiques et sont notamment responsables des métastases pulmonaires.

Identifier ces états de transition des cellules cancéreuses et les propriétés spécifiques qu'elles acquièrent durant cette transition permet de mieux comprendre l'évolution de la maladie, la réponse aux traitements existants, et d'envisager de nouvelles stratégies pour bloquer la progression tumorale et les métastases.

Article rédigé par Georges Simmonds pour RT Flash

ULB

|

|

|

|

|

|

|

|

|

Une étude clinique réalisée par le Professeur Didier SCAVARDA, chef du service de neurochirurgie infantile, en collaboration avec le Professeur Fabrice BARTOLOMEI, chef du service d’épileptologie et de rythmologie cérébrale (Hôpital de la Timone – AP-HM et Aix-Marseille Université) vient de montrer qu'il est possible, sur certains patients épileptiques, de procéder à une déconnexion partielle efficace à 100 % de l'hémisphère cérébral lésé, sans détérioration des fonctions cognitives.

De nombreux patients ayant subi des accidents vasculaires cérébraux précoces, parfois en période anténatale, développent par la suite une forme d’épilepsie réfractaire aux traitements médicamenteux. Les crises brutales et les chutes consécutives contraignent ces personnes à porter constamment un casque et sont un obstacle majeur à leur intégration sociale. La technique chirurgicale la plus couramment utilisée est alors l’hémisphérotomie. Celle-ci consiste à déconnecter totalement l’hémisphère cérébral lésé, contraignant le patient à ne vivre qu’avec une moitié de son cerveau. Il s’agit d’une intervention lourde qui a pour conséquence une aggravation du déficit de langage et bien souvent une altération de la vue.

La technique mise au point par le Professeur Didier SCAVARDA et ses équipes s’appuie sur une exploration inédite du cerveau par stéréo-électro-encéphalographie (implantation d’électrodes intracérébrales).

Le constat est que la zone épileptogène est bien souvent beaucoup plus localisée qu’on ne le croyait, permettant un geste chirurgical de déconnexion partielle « sur-mesure », adapté à chaque patient et ne causant pas d’aggravation des déficits visuel et langagier.

Par ailleurs, l’amélioration globale de la qualité de vie et du pronostic fonctionnel est constamment rapportée par les familles. Déjà pratiquée sur six patients, la technique s’est avérée efficace à 100 %, avec une interruption des crises et une meilleure intégration sociale.

Article rédigé par Georges Simmonds

AP-HM

|

|

|

|

|

|

|

|

|

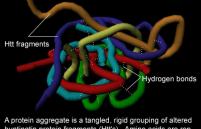

La maladie de Huntington est une affection neurodégénérative qui touche en France environ 18 000 personnes dont 12 000 sont encore sans symptômes. Elle se manifeste classiquement entre 30 et 50 ans par des mouvements brusques involontaires (chorée) et des troubles comportementaux et cognitifs. La pathologie est due à la mutation du gène codant la protéine huntingtine qui provoque une dégénérescence des neurones débutant dans le striatum, zone du cerveau impliquée dans le contrôle des mouvements. Les mécanismes qui conduisent à la neurodégénérescence sont encore largement incompris.

Des pistes existent néanmoins, parmi lesquelles des anomalies de la transcription. Une collaboration menée par des chercheurs de l'Institut François-Jacob, au MIRCenn, montre que la réduction de la production d'une enzyme, DCLK3, observée dans les neurones du striatum des malades ou d'organismes modèles de la pathologie, pourrait participer à la vulnérabilité des neurones en agissant de manière globale sur la transcription.

La fonction de DCLK3 est inconnue mais, selon des études très récentes, son activité pourrait moduler la survie des cellules. Les travaux du MIRCen montrent, dans un modèle murin de la maladie de Huntington, que réduire l'expression de DCLK3 exacerbe la toxicité du mutant de l'huntingtine. Inversement, augmenter la production de DCLK3 protège les neurones de la dégénérescence. Toujours dans un modèle murin de la maladie, rétablir un niveau suffisant d'expression de DCLK3 améliore certains symptômes moteurs. L'étude identifie in vitro sept partenaires potentiels de la protéine.

Étonnamment, ces candidats ont comme caractéristique commune d'être des régulateurs connus ou présumés de la transcription. En déterminant le niveau d'expression des gènes dans les neurones du striatum en fonction de l'activité de DCLK3, les chercheurs montrent que la protéine se comporte comme un régulateur de la transcription et du remodelage de la chromatine. En accord avec ces données, ils observent une fraction de DCLK3 dans le noyau des cellules, siège de la transcription.

Article rédigé par Georges Simmonds pour RT Flash

CEA

|

|

|

|

|

|

|

|

|

En oncologie, l’optimisation du traitement du cancer est l’un des objectifs premiers. En ce sens, l’Hôpital del Mar de Barcelone est le premier centre hospitalier d’Espagne à tirer profit de l’impression 3D pour traiter les tumeurs de taille réduite de certains types de cancers de la peau grâce à la plésiothérapie à fort débit de dose, une sorte de curiethérapie de contact (utilisation de sources de radiation situées à l’intérieur ou proches de la zone affectée).