|

|

Edito

Les robots ne vont pas supprimer le travail mais le transformer…

La machine et le progrès technique vont-ils remplacer l’homme et lui prendre son travail ? Si cette question semble au cœur de l’actualité et s’est même invitée dans le débat politique à l’occasion de la campagne pour les élections présidentielles, elle est en réalité aussi vieille que notre civilisation. Il y a vingt-cinq siècles, Aristote craignait déjà que l’usage généralisé de la force animale finisse par ruiner l’économie grecque en condamnant à l’inactivité de nombreux travailleurs et artisans. Depuis l’Antiquité, ce débat n’a jamais cessé et il y a deux siècles, la révolte des canuts à Lyon avait conduit à la destruction des métiers à tisser Jacquard qui avaient permis un gain considérable de productivité et mis de nombreux tisserands au chômage.

Depuis cet épisode tragique, le monde a connu cinq révolutions énergétiques (vapeur, pétrole, électricité, nucléaire et énergies renouvelables) et autant de révolutions informationnelles (téléphone, radio, télévision, informatique et Internet). Chacune de ces vagues technologiques a bouleversé nos économies et nos sociétés, entraînant, dans un premier temps, la destruction de millions d’emplois traditionnels et parfois la fin de secteurs entiers d’activité. Mais à chaque fois, dans une seconde phase, ces sauts technologiques majeurs ont permis la création d’une multitude de biens et services nouveaux qui ont eux-mêmes généré un nombre de nouveaux emplois finalement plus important que ceux initialement détruits !

En 2013, une étude conduite par deux chercheurs américains, Carl Benedikt Frey et Michael Osborne, avait fait sensation en concluant que 47 % des emplois aux Etats-Unis étaient automatisables ou le seraient d'ici à dix ou vingt ans. En 2014, le cabinet Roland Berger évoquait pour sa part 42 % d'emplois menacés en France.

Il n’en fallait pas plus pour que les média s’emballent et que fleurissent dans la presse et sur le Net dossiers, articles et émissions nous expliquant que l’homme était cette fois condamné à être partout remplacé par des robots et qu’il fallait se résigner et se préparer à la « fin du travail » qui deviendrait de plus en plus rare et difficile d’accès.

Mais ni l’économie, ni la prospective ne sont des sciences exactes et plusieurs études récentes sont venues remettre en cause ces prévisions péremptoires. Il y a d’abord eu la note d'analyse publiée mi-juillet par France Stratégie (Voir France Stratégie). Selon cet organisme de réflexion prospective rattaché à Matignon, seuls 15 % des emplois hexagonaux (3,4 millions de postes) seraient réellement automatisables» (25 % des emplois de service et 15 % des emplois industriels), c'est-à-dire, selon la méthodologie retenue par cette étude, « soumis à un rythme de travail qui n'est pas imposé par la satisfaction immédiate de la demande des clients ».

Si les prévisions sont aussi divergentes entre ces études, c’est parce que l'étude Osborne, comme l’étude Berger, raisonnait par profession automatisable, considérant chaque métier comme un tout homogène. De manière plus fine, France Stratégie propose pour sa part une analyse non par profession, mais en se focalisant sur les différentes tâches composant ces métiers. Et là, les conclusions deviennent très différentes car France Stratégie souligne que « de plus en plus d'emplois apparaissent peu automatisables en France en raison des interactions sociales et de l'adaptabilité qu'ils requièrent ». Ces emplois réfractaires à une automatisation intégrale seraient plus de 9 millions selon cette étude et auraient augmenté d’un tiers depuis 15 ans.

A contrario et prenant le contrepied de nombreuses idées reçues, l’étude montre qu’en France, le nombre d’emplois automatisables a diminué de 200.000 en quinze ans. Ce surprenant constat s’expliquerait par un processus d'adaptation continuelle du contenu des emplois aux évolutions technologiques. Concrètement, cela veut dire que les métiers se recentrent sur des tâches non automatisables, à plus forte valeur ajoutée et requérant des compétences relationnelles et sociales.

La mutation du secteur bancaire illustre parfaitement ce recentrage vers l’humain. La Royal Bank of Scotland a par exemple fait le choix d’utiliser le système d’intelligence artificielle d’IBM Watson pour rendre plus performants ses centres d’appel. Cet établissement a récemment ouvert un chatbot, baptisé « Luvo », qui parvient déjà à répondre de manière complétement autonome à 10 % des appels de la clientèle. Mais ce n’est qu’un début car, comme Watson est capable d’apprendre et d’enrichir sans cesse ses compétences, la banque estime que d’ici 5 ans, le système pourra traiter seul 80 % des demandes des clients. Résultat : les téléconseillers pourront se concentrer uniquement sur les requêtes à forte valeur ajoutée.

L'analyse de France Stratégie vient ainsi conforter les résultats d'une étude publiée mi-mai par l'OCDE qui concluait qu’en France, seul un emploi sur dix avait un risque élevé d'automatisation. Ces deux organismes soulignent également que le lien entre technologie et automatisation est bien plus complexe qu’on ne l’imagine. De nombreux emplois sont techniquement automatisables depuis des années et pourtant ils restent exercés par des humains pour de multiples raisons, meilleure rentabilité économique, acceptabilité sociale, etc. Il peut être en effet plus profitable, in fine, pour une entreprise de garder des employés humains pour remplir certaines tâches. C’est le cas par exemple pour les caissières de magasins, une fonction qui reste essentiellement assurée par des êtres humains, alors que depuis plus de 10 ans, il serait techniquement possible d’automatiser entièrement ce métier.

Il faut également rappeler que, si l’on parle abondamment des emplois détruits par la révolution numérique et robotique, on parle beaucoup moins des créations d’emplois nouveaux que permet cette même révolution, sans doute à cause du décalage dans le temps entre ces deux phénomènes. Certains, par exemple, se lamentent du fait que le numérique ait entraîné une diminution considérable du nombre de secrétaires depuis 25 ans. Mais ils oublient de dire, qu’au cours de la même période, plus de 300 000 postes d’ingénieurs en informatique et en télécoms ont été créés et que ces travailleurs hautement qualifiés sont aujourd’hui, en France, plus nombreux que les secrétaires…

Le rapport publié il y a un peu plus d'un mois par le Conseil d’orientation pour l’emploi (COE) va dans le même sens que ceux de France Stratégie et de l’OCDE et considère que « seule une faible part des emplois a un indice d’automatisation élevé ». Cette étude souligne toutefois que la vague numérique va transformer l’ensemble des métiers, y compris ceux qui requièrent un bon niveau d’études supérieures. Selon le COE, à terme, c’est plus de la moitié des emplois qui sont amenés à évoluer radicalement sous l’effet de l’intelligence artificielle et de l’automatisation. Ce rapport souligne également que, sur les 149 nouveaux métiers apparus depuis 2010, 105 appartiennent au domaine du numérique, ce qui confirme la théorie de la « destruction créatrice » selon laquelle les ruptures technologiques majeurs, si elles commencent par détruire massivement des emplois, finissent toujours par créer de nouvelles activités et de nouveaux métiers en quantité au moins égale à ceux détruits.

Les dernières recherches de l’OCDE soulignent également un autre point essentiel et montrent que, contrairement à l’hypothèse de l’étude d’Oxford, qui repose sur une extrapolation par catégorie de métiers, le contenu précis d’un métier peut considérablement varier d’une entreprise à l’autre, en fonction notamment de la culture managériale et de l’environnement local. Or, si l’on tient compte de ces facteurs, ce ne serait plus la moitié des emplois qui seraient menacés par le numérique et les robots, comme le prédit l’étude d’Oxford, mais à peine un emploi sur dix, ce qui change évidemment les perspectives…

On ne s’en étonnera pas, l’OCDE insiste sur le fait que, d’une manière générale, ce sont les travailleurs les moins instruits qui courent le plus de risque de voir leur emploi supprimé. « Si 40 % des travailleurs avec un niveau inférieur au deuxième cycle du secondaire occupent des emplois ayant un fort risque d’automatisation, moins de 5 % des travailleurs diplômés de l’enseignement universitaire sont dans le même cas », précise sur ce point l’OCDE.

Ce que montrent ces différentes études, c’est que l’avenir n’est pas écrit et que le scénario de la fin du travail et d’un chômage massif qui seraient des conséquences inévitables des révolutions technologiques en cours, n’est en aucun cas inéluctable. Les travaux de l’OCDE ont d’ailleurs bien montré que chaque emploi créé dans le secteur de la haute technologie entraîne la création de cinq emplois supplémentaires.

Quant à ceux qui opposent systématiquement robot et emploi, ils devraient méditer l’exemple du cuisiniste Schmidt. Cette entreprise qui a toujours maintenu ses usines en France a opté pour une l'automatisation poussée. Dans chacune de ses usines, les ouvriers ont été remplacés par des robots et deux agents très qualifiés suffisent à faire tourner chaque unité de production. Et le résultat est plutôt probant, puisque Schmidt parvient à présent à produire une cuisine sur mesure en une demi-journée, contre une semaine auparavant. Devenue ainsi plus rentable, plus productive et plus compétitive, mais également plus souple et mieux à même de répondre aux demandes personnalisées de ses clients, Schmidt a pu multiplier par trois ses effectifs et recrute une centaine de collaborateurs chaque année.

Denis Pennel, directeur général de la « World Employment Confederation » à Bruxelles ne croit pas non plus à cette théorie en vogue d’une raréfaction inévitable du travail. Il souligne que l’automatisation transforme en profondeur les emplois et modes de production mais que la substitution des emplois par les machines a historiquement toujours été compensée par la croissance de la production et l’invention de nouveaux biens et services.

Si l’on observe, depuis le début de la révolution industrielle, l’évolution des conséquences de la mécanisation, puis de l’automatisation sur les gains de productivité, on constate que ces derniers ont surtout réduit le temps de travail, qui ne représente plus que 10 % de la vie d’un travailleur aujourd’hui, contre plus de 40 % à la veille de la première guerre mondiale. En revanche, la prodigieuse évolution technologique qui va de la machine à vapeur de Watt à l’Internet et aux robots n’a pas empêché un accroissement considérable du nombre d’emplois et une augmentation tout aussi impressionnante de la population active.

Il est intéressant de souligner également que, selon l’OCDE, le ratio PIB par heure travaillée n’a progressé en moyenne annuelle que de seulement 1 % aux Etats-Unis sur les dix dernières années (2004-2014), contre 2,7 % sur la période 1997-2004. La tendance est similaire en Allemagne (0,8 % contre 1,5 %), en France (0,7 % contre 2 %), au Royaume-Uni (0,4 % contre 2,4 %) et au Japon (0,8 % contre 1,9 %).

Toutefois ces gains de productivité moyenne annuelle pourraient sensiblement augmenter, selon le dernier rapport de l’Institut McKinsey, récemment publié. Cette étude estime en effet que robots et automatisation pourraient améliorer considérablement la performance des entreprises et augmenter la productivité à l'échelle mondiale, qui passerait de 1 % à 1,4 % par an d’ici 20 ans (Voir Mc Kinsey & Company). Globalement, ce rapport estime à 49 % la part des activités entièrement automatisables d’ici 2050 mais considère que seuls 5 % des métiers pourront être entièrement automatisés au cours du prochain quart de siècle. L’impact socio-économique de ce processus d’automatisation du travail devrait cependant être à terme considérable et pourrait concerner 54 millions d'équivalents temps plein dans les cinq plus grandes économies européennes : France, Allemagne, Italie, Espagne, et Royaume-Uni. Mais, dans le même temps, les nouvelles technologies numériques vont créer une multitude d’activités et d’emplois nouveaux, en décuplant les possibilités d’offre économique totalement personnalisée.

Contrairement à beaucoup d’idées reçues, les pays qui comptent actuellement le plus fort taux de robotisation par habitant sont aussi ceux qui connaissent le niveau de chômage le plus faible. C’est notamment le cas en Allemagne, en Suisse, en Suède, au Danemark, au Japon et en Corée du Sud. Cette apparente contradiction s’explique en grande partie par le fait que ces pays consacrent des moyens très importants pour dispenser à leurs habitants le meilleur niveau d’éducation et de formation professionnelle possible. Ces états ont également fait le choix de mettre en œuvre des politiques ambitieuses de recherche et d’innovation, y compris dans le temps long de la recherche fondamentale, celle qui n’est pas immédiatement rentable mais finit par provoquer des ruptures technologiques majeures. Enfin, et ce point essentiel est curieusement peu évoqué, ces pays sont également ceux qui proposent à leurs habitants les meilleurs couvertures d’accès à l’Internet à très haut débit, fixe et mobile.

Ce ne sont donc pas les robots, l’intelligence artificielle et les outils numériques qui, intrinsèquement, détruisent des emplois et conduisent à une raréfaction du travail. Mais il est vrai que ces conséquences sociales et humaines très négatives peuvent survenir quand les bouleversements technologiques affectent très rapidement des sociétés qui ne sont pas préparées à les recevoir et n’ont pas anticipé ces ruptures en actionnant simultanément quatre leviers puissants et indissociables : une éducation de très haut niveau pour tous, une offre riche et adaptée de formation professionnelle individualisée tout au long de la vie, un effort suffisant d’innovation et de recherche fondamentale à long terme et enfin un accès pour tous à l’Internet à très haut débit.

Je suis persuadé que si nous nous donnons les moyens de construire ce cadre gagnant, nous cesserons de voir les révolutions technologiques actuelles comme des mouvements déstabilisateurs que nous devons subir et redouter, en espérant que nous garderons la tête hors de l’eau, et nous verrons au contraire tout l’immense potentiel d’épanouissement individuel et de production de richesse collective que constituent ces sauts technologiques, en termes de création d’activités nouvelles et d’emplois à la fois plus nombreux, plus riches et plus variés que ceux du passé.

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Après un traumatisme ou un accident vasculaire, des patients peuvent développer le locked-in syndrome (LIS). Cette maladie neurologique très rare les emprisonne dans leur propre corps. Ils sont conscients de ce qui se passe autour d’eux mais ils ne peuvent pas interagir avec le monde extérieur, excepté par des mouvements des yeux ou un clignement des paupières.

Mais ce mode de communication pourrait être bouleversé par la découverte d’une équipe du Centre de neuro-ingénierie Wiss (Suisse) qui a mis mis au point une interface cerveau-machine non invasive capable de déchiffrer les pensées de ces patients paralysés. Celle-ci fonctionne grâce à des électrodes placées sur le crâne mesurant le taux d’oxygène dans le cerveau. Ces informations sont ensuite envoyées à un ordinateur chargé de les traduire.

Pour tester leur interface, les scientifiques ont sélectionné 4 personnes souffrant de sclérose latérale amyotrophique, plus connue sous le nom de maladie de Charcot ou maladie de Lou Gherig. Ces volontaires souffraient d’un locked-in syndrome sévère puisqu’ils ne pouvaient pas communiquer avec les yeux.

Mais grâce à l’invention des ingénieurs, ces volontaires ont pu répondre "oui" ou "non" à des questions personnelles telles que « Votre mari s’appelle Joachim ? » ou « Votre mère s’appelle Gargit ? ». Dans 70 % des cas, ils ont réussi à obtenir une réponse. Interrogée par son mari pour qu'elle donne sa bénédiction aux fiançailles de sa fille, une des participantes a répété 9 fois qu'elle était contre, ont également précisé les auteurs.

"Ces résultats remarquables ont chamboulé ma propre théorie selon laquelle les patients souffrant d’un LIS complet sont incapables de communiquer", a confié le Professeur Niels Birbaumer, neuroscientifique et auteur de l’étude. "Nous avons constaté que les 4 patients ont pu répondre à ces questions en utilisant uniquement leurs pensées. Si nous sommes capables de répliquer ces résultats chez un plus grand nombre de malades, je crois que nous pourrions restaurer des capacités de communication chez ces malades".

Article rédigé par Georges Simmonds pour RT Flash

Plos

|

|

|

|

|

|

|

|

|

Le Laboratoire d'analyse et d'architecture des systèmes (LAAS) du CNRS a mis au point PYRENE, un étonnant robot humanoïde conçu pour mieux interagir avec son environnement et effectuer des tâches qui nécessitent une certaine force physique. Ses impressionnantes capacités en termes de calcul, d'actionnement et de perception, lui permettront d'exécuter tout un ensemble de tâches qui n'étaient pas réalisables avec la génération précédente de robots humanoïdes. Ce nouveau robot dispose d'une électronique puissante et de capteurs d'efforts au niveau de ses articulations.

Actuellement, le robot est capable d'effectuer des mouvements de base incluant la marche. D'ici quelques mois, lorsque la programmation sera plus avancée, la plate-forme PYRENE permettra de réaliser des tâches complexes telles que la locomotion sur des terrains accidentés, et plus seulement sur des sols plats, ou l'interaction en toute sécurité avec les êtres humains. Des tâches nécessitant une forte puissance, comme le port de lourdes charges à bout de bras, pourront également être réalisées, ce que les plates-formes existantes ne peuvent effectuer à l'heure actuelle.

PYRENE est un outil essentiel pour contribuer à l'étude du mouvement du corps anthropomorphe, dans le but d'aider l'Homme dans l'exécution de tâches difficiles dans des contextes divers.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Des chercheurs de l’Université de Floride Centre viennent de mettre au point une batterie aux propriétés particulièrement innovantes. Non seulement cette batterie peut durer plusieurs jours et offrir une autonomie inégalée à votre terminal mobile, mais en plus, elle ne demande que quelques secondes de mise sous tension pour se charger.

Comme il s’agit d’un prototype expérimental, elle ne sera pas encore commercialisée avec les prochains téléphones. Cependant, elle tient déjà toutes ses promesses puisque le procédé attire l’attention des fabricants de terminaux mobiles pour pouvoir l’adapter à une production à grande échelle. Le vrai défi est donc de trouver la version commerciale à prix réduit qui permettra de la produire en masse pour équiper les téléphones de nouvelle génération.

Cette batterie sera capable de stocker de l’énergie de manière statique en surface. Elle fonctionnera donc très différemment des batteries lithium-ion actuelles qui sont basées sur des réactions chimiques et qui sont actuellement au cœur de la polémique (des cas d’explosion ont été répertoriés).

Les propriétés du graphène ont été exploitées pour développer une nanostructure complexe et permettre une charge pouvant durer jusqu’à une semaine d’utilisation. Et cerise sur le gâteau, elle aura également une durée de vie plus longue puisqu’elle pourra recevoir jusqu’à 30 000 cycles de charge contrairement, soit toute une décennie d’utilisation. En outre, la batterie sera de plus en plus fine. Elle sera pratiquement de l’épaisseur d’une fine feuille de métal.

Article rédigé par Georges Simmonds pour RT Flash

Engadget

|

|

|

|

|

|

|

|

|

Des physiciens de l'Institut Néel (CNRS), en collaboration avec des chercheurs japonais et allemands, ont conçu et réalisé un dispositif permettant de transférer l'information stockée sur le spin d'un électron unique entre deux boîtes quantiques distantes de 4 microns.

Pour parvenir à ce résultat, les chercheurs ont réalisé un canal vide d'électron entre deux boîtes semi-conductrices et propulsé dans ce canal l'électron stocké dans l'une des deux boîtes à l'aide d'une onde acoustique de surface. La durée de transfert, de l'ordre la nanoseconde, est alors assez rapide pour que l'information portée par l'électron ne soit pas détruite par les mécanismes de décohérence.

Pour réaliser leurs boîtes quantiques, les chercheurs ont déposé de fines grilles d'or à la surface d'une couche d'arséniure de gallium et d'aluminium (AlGaAs) déposée sur un substrat d'arséniure de gallium (GaAs). Ils piègent ainsi des électrons se déplaçant librement à l'interface entre les deux matériaux semi-conducteurs à l'aide du potentiel électrostatique créé par les grilles. Ce dispositif leur permet aussi de réaliser in situ un électromètre qui leur permet de mesurer simultanément la présence d'un électron dans la boîte et son état de spin.

En répétant cette procédure une dizaine de milliers de fois, les physiciens ont quantifié la fidélité du transfert d'information. Celle-ci approche actuellement les 65 %. Elle est limitée pour l'instant par des processus de dépolarisation de spin principalement actif au cours l'injection entre boîtes quantiques statiques et en mouvement.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

| ^ Haut |

|

|

|

|

|

|

|

Espace |

|

|

Espace et Cosmologie

|

|

|

|

|

|

|

|

|

|

C'est une découverte tout à fait exceptionnelle que vient d'annoncer la NASA le 22 février dernier : grâce à Spitzer, le télescope spatial de la Nasa, l’équipe de Michaël Gillon (Université de Liège) a pu observer pendant trois semaines, à l’automne 2016, sept exoplanètes qui orbitent autour d’une "naine rouge", une étoile plus petite et plus froide que notre Soleil située à seulement 40 années-lumière de la Terre. Trois de ces planètes, qui ont la taille de la Terre, pourraient abriter de l’eau sous forme liquide à leur surface.

« À présent, nous avons la bonne cible » pour rechercher la présence de vie éventuelle sur des exoplanètes, a déclaré Amaury Triaud, de l'Université de Cambridge, coauteur de l'étude. Les sept planètes, qui pourraient avoir des températures assez proches de celles de la Terre, tournent autour d'une toute petite étoile peu lumineuse et ultra-froide, TRAPPIST-1, située dans notre galaxie, à "seulement" 40 années-lumière de nous.

« Vingt ans après les premières exoplanètes, il s'agit sans nul doute d'une des plus grandes découvertes dans le domaine des planètes extrasolaires », estime Didier Queloz, de l'Université de Genève, coauteur de l'étude. L'équipe internationale, dirigée par l'astronome belge Michaël Gillon de l'Université de Liège, avait déjà découvert fin 2015 trois de ces planètes à partir du petit télescope TRAPPIST de l'ESO (Observatoire européen austral) basé au Chili.

« C'est la première fois que l'on détecte autant de planètes de taille terrestre, dont trois potentiellement habitables, pour lesquelles une étude poussée est possible avec la technologie actuelle, y compris la détermination de la composition atmosphérique et la recherche de traces chimiques de vie », précise Michaël Gillon, principal auteur de l'étude. Le système planétaire a été détecté grâce à la méthode des transits. Elle permet de repérer la présence d'une planète lorsque celle-ci passe devant le disque de son étoile, car cela provoque une légère baisse de la luminosité (appelée transit).

« Ce qui est surprenant, c'est que les sept planètes ont une grande régularité en taille », souligne Franck Selsis, chercheur CNRS à l'Université de Bordeaux, et coauteur de l'étude. Leur rayon est plus ou moins 15 % celui de la Terre. Elles ont des insolations et donc des températures moyennes proches de celles de la Terre. Six de ces planètes tournent autour de la naine rouge en 1,5 à 12 jours. Elles sont beaucoup plus proches de leur étoile que la Terre du Soleil. Du fait des forces de marée, elles présentent toujours la même face à leur étoile.

Trois des planètes (TRAPPIST-1 e, f et g) se trouvent dans la zone "habitable" du système, c'est-à-dire susceptible d'abriter de l'eau liquide sur la majeure partie de la surface. « C'est le Graal pour les astronomes », souligne l'ESO. « L'eau liquide est un pré-requis à l'existence de la vie », même si cela n'est pas une condition suffisante, car il faut aussi « la présence des bonnes molécules », rappelle Franck Selsis.

Grâce au contraste de taille favorable entre les planètes et leur petite étoile, ces chercheurs vont pouvoir mesurer leur atmosphère avec le télescope spatial James Webb qui sera lancé par la Nasa en 2018. "Ce nouvel outil va nous permettre de caractériser les propriétés des atmosphères de ces planètes et peut-être même de trouver des biomarqueurs, c'est-à-dire des molécules comme l'eau, l'ozone, le gaz carbonique, le méthane, qui pourraient indiquer qu'il y a de la vie sur ces planètes", précise Michaël Gillon.

Depuis 1996, date de la découverte de la première exoplanète, près de 5000 exoplanètes ont été découvertes et les scientifiques estiment qu'il y aurait au bas mot un milliard de planètes dans notre galaxie qui seraient en orbite dans la zone dite "habitable", c’est-à-dire ni trop proche, ni trop lointaine de leur étoile, ce qui permettrait à ces planètes de réunir les conditions rendant possible l'apparition de la vie…

Article rédigé par Georges Simmonds pour RT Flash

NASA

|

|

|

|

|

|

|

|

|

Une équipe de recherche, conduite par l'EPFL de Lausanne et le Max Planck Institute, a procédé à une nouvelle mesure de la fameuse Constante de Hubble, qui indique la vitesse de l'expansion de l'Univers. Cette nouvelle mesure remet en cause certaines des mesures les plus récentes et pointe potentiellement vers une nouvelle physique, au-delà du Modèle Cosmologique Standard.

Pouvoir mesurer à quelle distance des objets se situent dans l'espace a conduit à de grandes découvertes, par exemple celle que notre Univers est en expansion. La vitesse d'expansion est déterminée par le Modèle Cosmologique Standard en vigueur, "Lambda CDM", qui fixe la vitesse d'expansion actuelle à environ 72 km par seconde par mégaparsec (un mégaparsec représente environ 3,3 millions d'années-lumière).

Cette vitesse est appelée "Constante de Hubble", et a été constamment affinée pendant près d'un siècle : une mesure de haute précision de H0 a des implications profondes, autant en cosmologie qu'en physique. Grâce à de nouveaux outils, ces travaux ont permis de calculer de manière indépendante la très importante Constante de Hubble avec une précision de 3,8 %. Le nouveau chiffre correspond à celui d'études récentes, qui cependant sont en contradiction avec les prédictions du Modèle Cosmologique Standard, et pointent vers une nouvelle physique.

L'expansion de l'Univers, qui se fonde sur l'idée que l'Univers est né avec le Big Bang, a été suggérée pour la première fois par le cosmologiste belge Georges Lemaître. A peu près en même temps, à la fin des années 1920, l'astronome Edwin Hubble étudiait des galaxies qui s'éloignaient de la Voie Lactée ; il remarqua que les plus éloignées de la Terre semblaient se déplacer plus rapidement. Ce qu'il observait en réalité, c'était l'Univers en expansion, et il s'attacha à calculer son taux d'expansion. Les observations de Hubble ont conduit à une constante qui quantifie cette expansion, et qui sera appelée plus tard la "Constante de Hubble".

Cette équipe est parvenue à mesurer la Constante de Hubble de manière indépendante, en exploitant un phénomène cosmique appelé "lentilles gravitationnelles", dans lequel la masse énorme des galaxies courbe l'espace-temps. Les galaxies agissent alors comme des lentilles qui peuvent agrandir et déformer l'image normalement diffuse d'objets situés plus loin.

Elles peuvent aussi produire plusieurs images des objets originaux "lentillés", et les faire apparaître multiples. Pour mesurer la Constante de Hubble, les scientifiques ont étudié la lumière en provenance de cinq quasars vus de manière démultipliée en raison de l'effet de lentille gravitationnelle produit par des galaxies situées à l'avant-plan.

Les quasars sont des trous noirs supermassifs au centre de galaxies, qui émettent de gigantesques quantités d'énergie électromagnétique. La magnitude des quasars présente des variations aléatoires au fil des ans, dont il résulte une oscillation apparente de leur intensité. Cette oscillation est vue de manière décalée dans chaque lentille gravitationnelle, parce que la lumière emprunte des chemins différents dans chaque image. Par conséquent, le fait de mesurer le décalage temporel entre les lentilles gravitationnelles offre un moyen de déterminer la Constante de Hubble.

Avec cette technique, la Constante de Hubble a été mesurée avec une précision de 3,8 % dans le cadre du Modèle Cosmologique Standard. Cette mesure est indépendante des autres méthodes, les trois lentilles gravitationnelles consistant en elles-mêmes en une sonde cosmologique ne se fondant sur aucune autre mesure. Ces résultats confirment les limites du modèle standard et confortent l'existence de l'énergie sombre qui accélère l'expansion de l'Univers.

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

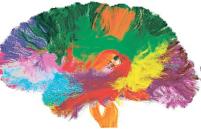

Selon une étude conduite par des chercheurs italiens, américains et anglais, notre personnalité serait liée à l'anatomie de notre cerveau. Ces scientifiques ont examiné des données d'imagerie cérébrale collectées chez plus de 500 individus jeunes et en bonne santé. A l'aide du modèle des "Big Five", utilisé en psychologie, ils ont également évalué leur degré de névrosisme (changements d'humeur), d'extraversion (enthousiasme), d'ouverture d'esprit, d'amabilité et de conscience (capacité de se percevoir et se comporter de manière adaptée).

En croisant ces données, les scientifiques sont arrivés à la conclusion que chacun de ces traits de personnalité pouvait être associé à un ensemble de trois caractéristiques du cortex cérébral (la matière grise qui entoure notre cerveau) : son épaisseur, sa surface et ses plissures.

Les personnes névrosées auraient par exemple tendance à avoir un cortex plus fin, moins plissé et d'une surface plus petite dans les régions préfrontales. Les personnes plus curieuses, créatives, avec une préférence pour la nouveauté (ou "ouvertes") auraient à l'inverse une surface plus importante et davantage de plissures dans ces régions.

"Elément intéressant, beaucoup de ces variations sont localisées dans le cortex préfrontal, un ensemble de régions du cerveau ayant connu une évolution significative chez les êtres humains et les singes en comparaison des autres espèces", note l'étude.

"L'évolution a adapté l'anatomie de notre cerveau de façon à maximiser sa surface et ses plissures aux dépens de l'épaisseur du cortex", "comme si on étirait puis compressait une feuille de caoutchouc", illustre l'un des auteurs, Luca Passamonti. Ce processus d'"étirement du cortex" se reproduit également au cours de la vie. "L'épaisseur du cortex tend à décroître tandis que la surface et les plissures augmentent", explique-t-il. Notre personnalité serait donc liée, dans une certaine mesure, à la maturation de notre cerveau, selon l'étude.

Ces découvertes ouvrent de nouvelles perspectives à la compréhension et au traitement des maladies neuropsychiatriques dès le plus jeune âge. Dans le cas d'un individu malade, il est en effet probable que ces différences structurelles soient encore plus prononcées.

Article rédigé par Georges Simmonds pour RT Flash

S.C.A.N.

|

|

|

|

|

|

|

|

|

Deux algues sont revenues en relativement bonne santé d’un voyage de deux ans dans l'Espace (dans la Station spatiale internationale) puis d'un séjour de 16 mois à l’extérieur, seulement protégées du vide par un filtre neutre réduisant les effets des radiations.

Ces deux souches sont revenues sur Terre le 18 juillet 2016 par une capsule Soyouz. Les chercheurs ont mis plusieurs mois pour vérifier qu’elles reprenaient bien leur croissance. Et le résultat –incroyable– vient juste de tomber. Les fonctions vitales sont bien reparties. Mais les chercheurs ne veulent pas seulement savoir si les algues peuvent survivre en orbitre terrestre. Ils s’intéressent aussi à la réponse des cellules dans le vide aux rayonnements UVA, UVB et UVC.

"Nous nous attendions à ce que les organismes survivent au vide et aux températures fluctuant entre -20°C et +50°C aussi bien qu’aux rayonnements UVA et UVB, explique Thomas Leya. Mais nous avons été surpris de voir que les souches algales sont restées indemnes d’une exposition à des rayonnements UVC extrêmement destructeurs". Les biologistes vont désormais étudier les stratégies d’adaptation des cyanobactéries et des algues vertes. Les rayons UV peuvent en effet endommager l’ADN humain. Aussi est-il intéressant de voir si l’ADN de ces algues a été endommagé, dans quelles régions de l’ADN et dans quelles proportions.

Les retombées de ces recherches sont multiples. L’intérêt le plus évident porte sur l'exploration de Mars. En cas de colonisation de la planète rouge, les algues qu’on imagine pousser dans des serres pourraient produire de la nourriture et de l’oxygène. En sciences de la vie, cette expérience redonne une certaine vigueur à l’hypothèse d’une origine extraterrestre de la vie sur Terre. Mais les sciences appliquées sont aussi concernées. Les composants protecteurs des algues pourraient ainsi être extraits pour des crèmes solaires anti-UV. Et l’industrie agroalimentaire pourrait s’emparer des compléments nutritionnels présents dans ces organismes.

Article rédigé par Georges Simmonds pour RT Flash

Phys.org

|

|

|

|

|

|

|

|

|

Selon une étude de l’Université de Californie, consommer du raisin deux fois par jour pendant six mois prévient le déclin métabolique que l’on observe dans les parties du cerveau atteintes par la maladie d’Alzheimer.

Ces travaux ont porté sur des personnes atteintes d’un léger déclin cognitif en stade précoce. Le premier groupe a consommé une poudre réalisée à partir de raisins complets, en quantités équivalentes à deux tasses et demi de grappes par jour. Le second groupe, quant à lui, a reçu pour placebo une poudre sans polyphénol, cette molécule organique contenue dans le raisin.

Après six mois de ce régime, les performances cognitives des deux groupes ont été évaluées grâce à des tests et des « scanners PET », méthode d’imagerie qui permet de mesurer l’activité métabolique d’un organe. Les chercheurs ont pu constater un fonctionnement métabolique normal dans la zone cérébrale des participants du premier groupe. Ceux qui appartenaient au second groupe, en revanche, ont manifesté un déclin cognitif caractérisé par une faible activité métabolique de cette zone, suggérant une évolution défavorable de la maladie.

Par ailleurs, le régime enrichi en raisin était associé à des améliorations métaboliques dans une autre région cérébrale impliquée dans la cognition et la mémoire. Les polyphénols du raisin possèdent des propriétés anti-inflammatoires et sont des antioxydants, qui ont un effet protecteur sur le cerveau. La littérature suggère que cet effet est à l’origine d’une réduction du stress oxydatif et d’un meilleur afflux sanguin dans cet organe.

« Cette étude pilote s’ajoute aux travaux démontrant les bénéfices du raisin pour la santé neurologique et cardiovasculaire, même si d’autres études cliniques incluant de plus larges groupes sont nécessaires pour confirmer les résultats que nous avons observés », concluent les chercheurs.

Article rédigé par Georges Simmonds pour RT Flash

Science Direct

|

|

|

|

|

|

|

|

|

L’asthme est une maladie fréquente qui touche plus de 4 millions de personnes en France. Les premières manifestations de cette inflammation chronique des bronches surviennent le plus souvent pendant l’enfance. De nombreux facteurs de risque comme le tabagisme, l'obésité, la pollution atmosphérique et les symptômes dépressifs et anxieux lui ont été imputés. Et si de nombreux patients asthmatiques ont des troubles du sommeil, le phénomène inverse n'avait jusqu'à présent jamais été étudié.

Une équipe de chercheurs de l'Université norvégienne de sciences et de technologie (NTNU) à Trondheim a décidé d'explorer l'association entre insomnie, définie comme le fait d'avoir des difficultés à trouver ou maintenir son sommeil ou d'avoir un sommeil de mauvaise qualité, et le risque de développer un asthme à l'âge adulte. Pour mener à bien leurs travaux, les scientifiques se sont servis des données d'une enquête norvégienne intitulée HUNT (Nord- Trondelag Health Study) dans laquelle 17 926 participants de 20 à 65 ans avaient été sélectionnés.

Tous ont dû renseigner l'équipe sur leurs problèmes de sommeil (difficultés d'endormissement, réveils nocturnes et mauvaise qualité de sommeil) et sur les symptômes d'asthme, en début et fin d'étude. Et les résultats rapportés sont sans appel. Ils indiquent que les volontaires ayant signalé des difficultés à l'endormissement « souvent » ou « presque chaque nuit » au cours du mois précédent avaient un risque accru respectivement de 65 % et de 108 % de développer un asthme dans les 11 ans à venir.

Par ailleurs, ceux qui indiquaient s'être réveillés en pleine nuit et avoir eu du mal à retrouver le sommeil « souvent »ou « presque tous les soirs » voyaient leur risque augmenté de 92 % et 36 %. S'agissant des patients se plaignant d'avoir un sommeil de mauvaise qualité ou peu réparateur plus d'une fois par semaine, leur risque de développer un asthme s'accroissait de 94 %.

Pour finir, les chercheurs se sont enfin intéressés aux insomniaques chroniques qui avaient fait part d'au moins un signe d'insomnie au début de l'étude, puis 10 ans plus tard. Ils ont découvert que leur risque de devenir asthmatique triplait par rapport à ceux qui n'étaient pas insomniaques.

Article rédigé par Georges Simmonds pour RT Flash

Medscape

|

|

|

|

|

|

|

|

|

Des chercheurs de l’Université de Pennsylvanie (Etats-Unis) ont annoncé que leur vaccin expérimental concernant le virus Zika protège quasiment à 100 % des cobayes de laboratoire en une seule dose. "Nous avons observé une protection immunitaire rapide et durable sans effets secondaires, ce qui nous fait dire que notre vaccin-candidat est une stratégie prometteuse dans la lutte contre le virus Zika", a décrit le Professeur Drew Weissman, infectiologue à l’Université de Pennsylvanie.

Ce nouveau vaccin développé en collaboration avec l’Institut américain de l’allergie et des maladies infectieuses n’a pas été conçu avec un virus atténué comme c’est le cas pour de nombreux autres vaccins anti-Zika en cours de développement. A ce jour, un seul d’entre eux s’est révélé efficace chez l’animal, précisent les auteurs.

Ces derniers ont donc choisi une autre voie en utilisant des fragments du virus porteurs de ses caractéristiques génétiques. Chez la souris, ils ont découvert qu’une seule injection de ces molécules induit une réponse immunitaire efficace. Deux semaines plus tard, les rongeurs ont été exposés au virus Zika, mais aucun n’a présenté de charge virale détectable les jours suivants, une protection maintenue cinq mois après la vaccination. Les tests effectués chez des singes ont aussi montré qu’une seule dose suffit à apporter une protection pendant plusieurs mois.

Dans les deux cas, l’immunisation a provoqué la formation d’une grande quantité d’anticorps dirigés contre le virus Zika. Ce taux semble par ailleurs atteindre son pic à la 7e semaine post-vaccination. "Notre étude suggère que cette nouvelle stratégie vaccinale génère une quantité d’anticorps neutralisants 25 fois plus importante que celle observée avec les autres vaccins", se réjouit le Professeur Weissman qui souligne qu’elle pourrait même se maintenir des années.

"Si le vaccin est efficace après une seule injection, l’infrastructure nécessaire sera beaucoup plus simple. La production de ce type de vaccin est également plus simple et moins chère que celle des vaccins traditionnels", ajoute le spécialiste. L’équipe espère pouvoir lancer des essais cliniques chez l’homme d’ici 12 à 18 mois.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

L’Institut américain des allergies et des maladies infectieuses (NIAID) a présenté des résultats encourageants sur une nouvelle voie thérapeutique prometteuse contre la sclérose en plaques.

L’essai clinique baptisé HALT-MS, porte sur 24 patients et évalue une thérapie par cellules souches sanguines associée à un traitement immunosuppresseur (HDIT/HCT). Il a donné des résultats plus que satisfaisants. Cinq ans après le traitement, la sclérose en plaques ne s’est plus manifestée pour 69 % des patients : pas d’évolution des symptômes, pas de rechute, pas de nouvelles lésions nerveuses… Plus intéressant encore, certains symptômes préexistants ont régressé ; et ces résultats pleins d’espoir ont été obtenus sans aucun traitement supplémentaire.

La thérapie compte trois étapes. Dans un premier temps, des cellules hématopoïétiques sont prélevées chez les patients et cultivées en laboratoire. Ces cellules souches sont à l’origine de toutes les lignées de cellules sanguines : globules rouges, globules blancs et plaquettes. Avant leur réimplantation, les malades subissent une thérapie visant à détériorer leur système immunitaire. Avec l’apport ultérieur de cellules souches, ce dernier est en quelque sorte « réinitialisé ».

Car c’est en effet le système immunitaire qui est responsable de la sclérose en plaque, dite autoimmune. Une altération de son fonctionnement le pousse à attaquer et détruire la gaine de myéline qui entoure les cellules nerveuses. Les voies nerveuses sont alors atteintes et leur capacité à transmettre l’information est altérée, provoquant notamment des troubles de l’équilibre et musculaires qui altèrent la marche, des atteintes oculaires, ou encore des troubles de la sensibilité et des paralysies faciales.

Le traitement a été testé sur des patients souffrant de sclérose en plaques rémittente. Cette forme de la maladie est caractérisée par des poussées, qui peuvent durer quelques semaines, avant de régresser. Elle concerne 85 % des malades.

"Les données suggèrent qu’un traitement unique par HDIT/HCT pourrait être plus efficace que les meilleurs traitements à long terme disponibles pour les patients atteints de ce type de sclérose en plaques", estime le directeur du NIAID, Anthony Fauci. "Ces résultats encourageants soutiennent l’idée du développement d’un grand essai clinique randomisé, qui nous permettrait de comparer ce traitement aux traitements standard de cette maladie souvent invalidante".

Article rédigé par Georges Simmonds pour RT Flash

Neurology

|

|

|

|

|

|

|

|

|

Une équipe italo-américaine (Université de Trento et Université du Maryland) a développé des cellules artificielles qui peuvent chimiquement communiquer avec les bactéries. Selon ces chercheurs, les bactéries échangent constamment des messages et les “mots” sont des molécules synthétisées par leurs gènes qui s’envolent vers l’extérieur en traversant les membranes cellulaires. Quand ces molécules atteignent une autre bactérie, elles pénètrent leur membrane, atteignent l’ADN et déclenchent l’activation de gènes. Ceux-ci produisent alors des molécules “réponse”, lesquelles entraînent à leur tour l’activation de gènes de la première bactérie et ainsi de suite.

Lorsque les cellules artificielles ont été placées près de trois espèces différentes de bactéries vivantes — E. coli, Vibrio fischeri et Pseudomonas aeruginosa —, ces premières ont commencé à produire des protéines en réponse à ces dernières, suggérant ainsi aux chercheurs qu’elles étaient « à l’écoute » de leurs voisins bactériens. Mais il ne suffit pas simplement « d’écouter » lors d’une conversation.

Si vous souhaitez convaincre une personne que vous êtes tout aussi vivante, vous devez vous engager dans un dialogue. Une fois que les chercheurs ont pu prouver que leurs cellules artificielles avaient été détectées par les bactéries vivantes, ils leur ont donné la possibilité de communiquer avec elles en produisant leurs propres composés chimiques qui pourraient être interprétés par les bactéries.

Ce processus imite ainsi la façon dont les formes de vie simples communiquent entre elles dans la nature, ce qui signifie que nous pourrions théoriquement créer des cellules qui agissent comme médiateurs pour les organismes qui ont des problèmes de connexion : « ces cellules artificielles peuvent détecter les molécules qui sont naturellement sécrétées par des bactéries et, en réponse, synthétiser et libérer des signaux chimiques vers ces bactéries », explique Sheref S. Mansy, de l’Université de Trento, en Italie.

Il reste encore néanmoins beaucoup de chemin à parcourir. Comme l’explique le chercheur : « la machinerie nécessaire pour la production des protéines à partir de plans d’ARN a été isolée à partir de bactéries vivantes avant d’être implantée dans les cellules artificielles, mais le scénario idéal serait d’avoir des cellules produisant leur propre machinerie de traduction ».

Cela dit, le fait que des bactéries vivantes puissent finalement ne pas faire la différence signifie que nous pourrions utiliser des cellules artificielles pour faciliter la connexion de vastes et complexes réseaux d’organismes. Le contraire pourrait également être possible. L’équipe a constaté que dans certains cas, les cellules artificielles pouvaient interférer avec l’activité des bactéries pathogènes, ce qui signifie qu’un jour nous pourrions les utiliser pour neutraliser des colonies adhésives de bactéries nocives qui sont responsables de plus de 80 % de toutes les infections microbiennes dans le corps.

Article rédigé par Georges Simmonds pour RT Flash

ACS

|

|

|

|

|

|

|

|

|

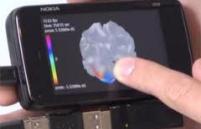

Pour détecter des mutations génétiques chez un patient à partir d'un échantillon de son ADN, il est nécessaire d'envoyer ce dernier dans un laboratoire d'un grand hôpital, qui possède tout l'équipement nécessaire. Mais comment faire lorsque l'échantillon est prélevé dans un pays en voie de développement ne bénéficiant pas de telles infrastructures, ou dans une zone reculée du monde ?

Pour surmonter cet obstacle, des chercheurs de l'Université de Stockholm (Suède) et de l'Université de Californie - Los Angeles (États-Unis) ont eu l'idée d'équiper un smartphone d'un dispositif imprimé en 3D afin que le médecin puisse détecter des mutations tumorales sur place, au chevet du patient ! Le dispositif se présente de la manière suivante : un smartphone (le test a été réalisé sur un "Nokia Lumia 1020"), est équipé d'un module imprimé en 3D, comprenant une LED pour l'éclairage et deux diodes laser pour l'imagerie en fluorescence.

L'ADN est rendu fluorescent par des substances appelées fluorochromes, chacune repérant et éclairant l'une des lettres composant l'ADN (les nucléotides A, T, C et G). Grâce à sa caméra et une lentille adaptée, le smartphone détecte les réactions de fluorescence et se lance, dans ces fragments d’ADN lumineux, à la recherche d'éventuelles mutations sur des gènes dont l'expression favorise la survenue d'un cancer (les scientifiques parlent "d'oncogènes"). Les chercheurs ont testé avec succès leur dispositif pour le gène KRAS, muté dans environ un tiers des cancers colorectaux.

Ce nouveau dispositif présente l'immense avantage d'être peu onéreux : il pourrait être fabriqué pour moins de 500 dollars (470 euros environ) s'il était produit en grande quantité - il est donc beaucoup moins cher que les équipements utilisés actuellement.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

Selon une étude publiée dans la revue Tobacco Control, le coût mondial du tabagisme représenterait environ 6 % des dépenses mondiales consacrées à la santé ainsi que 2 % du Produit Intérieur Brut (PIB) global, soit 1 436 milliards de dollars dans le monde, dont 40 % à la charge des pays en développement.

Les chercheurs ont collecté des données sur 152 pays, représentant 97 % de l'ensemble des fumeurs de la planète. Ils ont évalué le coût du tabagisme en incluant les dépenses directes (hospitalisations et traitements) et les dépenses indirectes (calculées sur la base de la productivité perdue en raison des maladies et des décès prématurés).

En 2012, le tabagisme a été à l'origine d'un peu plus de 2 millions de décès chez des adultes âgés de 30 à 69 ans dans le monde, soit environ 12 % de l'ensemble des décès survenus dans cette tranche d'âge, selon cette étude. Les pourcentages les plus élevés ont, selon les chercheurs, été observés en Europe (26 %) et en Amérique (15 %).

Au cours de la même année, les dépenses directes de santé liées au tabagisme se sont élevées au total à 422 milliards dans le monde, soit 5,7 % de l'ensemble des dépenses de santé, un pourcentage qui atteint 6,5 % dans les pays à forts revenus. Le quart du coût économique total du tabagisme (1 436 milliards de dollars) est assumé par quatre pays : Chine, Inde, Brésil et Russie.

Rapporté au PIB des différents pays, le tabagisme s'est avéré particulièrement coûteux en Europe de l'Est (3,6 % du PIB) ainsi qu'aux Etats-Unis et au Canada (3 %). Le reste de l'Europe se situe à 2 % contre 1.8 % à l'échelle mondiale. L'OMS s'est fixé comme objectif de réduire d'un tiers les décès prématurés liés aux maladies non infectieuses, et notamment au tabagisme d'ici à 2030.

Article rédigé par Georges Simmonds pour RT Flash

Eurekalert

|

|

|

|

|

|

|

ERRATUM

Dans notre article du 22-02-2017, intitulé "Une nouvelle immunothérapie efficace contre certaines leucémies de l'enfant", nous avons, de manière tout à fait non-intentionnelle, omis de mentionner que, si l'équipe des chercheurs de l'University College de Londres a bien expérimenté en 2015 ce nouveau traitement contre la leucémie aigüe lymphoblastique, c'est l'équipe du biologiste français André Choulika, Président et cofondateur de la société française Cellectis qui, la première , a mis au point et expérimenté, en 2010, ce nouveau traitement très prometteur , à l'Université de Pennsylvanie (USA).

Nous présentons toutes nos excuses pour cette omission involontaire

René Trégouët

|

|

|

|

|

|

|

Une semaine pour découvrir le fonctionnement de notre cerveau et les progrès faits par la Recherche en Neurosciences.

La 19e édition de la Semaine du cerveau aura lieu en France et dans 62 pays dans le monde du 13 au 19 mars 2017. Pendant toute cette semaine, dans plus de trente villes françaises le grand public pourra aller à la rencontre des chercheurs pour apprendre à mieux connaître le cerveau et s'informer sur l'actualité de la recherche en neurosciences. Plus de 500 chercheurs enthousiastes sont impliqués dans cette campagne d'information grand public et gratuite.

Cette manifestation est coordonnée par la Société des Neurosciences sous l'égide de la Fondation Dana Alliance.

Voir la programmation de cette semaine du cerveau sur www.semaineducerveau.fr

|

|

|

|

|

|

|

Une semaine pour découvrir le fonctionnement de notre cerveau et les progrès faits par la Recherche en Neurosciences.

La 19e édition de la Semaine du cerveau aura lieu en France et dans 62 pays dans le monde du 13 au 19 mars 2017. Pendant toute cette semaine, dans plus de trente villes françaises, le grand public pourra aller à la rencontre des chercheurs pour apprendre à mieux connaître le cerveau et s'informer sur l'actualité de la recherche en neurosciences. Plus de 500 chercheurs enthousiastes sont impliqués dans cette campagne d'information grand public et gratuite.

Cette manifestation est coordonnée par la Société des Neurosciences sous l'égide de la Fondation Dana Alliance.

Voir la programmation de cette semaine du cerveau sur www.semaineducerveau.fr

|

|

|

|

|

|

|

|

|

Selon une étude sino-canadienne menée sur la souris puis reproduite chez l’Homme, une carence, même légère, en vitamine A, pourrait favoriser la maladie d’Alzheimer. Ces recherches préconisent une supplémentation, en cas de carence, et chez les personnes âgées comme thérapie complémentaire dans la prévention ou la prise en charge de la maladie d’Alzheimer.

La vitamine A contribue à stimuler le système immunitaire. On en trouve principalement dans les aliments de source animale, dont les produits laitiers, les œufs, la viande et le poisson gras, mais également dans certains fruits et légumes à feuilles. Les aliments d’origine animale contiennent de la vitamine A sous forme de rétinol et d’esters de rétinol alors que les légumes contiennent essentiellement des précurseurs du rétinol ou bêta-carotène. Les besoins quotidiens en vitamine A pour un adulte sont estimés de 0,7 à 1 mg environ.

Ici, les chercheurs de la Chongqing Medical University (Chine) et de l’University of British Columbia (Canada) ont travaillé sur des souris modèles d’Alzheimer. Leur étude constate que les souris déficientes en vitamine A présentent un développement anormal d’agrégats et de touffes de protéines caractéristiques de la maladie d’Alzheimer. Au-delà, la descendance de ces souris présente des capacités cognitives réduites, telles qu’évaluées par le test du labyrinthe.

Ces résultats sont également confirmés chez les humains : les chercheurs ont en effet analysé des prélèvements sanguins de 330 participants âgés en moyenne de 77 ans, résidant dans des foyers de soins chinois. Leurs capacités cognitives ont été évaluées et des prélèvements sanguins ont été effectués pour l’évaluation des niveaux de vitamine A.

L’analyse confirme le lien entre les niveaux de vitamine A et la déficience cognitive et montre que les scores aux tests sont moins bons chez les participants présentant une carence ou une carence marginale vs avec des taux de vitamine A normaux. Les chercheurs suggèrent ainsi, avec ces travaux, menés chez l’animal et confirmés chez l’Homme, que la carence en vitamine A est corrélée à une augmentation du déclin cognitif chez les adultes plus âgés.

A l’appui de cette association, ils constatent qu’une carence même légère en vitamine A favorise le dépôt de la plaque amyloïde chez les souris modèles Alzheimer et conduit à des déficits de mémoire. Ainsi, la supplémentation en vitamine A pourrait être une approche complémentaire possible pour la prévention et le traitement de la maladie d’Alzheimer.

Article rédigé par Georges Simmonds pour RT Flash

Acta Neuropathologica

|

|

|

|

|

|

|

|

|

L'équipe de Floyd E. Romesberg du Scripps Research Institute (Californie) a réussi à élaborer deux nouvelles bases, baptisées X et Y, mais surtout à assurer leur maintien lors de la réplication de l’ADN in vivo. Le but : créer des organismes semi-synthétiques, avec une information génétique enrichie (3 paires de bases au lieu de 2), afin de les doter de fonctions inédites.

Pour arriver à ce résultat, l’équipe a d’abord dû choisir les bases X et Y parmi un certain nombre de candidats. Les deux bases devaient être parfaitement complémentaires, comme le sont A et T d’une part, et G et C d’autre part, afin que la réplication puisse se faire sans aucun souci.

Pendant 15 ans, les chercheurs ont fabriqué 60 candidats, donc 3 600 paires possibles et ont réussi à en sélectionner une, puis à l’optimiser. Les deux bases sélectionnées ont été les composés NaM et TPT3. Une fois ces deux bases identifiées, le principal défi consistait à assurer leur réplication une fois insérée dans un organisme – en l’occurrence, la bactérie E. coli. Un plasmide, c’est-à-dire une molécule d’ADN circulaire fabriqué in vitro, contenant une paire de bases X et Y, a été importé dans la bactérie.

Dans un second temps, des bases X et Y libres ont été ajoutées dans le milieu de culture et le génome de la bactérie a été modifié pour produire une protéine permettant le passage de ces bases libres vers l’intérieur de la bactérie. Une fois à l’intérieur, elles ont été prises en charge par les enzymes qui assurent normalement la réplication de l’ADN d’E. coli et qui placent, en face de chaque base azotée, sa base complémentaire.

Chaque brin du plasmide a ainsi été efficacement copié, la séquence AGCXT devenant TCGYA. Mais la réplication de X et de Y n’était pas parfaite, explique Thomas Lavergne, chercheur CNRS au département de chimie moléculaire de l’Université Grenoble-Alpes, qui fait partie de l’équipe. C'est à ce stade qu'est intervenu le nouvel outil révolutionnaire appelé CRISPR-Cas9.

Cette enzyme permet en effet de couper l’ADN à un endroit souhaité. L’équipe de Floyd E. Romesberg a utilisé ce dispositif pour couper les morceaux d’ADN qui avaient muté. Pour Philippe Marlière, "l’utilisation de CRISPR-Cas9, en plus d’être une technique très élégante, a aussi été très efficace. Cela a considérablement amélioré la rétention de la paire de nucléotides X et Y."

Fort de ce résultat encourageant, l’équipe a ensuite testé cette technique de réplication de l’ADN modifiée d’E. Coli dans des conditions plus difficiles et dans différents milieux, liquides ou solides. Les résultats sont restés très satisfaisants. Au fil des réplications, la perte d’information par suppression de bases azotées ou par mutation a été négligeable et la croissance des bactéries n’a été ralentie que de 10 %, un chiffre remarquable.

Les chercheurs ne veulent pas s’arrêter là. La réplication ADN-ADN avec ces deux nouvelles bases n’est qu’une première étape. La prochaine, c’est le passage de l’ADN à l’ARN afin par la suite de produire des protéines qui seraient constituées d’aminoacides modifiés par l’homme. Il serait ainsi possible de fabriquer des protéines thérapeutiques totalement nouvelles.

Les chercheurs se veulent rassurants quant à cette nouvelle technique et soulignent qu’en l’absence des bases X et Y dans le milieu de culture, l’ADN semi-synthétique contenant par exemple ATGXC était rapidement converti en ADN naturel ATGAC. Ces bases X et Y étant exclusivement synthétiques et absentes de notre environnement, la propagation de ces organismes hors des frontières du laboratoire est donc impossible.

Article rédigé par Georges Simmonds pour RT Flash

Science Daily

|

|

| ^ Haut |

|

|

|

|

|

|

|

Recherche |

|

|

Recherche & Innovation, Technologies, Transports

|

|

|

|

|

|

|

|

|

|

Comment organiser la transition entre les véhicules autonomes et connectés d'aujourd’hui et un véritable système intelligent plus sûr, plus confortable, plus fluide et plus durable dans quelques années ? En mariant les technologies d’aide à la conduite et la communication entre véhicules, répondent les chercheurs réunis au sein du projet européen AutoNet2030.

Ils viennent de prouver qu’il était possible de faire circuler, en conditions réelles, des véhicules avec et sans chauffeur sur plusieurs voies à grande vitesse de manière autonome. Une étape cruciale pour gérer la phase de transition a été réalisée par l’EPFL (Ecole Polytechnique Fédérale de Lausanne) qui a mis au point l’algorithme de contrôle du convoi de véhicules.

Grâce au protocole de communication, basé sur le Wi-Fi, entre véhicules, ces derniers sont aujourd’hui capables de communiquer avec leurs semblables. Parallèlement, les multiples aides à la conduite utilisant GPS, lasers, cameras et autres capteurs, permettent à une voiture de se déplacer de manière complètement autonome. Pour autant, il faudra encore une quinzaine d’années avant que l’essentiel du parc roulant soit doté de ces atouts qui nous promettent un avenir sans chauffeur.

Une des options étudiées aujourd’hui est de faire circuler les véhicules en convois. Par exemple, un camion avec chauffeur mène à la queue leu-leu des semi-remorques autonomes et connectés qui roulent à vitesse et à distance égales. Des tests ont déjà été réalisés avec succès sur des centaines de kilomètres en Australie. Le problème est que ce type de convoi se comporte comme un bloc exclusif et qu’au-delà d’un certain nombre de véhicules, il devient de plus en plus compliqué à gérer.

Les chercheurs d’AutoNet2030 proposent une autre formule : un système coopératif et décentralisé. Exit le chef. Chaque véhicule connecté communique avec ses proches voisins. Il calibre ainsi sa position et règle sa vitesse de manière indépendante. Le convoi peut ainsi aisément rouler sur une, deux ou davantage de voies sur une autoroute, intégrer un véhicule qui y entre et se repositionner en conséquence.

Mieux, chaque véhicule bénéficie des "yeux" de ses voisins et dispose ainsi d’une perception à 360 degrés. En outre, le nombre de véhicules qui composent le convoi n’est théoriquement pas limité puisque chaque élément se positionne de façon autonome.

La gestion du convoi repose sur un logiciel de contrôle, un algorithme développé par le Laboratoire de systèmes et algorithmes intelligents distribués (DISAL) de l’EPFL.

"Schématiquement, l’idée est de faire coopérer des agents (robots ou voitures) individuellement, pas forcément très malins, afin d’obtenir un comportement général complexe", explique Alcherio Martinoli, directeur du DISAL. Mathématiquement, cela veut dire que l’algorithme intègre les informations fournies par les capteurs des agents et règle, en temps réel, l’évolution du convoi en conséquence. Le convoi se réorganise sans cesse automatiquement en fonction d’un départ ou d’une nouvelle arrivée, des changements de voie ou du respect d’une vitesse prédéfinie.

La démonstration finale a eu lieu fin octobre en Suède, sur le circuit d’essai routier AstaZero. Trois véhicules ont joué le jeu : un camion sans chauffeur, une voiture autonome et une voiture manuelle, un enjeu majeur du projet. Les chercheurs ont équipé cette dernière de capteurs tels que GPS et lasers ainsi que d’une interface homme-machine permettant au conducteur de suivre les indications afin de se fondre dans le convoi. « Nous avons pour la première fois pu démontrer ce que nous avions validé par simulation. Et le nombre de véhicules en convoi n’influence pas la complexité du contrôle », se réjouit Alcherio Martinoli.

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|