|

|

|

|

|

| NUMERO 822 |

|

|

|

|

|

|

|

Edition du 20 Novembre 2015

|

|

|

|

|

Edito

100 % d’électricité issue des énergies renouvelables en France : c’est tout à fait possible

Actuellement, la consommation totale d’électricité représente environ 22 % de la consommation finale d’énergie en France (154 millions de TEP) mais cette consommation a globalement triplé depuis 40 ans et surtout sa structure a complétement changé : alors qu'en 1970 l'industrie consommait plus de la moitié de l'électricité utilisée dans l'Hexagone, c'est aujourd'hui la consommation résidentielle qui domine, à 35 %, devant le sectaire tertiaire et l'industrie (à 30 % chacun). Les transports représentent 3 % de la consommation finale d'électricité et l'agriculture 1 %.

Il y a quelques semaines, l’Ademe a dévoilé son étude exploratoire envisageant la possibilité en France d’un mix électrique reposant jusqu’à 100 % sur les énergies renouvelables (EnR) à l’horizon 2050 (voir ADEME).

L’étude souligne que le potentiel énergétique renouvelable exploitable serait, en 2050, de 1 268 TWh. Cette étude envisage 14 mix électriques « techniquement possibles » selon l'Ademe, avec une part d’EnR dans la production électrique de 40 %, 80 %, 95 % ou 100 % en 2050. Ces différents scénarios comportent également des variantes en fonction de l’état des progrès technologiques et de l’acceptabilité sociale.

Dans son scénario de référence « 100 % EnR », l’Ademe prend comme hypothèse de départ une consommation d’électricité de 422 TWh par an, contre 470 TWh en moyenne au cours de ces dernières années. Ce niveau de sobriété de la consommation nationale en électricité implique donc une forte maîtrise de la demande d’électricité mais celle-ci est tout à fait à la portée de notre Pays quand on sait qu’elle représente une diminution de la consommation électrique intérieure de seulement 10 % sur 35 ans, soit moins de 0,3% par an en moyenne…

Dans ce scénario « 100 % d’électricité renouvelable », l’Ademe souligne également que le développement de ces énergies propres et non émettrices de CO2 devra être massif : il faudra notamment prévoir 50.000 éoliennes terrestres et maritimes, de 500 km² de centrales solaires au sol et une part non négligeable de la surface de toits équipée en panneaux photovoltaïques. Cette « armature énergétique » de base devra être complétée par le recours à plusieurs sources d’énergie issues des mers, comme l’énergie des vagues et courants marins.

En matière d’équilibrage et de stockage, l’Ademe envisage 3 types de stockage : des solutions de stockage de court terme, les stations de transfert d’énergie par pompage (STEP), qui constituent déjà l’essentiel des solutions actuelles de stockage électrique et le « power to gas », une nouvelle technologie très prometteuse de stockage de la production d’électricité excédentaire sous forme d’hydrogène et de restitution en cas de forte demande.

Mais pour atteindre cet objectif ambitieux, la France devra également se doter de multiples unités de méthanisation et développer de très grandes capacités de stockage d'énergie sous forme d’hydrogène, de méthane, d'air comprimé et de batteries liquides à flux redox. Il faudra également que notre Pays double le nombre de ses stations de pompage alimentant des barrages, de façon à atteindre une capacité de stockage total de 36 GW (plus de la moitié de la puissance du parc nucléaire actuel).

Côté demande, les consommateurs devront être massivement connectés, via le Net et leurs installations domotiques, à des dispositifs de gestion intelligents, capables de « lisser » les redoutables pointes de consommation.

Dans son scénario de référence, l’Ademe envisage que 63 % du mix électrique français repose sur l’éolien (très majoritairement terrestre), 17 % sur le solaire photovoltaïque, 13 % sur l’hydraulique, près de 5 % sur le bois énergie et 2 % sur les autres EnR (méthanisation, déchets, géothermie, solaire thermodynamique, énergie marémotrice).

Il est très intéressant de noter que, dans ce scénario, le mégawattheure produit reviendrait à 119 euros, contre 91 euros le MWh aujourd’hui et…117 euros pour le scénario comprenant 40 % d’énergies renouvelables, associé à 55 % de nucléaire et 5 % d’énergies fossiles. Cette faible différence s’explique par les courbes de coût de production de ces différentes sources d’énergie. Le coût du MWh éolien et solaire devrait diminuer d’au moins 40 % d’ici 2050, alors qu’au contraire, le coût de production du MWH nucléaire pourrait grimper de 30 %, notamment en raison des lourds travaux de modernisation et de mise aux nouvelles normes de sécurité adoptées à la suite de la catastrophe de Fukushima. Mais l’étude de l’Ademe précise que, quel que soit le mix énergétique retenu, le coût global de l’électricité sera sensiblement plus élevé qu'actuellement, de l'ordre de 30 %.

L’un des facteurs-clés dans la réalisation de ce scenario « 100 % d’électricité renouvelable » réside dans la mutation énergétique du bâtiment, qu’il soit résidentiel ou d’entreprise. Sur ce point crucial, une équipe d'EDF-R&D avait déjà réalisé en 2008 une remarquable étude qui fait toujours référence et montre qu’il est possible d’envisager un scénario d'évolution vers des bâtiments (des secteurs résidentiel et tertiaire) ne faisant pas appel aux énergies fossiles, à l'horizon 2050 (Voir Etude). Dans ce travail, les chercheurs montraient que notre Pays pouvait, sans augmenter de façon significative la demande d'électricité, ne plus recourir aux énergies fossiles dans le bâtiment, tout en diminuant ses émissions de CO2 de 90 millions de tonnes par an.

Selon cette étude très réaliste, il serait en effet envisageable de fournir la quasi-totalité de l’énergie de chauffage de ces bâtiments en 2050 en combinant électricité (d’origine essentiellement renouvelable), pompes à chaleur et biomasse.

Mais la révélation la plus surprenante de cette étude était que cet objectif pouvait être atteint sans ruptures technologiques majeures, sans changements radicaux des comportements et sans augmentation irréaliste de la consommation de biomasse, en misant essentiellement sur une meilleure isolation des bâtiments, une amélioration de l’efficacité énergétique et une utilisation combinée intelligente de la biomasse, de l’énergie solaire et des systèmes de récupération d’énergie. En revanche, l’étude insistait sur la nécessité d’imaginer de nouveaux instruments fiscaux et financiers adaptés, susceptibles d’inciter les entreprises et les ménages à investir massivement dans l’amélioration des performances énergétiques des bâtiments dévolus au travail et au logement.

La réalisation d’un tel scénario supposerait cependant un investissement important (de l’ordre de 850 milliards d’euros) en tenant compte de la baisse prévisible du coût d’installation des systèmes de production d’énergies renouvelables.

Il y a quelques jours a été posée à Strasbourg la première pierre d’un bâtiment qui préfigure ce que sera cette révolution énergétique du bâtiment. Le quartier des Deux Rives à Strasbourg accueillera la première tour de logements à énergie positive au monde en 2017. La tour, ses 66 logements et la mécanique de l’immeuble – ascenseurs, chauffage, éclairage –, devraient produire plus d’énergie qu’ils n’en consomment. Pour parvenir à ce bilan positif, il est prévu l’installation de 800 à 1 000 mètres carrés de panneaux photovoltaïques. Haute de 50 mètres, la tour produira ainsi 100 kWh/m2/an pour une consommation de 97 kWh/m2/an. Une société constituée du Crédit agricole (46 %), de la Caisse des Dépôts (46 %) et d’Elithis (8 %) portera cet investissement de 20,1 millions d’euros.

S'agissant de la question récurrente du coût réel des énergies renouvelables, un rapport très argumenté, réalisé par l’IRENA (Agence Internationale des Energies Renouvelables) a montré il y a quelques mois que, contrairement à ce qu’affirment souvent leurs détracteurs, les principales énergies renouvelables (biomasse, l'hydroélectricité, géothermie, l'éolien terrestre et solaire photovoltaïque) peuvent déjà être compétitives par rapport aux énergies fossiles (charbon, pétrole et gaz), même sans soutien financier et malgré la baisse des prix du pétrole. Le solaire photovoltaïque (PV) a vu ses coûts de production diminuer de 75 % depuis 2009 (voir IRENA).

"Les projets d'énergie renouvelable à travers le monde arrivent à la hauteur, voire surpassent les combustibles fossiles, en particulier pour la comptabilisation des externalités comme la pollution locale, les dommages environnementaux et les problèmes de santé", souligne Adnan Z. Amin, Directeur général de l'IRENA, qui ajoute « L'effondrement des coûts des énergies renouvelables a créé une occasion historique de construire un système d'énergie propre, durable à un prix abordable et d'éviter un changement climatique catastrophique ».

Et les faits sont là : 120 gigawatts d'énergies renouvelables ont été ajoutés au mix énergétique mondial en 2013, avec des prévisions similaires pour 2014. Aujourd’hui, on estime que les énergies renouvelables représentent déjà près du quart de la production mondiale d'électricité et 20 % de la consommation totale d'énergie finale.

Ce rapport constate également que la baisse des prix des énergies renouvelables ne se fait pas au même rythme partout. Cette baisse varie sensiblement en fonction des ressources et de la disponibilité des financements. L'éolien marin et l'énergie solaire thermodynamique et à concentration (CSP) sont des technologies dont les coûts de déploiement vont rester à moyen terme plus élevés que ceux des combustibles fossiles. Mais le gisement énergique exploitable par ces technologies est gigantesque au niveau planétaire, ce qui finira par bouleverser la donne énergétique mondiale, à condition toutefois que les pays émergents, dans lesquels vivent les 1,3 milliard d’êtres humains qui n’ont toujours pas accès à l’électricité, puissent disposer des outils et mécanismes financiers et bancaires qui leur permettent de réaliser ces équipements qui nécessitent de lourds investissements et un amortissement sur de longues durées.

Cette étude souligne également que dans de nombreuses régions du monde, dont l'Europe, l'éolien terrestre reste l'une des sources d’énergie les plus compétitives dans les nouvelles capacités électriques disponibles. Les projets éoliens individuels permettent à présent de produire une électricité à 0,05 dollar du kilowatt-heure (kWh) sans soutien financier, par rapport à une fourchette de 0,04 à 0,14 / kWh pour les centrales à combustibles fossiles. Le coût moyen de l'énergie éolienne varie de 0,06 dollar du kWh en Chine et en Asie à 0,09 dollar du kWh en Afrique. L'Amérique du Nord possède également des projets éoliens compétitifs, avec un coût moyen de 0,07 dollar du kWh.

Quant aux systèmes solaires photovoltaïques résidentiels, leur prix a diminué de 70 % au cours de ces sept dernières années et les projets photovoltaïques solaires les plus compétitifs produisent à présent de l'électricité à 0,08 dollar du kWh sans soutien financier et devraient pouvoir devenir plus rentables que l’électricité d’origine fossile d’ici cinq ans, surtout si les grands pays développés et émergents parviennent à donner un prix suffisant à la tonne de carbone émise.

Soulignons également que cette baisse considérable du coût de production de l’électricité produite à partir de l’éolien et du solaire ouvre enfin la perspective de pouvoir fournir un accès décentralisé et bon marché à l’énergie électrique aux 500 millions de foyers dans le monde (un foyer sur cinq) qui en sont toujours privés. Sachant qu’un système portatif de production et d’alimentation électrique coûte à présent moins de 100 dollars, Gérard Mestrallet, Président d'Engie, rappelait récemment à juste titre qu’il suffirait d’environ 50 milliards de dollars pour apporter à tous les humains l’électricité et avec elle un bien meilleur accès à la culture et à l’éducation…

A quelques jours de l’ouverture de la COP 21 à Paris, Jean-Bernard Lévy, Président d'EDF, vient de présenter « CAP 2030 » qui révèle les objectifs majeurs du Groupe en matière de politique énergétique. EDF annonce notamment un doublement de son parc de production d'énergie renouvelable d'ici à 2030 et rappelle au passage qu’elle produit désormais en France de l'électricité décarbonée à 98 %. De ce fait, la teneur en carbone de l'électricité française est descendue à 17 grammes par kilowattheure, soit 20 fois moins que la moyenne européenne (328 g/kWh), encore largement impactée par le recours au charbon dans la production électrique. EDF souligne enfin que, depuis 25 ans, ses émissions de CO² sont passées de plus de 24 millions de tonnes à moins de 10 millions de tonnes...

Mais pour aller encore plus loin et parvenir à réaliser l’objectif des 100 % d’électricité renouvelable en 2050, la France devra actionner simultanément tous les leviers technologiques, économiques, sociaux et politiques agissant sur l’offre et de la demande car un tel objectif constitue un véritable défi de société et suppose un profond changement des mentalités et des comportements individuels.

Sur le plan économique, il est notamment crucial, comme viennent de le rappeler dans une analyse commune le président du groupe Banque mondiale, Jim Yong Kim, et Christine Lagarde, Directrice du Fonds monétaire international (FMI), de parvenir à donner un prix suffisamment élevé au carbone émis pour accélérer la transition énergétique, tant au niveau national que mondial (Voir La Banque Mondiale).

A cet égard, La plupart des experts et économistes, dont le Nobel Joseph Stiglitz s'accordent sur la nécessité d'une augmentation progressive du prix de la tonne de CO2 qui pourrait passer de moins de 15 euros aujourd’hui à 50 euros vers 2020, puis monter jusqu'à 100 euros en 2030. Sachant qu’il faut atteindre un niveau du prix de la tonne de CO2 de l'ordre de 70 euros pour provoquer un basculement massif du charbon vers les énergies renouvelables, un tel rythme d'évolution du prix du CO2 permettrait de provoquer une véritable rupture énergétique au cours de la prochaine décennie et d'accélérer la décarbonisation de notre économie en réduisant plus rapidement la part du charbon (40 % au niveau mondial) dans la production d’électricité.

On peut toutefois s'interroger, quels que soient les progrès attendus en matière de rendement, d’efficacité et de coût de production des énergies renouvelables, sur la faisabilité pour 2050 d’un scénario de production électrique entièrement décarbonée qui exclut totalement le nucléaire. En effet, même si nous parvenons à stabiliser notre consommation électrique nationale ou à la faire légèrement diminuer à l’horizon 2050, nous partons d’un niveau de production électronucléaire si élevée, à la fois en valeur absolue (404 TWH par an) et en valeur relative (75 % de la production électrique nationale) qu’il sera très difficile, à un coût économique, social et environnemental acceptable, de remplacer l’ensemble de cette production électronucléaire par des énergies renouvelables.

Autre inconnue de taille : personne n’est capable de dire aujourd’hui combien de temps prendra et combien coûtera exactement le démantèlement complet de l’ensemble de notre parc nucléaire. Ce qui est certain c’est que la dépense s’annonce colossale, sans doute plusieurs centaines de milliards d’euros et qu’une telle entreprise pourrait prendre un demi-siècle, voire d’avantage…

Même si la part de l’énergie nucléaire de fission dans le bouquet énergétique national est sans doute appelée à diminuer sur le long terme, il me semble donc très hasardeux de décréter, sur des considérations essentiellement idéologiques, que cette forme d’énergie ne sera plus du tout nécessaire en 2050, surtout si nous voulons accélérer le rythme de diminution des émissions de CO2 liées à la production d’énergie.

Il serait sans doute plus réaliste, tout en maintenant cet objectif nécessaire des 100 % d’électricité renouvelable d’ici 2050, de ne pas fixer de seuils et paliers trop précis (sous risque qu’ils s’avèrent intenables) quant au rythme de la diminution de la part de l’énergie nucléaire dans notre production électrique. Il faut en effet savoir hiérarchiser les menaces et celle du réchauffement climatique, qui suppose une réduction drastique des émissions humaines de gaz à effet de serre dès à présent, doit évidemment l’emporter sur celle liée à l’utilisation raisonnée de l’énergie nucléaire.

Enfin, même si le nucléaire ne peut absolument pas constituer une solution-miracle pour lutter contre le réchauffement climatique et voit sa part relative diminuer dans la production mondiale d’électricité (11 % en 2014,contre 17 % en 2004), l’argument de l’impact positif du nucléaire en matière d’émissions de CO2 ne peut être balayé d’un revers de main, comme le rappelle une très sérieuse étude publiée en 2013 et dirigée par James Hansen, l’un des plus éminents scientifiques mondiaux en matière de changement climatique (Voir ACS).

Selon cette étude, le recours au nucléaire aurait permis d’éviter l’émission d’au moins 64 milliards de tonnes d'équivalent CO2 de gaz à effet de serre et permettrait d’en éviter 80 à 240 milliards de tonnes d'équivalent CO2 d’ici 2050 (en fonction des politiques énergétiques mises en œuvre par les états), soit l’équivalent de 1,5 à 5 ans d’émissions humaines d’équivalent-CO2, ce qui est tout à fait conséquent !

Il me semble que notre priorité planétaire doit être la diminution rapide et massive de nos émissions de CO2 et la lutte contre le réchauffement climatique et que la question, certes importante, de la part et de l’avenir du nucléaire dans notre bouquet énergétique doit être considérée plutôt comme une variable d’ajustement de cette priorité absolue, au lieu d’être posée comme sa condition préalable et indispensable de réalisation !

Ne nous trompons pas d’objectif et sortons enfin des visions idéologiques réductrices pour savoir imaginer tous ensemble un scenario de transition énergétique national et mondial réaliste, efficace et équitable, tant sur le plan économique que social et environnemental. Dans ce défi mondial, la France a tous les atouts pour devenir un exemple et un modèle de transition énergétique intelligente et pragmatique !

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Améliorer l'efficacité énergétique globale et réduire la consommation globale d’énergie des ménages, telle est l'objectif de AMIE (Additive Manufacturing Integrated Energy), un projet mené par des chercheurs de l’Oak Ridge National Laboratory en partenariat avec l’Université du Tennessee et une vingtaine d’acteurs du secteur privé. « Nous souhaitons parvenir à répondre efficacement aux défis de l’approvisionnement en énergie de la population mondiale », explique Roderick Jackson, membre de l’équipe scientifique en charge du projet.

Pour atteindre cet objectif, AMIE tente de repenser la manière dont l’énergie est générée, stockée et utilisée. « Lorsque nous utilisons nos véhicules, nous utilisons de l’énergie tout comme nous le faisons dans nos habitations. Cependant, ces deux flux d’énergie circulent habituellement de manière indépendante. De plus, quand ma voiture est inutilisée, sa batterie l’est aussi. On s’est alors posé la question suivante : et si on rassemblait ces deux courants d’énergie ? », poursuit le chercheur.

AMIE a réussi à faire sortir de terre une maison capable de recevoir l’énergie d’un véhicule et ainsi contribuer à son autosuffisance. 80 % de cette maison ont été créés grâce à l’additive manufacturing, soit la version industrielle de l’impression 3D. General Electric a d’ailleurs contribué à sa réalisation. Les chercheurs ont notamment travaillé sur un transfert d’énergie wireless entre l’habitation et le véhicule. « On a déjà pu observer cette technologie à l’échelle d’un smartphone : pas besoin de brancher quoi que ce soit. Ici, le principe est le même. La voiture, en se garant, se stationne sur un socle de transfert d’énergie qui décide quelle quantité d’énergie va pouvoir être transférée à la maison ».

Article rédigé par Georges Simmonds pour RT Flash

AMIE

|

|

|

|

|

|

|

|

|

Un moteur basé sur le principe du moteur d’Ericsson a été développé par le groupe d’ingénierie Assystem. La technologie a remporté le Grand Prix National de l’ingénierie 2015 ce 14 octobre, lors du salon World Efficiency. Développé par les ingénieurs d’Assystem en partenariat avec l’institut FEMTO-ST, le moteur Energine produit de l’énergie mécanique ou électrique à partir d’une source de chaleur externe dont la température est supérieure à 150°C.

Ce moteur Energine est inspiré du cycle d’Ericsson, vieux de plus de 160 ans ! C'est un moteur dit "à air chaud", ou "moteur à combustion externe". Son principe de fonctionnement est simple : de l’air en provenance de l’extérieur est comprimé dans une première enceinte avant de passer dans un échangeur où il est chauffé par une source de chaleur externe, pour arriver chaud dans une enceinte de détente. Cette détente pousse un piston et entraîne mécaniquement la compression d’air froid situé dans l’autre enceinte, ainsi que la mise en mouvement d’un alternateur qui convertit l’énergie mécanique en électricité.

Le rendement du moteur ne dépend que de la différence de température entre la source froide et la source chaude, et donc finalement de la température de chauffe. Le moteur qu’a mis au point Assystem peut fonctionner si cette différence de température est au minimum de 150°C avec une source chaude pouvant aller jusqu’à 800°C. 90 % de la chaleur fatale peut être ainsi convertie en énergie thermique utile et en énergie électrique. La technologie permet ainsi de récupérer la chaleur perdue, ou "chaleur fatale" de différents procédés. Elle devrait trouver de multiples applications, notamment dans les industries fortement émettrices de chaleur, telles que la sidérurgie ou la cimenterie.

Un prototype sera bientôt testé sur la cheminée d’une chaufferie, qui en récupère la chaleur en sortie, de 200°C, pour produire de l’électricité. Ensuite, le système pourrait être installé chez les particuliers pour faire de la micro-cogénération et donc produire de l’électricité en utilisant la chaleur de la chaudière. Enfin, le système, miniaturisé, pourrait être installé pour récupérer la chaleur du pot d’échappement des camions ou des trains pour soulager le moteur et donc consommer moins de carburant.

Article rédigé par Georges Simmonds pour RT Flash

Assystem

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

L’Equipe de Recherche en Epidémiologie Nutritionnelle (EREN) s’est intéressée au lien entre équilibre alimentaire et développement de tumeurs. Elle a utilisé pour cela le score FSA-NPS, qui devrait prochainement être utilisé pour indiquer la valeur nutritionnelle des aliments en magasin. Les résultats, parus dans le British Journal of Nutrition, permettent de faire le lien entre mauvais choix dans l’assiette et sur-risque de cancer.

Les chercheurs ont travaillé sur les données issues des habitudes alimentaires des 6 435 participants de la cohorte SU-VI-MAX (Supplémentation en Vitamines et Minéraux AntioXydants), démarrée en 1994 et clôturée en 2007.

Grâce à ces données, les auteurs ont calculé le score de chaque aliment en tenant compte de sa teneur en calories, sucres simples, acides gras saturés, sodium, fibres, protéines, fruits et légumes. « Il sert de base au système à 5 couleurs baptisé 5-C (vert, jaune, orange, rose fuschia, rouge) proposé par les scientifiques et considéré par le Haut Conseil de la Santé Publique comme la signalétique la plus pertinente pour orienter les choix alimentaires des consommateurs », explique le Docteur Mathilde Touvier, qui coordonne les recherches, dans un communiqué. Un ensemble précis qui a permis de calculer le score de qualité de l’alimentation générale de chaque participant.

Après un suivi médian de 12,6 ans, 453 cancers ont été diagnostiqués chez les participants, cancers du sein et de la prostate exclus. Les volontaires dont l’alimentation était la moins équilibrée sont 34 % plus à risque que ceux dont l’assiette est la mieux garnie. Selon les auteurs, cela pourrait suggérer « que cet effet bénéfique serait contrebalancé par un fort apport calorique ». D’où l’importance de veiller à la qualité mais aussi à la quantité de nourriture ingérée.

Article rédigé par Georges Simmonds pour RT Flash

British Journal of Nutrition

|

|

|

|

|

|

|

|

|

Le CHRU de Brest et la société bretonne Hemarina ont débuté un essai clinique sur 60 patients, destiné à évaluer une molécule issue du sang d'un ver marin pour la préservation des greffons rénaux.

Après prélèvement et en attendant la transplantation, le greffon rénal est préservé dans un liquide de conservation. Durant cette période, le greffon "subit des lésions potentiellement irréversibles", explique le document, indiquant que ces lésions peuvent s'aggraver lors de la transplantation.

Ces lésions sont dues à une carence en oxygène lors du prélèvement et de la conservation du greffon, ainsi qu'à la ré-oxygénation brutale lors de la transplantation.

"Elles sont responsables d'un moins bon fonctionnement du greffon et d'une survie diminuée à long terme", note le communiqué, assurant qu'actuellement aucun dispositif ne permet de compenser la carence en oxygène du greffon.

La molécule prochainement testée est produite grâce à l'hémoglobine extracellulaire d'un ver marin appelé arénicole. Mesurant habituellement entre 10 et 15 cm, on connaît surtout de ce ver les petits tortillons visibles sur les plages du littoral Atlantique européen. "Après des résultats très encourageants dans les études pré-cliniques, nous avons hâte d'utiliser cette molécule pour la première fois chez l'homme", indique Yannick Le Meur, chef de service néphrologie-transplantations rénales au CHRU de Brest et investigateur principal de l'essai.

L'étude clinique sera menée dans six centres de transplantation : Brest, Paris, Lyon, Tours, Poitiers et Limoges. La transplantation rénale est aujourd'hui le seul traitement de l'insuffisance rénale terminale. Elle permet aux patients dont les reins ont été détruits par la maladie de retrouver une espérance de vie et une qualité de vie proches de la normale.

Article rédigé par Georges Simmonds pour RT Flash

Hemarina

|

|

|

|

|

|

|

|

|

Les chercheurs américains de l'Université du Nouveau Mexique ont analysé pendant trois ans les habitudes de sommeil de 94 adultes issus de trois tribus : les Hazda, des chasseurs-cueilleurs de Tanzanie, les San, des chasseurs-horticulteurs qui vivent dans le désert du Kalahari (Namibie) et les Tsimane de Bolivie, qui vivent aux pieds de la Cordillère des Andes. Ces populations ne possèdent ni électricité ni ordinateur.

En moyenne, les membres des tribus traditionnelles dorment 6 heures et 25 minutes, avec une légère variation selon la saison (1 heure de plus en hiver qu'en été), alors que dans les sociétés industrialisées en Europe et en Amérique, la durée moyenne de sommeil des adultes est de 8 heures. Les membres des trois tribus ne se couchent pas plus tôt que nous : ils veillent en moyenne 3 heures et 20 minutes après le coucher du soleil.

En comparaison, en France, une personne sur deux n'est pas couchée à 23 heures. "Le fait que nous restions debout des heures après le coucher du soleil est totalement normal, et ce n’est pas nouveau, bien que les lumières électriques aient pu étendre cette tendance naturelle à veiller", souligne Jérôme Siegel, principal auteur de l'étude et professeur de psychiatrie à l’Université de Californie (Los Angeles).

Cette étude montre également qu'en dépit de leur durée moyenne de sommeil plutôt courte, les membres de ces tribus sont en bonne santé. Ils souffrent ainsi moins d’obésité, d’hypertension artérielle et d’athérosclérose que dans les pays occidentaux. Preuve que le temps de sommeil n’est pas le seul facteur à entrer en ligne de compte dans la santé.

L'étude souligne enfin qu'il semble exister trois points communs bénéfiques pour la santé chez ces trois tribus : respecter un rythme régulier, dormir dans un espace dont la température est modérée et s’exposer principalement à la lumière du matin.

Article rédigé par Georges Simmonds pour RT Flash

Cell

|

|

|

|

|

|

|

|

|

Des scientifiques américains du Scripps Research Institute de Los Angeles sont parvenus à transformer des cellules cancéreuses porteuses de leucémie en cellules tueuses de cancer. Ces chercheurs ont d'abord découvert un anticorps capable de faire muter des cellules de manière spectaculaire.

Ainsi soumises à cet anticorps spécifique, des cellules de la moelle épinière ont pu être radicalement transformées en cellules cérébrales. Dans un deuxième temps, cherchant à transformer des cellules cancéreuses de la moelle épinière en cellules saines, les chercheurs ont découvert un anticorps encore plus puissant, présent dans les cellules malades des formes myéloïdes aiguës de leucémies.

Quand les chercheurs ont administré cet anticorps à des cellules malades, ces dernières se sont transformées en cellules dites dendritiques, à savoir des cellules du système immunitaires très efficaces. En renouvelant l'opération et en soumettant à nouveau ces cellules à l'anticorps miracle, ces dernières se sont transformées en cellules dites "tueuses naturelles" (Natural Killer), qui ont la particularité de détruire sélectivement et avec une grande efficacité leurs homologues cancéreuses. Reste à présent à mieux comprendre le fonctionnement de cet anticorps au potentiel thérapeutique prometteur.

Article rédigé par Georges Simmonds pour RT Flash

Science Alert

|

|

|

|

|

|

|

|

|

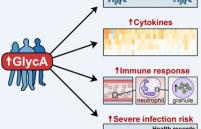

Selon une étude australo-finlandaise, un marqueur sanguin permettrait de prédire, chez des sujets apparemment sains, le risque d’infection sévère dans la décennie à venir. Le GlycA, déjà connu comme marqueur prédictif de la mortalité à court terme, serait aussi un marqueur d’inflammation chronique et, par-là, de la mortalité à long terme.

Pour identifier le GlycA, les chercheurs ont analysé les données biologiques et génétiques issues de plus de 10 000 sujets. Le taux de GlycA s’est révélé stable au-delà d’une période de 10 ans parmi eux. Chez des sujets apparemment en bonne santé, un taux élevé de GlycA était associé à une élévation de nombreuses cytokines pro-inflammatoires et à une expression génique majorée de l’activité neutrophile, « suggérant que les individus à GlycA élevé sont dans un état de réponse inflammatoire chronique ».

Ces données moléculaires ont été confirmées par les dossiers médicaux. Un taux élevé de GlycA était associé à un risque augmenté d’infections graves respiratoires et non localisées, en particulier des septicémies et des pneumonies. Les chercheurs espèrent que la compréhension des mécanismes impliqués permettra à l’avenir de « court-circuiter » ce risque.

Article rédigé par Georges Simmonds pour RT Flash

Cell

|

|

|

|

|

|

|

|

|

En cas d'Accident Vasculaire Cérébral (AVC), un traitement appelé thrombolyse est prescrit pour désagréger le caillot qui obstrue l'artère cérébrale. Cependant, les médicaments utilisés ne sont pas dénués de risque hémorragique. Pour prévenir les complications, des chercheurs lillois et finlandais ont testé avec succès un nouveau marqueur qui permettrait de sélectionner les patients à haut risque d'hémorragie. Dans les cas difficiles, ce biomarqueur guidera la décision médicale avec à la clé des traitements personnalisés en fonction du profil de risque de chaque patient. A Lille, les Professeurs Leys et Bordet sont à l'origine de l'identification de cette caractérisation biologique.

Partant de la réalité clinique, les chercheurs ont formulé l'hypothèse que l'interaction entre les différents globules blancs pouvait, chez un patient ayant subi un premier AVC, jouer un rôle majeur dans le risque d'hémorragie.

Après des premiers essais chez l'animal, l'hypothèse a été testée auprès de 846 patients lillois et finlandais, d'un âge moyen de 71 ans. Les résultats cliniques publiés dans "Neurology", une grande revue scientifique, montrent que chez les patients ayant subi un AVC, le nombre important de polynucléaire neutrophile, un type spécifique de globule blanc, augmenterait le risque de saignement cérébral après une thrombolyse, et offrirait un moins bon pronostic de survie à trois mois.

Ces travaux ont également montré que le rapport entre neutrophile/lymphocyte, deux types de globule blanc, était encore plus prédictif : plus le rapport entre les globules blancs serait supérieur à 4,8, plus le risque de récidive serait important (jusqu'à 4 fois plus). Cette découverte pourrait permettre d'envisager une nouvelle prise en charge personnalisée de l'AVC.

Article rédigé par Georges Simmonds pour RT Flash

Neurology

|

|

|

|

|

|

|

|

|

La radiothérapie est l’une des armes les plus anciennes contre le cancer : son effet sur le système immunitaire dépend des doses et du choix de la cible : les irradiations à large champ induisent à la fois une mort des cellules tumorales et des lymphocytes irradiés.

L’irradiation ciblée de cellules tumorales induit des conséquences immunologiques particulièrement importantes pour la suite de la prise en charge, souligne le Docteur Sandra Demaria, professeure d'oncologie à l'Université de New-York. En effet, l’irradiation permet une triple action : lésions de la membrane modifiant les antigènes de surface, altération de l’ADN et modifications de l’expression cellulaire.

Du fait de ces actions multiples, l’irradiation peut donc interférer à différents niveaux avec l’immunothérapie. Par ailleurs, l’irradiation du site primaire de la tumeur peut induire des modifications à distance de l’immunogénicité des métastases.

C’est avec l’arrivée des immunothérapies plus récentes – et notamment les anti-CTLA-4 (ipilimumab) – que les essais de traitement combinant radiothérapie et immunothérapie ont donné les premiers résultats positifs reproductibles. Chez l’animal, la radiothérapie induit une réponse lymphocytaire T chez des souris atteintes de carcinomes et jusque-là réfractaires au traitement par anti-CTLA-4.

Chez l’homme, la combinaison thérapeutique a permis d’améliorer le devenir de petites populations de patients atteints de cancers de la prostate, de sarcomes des tissus mous, de cancers du poumon non à petites cellules. Des essais sont aujourd’hui en cours dans le gliome, les cancers de la prostate résistant à la castration, le mélanome, les cancers du rein ou du col de l’utérus.

Article rédigé par Georges Simmonds pour RT Flash

ECC 2015

|

|

|

|

|

|

|

|

|

Des étudiants de l’Université Johns Hopkins ont mis au point un stéthoscope intelligent qui supprime les sons parasites et propose des diagnostics. Un outil pratique pour les environnements bruyants.

L’auscultation est une étape clé pour détecter les maladies cardiaques, respiratoires ou gastro-intestinales, mais il est parfois difficile pour un pédiatre, par exemple, de se concentrer sur les pulsations du coeur de son jeune patient en pleurs. En effet, aux urgences ou encore dans les ambulances, la médecine se pratique souvent dans des environnements bruyants. Pour remédier à ces situations et améliorer les diagnostics, des étudiants de l'Université Johns Hopkins ont inventé un stéthoscope intelligent qui supprime les bruits alentours.

Pour améliorer les consultations, ce stéthoscope est doté de plusieurs microphones : six enregistrent les sons du corps et le dernier, externe, enregistre les bruits de l'environnement pour qu'ils puissent être supprimés de l'analyse. C’est également un outil digital qui propose des diagnostics automatisés grâce à des algorithmes sophistiqués et permet ainsi une surveillance plus efficace et un meilleur suivi du patient.

On peut imaginer qu’une telle invention sera d’autant plus utile dans des zones de conflits, dans une navette spatiale, après une catastrophe naturelle ou dans toute autre situation où l’environnement n’est pas propice au silence et à la pratique de la médecine.

L’équipe à l’origine du projet est finaliste de la compétition nationale Collegiate Inventors Competition, un programme du département de génie électronique et informatique organisé par le National Inventors Hall of Fame et Invent Now.

Article rédigé par Georges Simmonds pour RT Flash

Johns Hopkins University

|

|

|

|

|

|

|

|

|

Une équipe internationale à laquelle participent des chercheurs de l'Université McGill a développé une nouvelle approche pour freiner la croissance des cellules pulmonaires cancéreuses, en bloquant leur capacité à utiliser d'autres sources de nutrition. La chercheuse Emma Vincent et ses collègues affirment qu'ils ont réalisé cette percée en déterminant les programmes métaboliques utilisés par les cellules cancéreuses pour alimenter leur croissance.

Les cellules cancéreuses ont un métabolisme très différent de celui des autres cellules car leur prolifération rapide demande un apport énergétique plus important, lequel est assuré par l'utilisation du sucre comme principal élément nutritif. Cependant, lorsque le sucre se fait rare, les cellules cancéreuses doivent utiliser d'autres sources de nutrition pour assurer leur croissance.

Les scientifiques ont donc étudié la réponse des cellules cancéreuses lorsque la disponibilité du glucose est réduite. Les chercheurs ont étudié l'un des types de cancer du poumon le plus répandu, le cancer du poumon non à petites cellules. Ce dernier touche de 85 % à 90 % de toutes les victimes de cancer pulmonaire. Ils ont ainsi découvert que certaines cellules pulmonaires cancéreuses se nourrissent plutôt de glutamine lorsque le glucose est rare.

De plus, les chercheurs ont découvert que les cellules cancéreuses utilisent une enzyme appelée PEPCK pour reprogrammer leur métabolisme. "Nous avons découvert que certaines cellules cancéreuses expriment également l'enzyme PEPCK, ce qui leur confère la capacité de transformer la glutamine en énergie et en divers éléments favorisant leur croissance. Grâce à ce changement métabolique, l'enzyme PEPCK permet non seulement aux cellules cancéreuses de survivre, mais également de continuer à proliférer". Ces travaux ont, en outre, démontré que l'inhibition de l'enzyme PEPCK dans les cellules cancéreuses pouvait ralentir la croissance tumorale chez la souris.

Article rédigé par Georges Simmonds pour RT Flash

Cell

|

|

|

|

|

|

|

|

|

Des chercheurs chinois dirigés par le Professeur Dingli Xu de l'Université Southern Medical à Guangzhou ont suivis 138 782 patients pendant plusieurs années pour essayer de mesurer l'impact du stress au travail sur les risques d'AVC. Afin de déterminer le degré de stress lié aux emplois, les chercheurs ont établi un classement en quatre catégories en fonction de la charge mentale, de la pression ainsi que de la capacité de choix des travailleurs.

Ces différentes catégories sont : les emplois passifs (comme les concierges ou les travailleurs manuels selon l'étude), ceux de faible contrainte (les architectes), les actifs (les médecins, les enseignants et les chercheurs). Pour ces travailleurs, aucune augmentation du risque d'accident vasculaire cérébral n'a été constatée.

En revanche, ceux qui occupent un poste avec un stress important (serveurs, infirmiers), voient leurs risques de faire un AVC augmenter de 22 % (33 % chez les femmes). L'étude fait l'hypothèse que le stress chronique au travail conduirait à une mauvaise hygiène de vie pour ces travailleurs.

Récemment, une autre étude avait montré un lien entre les horaires de travail à rallonge et le risque accru d'accident vasculaire cérébral : travailler plus de 55 heures par semaine augmentait de 33 % le risque par rapport à un travail hebdomadaire de 35 à 40 heures.

Article rédigé par Georges Simmonds pour RT Flash

Neurology

|

|

|

|

|

|

|

|

|

Des chercheurs du Brigham And Women's Hospital de Boston (Etats-Unis) viennent de mettre en lumière les propriétés anti-inflammatoires de bio-molécules trouvées dans le lait maternel. "Nous avions déjà identifié certains signaux de ces molécules dans d'autres organes et tissus du corps humains, mais c'est la première fois que nous les voyons groupées au même endroit" explique l'un des co-auteurs de cette étude, Charles Serhan.

En procédant par une technique détaillée de profilage, l'équipe a pu identifier des molécules dénommées SPMs (Specialized Pro-resolving mediators molecules) dans le lait maternel. Elle a découvert que chacune de ces molécules était capable de faire régresser les réactions inflammatoires et de stimuler le système immunitaire.

Si certaines de ces molécules avaient déjà été identifiées auparavant dans le lait maternel, c'est la première fois que les chercheurs découvrent une telle variété en si grandes quantités. Certaines d'entre-elles permettent de lutter contre les infections ou la douleur, d'autres ont des effets anti-inflammatoires ou contribuent à la cicatrisation des plaies.

L'équipe a ensuite testé les échantillons de lait humain provenant de femmes souffrant de mastite, une douloureuse infection inflammatoire du tissu mammaire. Ils ont découvert que le niveau de molécules SPMs était à un bien plus faible niveau que dans le lait maternel ordinaire et que ses propriétés anti-inflammatoires ne parvenaient pas à réduire l'infection au niveau précédemment constaté.

"Nos résultats suggèrent que les SPMs jouent un rôle de modulation de l'inflammation et de réduction de l'infection tout en stimulant le système immunitaire lors de son développement et renforcent donc l'importance du lait maternel pour les nourrissons" conclut Charles Serhan qui ajoute : "il est important pour les mères de sérieusement envisager l'allaitement si cela est possible".

Selon l'Organisation mondiale de la santé (OMS), si chaque enfant était allaité exclusivement pendant au moins 6 mois et l'allaitement maintenu jusqu'à l'âge de 2 ans, plus d'un million de vies d'enfants seraient chaque année sauvées dans le monde.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

Selon des chercheurs espagnols, il est possible que des mycoses, des infections provoquées par des champignons microscopiques, puissent être impliquées dans la maladie d'Alzheimer.

En comparant des tissus cérébraux prélevés post mortem sur onze personnes atteintes d'Alzheimer et sur dix personnes ne présentant pas la maladie, Luis Carrasco, du Centre de biologie moléculaire de Madrid, et son équipe ont découvert des structures signant la présence de différents types de champignons chez tous les malades d'Alzheimer sans exception, mais pas chez les non-malades.

Ces chercheurs précisent avoir détecté ces traces dans différentes parties du cerveau des malades, y compris dans les vaisseaux sanguins, ce qui pourrait expliquer les pathologies vasculaires souvent observées chez les malades d'Alzheimer. "Nos travaux fournissent des preuves irréfutables de la présence de mycoses dans le système nerveux central de malades atteints d'Alzheimer", soulignent-ils, estimant que leur découverte relance l'hypothèse d'une origine infectieuse de la maladie.

Ces mycoses pourraient expliquer pourquoi la maladie progresse lentement et pourquoi les patients présentent des inflammations chroniques et une activation de leur système immunitaire. Mais il est également possible que les malades d'Alzheimer puissent, pour diverses raisons (modifications dans leur hygiène ou leur alimentation, système immunitaire moins performant), être plus sensibles aux mycoses.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|