|

|

Edito

Comment le smartphone va remplacer le PC

Salon Mondial du Mobile à Barcelone

L'événement est passé presque inaperçu mais il marque un véritable basculement dans l'évolution vers la société numérique : en 2011, pour la première fois, le nombre de smartphones vendus dans le monde a largement dépassé celui des PC, soit 488 millions de mobiles "intelligents" contre 414 millions d'ordinateurs individuels. Dans cette bataille techno-économique planétaire, Apple devance encore de justesse son grand rival, le coréen Samsung, avec 93 millions d'appareils, contre 92 millions. Autre indicateur, les ventes mondiales de smartphones ont progressé de 60 %, contre seulement 15 % pour les ordinateurs personnels et cela malgré la montée en puissance des tablettes tactiles (63 millions d'exemplaires vendus en 2011).

A présent, on compte plus de connexions à l'Internet et d'envois de courriels à partir de smartphones que depuis des PC ou ordinateurs portables. La prochaine étape de cette évolution pourrait bien être celle préparée par la firme Canonical, qui a développé un système d'exploitation baptisé Ubuntu pour Android. Ubuntu, s'appuyant sur l'augmentation vertigineuse de la puissance de calcul et de stockage de nos smartphones, est persuadé que l'avenir appartient à un système modulaire intégrant nos mobiles, nos portables et la télévision numérique connecté au Web.

Le schéma est le suivant : l'utilisateur commence par installer Ubuntu sur son mobile tournant sous Android. Il suffit ensuite d'insérer son smartphone dans une station d’accueil reliée à un écran d’ordinateur ou à un téléviseur numérique. L’utilisateur peut alors travailler sur son interface Ubuntu qui intègre toute une panoplie de logiciels, bureautique, navigateur, messagerie, base de données... il récupère également automatiquement son carnet d'adresses et des données personnelles.

Motorola propose déjà un concept similaire sur son smartphone Atrix qui peut se transformer en PC portable par connexion sur une station et un écran dédiés. Ubuntu vise donc à généraliser ce schéma à tous les smartphones tournant sous Android.

Il reste que pour pouvoir tirer pleinement partie d'un tel concept, l'utilisateur doit disposer d'une puissance de calcul considérable sur son mobile. C'est ce qu'a bien compris le géant Intel qui compte bien imposer ses microprocesseurs de nouvelle génération dans nos smartphones. Il vient, il y a quelques jours, de présenter "Orange Santa Clara", un smartphone aussi puissant qu'un ordinateur portable qui sera disponible sur le marché à l'été 2012. Utilisant le système d'exploitation Android de Google, ce smartphone sera le premier au monde équipé du nouveau processeur "Atom".

Cette puce révolutionnaire intègre non seulement un double cœur mais également un émetteur-récepteur WiFi ! Avec l'accélération du déploiement des réseaux 4G, cette puce est destinée à équiper d'ici 2 ans l'ensemble des smartphones et tablettes numériques qui auront ainsi une autonomie et une puissance considérablement augmentées. Côté stockage des données, Lexar s'apprête à commercialiser des cartes mémoire de 256 Go, soit la capacité d'un disque dur de Pc d'il y a seulement 5 ans !

Reste à résoudre le dernier défi, celui de la visualisation des données et de la virtualisation de l'écran lorsque l'utilisateur n'est pas chez lui. C'est là qu'intervient Google qui travaille sur la mise au point de lunettes, capables « de diffuser de l’information sur le globe oculaire de l’utilisateur en temps réel ». Ces lunettes devraient être disponibles fin 2012 à un prix comparable à celui d'un smartphone. Tournant évidemment sous Android, le système d'exploitation de Google pour mobile, elles intègreront un écran dans les verres et seront équipées de capteurs de mouvements, d’un GPS et d'une caméra destinée à pouvoir afficher des éléments de l'environnement en réalité augmentée. Pour se déplacer dans les menus, il suffira de simples mouvements de tête !

Autre inconnue : comment Microsoft, IBM et Sony et les autres géants du secteur informatique et multimédia, notamment Apple, vont-t-il réagir et riposter à cette nouvelle tentative de Google pour imposer son hégémonie sur l'ensemble de l'économie numérique ?

Enfin, et ce n'est pas le moins important, ces systèmes informatiques portables pourront permettre d'identifier et d'enregistrer à leur insu des personnes croisées dans la rue ou dans un bureau par exemple. Une telle possibilité n'est pas acceptable sur le plan éthique car elle porte gravement atteinte au droit à l'anonymat et aux libertés individuelles. Google reconnaît d'ailleurs que cette application de la réalité augmentée sur ses futures lunettes-écran pose un vrai problème.

C'est donc une bataille économique et industrielle aux enjeux financiers colossaux qui va se jouer avec l'avènement de ce nouveau concept technologique combinant mobile, portable et téléviseur et utilisant des interfaces intuitives, voix, toucher, écriture et gestes. Informatique et ordinateur inséparables depuis plus de 60 ans, sont sur le point de se dissocier pour se fondre et se répandre dans l'ensemble des objets qui composent notre environnement, y compris sans doute notre propre corps ! Reste à savoir si notre société est prête à accepter l'avènement rapide et inéluctable de cet "homme augmenté" en gestation.

René TRÉGOUËT

Sénateur Honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

Le premier produit issu de Google X, ce laboratoire secret où la firme de Mountain View élabore des technologies futuristes, pourrait bien être une… paire de lunettes, capables « de diffuser de l’information sur le globe oculaire de l’utilisateur en temps réel ». Ces lunettes pourraient être vendues dès la fin de l’année, à un prix « similaire à celui d’un smartphone actuel ». Elles seraient basées sur Android, munies d’un petit écran incorporé dans les verres et disposeraient d’une connexion au réseau cellulaire ainsi que de capteurs de mouvements et d’un GPS.

Ce n’est pas la première fois que ces lunettes futuristes dotées d’un « affichage tête haute » sont évoquées. Un blogueur travaillant pour le site 9to5 Google en parlait déjà il y a quelques semaines et précisait qu’elles ressembleraient un peu à une paire de Oakley. Selon lui, les lunettes high-tech de Google auront une interface un peu spéciale, puisque l’on se déplacerait dans les menus par simples mouvements de tête. Les binocles seraient aussi dotées d’une caméra « de basse résolution » afin d’ajouter précisément des éléments virtuels au monde réel, par réalité augmentée.

Le New York Times ne détaille pas d’applications précises. Il explique toutefois que les lunettes « profiteront des produits Google disponibles sur le marché actuellement, mais qu’elles afficheront l’information en réalité augmentée ». On apprend aussi que « les lunettes enverront des données sur le cloud et utiliseront alors des produits comme Latitude pour partager la position de l’utilisateur, Google Goggles pour chercher des images ou savoir ce que l’on est en train de regarder, ou Maps pour afficher des endroits proches ». Les employés de Google que le journal a pu contacter indiquent par ailleurs que ces lunettes n’ont pas été conçues pour être portées tout le temps « mais, comme les smartphones, quand le besoin s’en fait sentir ».

Sergey Brin, le cofondateur de Google qui passe, selon le journal américain, « la plupart du temps dans les bureaux de Google X », serait à la tête du projet. Il n’y aurait pas de business model associé à ces lunettes, mais Google en ferait plutôt une « expérience que tout le monde pourrait rejoindre ».

Il n’en demeure pas moins que ces yeux améliorés, vus dans tant de films et séries de science-fiction, posent d’importantes questions. Les appareils électroniques wearable pourraient-ils représenter un danger pour notre vie privée et nos relations avec autrui, une fois que l’on serait « amélioré » de la sorte ? Les gens de Google ont indiqué au New York Times que « l’équipe de Google X a beaucoup discuté des implications sur la vie privée concernant ces lunettes, l’entreprise souhaite que les gens soient certains de savoir s’ils sont enregistrés par quelqu’un portant des lunettes à caméra intégrée ».

01net

|

|

|

|

|

|

|

|

|

Adepte de Google Earth et de Google Street View, vous avez peut-être déjà visité virtuellement la plupart des endroits de la planète qui vous faisaient rêver. Ne désespérez pas, la firme de Moutain View a un nouveau projet : vous faire découvrir la grande barrière de corail, au large de l'Australie, grâce à un partenariat avec des océanographes et une compagnie d'assurance, le Catlin Group Limited.

50 000 images seront accessibles sur Google Earh, Google Maps et YouTube. Des séances de visionnage en groupe sont également prévues sur Google +.

Enfin, Google devrait développer une nouvelle application, Panoramio, qui liera les photos au lieu où elles ont été prises.

Le projet, rendu possible grâce à des projets technologiques récents, ne sera pas lancé avant la fin de l'année, une expédition de grande ampleur autour de la grande barrière de corail étant nécessaire. Mais il est d'ores et déjà possible d'en avoir un aperçu sur le site du Catlin Seaview Survey, lancé le 23 février.

Atlantico

|

|

|

|

|

|

|

|

|

Les habitudes télévisées des consommateurs se modifient rapidement et évoluent vers la TV Internet et la vidéo. De nombreux téléspectateurs souscrivent à la TV par Internet et abandonnent la TV payante traditionnelle : on compte actuellement 5,1 millions de foyers qui cumulent télévision hertzienne et Internet haut-débit, un accroissement de 22,8 % par rapport à l'année dernière.

Bien que neuf foyers sur dix payent encore pour la télé, cette évolution pourrait être la plus significative car elle reflète le passage de la télévision hertzienne à la télévision par Internet, et de plus en plus de ménages coupent le cordon de la TV payante. Avec 4,5 %, les foyers TV hertzienne/ADSL représentent une petite partie de la population mais sont en croissance rapide et présentent des habitudes vidéo uniques. Ils regardent la vidéo en transit environ deux fois plus que tous les autres groupes, toutes plates-formes confondues, et ne regardent qu'à moitié autant la télévision.

Du troisième trimestre 2008 au troisième trimestre 2011, le nombre de personnes regardant la vidéo sur Internet a augmenté de 21,7 % et le temps qu'ils y consacrent de 79,5 %. Les utilisateurs qui ont regardé la télévision avec une fonction de décalage ont augmenté de 65,9 % et le temps consacré de 66,1 %. Les téléspectateurs sur téléphones mobiles ont augmenté de 205,7 % et, parmi eux, le temps consacré a augmenté de 19,8 %. Cette période de trois ans montre comment la façon de regarder la vidéo a évolué. Dans la même année, le temps consacré au petit écran a augmenté de 7,1 % pour la vidéo Internet, de 13,8 % pour la télévision à décalage et de 36,9 % pour la vidéo mobile. Internet, le décalage et la vidéo mobile sont relativement neufs et tous modifient le paysage de la vidéo sur demande, ayant atteint ce qu'on pourrait qualifier d'un niveau de pénétration stable.

La connexion haut-débit devient-elle une alternative à la télévision payante ou détermine-t-elle, en fait, de nouveaux schémas d'utilisation ? La question est complexe, mais l'enquête de Nielsen montre que le nombre de foyers cumulant TV hertzienne et Internet haut-débit a augmenté de 22,8 % et que celui des foyers à télévision câblée et Internet sans ADSL a diminué de 17,1 %. En d'autres termes, de plus en plus de foyers acquièrent la TV par Internet, y compris ceux qui payent déjà pour le câble ou le satellite. Les vitesses élevées d'Internet fournissent aux foyers qui ne disposent pas de la TV payante l'accès à du contenu suivant de nouveaux schémas d'utilisation, et donnent également, à un petit nombre d'abonnés à la télévision câblée ou à d'autres programmes de prime TV, l'option de soulager leurs dépenses.

L'Atelier

|

|

| ^ Haut |

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Des chercheurs de l’Université de la Caroline du Sud et de l’Université de Georgie aux États-Unis ont découvert un moyen de manipuler plus facilement un groupe de nanotubes de carbone à l’aide d’ultrasons et un flot d’hydrogène gazeux. Leurs résultats ont été publiés dans la revue Advanced Materials.

Les nanotubes de carbones sont envisagés comme un remplaçant possible du canal des transistors, mais ils ont aussi un avenir très prometteur dans les NEMS (Nano Electro Mecanical Systems) piézoélectriques. L’un des grands obstacles à leur démocratisation est la manipulation difficile d’un large groupe de nanotubes. En effet, ils sont hautement hydrophobiques et ils réagissent mal avec les solvants ou polymères couramment utilisés. Ils ont tendance à s’amasser en bloc, ce qui rend leur dispersion relativement complexe et hasardeuse.

L’idée d’irradier un liquide avec des ultrasons (>20 kHz) pour manipuler des nanotubes de carbone n’est pas nouvelle, mais jusqu’à présent les résultats étaient médiocres. Le processus demandait beaucoup de temps et à la fin de l’ultrasonification, les nanotubes retrouvaient leur place d’origine. Les chercheurs ont néanmoins découvert qu’en utilisant de l’hydrogène sous forme gazeuse, en même temps que les ultrasons, il est possible de disperser des nanotubes dans de l’éthanol en seulement 2 heures. En plus de résoudre les problèmes de temps et stabilité, cette solution permet de créer des structures uniformes. L’ensemble serait aussi plus solide.

Les scientifiques pensent que les ultrasons cassent les liens entre les atomes de carbones pour réagir avec l’hydrogène et former des liens C-H qui ont été confirmés par spectrométrie photoélectronique X. Une fois que les scientifiques ont obtenu la structure désirée, l’hydrogène est retiré à l’aide d’un recuit, ce qui permet de retrouver des nanotubes de carbone purs.

Présence PC

USC

|

|

|

|

|

|

|

|

|

Des chercheurs du Centre d’informatique quantique de l’Université de Nouvelle-Galles du Sud, à Sydney sont parvenus à positionner avec une précision sans précédent cet atome de phosphore au sein d’une couche de silicium en combinant des techniques déjà utilisées dans la production industrielle de semi-conducteurs classiques avec un microscope «à effet tunnel». Cette prouesse technique leur a permis de cibler un groupe de six atomes de silicium et de remplacer l’un d’eux par l’atome de phosphore, avec une précision supérieure à un demi-nanomètre (un nanomètre est un million de fois plus petit qu’un millimètre).

Jusqu’à présent, la précision obtenue pour de telles opérations était de l’ordre de 10 nanomètres, une marge d’erreur encore bien trop importante à l’échelle atomique. «Cette position individuelle de l’atome est vraiment primordiale si on veut pouvoir l’utiliser dans un ordinateur quantique», qui offrirait une rapidité et une puissance de calcul inégalées, explique Martin Füchsle, du Centre d’informatique quantique de l’Université de Nouvelle-Galles du Sud, à Sydney.

Les tests réalisés par l’équipe de Michelle Simmons ont confirmé que l’atome de phosphore jouait bien le rôle d’un transistor, comme ceux qui sont utilisés en électronique classique. Il peut servir par exemple d’interrupteur ou d’amplificateur d’un signal électrique. Mieux encore, ce transistor atomique conserverait une partie de ses propriétés quantiques, ouvrant la voie à d’autres applications. La physique quantique, en vigueur au niveau de l’atome, déroge en effet aux règles de la physique classique s’appliquant à plus grande échelle.

Cette technique, encore expérimentale, serait donc «particulièrement pertinente pour le développement de transistors au silicium à l’échelle de l’atome, et notre approche pourrait aussi être utilisée dans les ordinateurs quantiques», affirment les chercheurs. Il ne s’agit toutefois que d’un premier pas, soulignent-ils. «Pour arriver à construire un ordinateur (quantique), il faudra à terme placer un grand nombre de transistors atomiques» les uns à la suite des autres, explique Mme Simmons. Mais ces résultats sont très encourageants et démontrent qu’un dispositif constitué d’un seul atome peut en théorie être construit et contrôlé à l’aide de nanofils.

La même équipe dirigée par Michelle Simmons a par ailleurs réussi à mettre au point un tel nanofil, constitué de silicium et de phosphore, large de quatre atomes et haut d’un seul. Ce nanofil est capable de conduire le courant aussi efficacement que le banal fil de cuivre des câbles électriques de nos appareils électroménagers.

Nature technology

Nature Nanotechnology

Science

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Une innovation conçue et mise au point par L.E.S.S. ( Light Efficient SystemS ) pourrait faire économiser à nos écrans d'ordinateur 30 % d'énergie, voire même booster les processeurs. « Actuellement, la moitié de la consommation d'énergie dans les ordinateurs portables est liée à l'écran et plus particulièrement à leur éclairage » souligne Yann Tissot, fondateur de l'entreprise L.E.S.S. Apporter de la luminosité par une fibre optique comme veut le faire la start-up qui vient juste d'être créée permettrait de réduire de plus de 30 % cette dépense énergétique.

Les écrans d'ordinateurs portables sont composés de différents filtres pour les couleurs et d'une source de lumière blanche située dans la partie inférieure du cadre. Dans les LED, utilisées actuellement, 60 % de la lumière reste piégée à l'intérieur même de ces diodes, soit autant de perte. La fibre mise au point par L.E.S.S., pourrait apporter autant de luminosité et de contraste tout en économisant un tiers d'énergie. « La puissance ainsi libérée pourrait être utilisée par le processeur qui gagnerait ainsi en rapidité », ajoute l'entrepreneur.

La fibre optique ressemble à un simple fil de quelques microns de diamètre, principalement composé de verre. C'est à l'intérieur que réside son secret : une nanostructure qui permet de générer et guider la lumière blanche afin d'éclairer l'écran de manière uniforme et efficace.

Qu'en est-il de ce système face aux diodes électroluminescentes organiques (OLED), cette nouvelle technologie pour écrans plats qui ne nécessitent pas de source de lumière ? « Le principal problème de ce système est que la luminosité et donc la consommation varient selon la couleur. Lorsque l'écran est principalement composé de blanc, elles sont allumées à plein régime et donc consomment 3 fois plus qu'un système rétroéclairé par les LED. Or sur un écran d'ordinateur portable, il y a 70 % de blanc en permanence.» C'est d'ailleurs pour cette raison que cette innovation est principalement destinée aux écrans d'ordinateurs, les télévisions ayant un pourcentage de blanc moins important en raison de leur utilisation pour le visionnage de film, émission ou autre sont principalement en couleurs.

La technologie développée par Yann Tissot et son collègue Simon Rivier ouvre la voie à diverses applications. Dans un premier temps, elle sera utilisée pour éclairer des éléments à observer sous un microscope et devrait pouvoir équiper les ordinateurs d'ici quatre ou cinq ans.

Enerzine

|

|

|

|

|

|

|

|

|

La quête vers l'innovation se poursuit en Europe. Vient s'ajouter à la liste croissante de produits et services innovants le premier circuit de RFID (identification par radiofréquence) conçu et créé par l'Interuniversitair Micro-Electronica Centrum Vzw (imec) en Belgique, le centre Holst aux Pays-Bas et le consortium ORICLA («Towards electronic product coding with RFID tags based on hybrid organic-oxide complementary thin-film technology»), soutenu au titre du thème «Technologies de l'information et de la communication» du septième programme-cadre (7e PC) de l'UE à hauteur de 3,02 millions d'euros.

Ce premier circuit RFID a été développé à l'aide d'une technologie à basse température de films minces qui permet une communication de type «reader-talks-first», ou RTF, dans laquelle l'étiquette attend un message du lecteur avant d'exécuter une action. Les chercheurs expliquent que la technologie à l'origine de ce prototype est essentielle pour que les étiquettes RFID deviennent une réalité. Ces étiquettes sont suffisamment performantes pour être utilisées comme étiquettes d'articles sur l'emballage de biens de consommation en vente au détail.

Selon les chercheurs, ces étiquettes pourraient être avantageuses pour les consommateurs car elles leur permettraient d'avoir un accès rapide à des informations telles que le prix, les caractéristiques ou la fraîcheur d'un produit. Les vendeurs en profiteraient également car ils pourraient introduire une fonction de gestion automatique de la facturation et de l'inventaire.

La toile en matière plastique est utilisée pour les puces de RFID à couche mince. Commentant sur ce dernier développement, le directeur de l'électronique de grande surface et coordinateur d'ORICLA Paul Heremans : «Avec cette technologie, nous pouvons pour la première fois réaliser un circuit RFID à couche mince basse température de type RTF. Lorsque le lecteur RFID se met en marche pour la première fois et contacte l'étiquette, il transmet une horloge et des données d'identification. L'étiquette utilise ensuite ces données et cette horloge pour déterminer quand envoyer son code. Ce mécanisme permet pour la première fois de mettre en oeuvre un régime pratique anticollision pour les étiquettes RFID à couche mince.

L'équipe a utilisé une technologie hybride complémentaire organique-oxyde pour obtenir cette étiquette RFID qui passera d'un concept à un objet tangible. Les chercheurs ont associé un transistor à couche mince métal-oxyde de type n à haute température traité par solution avec un porteur de charge classique de 2 cm2/Vs à un transistor à couche mince de pentacène de type p ayant une mobilité de 1cm2/Vs. Ils ont utilisé un diélectrique à haute constante k AI203 pouvant stimuler les vecteurs actuels des transistors.

Les molécules organiques et métal-oxyde font partie de la recette de l'électronique à couche mince, qui peut être fabriquée à partir de feuilles de plastiques fines et à bas prix. Le développement d'étiquettes intelligentes à bas prix est une excellente solution pour tous.

Cordis

|

|

|

|

|

|

|

|

|

Des chercheurs soutenus par le Fonds national suisse (FNS) ont présenté un système microscopique permettant de convertir la lumière en une oscillation mécanique et de la reconvertir en lumière. Cette interaction est si puissante qu'il est possible de contrôler le mouvement de l'oscillateur au niveau où la mécanique quantique régit son comportement.

Les effets quantiques ne peuvent effectivement s’observer que sur des systèmes très bien isolés interagissant très peu avec leur environnement. Pour les objets de grande taille, l'inévitable interaction avec l’environnement élimine rapidement toute propriété quantique, dans un processus connu sous le nom de «décohérence quantique». Jusqu'à récemment, les scientifiques ne parvenaient à mettre en évidence des propriétés quantiques que dans le mouvement de minuscules objets comme des atomes isolés ou des molécules. Sous la houlette de Tobias Kippenberg, une équipe de scientifiques du Laboratoire de photonique et de mesure quantique de l'EPFL vient de prouver qu'il était possible de contrôler le mouvement d'un objet, suffisamment grand pour être visible à l'œil nu, au niveau où dominent les lois de la mécanique quantique. Pour y parvenir, ils éclairent l'objet en question avec une lumière laser. Les résultats ont été publiés dans le magazine Nature.

Cette structure a la forme d’un donut de verre minutieusement façonné sur une puce. Son diamètre est de 30 micromètres (environ la moitié du diamètre d'un cheveu), capable de vibrer à une fréquence bien définie. En même temps, la lumière circule le long de la circonférence de l'anneau comme sur un circuit de course automobile. La lumière exerce alors une légère pression sur la surface du verre à cause de la courbure suivie. Cet effet, appelé «pression de radiation», peut devenir significatif sur ces structures car la lumière parcourt jusqu'à un million de fois le tour de l'anneau avant de disparaître. De façon comparable à la vibration produite lorsque l'on passe son doigt sur le bord d'un verre à vin, l’anneau peut entrer en vibration sous l’effet de la pression de radiation. En outre, cette dernière peut également être utilisée pour amortir les vibrations et réduire ainsi le mouvement oscillant.

Le refroidissement est primordial pour atteindre le régime quantique du mouvement, qui est normalement éclipsé par les fluctuations thermiques aléatoires. C'est la raison pour laquelle la structure est portée à une température inférieure à un degré au-dessus du zéro absolu. De plus, l'amortissement par pression de radiation produit par la lumière laser lancée dans le «donut» refroidit le mouvement à une température encore 100 fois inférieure. L'oscillateur est alors tellement froid qu'il passe une grande partie du temps dans son état quantique fondamental. En fait, l'interaction entre la lumière et le mouvement de l'oscillateur peut être si forte que les deux forment une connexion intime. Une petite excitation sous la forme d'une impulsion lumineuse peut être transformée intégralement en une petite vibration, puis reconvertie à nouveau en lumière.

Pour la première fois, cette transformation entre lumière et mouvement se produit pendant une période de temps suffisamment brève pour que les propriétés quantiques de l'impulsion lumineuse initiale ne soient pas perdues par décohérence pendant l’échange. En l’emportant sur la décohérence, les résultats actuels montrent qu’il est possible de contrôler efficacement les propriétés quantiques du mouvement de l'oscillateur et de voir les étranges prédictions de la mécanique quantique à l'oeuvre sur des objets fabriqués par l'homme.

Enerzine

|

|

|

|

|

|

|

|

|

Pour se prémunir contre les défauts structurels faisant leur apparition sur bon nombre de constructions, il existe des solutions peu pratiques, et dont le coût reste souvent excessivement élevé, voire prohibitif. Une équipe de chercheurs de l'université de Strathclyde, à Glasgow, en Écosse, a mis au point une peinture qualifiée d'« intelligente », permettant de détecter et de lutter contre les minuscules défauts structurels (inclusions d'air, micro fissures) qui peuvent consteller et fragiliser sur le long terme de gigantesques constructions telles que les éoliennes, les ponts ou encore certains bâtiments publics.

On retrouve au cœur de cette peinture écologique les inévitables nanotechnologies, par le biais de nanotubes de carbone, dont le rôle ici est de détecter les mouvements sur les très grandes structures, faisant fi des méthodes de surveillance et de contrôle traditionnelles, trop complexes et chronophages. Ces méthodes traditionnelles nécessitent des outils toujours plus pointus et onéreux, allant jusqu'à engloutir des millions d'euros chaque année. Elles peuvent aller d'une simple mais fastidieuse surveillance à l’œil nu, très imparfaite, jusqu'à une très complète mais peu pratique radiographie numérique à particule.

Cette peinture intelligente est, d'après ses concepteurs, très simple d'utilisation, puisqu'une fois pulvérisée sur n'importe quel type de surface, il suffit de lui associer des électrodes, combinaison détectant les défauts longtemps avant qu'un problème plus conséquent n'apparaisse. Le processus de surveillance et de contrôle ne requiert quant à lui aucune expertise. « Son prix accessible lui donne en outre un sérieux avantage sur ses concurrents », ajoute le docteur Mohamed Saafi, responsable du département d'ingénierie civile de l'université de Strathclyde.

Les principaux composants de cette peinture intelligente sont les fameuses « cendres volantes », un sous-produit industriel recyclé, ainsi que des nanotubes de carbone. Le mélange présente des propriétés de résistance et de durabilité identiques à celles du ciment, le rendant très utile dans des environnements considérés comme difficiles.

Le processus de contrôle implique un réseau de capteurs sans-fil connectés à une source d'alimentation autonome, réseau capable par exemple de dépister les moindres micro-fissures dans les fondations d'une éolienne. « Le contrôle des éoliennes se fait encore visuellement. La mise en place de ce système pourrait réduire de manière significative les coûts de maintenance et améliorer la sécurité de ces structures », rappelle Mohamed Saafi. « La peinture intelligente permet une surveillance sur l'ensemble de la structure, alors que les technologies actuelles nous cantonnent à des zones spécifiques », ajoute-t-il, « ce qui est particulièrement utile pour maximiser les opportunités de prévention de dégâts majeurs. »

Un prototype développé par l'équipe universitaire aurait déjà fait ses preuves, et d'autres tests sont en cours dans les environs de Glasgow. Nul doute que les propriétés mécaniques des cendres volantes, ainsi que leur prix dérisoire feront pencher la balance en faveur de cette nouvelle méthode de contrôle.

Techniques de l'Ingénieur

|

|

|

|

|

|

|

|

|

La plupart des systèmes houlomoteurs développés à l’heure actuelle dans le monde génèrent l’électricité en mer. Or l’eau et l’électricité ne font pas vraiment bon ménage. Comment transférer économiquement l’énergie collectée en mer sans passer par les électrons ? En comprimant l’eau de mer ! Le milieu marin est corrosif pour le matériel électrique, ce qui conduit à utiliser des matériels de protection onéreux qui plombent l’équation économique des systèmes. Le Searaser, une innovation de l’ingénieur anglais Alvin Smith, permet de surmonter ces difficultés.

Constitué d’une bouée, d’un piston et d’un système d’ancrage, le principe de fonctionnement est très simple. La bouée suit le mouvement de va-et-vient de l’océan et compresse l’eau dans le piston. L’eau pressurisée est alors dirigée vers la terre ferme voisine et alimente une turbine produisant l’électricité onshore, et donc à l’abri des agressions marines.

Et ce n’est pas tout. L’un des défis avec les énergies renouvelables fluctuantes comme l’éolien, le solaire ou l’énergie houlomotrice, c’est d’adapter la production, variable en fonction de la météo, à la demande des consommateurs. L’approche Searaser est particulièrement prometteuse dans cette perspective. En effet, l’eau pressurisée par le mouvement de la mer peut être dirigée vers un bassin suspendu à quelques dizaines de mètres au dessus du niveau marin, ceci directement, sans faire appel à une pompe électrique.

L’eau de mer stockée en hauteur, comme dans les Stations de Transfert d’Energie par Pompage classiques (S.T.E.P.), peut ensuite descendre vers la mer qui fait office de bassin inférieur, entraînant ainsi une turbine permettant la production de l’électricité. Ceci à la demande, par exemple durant les périodes de pointe de consommation, et avec un temps de réponse très court. L’énergie ainsi stockée constitue une véritable bulle d’oxygène pour les gestionnaires des réseaux électriques.

« C’est un système très simple, et nous pensons qu’il peut produire l’électricité la meilleure marché du monde. Le potentiel est énorme » affirme Dave Vince, PDG d’Ecotricity, une entreprise anglaise spécialisée dans l’électricité durable qui a fait l’acquisition de Searaser fin 2011. Le système a été testé avec succès au large de la côte du sud-ouest de l’Angleterre. La phase commerciale va commencer dans moins d’un an : 200 unités Searaser d’1MW chacune vont d’ici 5 ans être installées le long des côtes britanniques, dont le gisement houlomoteur est considérable. Le bilan environnemental du Searaser est excellent. Les dispositifs d’ancrage des bouées/piston peuvent favoriser la fixation d’organismes marins, par effet récif. L’impact paysager est limité. Et l’électricité est générée sans émettre de gaz à effet de serre.

Techniques de l'Ingénieur

|

|

|

|

|

|

|

|

|

Doper artificiellement la photosynthèse, qui permet aux plantes et bactéries d'utiliser la lumière du soleil pour créer nutriments et énergie, représente un vaste potentiel énergétique, selon des travaux présentés récemment à une conférence scientifique.

La consommation d'énergie de la planète devrait doubler lors des quarante prochaines années tandis que les réserves connues d'hydrocarbures vont s'amenuiser, ont souligné des chercheurs américains et européens qui travaillent sur différentes approches visant à manipuler la photosynthèse. Ils ont fait le point sur l'état d'avancement de leurs recherches respectives à la conférence annuelle de l'Association américaine pour l'avancement de la science qui s'est tenue à Vancouver (Colombie Britannique, ouest du Canada).

La photosynthèse permet aux végétaux et à des bactéries de transformer le dioxyde de carbone (CO2) en composants organiques. Mais la nature n'est pas très productive. Ainsi, selon ces scientifiques, le rendement théorique maximum de ce processus pour les grandes cultures comme le blé ou la betterave à sucre ne serait que de 5 %."Les plantes, algues et certaines bactéries convertissent la lumière et le CO2 en hydrates de carbone", a précisé devant la presse Anne Jones, professeur de biochimie à l'Université d'Arizona (sud-ouest). Elle a présenté une communication à la conférence de l'AAAS.

"En fait, a-t-elle noté, tous les carburants fossiles que nous utilisons ont été produits ainsi". Les hydrates de carbone ou encore des glucides sont une source importante de l'alimentation humaine. Mais "malheureusement ce processus est relativement inefficace", a ajouté cette bio-chimiste. Si le taux de conversion de la photosynthèse pouvait être accru, même de quelques points, le potentiel d'accroissement des rendements agricoles ou de la production d'une source de bio-énergie abondante "serait très important", ont convenu ces chercheurs. Anne Jones a expliqué cette limite par la saturation assez rapide d'une enzyme appelée Rubisco qui catalyse le CO2, entraînant un ralentissement de la production d'hydrate de carbone.

Le résultat, c'est qu'une grande partie de l'énergie lumineuse de la plante est gaspillée. Cette bio-chimiste propose de récupérer ces électrons perdus durant la photosynthèse en créant, au niveau cellulaire, des "nanofils" biologiques pour les transférer dans une autre cellule produite par manipulation génétique pour fabriquer de l'énergie et des nutriments.

Howard Griffiths, un physiologiste à l'Université de Cambridge (GB), cherche à améliorer la photosynthèse du riz en manipulant l'enzyme Rubisco pour en décupler l'efficacité. C'est un peu comme un moteur à injection en mécanique. Certaines cultures comme la canne à sucre ou encore les algues et des bactéries sont naturellement dotées d'un "Rubisco" à haute performance grâce à un mécanisme moléculaire appelé C4. Cette nouvelle machinerie cellulaire pourrait être intégrée dans la cellule de la plante du riz par manipulation génétique pour obtenir de plus grands rendements dans les récoltes.

La troisième approche pour améliorer la photosynthèse présentée à Vancouver est explorée par Richard Cogdell, un biologiste de l'Université de Glasgow en Ecosse. Elle consiste à développer une feuille artificielle capable de produire directement un bio-carburant à partir du CO2 et de l'eau. Ce bio-carburant serait un terpène, hydrocarbure produit par des plantes et principal composant de la résine végétale dont est dérivée la térébenthine. "Nous n'en sommes pas encore là mais nous avons une feuille de route qui nous a amenés à mi parcours dans la direction pour surmonter ce défi....l'un des plus difficiles auxquels est confrontée l'humanité", a jugé Richard Cogdell.

Good Planet.info

|

|

|

|

|

|

|

|

|

Une étude de Bloomberg New Energy Finance (BNEF) prévoit que le coût de certains carburants, notamment ceux issus d’huiles végétales non alimentaires, pourrait être proche de ceux du kérosène d’ici à 2018. En revanche, les types de biocarburants les plus connus et les plus anciens, issus d’huiles végétales telles que l’huile de soja ou de palme pourraient ne jamais devenir compétitifs. Pour BNEF, le troisième type de biocarburants pour l’aviation existant aujourd’hui, tiré de matériaux ligneux transformés grâce au procédé Fischer Tropsch, ne devrait pas être compétitif avant le milieu des années 2020. Ils misent plus sur le procédé de la pyrolise, qui permet également de transformer le bois en carburant et devrait être certifié en 2014.

Pour les toutes prochaines années, l’étude évalue pourtant à un maximum de 2 % la proportion de biofuel que pourraient utiliser les compagnies aériennes dans leur mix. Et il s’agira probablement d’huile végétale produite à partir de denrées alimentaires, qui ne sera pas compétitive en tant que carburant mais permettra à certaines compagnies d’améliorer leurs performances environnementales et de se familiariser avec les biocarburants. Au cours actuel des denrées agricoles, BNEF estime en effet à 1,20 dollar le litre le coût de production d’une huile végétale à grande échelle, nettement supérieur aux 0,85 $ du kérosène.

En revanche, d’ici à 2018 environ, les biocarburants fabriqués à partir d’huiles non alimentaires, de jatropha ou de cameline par exemple, ou à partir de matériaux ligneux par pyrolise, pourraient devenir compétitifs. A deux conditions : passer à une production de masse et intégrer le coût de la tonne de CO2 dans la comparaison. BNEF anticipe des coûts de 0,86 dollar pour le jatropha, et 0,90 dollar pour la pyrolise. En revanche, la transformation de lignocellulose ne pourrait descendre en dessous des 2,60 dollars. Quant aux carburants issus de micro-algues, ils ne devraient pas se développer à grande échelle dans les dix prochaines années. Mais à court terme, l’aviation est surtout confrontée à la concurrence du transport routier pour l’accès à des carburants certifiés et abordables. La même contrainte vaut également pour le transport maritime, qui s’intéresse aux biocarburants pour les mêmes raisons.

Aussi, pour accroître cette proportion, les gouvernements doivent, soit subventionner des carburants jusqu’à ce qu’ils deviennent compétitifs, soit imposer des taux d’intégration, à charge aux compagnies aériennes de répercuter le surcoût sur le prix des billets. L’association internationale du transport aérien (IATA) a d’ores et déjà annoncé un objectif de 6 % en 2020, ce qui permettrait d’atteindre les objectifs de réduction d’émissions auxquels le secteur s’est engagé malgré une prévisions de hausse annuelle du trafic de 5 % environ d’ici là.

La Tribune

|

|

|

|

|

|

|

|

|

Des ingénieurs américains viennent de dévoiler un dispositif innovant qui pourrait bien donner un sacré coup de vieux aux grandes silhouettes blanches qui fleurissent dans la campagne française et s'apprêtent à envahir nos côtes. Pourtant, au premier regard, le prototype développé par Makani Power n'a rien à voir avec les éoliennes telles que nous pouvons nous les représenter. Fait de fibres de carbone, il tient plutôt du planeur ou encore du... cerf-volant. Ses ailes de 8 mètres d'envergure sont dotées d'hélices motorisées destinées à le hisser jusqu'à 400 mètres d'altitude, dans le ciel, là où le vent est à la fois plus fort et plus régulier.

Une fois en l'air, l'appareil, relié à la terre par un câble, est conçu pour adopter un mouvement circulaire perpendiculaire à la direction du vent. Cela lui permet de se maintenir dans le ciel sans consommer la moindre énergie. Ses hélices se muent alors en turbines, et son moteur en générateur. L'éolienne volante en marche, l'électricité produite est rapatriée au sol via un câble électrique. Le mouvement de giration du dispositif décuple la puissance du vent de sorte que les hélices sont entraînées à une vitesse environ dix fois supérieure à celui-ci. Or, à 400 mètres d'altitude, la force du vent est déjà en moyenne deux fois plus élevée qu'à 50 mètres, et il est aussi plus fréquent. L'actuel prototype de 8 mètres d'envergure a fourni lors des essais environ 20 Kw. La prochaine étape est de mettre au point, d'ici à 2013, une seconde génération d'éolienne volante, dotée d'une aile de 26 mètres, pour une puissance de 1 MW.

À terme, le système pourrait permettre de produire plus d'électricité que les éoliennes conventionnelles, de manière plus régulière et surtout moins onéreuse ! Car la fabrication de ce type de machine est beaucoup moins coûteuse que celle d'une éolienne traditionnelle. Et elle nécessite également peu d'infrastructures au sol. L'idée est qu'elle pourrait être accrochée à des petites plates-formes installées en mer, à plusieurs kilomètres des côtes. Makani Power - dont les recherches sont notamment financées par le département américain de l'Énergie et par le géant Google - envisage une commercialisation à l'horizon 2015. Mais la compétition bat son plein. D'autres équipes dans le monde planchent sur des prototypes d'éolienne d'altitude, notamment en Italie, au Canada et en Grande-Bretagne. Il faut dire que l'enjeu est de taille : parvenir à concurrencer les bonnes vieilles centrales thermiques avec une énergie propre et indéfiniment renouvelable.

Le Point

|

|

|

|

|

|

|

|

|

Les chercheurs de l’Université de Berkeley ont mis au point une mémoire non volatile qui serait capable de retenir ses données pendant un milliard d’années, contre seulement quelques dizaines d'années pour les puces mémoires en silicium. Les études menées conjointement avec le département américain de l’énergie n’augmentent pas seulement la durée de vie de la mémoire, mais améliorent aussi sa capacité.

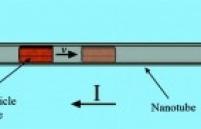

La mémoire en question utilise une nanoparticule de fer enfermée dans un nanotube de carbone. Le fer se déplace au sein du nanotube et sa position va représenter un 1 ou un 0. La particule de fer se déplace lorsqu’un courant électrique d’une faible intensité est appliquée et le système prend connaissance de la position de la particule en mesurant la résistance électrique à un endroit précis du tube.

Ce genre de mémoire permet de concentrer 500 milliards de bits par centimètre carré. Par comparaison, les dernières générations de mémoire Flash NAND Toshiba ou Samsung gravées en 32 nm à 3 bit par cellule atteignent tout juste 28 Gbit/cm2 et la dernière génération de disques durs enregistrent 51 Gbit/cm2 sur leurs plateaux.

Par ailleurs, vu que le système est hermétiquement fermé, il est moins sensible aux aléas environnementaux. De plus, le fait que cette mémoire consomme peu permet non seulement de faciliter son évolution, mais elle pourrait être fabriquée avec des outils déjà existants. Les chercheurs sont en fait tellement confiants dans leurs technologies qu’ils affirment qu’une telle mémoire pourrait débarquer sur les marchés d’ici deux ans.

Berkeley

|

|

|

|

|

|

|

|

|

Constitué d’une simple couche d’atomes de carbone disposés en nids d’abeilles, le graphène est un matériau étudié depuis le début des années 2000 pour ses propriétés physiques remarquables : c’est en effet un excellent conducteur d’électricité, mais également le meilleur conducteur thermique connu aujourd’hui. Ce qui n’a pas empêché une équipe de physiciens chinois et américains de doubler sa conductivité thermique en modifiant subtilement sa composition chimique.

En 2008, une partie de cette même équipe, menée par l’Américain Alexander Balandin de l’université de Californie à Riverside, avait déjà mesuré la conductivité thermique du graphène. A 5300 watts par mètre et par kelvin à température ambiante, ce matériau bat tous les records dans ce domaine. A température équivalente, il écrase par exemple le cuivre, pourtant bon conducteur thermique avec 400 watts par mètre et par kelvin.

Les physiciens ont tenté de déterminer si on pouvait encore améliorer cette propriété. Ils ont pour cela fabriqué une nouvelle forme de graphène, dite isotopique. Dans la nature, on trouve deux formes stables du carbone, les isotopes, qui ne diffèrent que par le nombre de neutrons dans leur noyau : le carbone 12 et le carbone 13. Le premier est ultra-majoritaire et représente 98,9 % du total. Le second ne représente que 1,1 % de l’ensemble. C’est à l’aide de méthane gazeux, déposé en couches ultrafines, que les physiciens ont fabriqué du graphène isotopique constitué à 99,9 % de carbone 12 et 0,1 % de carbone 13.

Cette substitution de 1 % de carbone 13 par du carbone 12 a des conséquences remarquables sur les propriétés thermiques du matériau. La conductivité thermique du graphène isotopique est en effet presque deux fois plus élevée que dans sa forme naturelle. Quant aux propriétés électriques et mécaniques, elles restent identiques. Comment expliquer cette différence ? Parmi les hypothèses envisagées, le graphène isotopique transporterait mieux la chaleur grâce à sa masse (il est sensiblement plus léger) et sa structure atomique sensiblement différentes. Dans un solide, la conductivité thermique dépend des phonons, les modes de vibration des atomes entre eux. En modifiant la structure atomique du graphène, on favoriserait alors certains phonons, ce qui augmenterait le transport de chaleur au sein du réseau d’atomes de carbone.

« Cette expérience modifie notre vision du fonctionnement de la conductivité thermique » explique Clément Faugeras, du Laboratoire national des champs magnétiques intenses à Grenoble. « On comprend désormais mieux comment certains phénomènes microscopiques, ici une modification de la masse atomique, ont des conséquences macroscopiques sur la conduction thermique. Cela ouvre de nouvelles perspectives pour l’étude de phénomènes thermiques dans d’autres matériaux uni ou bidimensionnels » poursuit-il.

La Recherche

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Une étude publiée dans la revue Science montre que la sécheresse est en partie responsable de la disparition des Mayas, mais qu'elle a été moins forte que ce que les scientifiques pensaient : «Aucune estimation fiable n'avait été réalisée sur la gravité de cette sécheresse, mais certains avaient suggéré des scénarios extrêmes», relève le site Fox News.

Menées par le Centre pour la recherche scientifique du Yucutan au sud du Mexique, ces recherches se fondent sur l'étude de trois lacs et d'une stalagmite précise le site Science et avenir, ce qui permet de connaître l'équilibre «entre l'évaporation et les précipitations» de l'époque. Les résultats établissent qu'une faible réduction des précipitations annuelles de 25 % à 40 %, due au manque d'orage en été, avait suffit à épuiser les réserves d'eau de la région entre 800 et 950 après J-C : «L'été est la saison principale pour la culture et la reconstitution des systèmes de stockage d'eau douce chez les Mayas. Les perturbations sociétales et l'abandon des villes sont les conséquences probables de graves pénuries d'eau qui se sont répétées chaque été.»

Les caractéristiques de la sécheresse responsable de la perte des Mayas sont similaires à celles prévues dans un futur proche pour cette même région par le Groupe d'experts intergouvernemental sur l'évolution du climat (Giec). Les chercheurs voient alors dans cette conclusion comme un message d'alerte, relève le site de la BBC : «Ce qui semble être une diminution mineure de la disponibilité en eau peut avoir des conséquences durables et importantes. Le problème n'est pas propre à la péninsule du Yucatan, mais s'applique à toutes les régions dans des contextes similaires où l'évaporation de l'eau est forte.»

Les Mayas ont prospéré pendant près de 6 siècles et sont réputés pour être l'une des civilisations les plus riches du Nouveau Monde. Ils sont à l'origine d'avancées spectaculaires dans les domaines de l'astronomie, l'architecture, les mathématiques, l'art et l'écriture.

Slate

|

|

|

|

|

|

|

|

|

La légère amélioration enregistrée en 2009 (- 1,3 % d'émissions de CO2 dans le monde) n'était qu'illusoire et les experts du GCP expliquent qu'elle était liée aux conséquences de la crise financière globale. Cynisme quand tu nous tiens... En effet, les émissions de CO2 sont reparties à la hausse en 2010, une hausse de surcroît très significative de 5,9 %. 36 milliards de tonnes de CO2 (soit prés de 10 gigatonnes de carbonne) ont ainsi été libérées dans l'atmosphère en 2010, valeur intégrant l'effet des déforestations. C'est tout simplement le niveau le plus élevé de l'histoire de l'humanité et cela représente une hausse vertigineuse de près de 40 % par rapport à 1990. Vive Kyoto...

Notons encore que le GCP avance cette valeur : la concentration globale en CO2 de l'atmosphère s'établit à 390 ppm (parties par million). Le charbon demeure la bête noire environnementale, puisqu'il représente 41 % des émissions liées aux combustibles fossiles.

Au niveau des pays, le niveau d'émissions progresse sans surprise dans les pays émergents (+ 7,6 % au global contre 3,4 % pour les pays développés). Les plus fortes progressions ont été identifiées en Chine (+ 10,4 %) et en Inde (+ 9,4 %). Une donnée que les experts du GCP relativisent toutefois en soulignant que les pays développés "externalisent" une grande partie de leurs émissions via leurs implantations industrielles dans les pays émergents. En outre, sur l'autel de la rentabilité, ces sites pourtant récents ne suivent pas toujours des normes environnementales aussi strictes que dans les marchés traditionnels.

En valeur absolue, les pays qui émettent le plus de CO2 sont la Chine, les Etats-Unis, l'Inde, la Russie et le Japon. Mais attention, per capita, la Chine et l'Inde apparaissent encore éloignées des Etats-Unis, de la Russie et du Japon. Dans la zone Europe, l'Allemagne a le rôle du mauvais élève en 2010, tandis que la France figure dans la même tranche que le Royaume-Uni et l'Italie. Toujours dans cette zone, les pays les plus vertueux en 2010 ont été l'Espagne, la Suisse et plusieurs pays de l'Est.

Enfin, les experts du GCP mettent en exergue un autre indicateur négatif : le niveau des émissions progresse dorénavant plus vite que la croissance économique mondiale, ce qui traduit une perte d'importance des enjeux environnementaux et climatiques...

Journal Auto

|

|

|

|

|

|

|

|

|

La Banque mondiale a proposé ces jours derniers la création d'un «Partenariat mondial pour les océans» qui rassemblerait gouvernements, ONG, scientifiques et secteur privé, afin de lever 1,5 milliard de dollars sur cinq ans.

«Je veux proposer une nouvelle approche, un Partenariat mondial pour les océans», a déclaré le président de la Banque mondiale (BM) Robert Zoellick, dans un discours prononcé à Singapour lors d'une conférence sur les océans.

Surpêche, dégradation des fonds marins et de l'eau, réduction de l'habitat : «Les océans de la planète sont en danger», a tonné M. Zoellick.

Environ 85 % des zones de pêche sont exploitées à leur maximum, surexploitées ou déjà vidées de leurs réserves de poissons alors que, dans les pays en voie de développement, un milliard de personnes dépendent des produits de la mer pour leur apport en protéine et environ la moitié en tirent leurs revenus, a-t-il souligné.

«Les faits ne mentent pas et les statistiques montrent que nous ne faisons pas assez, les océans continuent à tomber malades et à mourir», a prévenu M. Zoellick. Il a fixé plusieurs objectifs pour la décennie à venir, dont la reconstitution de la moitié des stocks de poissons et le doublement des réserves marines (2 % des mers actuellement contre 12 % des terres). Les ONG, la Banque mondiale, les États dépendent annuellement plusieurs centaines de millions de dollars dans la protection des océans.

Mais «pour permettre à nos océans de redevenir sains et productifs, nous avons besoin de davantage de coopération, d'une action intégrée à l'échelle mondiale, pour que nos efforts se conjuguent plutôt que de n'être que la somme d'actions séparées», a souligné M. Zoellick.

Dans un premier temps, le partenariat s'engage à lever au moins 300 millions de dollars affectés à son fonctionnement et à la coordination, puis 1,2 milliard pour les projets concrets. La réunion constituante de ce partenariat se tiendra à Washington en avril.

Cyberpresse

|

|

|

|

|

|

|

|

|

Une nouvelle étude réalisée par les scientifiques de la NASA indique que ce sont les gaz à effet de serre résultant de l’activité humaine, et non pas des variations de l’activité solaire, qui sont le principal facteur du réchauffement de la planète.

Cette étude actualise l’évaluation du déséquilibre du bilan énergétique de la Terre, c’est-à-dire de la différence entre la quantité d’énergie solaire absorbée par la surface de la Terre et celle restituée dans l’espace, sous forme de chaleur. Les calculs des chercheurs montrent que malgré une activité solaire inhabituellement faible entre 2005 et 2010, la planète a continué d’absorber plus d’énergie qu’elle n’en a renvoyée vers l’espace. L’irradiance solaire totale, qui mesure la quantité d’énergie solaire reçue par mètre carré au sommet de l’atmosphère, décline généralement d’environ 0,1 % durant les accalmies cycliques de l’activité solaire qui sont causées par les changements du champ magnétique du soleil. Habituellement, les minimums solaires se produisent environ tous les onze ans et durent un ou deux ans, mais le minimum le plus récent s’est prolongé plus de deux ans au-delà de la moyenne, ce qui en fait le plus long minimum enregistré par les satellites.

La mesure de l’ampleur du déséquilibre du bilan énergétique de la Terre est fondamentale pour la climatologie, car elle permet une observation directe de l’état du climat. Ces calculs des déséquilibres énergétiques peuvent également servir de base pour les projections sur les changements climatiques futurs. Si ce déséquilibre est positif, avec plus d’énergie entrant dans le système que n’en sortant, la Terre se réchauffe. Si ce bilan est négatif, la planète se refroidit.

James Hansen, responsable du Goddard Institute for Space Studies de la NASA (GISS) à New York, a dirigé cette recherche, publiée en décembre par la revue Atmospheric Chemistry and Physics. L’équipe de Hansen conclut que la Terre a absorbé plus de 0,5 Watt par mètre carré d’énergie solaire qu’elle n’en a restitué, durant la période de six ans sur laquelle porte l’étude. La valeur du déséquilibre observé (0,58 watts d’énergie en excès par mètre carré) équivaut au double de la variation de l’énergie solaire reçue par la planète entre l’activité maximale et minimale du soleil (0,25 watts par mètre carré).

« Le fait que nous observions encore un déséquilibre positif, malgré ce minimum solaire prolongé ne constitue pas une surprise, étant donné ce que nous avons appris sur le système climatique, mais il est intéressant de noter que cela apporte une preuve sans équivoque que le soleil n’est pas le facteur dominant du réchauffement climatique », déclare Hansen. Selon les calculs effectués par Hansen et ses collègues, ce déséquilibre de 0,58 Watts/m2 implique que la concentration de dioxyde de carbone dans l’atmosphère doit être réduite à environ 350 parties par million (ppm) pour restaurer le l’équilibre du bilan énergétique. Les mesures les plus récentes montrent que le niveau de dioxyde de carbone atteint actuellement 392 ppm et les scientifiques s’attendent à ce qu’il continue d’augmenter à l’avenir.

Ce nouveau calcul du déséquilibre du bilan énergétique a des implications importantes pour la modélisation du climat. Sa valeur, légèrement inférieure aux estimations précédentes, suggère que la plupart des modèles climatiques surestiment le réchauffement des couches profondes de l’océan et sous-estiment de manière significative l’effet de refroidissement dû aux petites particules en suspension appelées aérosols, qui, avec les gaz à effet de serre et l’irradiance solaire, sont des facteurs déterminant dans le calcul du bilan énergétique. « Les modèles climatiques simulent les changements observés dans les températures globales assez précisément, donc si leur modélisation de la diffusion de la chaleur dans les couches profondes de l’océan est excessive, il s’ensuit que ces modèles sous-estiment l’ampleur de l’effet de refroidissement des aérosols, » précise Hansen.

Les aérosols, qui peuvent soit réchauffer, soit refroidir l’atmosphère en fonction de leur composition et de leur interaction avec les nuages, sont considérés comme ayant un solde net provoquant un refroidissement. Mais les estimations de leur impact global sur le climat sont assez incertaines, étant donné qu’il est difficile de mesurer la répartition de ces particules sur une grande échelle. Cette nouvelle étude suggère que l’effet de refroidissement global des aérosols pourrait être environ deux fois plus fort que ne le suggèrent les modèles climatiques actuels, en grande partie parce que ces modèles prennent peu compte la façon dont ces particules affectent les nuages.

Contre Info

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Le mode d’action des antibiotiques conventionnels – tuer les bactéries ou inhiber leur croissance – est à même d’induire une forte sélection et le développement d’une antibiorésistance. On s’intéresse aux approches alternatives, ciblant la pathogénie microbienne sans inhiber la croissance des micro-organismes, qui devraient réduire la sélection des micro-organismes résistants.

Ainsi, pour combattre les infections par les streptocoques du groupe A (SGA), on recherche des composés inhibant l’expression du gène de la streptokinase, un facteur de virulence de ces pathogènes. En passant au crible 55 000 petites molécules, des chercheurs américains (Universités du Missouri et du Michigan) ont identifié des composés capables de cette inhibition. Ils démontrent que le composé principal (nommé CCG-2979), ainsi qu’un analogue (CCG-102487), inhibent la production de protéine streptokinase active.

Les analyses par puces à ADN montrent une régulation négative de gènes codant plusieurs facteurs de virulence supplémentaires, « suggérant une interruption d’un gène plus général de virulence, démantelant un réseau de gènes intervenant dans la virulence. » Il n’y a pas d’inhibition de la croissance bactérienne. Mais les essais in vitro avec les deux composés montrent une augmentation de la phagocytose des SGA par les granulocytes. Enfin, ce qui est le plus intéressant, les études in vivo chez la souris avec ces deux composés montrent qu’ils ont le pouvoir de réduire significativement la gravité des infections par les SGA : la mortalité des souris d’un modèle murin sensible à l’infection par les SGA est significativement réduite.

Le Quotidien du Médecin

|

|

|

|

|

|

|

|

|

Il y a plus de 55 millions d'années, un cheval primitif n'était pas plus gros qu'un chat... En cause: la hausse des températures à la surface du globe.

Certes, ce lointain ancêtre du cheval qui vivait il y a plus de 50 millions d’années en Amérique du Nord n’avait pas la taille d’un étalon de champ de course. Le Sifrhippus sandrae ne pesait guère plus de 5,6 kg. Il a même rétréci jusqu’à peser moins de 4 kg : le poids d’un chat. Qu’est-ce qui l’a fait ainsi rétrécir ? La hausse de la température, expliquent aujourd’hui des chercheurs dans la revue Science.

L’équipe coordonnée par Ross Secord (University of Nebraska) et Jonathan Bloch (University of Florida) a reconstitué l’évolution de la taille du Sifrhippus au cours d’une période de réchauffement de la Terre connue comme le maximum thermique du Paléocène-Eocène. Entre -55,5 millions et –54,5 millions d’années, la température à la surface des océans a grimpé de 5°C. La quantité de carbone dans l’atmosphère aurait été de 2.000 à 3.000 ppm contre 380 ppm (parties par million) actuellement. Les écosystèmes ont donc été fortement bouleversés.

Grâce à l’analyse de fossiles appartenant à 44 individus adultes de Sifrhippus, l’équipe de Secord et Bloch a pu reconstituer l’évolution de la taille de l’équidé au cours de cette période chaude. Il perd 30 % de sa taille au début, passant de 5,5 kg en moyenne à 3,8 kg ; puis regagne 75 % à la fin de la période, atteignant 6,8 kg.

Restait à déterminer la cause principale de cette évolution : est-elle directement liée à la température ou plutôt à la nourriture disponible (la productivité de l’écosystème)? La courbe des températures, reconstituée à partir des analyses isotopiques, est directement corrélée à la taille des petits chevaux : plus il fait chaud, plus ils rétrécissent. En revanche, les chercheurs n’ont pas retrouvé cette corrélation avec la productivité de l’écosystème dans lequel vivaient les Sifrhippus.

Ces résultats témoignent d’une évolution de la taille d’un mammifère à court terme à l’échelle de l’histoire de la Terre. Des données importantes pour essayer de comprendre quelles pourraient être les conséquences du réchauffement climatique en cours sur les espèces actuelles.

Sciences et Avenir

|

|

|

|

|

|

|

|

|

C'est désormais possible avec la méthode qui vient d'être mise au point par des chercheurs d'une équipe du Laboratoire de chimie bactérienne de l'Institut de microbiologie de la Méditerranée (CNRS/Aix-Marseille Université) et leurs collègues du Laboratoire de glycochimie moléculaire et macromoléculaire de l'Institut de chimie moléculaire et des matériaux d'Orsay (CNRS/Université Paris-Sud). Celle-ci permet de détecter les bactéries vivantes de type Gram négatif, auquel appartiennent des pathogènes tels que Escherichia coli, Salmonella typhimurium et Legionella pneumophila.

Pour y parvenir, les chercheurs mettent en contact ces bactéries avec du KDO, un sucre dont ces dernières se servent pour synthétiser un polysaccharide spécifique de leur membrane cellulaire. Mais le KDO utilisé par les chercheurs présente la particularité d'avoir été préalablement modifié, ceux-ci y ayant introduit une fonction azoture, constituée de trois atomes d'azote. Ainsi leurrées, les bactéries intègrent alors ce sucre artificiel à leur membrane.

L'utilisation d'une molécule fluorescente qui s'attache exclusivement au groupe azoture permet ensuite de reconnaître et de compter rapidement les bactéries Gam négatif vivantes, les seules à avoir assimilé le KDO modifié.

Les résultats obtenus à l'aide de cette nouvelle méthode sont d'autant plus importants qu'il n'existe pas à ce jour de méthode rapide qui permette simultanément de détecter et de dénombrer les bactéries vivantes d'intérêt. Qui plus est, les méthodes utilisées actuellement ne donnent pas entière satisfaction. Si certaines sont lentes en raison de la mise en culture qu'elles nécessitent et qui peut demander jusqu'à plusieurs semaines d'attente avant l'établissement de leur dénombrement, d'autres plus rapides peuvent hélas donner de faux négatifs ou positifs.

Dans ces conditions, cette nouvelle méthode pourrait rapidement devenir un outil indispensable en matière de contrôle qualité microbiologique et de santé publique. A terme, l'utilisation d'un sucre spécifique de chaque bactérie d'intérêt devait permettre la détection d'un très large éventail de bactéries pathogènes vivantes.

Bulletins Electroniques

|

|

|

|

|

|

|

|

|

Une équipe de chercheurs de l'Institut Pasteur et du CNRS vient de mettre en évidence une protéine capable de contrôler spécifiquement l'activité d'une enzyme dont le dysfonctionnement est associé au développement de nombreux cancers. Ce travail révèle une cible thérapeutique potentielle pour le traitement de ces tumeurs. PLK1 est une enzyme présente à toutes les étapes de la mitose, ce processus clé de la vie des cellules qui permet à une cellule mère de se diviser en deux cellules filles.

L'expression de la protéine PLK1 est augmentée dans de nombreux cas de cancers (du sein, colorectal, de l'estomac et de l'œsophage, du pancréas, de la peau, de l'utérus, du larynx, certains cancers du poumon...). Afin de réguler cette surproduction de PLK1, la communauté scientifique cherche depuis de nombreuses années à identifier des inhibiteurs spécifiques pouvant être utilisés à des fins thérapeutiques. Ces recherches se sont cependant révélées décevantes. Les molécules proposées ont toutes des effets secondaires importants, dus à leur manque de spécificité.

Une équipe dirigée par Robert Weil, de l'unité de Signalisation moléculaire et activation cellulaire (Institut Pasteur et CNRS) a mis en évidence la capacité d'une protéine, appelée Optineurine, à inactiver spécifiquement PLK1. L'étude in cellulo montre en effet qu'en l'absence d'Optineurine, l'activité de PLK1 n'est plus contrôlée. Il en résulte des anomalies cellulaires importantes : défauts de séparation des chromosomes, cellules à plusieurs noyaux, etc. Cette publication décrit également comment ce contrôle s'exerce par une régulation réciproque de leurs deux activités.

Plus connue jusqu'à présent pour son rôle antibactérien et antiviral, Optineurine, identifiée comme régulateur spécifique de PLK1 ouvre de nouvelles perspectives thérapeutiques dans le cas de tumeurs associées à une surexpression de PLK1 : cibler Optineurine devrait permettre d'entraver la prolifération cellulaire non contrôlée qui caractérise les cancers.

CNRS

|

|

|

|

|

|

|

|

|

Selon des chercheurs allemands et britanniques sous la direction de l'université de Southampton au Royaume-Uni, les vitamines pourraient contribuer à lutter contre le paludisme. Les résultats de l'étude, présentés dans la revue Structure, pourraient encourager le développement de médicaments plus efficaces contre la maladie. Cette dernière affecte plus de 250 millions de personnes chaque année, et tue plus de 650 000 personnes. L'étude était partiellement financée au titre du sixième programme-cadre (6e PC) de l'UE.

Les vitamines sont des nutriments essentiels qui ne sont nécessaires qu'à petites doses. Mais en trop petites quantités, elles peuvent entraîner des carences. Les chercheurs pensent que plusieurs micro-organismes pathogéniques produisent des vitamines ; les voies biosynthétiques pourraient être un facteur essentiel pour le développement de traitements innovants.

Des études ont montré que les médicaments antifolates ciblant la biosynthèse de la vitamine B9 des parasites du paludisme jouent un rôle essentiel dans le traitement de la maladie. Les chercheurs se sont penchés sur la biosynthèse de la vitamine B6 du parasite en tant que cible médicamenteuse.

L'Organisation mondiale de la santé (OMS) explique que le diagnostic précoce et le traitement rapide sont deux éléments fondamentaux pour contrôler le paludisme. Les traitements précoces efficaces de la maladie peuvent réduire la durée et l'étendue de l'infection.

Mais le plus gros problème pour contrôler la maladie est le degré élevé de résistance développé par les espèces de Plasmodium contre les traitements actuels. Le paludisme est transmis par la piqûre de moustiques infectés. Ainsi la découverte de nouvelles cibles médicamenteuses et des chimiothérapies antipaludéennes est impérative.

Dans cette étude, les chercheurs ont identifié les enzymes paludéennes responsables de la biosynthèse de la vitamine B6 avec des structures tridimensionnelles (3D). L'équipe explique que la biosynthèse de cette vitamine est un processus très organisé qui implique une enzyme complexe de 24 sous-unités protéiques. Grâce à la microscopie électronique, ils ont examiné l'assemblage des protéines individuelles.

«Les études structurelles expliquent l'activation de ces enzymes vitales et montrent que le substrat de biosynthèse de la vitamine B6 devrait apporter des informations sur la chimie de la biosynthèse de PLP», commente le Docteur Ivo Tews, professeur en biologie structurelle à l'université de Southampton. «Le complexe enzymatique a un tunnel interne fascinant pour le transfert d'intermédiaires de réactions réactifs. Les études ont également souligné une organisation inattendue des complexes enzymatiques en fibres. Les nouvelles informations constituent un point de départ au développement d'inhibiteurs spécifiques ciblant les sites actifs des enzymes ou l'assemblage des protéines en complexes fonctionnels.»

Cordis

|

|

|

|

|

|

|

|

|

Une nouvelle combinaison de médicaments expérimentaux pourrait lutter efficacement contre le très agressif cancer du pancréas, selon ces scientifiques du Cambridge Research Institute, qui pubblient leurs résultats dans l’édition du 20 février du Journal of Experimental Medicine. Il s’agit d’une chimiothérapie comportant un médicament existant, la gemcitabine combiné avec un produit chimique expérimental appelé MRK003. Ce composé qui peut bloquer l’action de la protéine «gamma-sécrétase » participe à l'augmentation de la survie et à l'arrêt de la progression de la tumeur.

Le cancer du pancréas est un cancer de faible pronostic, généralement diagnostiqué à un stade avancé, un stade de résistance à de nombreux traitements conventionnels. C’est le 5e cancer le plus mortel et les patients atteints au stade métastatique ont une survie moyenne de 2 à 6 mois.

Pour tester l'effet de cette combinaison, ces chercheurs de la Cambridge University et du laboratoire de recherche de Merck ont administré la combinaison à des souris génétiquement modifiées pour développer un type de cancer du pancréas, l'adénocarcinome canalaire pancréatique qui représente environ 90 % des cas de cancer du pancréas. Ces souris ont survécu 26 jours avec le traitement combiné, alors qu’elles ne survivent que 9 jours sans le traitement. Cette étude sur l’animal apporte des résultats prometteurs pour cette thérapie combinée et un grand espoir aux patients.

Les chercheurs constatent que MRK003 diminue certains marqueurs de l'expression du cancer. Lorsqu'il est administré seul, MRK003 n'a aucun effet sur la survie du modèle animal, mais en combinaison avec la gemcitabine, il permet de porter la survie de 9 à 26 jours. Par ailleurs, en combinaison avec la gemcitabine, il favorise la mort des cellules tumorales et réduit la croissance tumorale.

Les inhibiteurs de la gamma-sécrétase (ou MRK003) en combinaison avec la gemcitabine sont un traitement prometteur pour les patients atteints d'un adénocarcinome canalaire pancréatique, concluent les chercheurs. L’Institut de recherche sur le cancer du Royaume-Uni signale également qu'un essai clinique, sur l’Homme est en cours sur l’efficacité de la combinaison gemcitabine et bloquant de la gamma-sécrétase pour le traitement du cancer du pancréas.

Santé Log

|

|

|

|

|

|

|

|

|

Seconde maladie neurodégénérative la plus fréquente après la maladie d’Alzheimer, la maladie de Parkinson se manifeste à partir de 50 ans par un tremblement de repos, des troubles du tonus et une akinésie. Elle se caractérise par une perte progressive des neurones dopaminergiques et une accumulation de corps de Lewy. Si son origine reste assez floue (facteurs environnementaux et génétiques), Parkinson est une maladie chronique, évolutive, et à ce jour, toujours incurable. En France, près de 100 000 personnes sont touchées par cette affection et près de 8 000 nouveaux cas sont diagnostiqués par an.

Jun Takahashi et ses collègues de l'Université de Kyoto ont mis en place un essai clinique qui consistait à injecter directement des cellules souches humaines (dont 35 % d’origine neurologique) dans le cerveau de quatre singes dont les membres bougeaient spasmodiquement (un des symptômes les plus courants de la maladie de Parkinson), et qui avaient du mal à contrôler leur corps.

Six mois après l’implantation, les premiers résultats étaient concluants. En effet, tous étaient de nouveau capables de marcher, et après analyse, les chercheurs ont constaté qu’environ 10 % cellules souches transplantées, d'origine neurologique, étaient toujours présentes dans le cerveau des singes. Forts de ce premier succès, les scientifiques japonais espèrent pouvoir mener les premiers essais cliniques chez l’homme, d’ici à 2015…

Information Hospitalière

|

|

|

|

|

|

|

|

|

Le sport est utile en termes de prévention du cancer, mais aussi en cours de traitement. Une note de l'Institut national du cancer (INCa), publiée le 14 février, dresse l'état des connaissances actuelles. Elle indique que l'activité physique est associée à une diminution de 25 % à 30 % de survenue des cancers du sein (surtout après la ménopause), du cancer du côlon et de l'endomètre. Des publications mentionnent l'effet protecteur de l'activité physique pour d'autres cancers (poumon, pancréas, prostate, ovaire), mais "les données sont encore insuffisantes pour en tirer des conclusions", précise l'INCa.

Une conférence s'est tenue sur ce sujet le 1er février, à Paris, lors du 7e Forum francophone de cancérologie, organisée par l'association Cancer, arts martiaux et information (CAMI), créée en 2000 par le docteur Thierry Bouillet, cancérologue au CHU Avicenne, à Bobigny (Seine-Saint-Denis), et Jean-Marc Descotes, professeur de karaté. Le bénéfice de l'activité physique après le diagnostic du cancer est démontré par de nombreuses études en termes de survie et d'amélioration de la qualité de vie, avec une réduction du risque de mortalité et de récidive. "La pratique d'une activité modérée trois heures par semaine ou d'une activité intense de trois fois vingt minutes par semaine diminue de 30 % le risque de mortalité prématurée", souligne le docteur Thierry Bouillet.

"Les études montrent un "effet dose" : plus on fait de sport, mieux c'est. Souvent, les personnes qui pratiquent une activité sportive ont une alimentation plus saine, fument moins, etc. Ce sont autant de facteurs protecteurs contre la maladie", explique le professeur Martine Duclos, chef du service médecine du sport au CHU de Clermont-Ferrand. "Pendant longtemps, on a dit au patient, "reposez-vous" ; or, le fait de pratiquer une activité physique permet de lutter contre la fatigue", constate le professeur Michel Pavic, de l'hôpital d'instruction des armées Desgenettes à Lyon. Un symptôme qui affecte environ 80 % des patients tout au long de la maladie. Au-delà des effets prouvés sur la maladie, "la pratique d'un sport amoindrit les symptômes dépressifs, améliore l'image corporelle, permet d'avoir accès, dans la panoplie des traitements, à quelque chose de plaisant, cela peut aussi être rassurant pour les proches en renvoyant une image de normalité", souligne Sarah Dauchy, psycho-oncologue à l'Institut Gustave-Roussy de Villejuif (Val-de-Marne).

Le Monde

|

|

|

|

|

|

|

|

|

Des chercheurs américains du Centre médical de Boston ont montré que la vitesse à laquelle nous marchons ou la force de notre poignée de main pourraient déterminer le risque d'une future démence ou d'un accident vasculaire-cérébrale (AVC) selon le site de la BBC :

«Scanner cérébral, vitesse de marche et force de préhension ont été enregistrés pour 2.410 personnes qui étaient âgées en moyenne de 62 ans. Les résultats présentés à la rencontre annuelle de l'Académie de neurologie disent que 11 ans plus tard, 34 personnes avaient développé une démence et 79 avaient eu un accident vasculaire cérébral.»

A partir de 65 ans, les personnes marchant lentement sont 1,5 fois plus susceptibles de devenir folles ou atteintes de la maladie d'Alzheimer que celles qui marchent plus rapidement, et les personnes ayant peu de force de préhension ont un risque supérieur à 42 % de subir un AVC, explique le site de santé Health : «Les chercheurs ont constaté qu'une vitesse de marche lente était associée à un moins grand volume total du cerveau et à une moins bonne performance dans les tests sur la mémoire, le langage et la prise de décision. Une poignée de main plus forte a été associée à un plus grand volume total du cerveau et à de meilleurs résultats sur les tests de pensée et de mémoire durant lesquels les gens devaient identifier les similitudes entre les objets.»

Ces études démontrent les effets d'une faiblesse physique sur la santé de personnes d'âge moyen, ces effets n'ont pas été observés chez les personnes de moins de 65 ans et l'avaient déjà été chez des personnes âgées.

Les chercheurs reconnaissent que d'autres recherches doivent être effectuées pour déterminer si cette faiblesse est un symptôme pré-clinique de la démence ou de la propension à être victime d'un AVC, selon le Huffington Post : «On ne sait pas vraiment si les gens dans cette étude avaient d'autres problèmes de santé qui pourraient avoir une incidence sur leur vitesse de marche, et qui pourraient également augmenter le risque de démence.»

Bien que ces résultats soient préliminaires, les chercheurs précisent que ces tests peuvent être facilement effectués par un médecin généraliste ou un neurologue dans le but de prévenir un risque.

Slate

|

|

|

|

|

|

|

|

|