|

|

|

|

|

| NUMERO 637 |

|

|

|

|

|

|

|

Edition du 02 Février 2012

|

|

|

|

|

Edito

L’énergie nucléaire entre dans une ère nouvelle

Il y a quelques jours, la Cour des Comptes a publié un rapport très attendu, le premier du genre, sur les coûts réels de la production d'électricité nucléaire en France. Ce rapport passionnant nous apprend que le montant total des investissement réalisés en France depuis 1957 dans le domaine du nucléaire civil se monte à environ 121 milliards d'euros constants (valeur 2010). Au total, chaque MW nucléaire installé a donc coûté 2 millions d’euros en investissements.

Si l’on fait à présent le ratio production électronucléaire annuelle (410 milliards de kWh) sur investissements, on obtient un coût de production annuelle (hors maintenance) de 30 centimes par kWh nucléaire produit.

Ce rapport essaye également d'estimer le coût des charges à venir, ce qui constitue un exercice délicat, compte tenu des incertitudes économique, politiques et technologiques dans ce domaine.

Ce coût prévisionnel comporte trois composantes majeurs : d'abord le démantèlement des centrales qui arriveront en fin de vie dans les décennies à venir. Ce démantèlement représente un coût qui varie, selon les experts, de 18 à 30 milliards d'euros pour nos 58 réacteurs actuels. Vient ensuite la maintenance et la mise aux nouvelles normes de sûreté décidée à la suite de la catastrophe de Fukushima : 50 milliards d'euros à prévoir d'ici 2025. Enfin, la dernière composante concerne le retraitement et le stockage à long terme des déchets hautement radioactifs qui représentent un coût beaucoup plus difficile à cerner mais qui est estimé à une fourchette qui va de 28 à 35 milliards d'euros.

Parallèlement à ce rapport de la Cour des Comptes, le Commissariat à l'Energie Atomique a publié un rapport envisageant différents scénarios de sortie du nucléaire. Le CEA a comparé une hypothèse dans laquelle la production d'électricité nucléaire reste à son niveau actuel d'environ 75 % (le solde étant assuré à 11 % par l'hydraulique, 10 % par d'éolien, 2 % par le solaire et 2 % par le gaz) à une autre hypothèse envisageant une sortie complète du nucléaire d'ici 2025 avec le scénario énergétique suivant : 60 % d'éolien, 12 % de solaire, 16 % de gaz et 12 % d'hydraulique. Le premier scénario supposerait un investissement de 178 milliards à 212 milliards d'euros alors que le scénario de sortie du nucléaire entraînerait un investissement bien plus important, de l'ordre de 352 à 560 milliards d'euros.

Ces études confirment, comme nous l'avons déjà souligné dans cette Lettre, que, sauf à l'étaler sur une période très longue (au moins un demi-siècle), une sortie complète du nucléaire serait non seulement très coûteuse pour notre Pays mais entraînerait de surcroît une augmentation sensible de nos émissions de CO2 (moins de 6 tonnes par an et par habitant, contre 10 tonnes pour un allemand et 8 tonnes pour un européen) incompatible avec nos engagements en matière de lutte contre le réchauffement climatique. On peut bien sûr nier cette réalité pour des raisons idéologiques mais elle n'en demeure pas moins vraie !

Reste que l'utilisation massive et durable de l'énergie nucléaire en France pose un vrai problème d'acceptabilité sociale qui nécessite une transparence totale et une information beaucoup plus complète de nos concitoyens des spécificités de cette énergie.

A cet égard, il faut souligner que la question redoutable et sensible de la gestion des déchets hautement radioactifs est en train d'être bouleversée par deux ruptures technologiques majeures.

La première concerne la transmutation qui vise à transformer les déchets très radioactifs en éléments beaucoup moins radioactifs et à durée de vie courte en les bombardant par des neutrons produits par un réacteur spécialement conçu à cet effet. L'Europe a en effet lancé le projet très prometteur du réacteur de recherche Myrrha (Multi-purpose hybrid research reactor for high-tech applications), conçu par le Centre d’étude de l’énergie nucléaire (SCK-CEN). Ce projet vient de démontrer, il y a quelques semaines, la faisabilité technique, via la fission nucléaire, de la transmutation des déchets radioactifs à longue durée de vie en déchets à courte durée de vie.

Grâce à ce réacteur Myrrha, il est désormais envisageable de traiter une importante catégorie de déchets nucléaires, les actinides ainsi que le plutonium, le neptunium, l'américium et le curium. Après une irradiation appropriée par une réaction de fission, ces éléments très radioactifs à longue durée de vie se transforment en éléments à durée de vie beaucoup plus courte (3 à 7 ans). Cette transformation va bouleverser complètement la donne en matière de stockage et de retraitement des déchets nucléaires car, non seulement elle permet de réduire considérablement la toxicité et la durée de vie des déchets hautement radioactifs, mais elle peut également être utilisée pour produire, à partir des déchets initialement dangereux, des substances très utiles, comme le Xénon, un gaz rare, du silicium dopé, indispensable à l'industrie électronique ou encore des radio-isotopes thérapeutiques pour traiter le cancer qui sont actuellement très difficiles à obtenir en quantité suffisante.

Parallèlement à ces progrès considérables dans la transmutation des déchets radioactifs, la communauté scientifique poursuit activement ses efforts pour parvenir à réaliser la séparation complète des actinides mineurs, composants majeurs des déchets radioactifs issus des centrales nucléaires. Un prototype de réacteur nucléaire à neutrons rapides au sodium, nommé « Astrid », devrait être opérationnel en 2020.

Ce réacteur de 4ème génération, à neutrons rapides au sodium, présente un véritable saut technologique, pourquoi ? Parce que cette nouvelle génération de réacteur sera capable de transformer la totalité de l’uranium 238 en plutonium 239, ce qui multipliera par 100 les ressources fissiles primaires mondiales.

Autre avantage, ces réacteurs pourront brûler les actinides mineurs qui constituent la majeure partie des éléments radioactifs à vie longue. A l'issue de ce retraitement, il ne restera donc que des produits de fission faiblement radioactifs pendant 300 ans et facilement stockables.

Enfin, une autre voie, encore plus radicale, est en cours d'expérimentation : la réinjection géothermique. Des chercheurs russes basés au Kamtchatka (Extrême-Orient russe) sont en effet parvenus à enfouir des déchets nucléaires à une température élevée (350°) dans des systèmes hydrothermaux. Ces expérimentations ont montré que l'enfouissement des déchets nucléaires, dans ces conditions particulières de pression, de température et de configuration géologiques, débouche sur la formation de combinaisons chimiques et géologiques stables et inoffensives.

La neutralisation des déchets par la voie géothermique pourrait donc offrir à terme une solution simple, peu coûteuse et parfaitement sûre à la question du retraitement et de la gestion des déchets nucléaires ultimes. Une telle injection de déchets nucléaires par voie géothermique n'aurait aucune conséquence pour l'environnement car la quantité de déchets injectés serait insignifiante par rapport aux volumes de ces flux. Cette voie technologique a d'ailleurs été validée par l'AIEA.

Ces progrès majeurs en cours dans le domaine de la séparation des actinides et de la transmutation ne pourront certes se substituer au stockage souterrain mais il vont permettre, d'une part, de réduire considérablement la quantité et la toxicité des déchets à entreposer et d'autre part, de produire à un niveau industriel de multiples matériaux et substances utiles à notre développement économique. Transformée par ces ruptures technologiques, l'énergie nucléaire va donc entrer dans une nouvelle ère et pourra, il faut l'espérer, être utilisée à une large échelle pour répondre à la soif d'énergie de la planète, sans contribuer à l'aggravation du réchauffement climatique et dans le cadre d'une utilisation durable et d'un niveau de risques acceptable par nos sociétés.

René TRÉGOUËT

Sénateur Honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

Pour la première fois en France, chaque citoyen majeur peut désormais être acteur de la recherche sur la grippe par l’intermédiaire du site www.grippenet.fr. Lancé à l’initiative de l’Inserm, l’université Pierre et Marie Curie et l’Institut de Veille Sanitaire (INVS), GrippeNet.fr s’inscrit dans le cadre d’un projet de surveillance et de modélisation des épidémies en Europe.

A ce jour, la surveillance de la grippe en France est réalisée à l’aide d’informations collectées par des médecins libéraux volontaires, faisant notamment partie du réseau Sentinelles de l’Inserm, et par un réseau de laboratoires et hôpitaux. Toute une partie de la population, qui présente un syndrome grippal mais qui ne consulte pas de médecin, échappe de fait à cette surveillance. Grâce au site www.grippenet.fr les chercheurs s’attendent donc à obtenir des informations complémentaires à celles obtenues par les systèmes de surveillance traditionnels.

Le site www.grippenet.fr est ouvert à toute personne majeure, malade ou non malade, et résidant en France métropolitaine. Après avoir rempli un questionnaire précisant son profil, le participant est invité chaque semaine à remplir un bref questionnaire récapitulant les symptômes qu’il a eus ou non depuis sa dernière connexion (fièvre, toux…). Ces données anonymes sont immédiatement analysées et contribuent en temps réel à la surveillance de la grippe en France. Les éléments recueillis sont également utilisés à des fins de recherche pour mieux comprendre la diffusion des épidémies de grippe, étudier les facteurs de risque ou encore connaître le comportement de la population vis-à-vis de la maladie.

- Etre acteur de la recherche et mieux informé sur la grippe

Pour les volontaires, la participation à ce programme ne se substitue évidemment pas à une visite chez son médecin généraliste ; toutefois les données recueillies via GrippeNet.fr leur permettront d’en apprendre davantage sur la grippe, tout au long de l’année, et d’être les premiers informés des résultats de l’étude. Ce système de surveillance de la grippe via Internet est cette année dans une phase de test. La participation du public sera déterminante : plus le nombre de participants sera élevé, plus les résultats de l’étude seront scientifiquement pertinents.

GrippeNet.fr s’inscrit dans le cadre du projet Epiwork financé par la Commission européenne, ayant pour objectif la mise en place d’infrastructures de surveillance et de modélisation des épidémies en Europe.

Inserm

|

|

|

|

|

|

|

|

|

Que diriez-vous d'être prévenu sur votre smartphone en cas de fuite d'eau à votre domicile et de pouvoir immédiatement couper l'alimentation générale ? Ou encore de savoir exactement quelles denrées manquent dans votre réfrigérateur ? Si de tels scenarii sont déjà devenus réalité avec certains acteurs de la domotique, ils risquent fort de se généraliser dans les prochaines années. En effet, Texas Instruments vient de lever le voile sur sa dernière puce Wi-Fi CC3000, censée — sur le papier tout du moins — révolutionner le secteur.

Ce module Wi-Fi à basse consommation et à faible coût peut en effet être intégré de manière très simple par les fabricants d'électroménager, les concepteurs d'appareils de domotique ou de sécurisation de domicile. Il ne mesure que 21 x 14 x 2,8 mm, peut fonctionner à des températures allant de –40°C à 85°C et ne nécessite que 6 Ko de mémoire flash et 3 Ko de mémoire vive !

Le tour de force de Texas Instruments est d'avoir intégré dans cette puce la couche TCP/IP, le logiciel de sécurité et son pilote Wi-Fi. Elle s'attribue donc elle-même sa propre adresse IP et ne nécessite pas d'interface utilisateur. Le pilotage de domicile du bout des doigts en passant par l'interface tactile de son smartphone va-t-il se démocratiser ? Réponse d'ici à quelques années.

01Net

|

|

|

|

|

|

|

|

|

On connaît le m-commerce, la m-banque, le m-marketing. Mais on ne pense peut-être pas souvent au m-learning. Apparemment, les universités et les écoles de commerce non plus. Selon un récent rapport de l'International University Consortium for Executive Education (Unicon), ces établissements devraient mieux exploiter les possibilités du "mobile learning" et prendre plus d'initiatives pour proposer aux étudiants des méthodes d'apprentissage plus individualisées, en se servant des différents terminaux mobiles qu'ils possèdent.

"Ces jeunes utilisateurs sont extrêmement connectés", explique Sébastien Brunet, responsable du Living Lab au Cned. "Pour continuer à les toucher, il faut réussir à faire le lien entre apprentissage formel au sein de la classe et informel (espace personnel, bibliothèque…) grâce aux smartphones ou aux tablettes."

Comment ? En envoyant par exemple résumés et comptes rendus au format textuel, sonore ou vidéo, que ce soit avant ou après les cours effectifs. Ou, dans une démarche plus structurée, en mettant en place des plates-formes collaboratives autour de forums et de groupes d'e-mailing, où étudiants et professeurs échangeraient des informations.

Ces méthodes ont également l'intérêt de faire profiter les étudiants de leurs différents temps morts dans la journée (comme les trajets dans les transports en commun) pour continuer à engranger du savoir. Mais utiliser de tels supports n'est pas sans contrainte. "Nous devons faire face à de vrais problèmes de standardisation technique, il est difficile de proposer des applications complexes, interactives et pertinentes quand les systèmes d’exploitation sont si variés."

Les structures éducatives se trouvent aussi confrontées à des problèmes récurrents de couverture réseau dans certaines zones du globe et au coût élevé des applications de qualité. Surtout, les réflexions autour du m-learning se focalisent trop souvent sur le support, pas assez sur les usages.

L'Atelier

|

|

|

|

|

|

|

|

|

Les bons vieux livres d'école finiront-ils sur l'iPad ? C'est le pari que fait Apple. Le groupe informatique a dévoilé récemment une nouvelle version de son service iBook, qui permet d'accéder à des manuels scolaires. Mais cette fois-ci, la marque à la pomme a signé des accords avec les grands noms de l'édition scolaire outre-Atlantique, Pearson, McGraw-Hill et Houghton Muffin Harcourt, qui revendiquent à eux trois 90 % du marché américain.

L'idée des dirigeants d'Apple est de développer l'offre numérique de manuels scolaires sur la tablette iPad. Selon Phil Schiller, vice-président d'Apple en charge du marketing au niveau mondial, 1,5 million d'iPad sont utilisés aujourd'hui dans l'éducation dans le monde. Les livres devraient être vendus en dessous de 14,99 dollars et seront disponibles sur iBook 2, une application gratuite que l'on pourra télécharger sur la tablette. Il sera possible d'annoter le livre sur iPad, de rechercher des mots dans le manuel ou encore de répondre aux questions et aux exercices. Il s'agit d'une idée qui tenait cher au coeur de Steve Jobs. Le fondateur d'Apple, décédé à l'automne dernier, estimait le marché de l'édition scolaire numérique à 8 milliards de dollars par an.

En attendant que ce marché décolle réellement, l'action Apple était au plus haut : la capitalisation boursière du groupe californien a même dépassé 400 milliards de dollars en cours de séance. En revanche, le titre Pearson a, lui, perdu 4 % à Londres, les investisseurs craignant que le rouleau compresseur Apple s'accapare ce nouveau marché au détriment des éditeurs.

Les Echos

|

|

| ^ Haut |

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

La technologie, brevetée par le groupe Sogetrel et Suez- Lyonnaise des eaux, permet un travail plus rapide et surtout évite de creuser des tranchées dans les chaussées de la commune.

La Ville de Morcenx, qui a décidé il y a déjà 10 ans de se doter d'un réseau fibre optique, poursuit ses chantiers. Tout récemment, le groupe Sogetrel était à pied d'oeuvre, rue de la Brune, pour équiper 400 mètres de réseau, à l'aide d'une technologie innovante et unique en France, appelée " Easy Fiber", brevetée par le groupe Sogetrel et Suez-Lyonnaise des eaux. Elle permet d'utiliser les réseaux déjà existants, comme les égoûts non visitables à Morcenx, pour effectuer le raccordement.

Concrètement, un robot équipé d'une caméra plonge dans les égouts. Il est suivi et télécommandé depuis un camion atelier aménagé d'équipements spécifiques. Le robot inspecte dans un premier temps les canalisations, puis oeuvre à la mise en place d'un fourreau à l'intérieur duquel sera installée la fibre optique. Selon le directeur régional adjoint du groupe Sogitrel, Lionel Carrère, le procédé a l'avantage de préserver la chaussée, de limiter les nuisances pour les riverains, de permettre une installation du réseau plus rapide, avec un coût de déploiement réduit de 30 %.

Sud-Ouest

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

L'effervescence autour de l'énergie éolienne donne des ailes au lidar. Cette technologie qui utilise le même principe que le radar, mais à partir d'un rayon lumineux, permet en effet la mesure très précise de la vitesse du vent. Une donnée précieuse qui sert déjà à évaluer la ressource d'un futur site éolien. « C'est fondamental, puisqu'un projet éolien est un projet financier. La précision de la mesure du vent conditionne la rentabilité et le montant de l'argent que l'on pourra emprunter », explique Alexandre Sauvage, fondateur de Leosphere, une jeune entreprise française spécialiste du secteur, dont la filiale Avent Lidar Technology est en concurrence avec d'autres spécialistes comme le britannique Natural Power ou le canadien Catch the Wind.

Traditionnellement, ces mesures sont effectuées grâce à un mât d'une centaine de mètres au grand maximum en haut duquel est perché un anémomètre. Le lidar est lui placé au sol. Le rayon orienté à la verticale permet de mesurer la vitesse du vent de façon continue et jusqu'à environ 200 mètres. De la taille d'un petit réfrigérateur, il est en outre déplaçable. « Une innovation de rupture qui permet une évaluation plus souple et plus complète », résume Werner Coppye, directeur technique de la société d'analyse 3E.

Pour l'éolien offshore, les lidars seront probablement encore plus utiles car les projets se chiffrent en milliards d'euros, avec des éoliennes de plus en plus grandes. La société bretonne Nass & Wind, qui vient de répondre à l'appel d'offres gouvernemental sur l'éolien marin, a ainsi utilisé deux lidars afin d'étudier les gisements de vent à proximité du banc de Guérande et au large de Saint-Brieuc grâce à la présence d'un îlet et d'un phare.

Pour pallier l'absence de point fixe, l'exploitant La Compagnie du Vent pilote un projet de recherche visant à développer un système de lidar installé sur une bouée. Labellisé par le Pôle Mer Bretagne, le projet Blidar pose deux défis, explique Philippe Alexandre, directeur technique de La Compagnie du Vent : « D'abord, celui de la stabilité qui va varier selon l'état de la mer et du type de bouée, ensuite celui du filtrage des données brutes qu'il faudra savoir traiter et corriger. »

Le lidar a d'autres promesses. Ainsi un seul appareil plus puissant, balayant l'espace à la fois horizontalement puis verticalement, pourrait donner une image globale et en 3D des flux de vents disponibles. « Cela ne donnerait toutefois que des données moyennes. Afin de mesurer instantanément le vent en 3 dimensions, il faudrait parvenir à combiner l'action de trois lidars. C'est ce sur quoi nous travaillons dans mon laboratoire », explique Rozenn Wagner, chercheur au DTU Wind Energy (ex-Riso) au Danemark.

Enfin, les lidars vont aussi monter à bord des éoliennes. D'abord pour évaluer leur performance réelle et vérifier que l'électricité produite correspond bien à ce qu'a promis le fabricant. A plus long terme pour aider à piloter les éoliennes et améliorer leur productivité. Placé au niveau de la nacelle et dirigeant son faisceau dans la direction du vent, le lidar offrirait ainsi à l'éolienne quelques secondes pour anticiper la puissance du vent et orienter ses pales de façon optimale. Voire les stopper complètement en cas de rafale.

Les Echos

|

|

| ^ Haut |

|

|

|

|

|

|

|

Espace |

|

|

Espace et Cosmologie

|

|

|

|

|

|

|

|

|

|

La NASA a annoncé que le télescope spatial américain Kepler venait de découvrir 11 nouveaux systèmes planétaires regroupant 26 planètes au total. Ces découvertes portent à 60 le nombre d'exoplanètes rencontrées et confirmées à ce jour par Kepler, et à plus de 2.300 le total de ces planètes "potentielles" se trouvant hors de notre système solaire, précise l'agence spatiale américaine dans un communiqué. Kepler a également triplé le nombre de systèmes planétaires connus comptant plus d'une exoplanète. Aucun de ces onze systèmes planétaires ne ressemble à notre système solaire, à l'exception d'un, baptisé Kepler-33, qui reste toutefois plus ancien et plus grand et compte cinq planètes contre huit pour le système solaire.

Ces 26 nouvelles exoplanètes varient en taille, allant de 1,5 fois le rayon de la Terre à une dimension surpassant Jupiter, la plus grosse planète de notre système solaire, formée de gaz. Quinze de ces exoplanètes se situent, en terme de taille, entre la Terre et Neptune. Davantage d'analyses et observations sont nécessaires pour déterminer celles qui sont rocheuses comme la Terre et celles qui ont une atmosphère gazeuse épaisse comme Neptune.

Ces exoplanètes orbitent autour de leur étoile dans des périodes allant d'une fois tous les six jours à une fois tous les 143 jours. "Avant le déploiement de Kepler --lancé en mars 2009-- nous connaissions l'existence de peut-être 500 exoplanètes dans l'ensemble de la Voûte étoilée", relève Dough Hudgins, le responsable scientifique de Kepler à la Nasa. Désormais, on en compte 729 au total, confirmées à ce jour, dont 60 ont été débusquées par Kepler, ajoute-t-il.

La Nasa estime qu'il s'agit d'une exoplanète lorsque les astronomes de l'agence la voient passer à trois reprises au moins devant son étoile, entraînant une baisse de luminosité à l'endroit où transite la planète. Ces nombres "nous indiquent que notre galaxie (la Voie lactée) est remplie de planètes de toute taille et (de tout type) d'orbites", souligne Dough Hudgins. Kepler identifie les exoplanètes potentielles en observant en permanence les changements de luminosité de plus de 150.000 étoiles situées dans les constellations du Cygne et de la Lyre. Sa mission est de rechercher des planètes soeurs de la Terre, susceptibles d'abriter la vie. Début décembre 2011, Kepler avait confirmé l'existence d'une exoplanète ressemblant à la Terre, portant à trois le nombre de ces planètes pouvant potentiellement permettre l'existence de la vie. Les découvertes annoncées par la Nasa sont publiées dans quatre revues scientifiques dont l'Astrophysical Journal et les Cahiers mensuels de la Royal Astronomical Society.

RTL

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Une équipe de chercheurs britannique et français financée par l'UE a identifié le «gène nourrisseur» responsable du transfert des nutriments provenant des plantes aux semences. Cette nouvelle découverte, présentée dans la revue Current Biology, pourrait aider à augmenter la production alimentaire mondiale mais a également des conséquences pour la sécurité alimentaire.

Pour la première fois, les chercheurs ont pu identifier le gène Meg1, qui régule la quantité optimale de nutriments s'écoulant des plantes de maïs mères aux plantes-filles.

L'étude a été partiellement financée par la Commission européenne dans le cadre de l'action «Harnessing plant reproduction for crop improvement» du domaine Alimentation et agriculture du cadre COST (Coopération européenne dans le domaine de la recherche scientifique et technique). COST coordonne différents programmes nationaux de recherche au niveau européen ; il est soutenu par la Direction générale de la recherche et de l'innovation. L'objectif principal est de réduire la fragmentation dans les investissements de recherche européenne et d'ouvrir l'Espace européen de la recherche (EER) à la coopération mondiale.

Meg1, contrairement à la majorité des gènes exprimés à partir des chromosomes maternels et paternels, est exprimé uniquement à partir des chromosomes maternels. Cette forme inhabituelle d'expression génétique uniparentale, appelée empreinte parentale, n'est pas limitée aux plantes ; elle se déclare également chez les gènes humains qui régularisent le développement du placenta pour contrôler l'approvisionnement en nutriments maternels au cours de la croissance foetale.

Les scientifiques connaissent depuis longtemps l'existence de gènes empreints chez l'homme et autres mammifères, mais il s'agit là du premier gène parallèle à régulariser l'approvisionnement en nutriments au cours du développement des semences à être identifié dans le monde végétal.

Les résultats de cette nouvelle étude impliquent que les scientifiques peuvent se concentrer sur l'utilisation de ce gène et comprendre le mécanisme dans lequel il s'exprime pour augmenter la taille des graines et la productivité dans la majorité des plantes à culture.

L'un des auteurs de l'étude, le Docteur Jose Gutierrez-Marcos de l'université de Warwick, commente : «Ces résultats ont d'importantes implications sur l'agriculture et la sécurité alimentaire, étant donné que les scientifiques possèdent désormais le savoir-faire moléculaire pour manipuler ce gène par la sélection végétale traditionnelle ou par d'autres méthodes pour améliorer les caractéristiques des graines telles que le rendement de biomasse par graine. Cette compréhension du développement des graines de maïs et d'autres céréales, par exemple le riz et le blé, est essentielle à mesure que la population mondiale s'appuie sur des produits phares d'alimentation. Pour répondre aux demandes de la population mondiale en pleine croissance dans les années à venir, les scientifiques et reproducteurs doivent collaborer pour préserver et augmenter la production agricole».

Un autre auteur de l'étude, le professeur Hugh Dickinson, de l'université d'Oxford, explique : «L'identification de MEG1 est une découverte importante, et elle représente une véritable percée dans la compréhension de voies génétiques complexes qui régulent l'apport et le contenu nutritionnel des graines.»

Bien que la majorité des caractéristiques prisées soient polygéniques, il n'existe aucun outil de sélection génétique permettant la fixation efficace de caractéristiques multi-génétiques sur des générations successives. Parmi plusieurs stratégies reproductives pour la fixation de caractéristiques agronomiques désirées, l'un des meilleurs choix est la production de graines clonées. Cette technique permet la fixation instantanée du génome complet des meilleures plantes.

L'objectif général de COST est de permettre la synergie de l'expertise européenne et internationale pour mieux comprendre les mécanismes de reproduction végétale sexuelle/apomictique et de faciliter l'application de ses connaissances dans le développement de nouvelles approches pour l'agriculture et l'industrie alimentaire, afin de renforcer la productivité des récoltes.

Cordis

|

|

|

|

|

|

|

|

|

Après deux années de travaux en commun, l'entreprise RWE (l'un des quatre grands énergéticiens allemands) et l'entreprise de biotechnologies Brain AG viennent de franchir une nouvelle étape dans leur projet de recherche sur les microorganismes mangeurs de CO2 à Niederaussem (Rhénanie du Nord-Westphalie).

Parmi les quelque 3.000 microorganismes testés, 29 viennent d'être sélectionnés pour leurs caractéristiques génétiques leur permettant de croître avec du CO2 et de valoriser ce dernier. Ces microorganismes se nourrissent de CO2, issu notamment des fumées des centrales à charbon de RWE à Niederaussem, à une température de 60°C, facilement obtenue à proximité de ces centrales thermiques. Ces microorganismes sont ensuite capables de transformer le CO2 en biomasse. Une fois sèche, celle-ci peut servir comme matériau isolant dans le secteur du bâtiment. Une autre possibilité vise à transformer cette biomasse en biomatériaux, en produits chimiques intermédiaires ou raffinés ou encore en bioplastiques.

Le projet de recherche porte sur la culture de microorganismes, les procédés et moyens de synthèse de transformation du CO2. Deux millions d'euros ont déjà été investis dans ces projets et les résultats satisfaisants ont incité RWE et Brain à continuer les recherches. RWE souhaite également développer une "alliance pour l'innovation" avec 21 partenaires issus de petites et moyennes entreprises ainsi que des centres de recherches et des universités, afin d'élargir le projet à d'autres sources de CO2, comme les déchets, les eaux usées ou encore les raffineries.

Bulletins Electroniques

|

|

|

|

|

|

|

|

|

Boris Johnson, le maire de Londres, s'est lancé dans une série d'expérimentations pour le moins controversées afin de réduire la pollution dans les rues de sa ville.

Depuis quelques mois, des camions parcourent les zones les plus polluées en dispersant une solution adhésive à base de calcium afin de clouer au sol les fines particules émises par les voitures. Cette flotte de trois camions se déploie entre minuit et six heures du matin sur environ 30 km de rues, près de Victoria, Earls' Court ou encore Marylebone, et commence par nettoyer au jet d'eau la chaussée. Ensuite, des véhicules spécialement modifiés dispersent cette solution collante sous la forme d'un fin nuage de gouttelettes, un peu comme le font les dégivreurs dans les aéroports. Une fois lancé, ce nuage est à peine visible et les fines gouttes vont piéger les particules dites PM10 avant de les entraîner par gravité vers le sol. C'est une méthode très similaire à celle utilisée en cas d'accident nucléaire pour limiter la dispersion des poussières radioactives.

Ces fines particules, PM10, sont émises par les pots d'échappement, mais aussi par les pneus et par les disques de frein. Elles sont à l'origine de nombreux problèmes de santé comme l'asthme, les maladies cardio-vasculaires, des cancers des poumons, ainsi que de nombreux décès prématurés chez les personnes les plus fragiles.

C'est face à ce problème de santé public et à un record de pollution depuis 2003 atteint un peu plus tôt dans l'année, que Boris Johnson a décidé de passer aux grands moyens. En effet, la ville de Londres est en infraction avec les réglementations européennes et risque des amendes de 300 M euros. Ce qui pourrait arriver si le nombre de jours où la qualité de l'air, qualifiée de "mauvaise", dépasse 35 en 2012. Et puis, il s'agit aussi de ne pas ternir l'image des jeux olympiques qui sont annoncés comme les plus "verts" et "durables". Le maire de Londres et Transport for London (TfL, l'opérateur public en charge des transports dans la capitale : métro, bus, vélos, etc.) applaudissent les résultats déjà obtenus, avec une réduction observée du taux de particules de 14 % dans les rues traitées.

Pour le directeur des opérations de TfL, Garrett Emmerson, ce schéma s'inscrit dans toute une série de mesures de long terme, destinées à combattre ce problème de pollution : introduire de nouveaux véhicules à basse émission de particules, déployer des bus plus propres, retirer les taxis les plus sales de la circulation, ou encore durcir les standards de pollution en accord avec le ministère des transports. Londres investit également dans des infrastructures passives comme des murs le long des voies rapides qui fixent les polluants, ainsi qu'en plantant des arbres.

Bulletins Electroniques

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Le caractère d'un individu transparaît dans son activité cérébrale.

Un jour, il sera peut-être possible de connaître la personnalité d'un individu en regardant un cliché de son cerveau en activité. Alors, les recruteurs pourront décider si un CV, accompagné d'une photo du cerveau du candidat, convient pour le poste. Des internautes surfant sur des sites de rencontres pourront trouver l'âme sœur en évaluant la compatibilité de leurs caractères, d'après des clichés d'imagerie cérébrale.

À vrai dire, ce jour ne semble pas si éloigné. Du moins au Laboratoire de psychologie de l'Université de New York, où des volontaires ont accepté de remplir des questionnaires de personnalité avant de subir une IRM qui mesurait l'activité de repos de leur cerveau. Les neuroscientifiques ont vu apparaître différents types d'activité cérébrale spontanée chez ces personnes, une empreinte cérébrale du tempérament, ou neurotempérament.

Quel est donc ce code cérébral de la personnalité ? Il met en relation de grands profils d'activation du cerveau, et chacune des cinq grandes dimensions de la personnalité répertoriées : l'extraversion, le névrosisme ou instabilité émotionnelle, l'ouverture, l'agréabilité et le caractère consciencieux.

Les images cérébrales montrent que les extravertis ont une activité de repos naturellement élevée dans les aires dites paralimbiques et le gyrus fusiforme, des structures cérébrales impliquées dans la reconnaissance des visages et les différentes formes de plaisir. Cela explique pourquoi l'extraverti se met en avant en société, car il retrouve du plaisir à établir de nombreux contacts et se lasse facilement en l'absence de stimulations sociales.

Les névrotiques, ou instables émotionnels, ont une activité de repos élevée dans les zones préfrontales dorsomédianes, impliquées dans l'anxiété, l'auto-évaluation et la peur.

Les personnes ouvertes (à la nouveauté, au changement, aux idées différentes) se reconnaissent à l'activité de leur cortex préfrontal dorsolatéral, associé à la flexibilité mentale, à l'imagination, la curiosité intellectuelle.

Les personnes agréables se signalent par un cerveau très actif dans les aires dites extrastriées (voisines du cortex visuel) postéromédianes et sensorimotrices, dont l'action conjointe favorise les mécanismes d'empathie et d'attention sociale.

Quant aux individus consciencieux, ils présentent une activité supérieure dans une partie du lobe temporal médian classiquement dévolue à la planification, l'organisation et la discipline.

Finalement, à chacun son cerveau : selon son type de personnalité, on utiliserait préférentiellement certains modules cérébraux orientant le comportement et la pensée. Mais n'oublions pas qu'un tempérament est un mélange de ces cinq dimensions, dans des proportions variables d'un individu à l'autre. C'est justement le dosage de ces proportions qui fait l'unicité du caractère, le neurotempérament de chacun.

Pour La Science

|

|

|

|

|

|

|

|

|

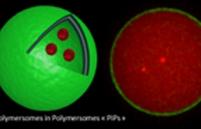

Les principaux nano-vecteurs de médicaments étudiés à ce jour sont des vésicules lipidiques ou « liposomes ». Leurs analogues à base de polymères ou « polymersomes » ont été découverts il y a une dizaine d'années. Ils présentent plusieurs avantages : plus stables et plus imperméables que les liposomes, ils s'avèrent plus facilement « fonctionnalisables et modulables » (il est possible par exemple de synthétiser un polymère thermosensible ou bien capable de reconnaître certaines cellules, notamment tumorales). L'équipe coordonnée par Sébastien Lecommandoux conçoit depuis 10 ans des polymersomes « intelligents » à base de polypeptides dont les propriétés et structures sont analogues à celles des virus.

Pour aller plus loin dans le mimétisme et l'inspiration biologique, une étape devait être franchie : encapsuler ces polymersomes les uns dans les autres. Ce cloisonnement permet de mimer la structure d'une cellule, elle-même constituée de compartiments (des petites organelles internes, sièges de milliers d'interactions et de réactions quotidiennes) et d'un cytoplasme viscoélastique, lui conférant entre autres une certaine stabilité mécanique. Mais, former de manière contrôlée des polymersomes emboités les uns dans les autres s'avère complexe.

Les chercheurs sont parvenus à cette prouesse en utilisant une méthode d'émulsion/centrifugation originale, simple d'utilisation, peu coûteuse en temps et en produits, et surtout très efficace. Par imagerie, ils ont ensuite mis en évidence, à l'aide de marqueurs fluorescents, la formation d'une structure « emboîtée » de polymersomes dans un autre. Maîtriser cette compartimentation permet désormais d'envisager l'encapsulation de multiples composés (dans les multiples polymersomes internes) au sein d'un même vecteur. C'est ce qu'ont démontré les chercheurs dans un second temps : ils ont encapsulé deux populations de polymersomes internes différents dans un polymersome unique plus grand. Au vu de leurs résultats, il est envisageable d'incorporer un nombre de vésicules distinctes beaucoup plus important. Cette capacité s'avère très intéressante pour la vectorisation combinatoire, en oncologie par exemple, où la faculté de pouvoir délivrer des composés actifs (parfois incompatibles) au sein d'un même vecteur est recherchée.

Ces structures originales pourraient par ailleurs être utilisées en tant que réacteurs compartimentés, en catalyse ou dans le domaine biomédical. Les chercheurs sont parvenus à encapsuler trois molécules fluorescentes différentes (utilisées comme « molécules modèles » de principes actifs) dans les trois compartiments différents que recèlent ces structures, à savoir la membrane du polymersome externe, la cavité aqueuse du polymersome externe et la membrane des polymersomes internes. On pourrait donc envisager d'encapsuler des réactifs différents dans différents compartiments des polymersomes ou bien de contrôler le déclenchement de réactions différentes, en cascade dans ces polymersomes.

Outre une meilleure protection des principes actifs encapsulés, l'autre intérêt de cette « mise en boite » réside dans un meilleur contrôle, une modulation plus fine des propriétés de perméabilité des vésicules. Les chercheurs ont modélisé cela via une expérience de libération in vitro d'un agent anticancéreux, la doxorubicine (DOX), incorporé dans les polymersomes internes. La DOX est effectivement libérée plus vite (environ deux fois) lorsqu'elle est intégrée dans des nanopolymersomes classiques, que lorsque ceux-ci sont eux-mêmes encapsulés dans des polymersomes externes.

A ce jour, les chercheurs sont les premiers à présenter ce type d'encapsulation multiple et contrôlée dans des vésicules compartimentées, en particulier polymères, contenant également un mime du cytosquelette : ainsi, la structure cellulaire complète est reproduite.

CNRS

|

|

|

|

|

|

|

|

|

Des scientifiques de l’Inserm viennent de mettre en évidence qu’un régime riche en graisse et en sucre empêche la destruction des neurones du système nerveux entérique chez la souris. En ralentissant le vieillissement naturel de ce second cerveau, ce régime particulier contribuerait au développement de l’obésité. C’est la conclusion surprenante d’un projet de recherche franco-allemand coordonné par Michel Neunlist, directeur de recherche à l’Inserm et Raphaël Moriez de l’Unité Inserm 913 "Neuropathies du système nerveux entérique et pathologies digestives : implication des cellules gliales entériques" à Nantes. Trop nombreux, ces neurones seraient alors trop efficaces et accélèreraient la vidange gastrique. Cet effet pourrait contribuer au développement de l’obésité en diminuant les signaux de satiété et en augmentant ainsi la prise alimentaire. Ces travaux sont publiés dans The Journal of Physiology.

En plus de notre cerveau qui contrôle l’ensemble des fonctions physiologiques, notre organisme dispose d’un second cerveau chargé de réguler les fonctions digestives. Cet autre cerveau, ou système nerveux entérique (SNE), est situé tout le long du tube digestif ; il est composé de plus de 100 millions de neurones faisant ainsi du tube digestif le second organe neurologique de notre corps. Le SNE joue un rôle central dans le contrôle de nombreuses fonctions allant de la régulation de la motricité digestive (vidange gastrique, transit colique), à l’absorption des nutriments en passant par le contrôle des fonctions de la barrière intestinale, barrière qui protège des agents pathogènes extérieurs.

Depuis quelques années les chercheurs découvrent le rôle clef du SNE, véritable acteur dans de nombreuses pathologies non seulement digestives (maladies fonctionnelles digestives, maladies inflammatoires chroniques intestinales) mais aussi extra-digestives (maladie de Parkinson). De manière surprenante, alors que l’obésité est une pathologie en très nette augmentation et représente un véritable défi en santé publique, très peu de données sur l’implication du rôle du SNE dans cette pathologie existent. Ceci est d’autant plus surprenant que le SNE joue aussi un rôle central dans le contrôle des fonctions clés nécessaires à l‘absorption des aliments et aussi à la régulation de la prise alimentaire.

Afin de disposer d’éléments plus précis sur le sujet, les chercheurs ont étudié l’impact d’un régime riche en sucre et graisse sur le SNE et ses répercussions sur la vidange gastrique et le transit intestinal. En empêchant la maturation du second cerveau, un régime riche en graisse et en sucre contribuerait au développement de l’obésité.

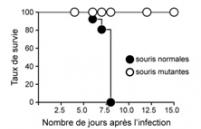

Ces travaux ont mis en évidence, de manière inattendue, que ce régime administré à des souris jeunes, prévenait la perte de neurones observée normalement chez les animaux contrôles au cours du temps. "Nous pensons qu’en empêchant l’évolution naturelle du système nerveux entérique au cours du temps, le régime riche en graisse et sucre empêcherait le tube digestif de s’adapter à un régime correspondant à l’âge adulte et maintiendrait son phénotype jeune correspondant à une période de la vie où la prise alimentaire est maximale" déclare Raphaël Moriez.

D’un point de vue fonctionnel, cette neuroprotection induite par le régime hypercalorique conduit à une modification des fonctions gastriques. Ainsi, chez les animaux recevant le régime riche en graisse et sucre, la vidange gastrique est trop rapide par rapport aux animaux contrôles et pourrait directement contribuer au développement de l’obésité en diminuant les signaux de satiété et en augmentant ainsi la prise alimentaire. Ce même phénomène d’accélération de la vidange gastrique est observé chez les patients obèses. D’un point de vue physiologique, cet effet ‘neuroprotecteur’ du régime hypercalorique est associé à une augmentation de la production gastrique d’un facteur neuroprotecteur, le GDNF, lui-même induit par la leptine, une hormone désormais bien connue pour réguler la satiété chez l’homme.

Ces travaux mettent en exergue la capacité des nutriments à moduler le fonctionnement du second cerveau et le rôle de ce cerveau dans le développement de l’obésité, en particulier juvénile. A terme, la prévention de pathologies neurodégénératives digestives voire du système nerveux central pourrait être modifiée par des approches nutritionnelles.

Inserm

|

|

|

|

|

|

|

|

|

Une étude de l'Université Illinois, publiée dans la revue Molecular Nutrition & Food Research vient de montrer que le maté ou thé mexicain pourrait prévenir le cancer du côlon. Cette étude montre que les cellules humaines de cancer du côlon meurent une fois exposées aux composés bioactifs présents dans une tasse de ce « thé », depuis longtemps consommé en Amérique du Sud pour ses propriétés médicinales.

C’est une espèce végétale sud-américaine (Ilex paraguariensis) de la même famille que le houx, celle des Aquifoliaceae. Ses feuilles, torréfiées et infusées dans l'eau chaude, fournissent une boisson stimulante, le maté. Les dérivés de caféine présents dans le maté ont non seulement induit la mort des cellules cancéreuses mais également réduit les marqueurs de l'inflammation", explique Elvira de Mejia, professeur agrégé de chimie alimentaire et toxicologie alimentaire à l’Université de l’Illinois. Un résultat important, alors que l'inflammation est l’un des facteurs déclenchants de la progression du cancer. Dans cette étude in vitro, les chercheurs ont isolé, purifié, puis traité des cellules humaines de cancer du côlon avec de l’acide caféoylquinique, un polyphénol dérivé du maté, présent également dans la pulpe de café. Lorsque les scientifiques augmentent la concentration d’acide caféoylquinique, ils constatent l'apoptose (la mort) des cellules cancéreuses.

«En fait, la cellule cancéreuse s'autodétruit parce que son ADN a été endommagé», explique l’auteur. Cette capacité du composé à induire l'apoptose est une stratégie thérapeutique prometteuse pour tous les types de cancer, ajoute-t-elle. Les chercheurs se déclarent capables d'identifier le mécanisme qui conduit à la mort cellulaire. L’acide caféoylquinique entraine une diminution considérable de plusieurs marqueurs de l'inflammation, notamment le marqueur nommé NF-kappa-B, qui régule de nombreux gènes producteurs d'enzymes importantes : Les cellules cancéreuses meurent avec l'induction de deux enzymes spécifiques, la caspase-3 et la caspase-8.

En réduisant l'activité de NF-kappa-B, un marqueur important de l'inflammation dans le cancer, les chercheurs pourront contrôler la transformation de cellules normales en cellules cancéreuses. Les résultats de l'étude suggèrent donc que ce dérivé de caféine dans le maté présente un vrai potentiel anti-cancéreux et, au-delà, pourra trouver un usage thérapeutique dans d'autres maladies associées à l'inflammation. Le colon et sa microflore jouant un rôle majeur dans l'absorption et le métabolisme de la caféine et de ses composés apparentés, les effets anti-inflammatoires et anti-cancer du maté pourraient se révéler plus efficaces dans le côlon. Selon les chercheurs, les preuves des bénéfices bioactifs du maté sont démontrés et en consommer ne peut qu’être bénéfique pour prévenir le cancer du côlon. Des sachets de maté sont disponibles dans tous les magasins d’aliments « de santé » et dans les supermarchés, précisent même les auteurs !

Molecular Nutrition & Food Research

|

|

|

|

|

|

|

|

|

Les derniers résultats de recherche sur la démence, présentés à l'Académie des sciences par l'Institut Baulieu, ont une nouvelle fois surpris les neurologues. Il y a deux ans, pratiquement jour pour jour, le Professeur Étienne-Émile Baulieu et son équipe Inserm suscitaient l'incrédulité des spécialistes de la maladie d'Alzheimer en annonçant avoir identifié une protéine (FKBP52) impliquée dans les démences séniles. À l'époque, la plupart des chercheurs étaient encore focalisés sur les dépôts de plaques amyloïdes dans le cerveau, une lésion que l'on observe assez tôt dans l'évolution de la maladie d'Alzheimer.

Mais la piste ouverte par le Professeur Baulieu vise un autre mécanisme qui est au cœur de la maladie. «C'est une approche originale, commente le Professeur Françoise Forette, directrice de la Fondation nationale de gérontologie, car si la recherche sur les dépôts amyloïdes reste importante, il est possible que dans la maladie d'Alzheimer, il faille associer les thérapeutiques». Raison de plus pour multiplier les pistes de recherche. La publication prochaine dans le Journal of Alzheimer's Disease des résultats obtenus par l'équipe de Baulieu, à partir de coupes de cerveaux de patients décédés avec une démence, sont éloquents. Ils confirment bien la diminution considérable de la fameuse protéine FKBP52 dans les cerveaux déments. Or, cette substance est censée jouer un rôle protecteur lorsqu'elle est présente dans le cerveau en empêchant notamment l'altération d'une autre protéine, centrale dans la pathologie des démences, la protéine tau.

D'ailleurs, on ne trouve pas de protéine tau anormale dans les zones du cerveau où le taux de FKBP52 est élevé. La protection semble donc bien, anatomiquement et quantitativement, efficace : une notion essentielle qui pourrait a contrario expliquer le peu de résultats obtenus à ce jour par les chercheurs qui ciblaient la seule protéine tau. Les nouveaux travaux réalisés grâce à la banque de cerveaux de la Pitié-Salpêtrière, à Paris, confirment in fine l'hypothèse émise il y a deux ans et ouvrent la porte à un diagnostic précoce de la maladie et à un traitement : «L'idée est maintenant de mesurer le taux de cette protéine par une ponction lombaire pour détecter les personnes à risque et pouvoir stimuler cette protéine dès que l'on aura trouvé une molécule à la fois active et bien tolérée. Ça peut aller très vite», résume le Professeur Baulieu. D'ores et déjà, le liquide céphalo-rachidien d'une cinquantaine de malades est décortiqué par l'équipe de l'Institut Baulieu et des dizaines de molécules sont en cours d'évaluation.

Le Figaro

|

|

|

|

|

|

|

|

|

C’est la seconde étude à suggérer qu’une dose quotidienne de statines, une classe de médicaments pour abaisser le cholestérol, pourrait contribuer à bloquer la croissance et la propagation des tumeurs. Cette recherche de laboratoire, co-financée par les NIH et la Breast Cancer Research Foundation, publiée dans l’édition du 20 janvier de la revue Cell, confirme non seulement le rôle clé d'une mutation génétique sur le gène P53 dans le développement du cancer du sein mais suggère l’efficacité des statines pour stopper la progression et la diffusion des tumeurs.

La recherche a été effectuée sur des cultures cellulaires de tumeurs du cancer du sein contenant une mutation du gène P53, par des chercheurs de l'Université de Columbia et d'autres instituts américains, du Japon et de Norvège. Ces chercheurs ont identifié la séquence biochimique spécifique ou «voie» via laquelle la mutation génétique induit les cellules à devenir cancéreuses. Cette voie est également impliquée dans la production de cholestérol et pourrait donc, peut-être être bloquée par les statines ? Les scientifiques ont néanmoins d’abord tenté de modifier les effets de cette mutation génétique et la moitié des cellules tumorales ont repris alors une structure normale. Et lorsqu’ils introduisent une version mutée du gène P53 dans les cellules mammaires non cancéreuses, ces cellules évoluent bien vers des cellules cancéreuses.

L’efficacité de la simvastatine : Les scientifiques ont ensuite regardé comment certains médicaments, dont plusieurs statines, pourraient interférer avec les effets de ce gène muté. Ils confirment qu’une statine, la simvastatine, permet de réduire la croissance des cellules cancéreuses et accroître l’apoptose (la mort) des cellules cancéreuses, avec un impact plus important qu’en intervenant sur la seule mutation du gène. Cette constatation est vérifiée à la fois sur des cellules tumorales porteuses de la mutation P53 ou sur la croissance de cellules cancéreuses implantées sur des souris.Cette recherche était donc à nouveau centrée sur ce fameux gène P53 qui code pour la production d'une protéine du même nom, connue pour contrôler la vie ou la mort des cellules, et l’un des acteurs clés de la recherche contre le cancer, depuis de longues années. Son inactivation est constatée chez 50 % des personnes atteintes de cancers. Nous avons couvert récemment une étude de l’Inserm, publiée dans la revue Cancer Cell, qui décrypte son mécanisme en chaine avec 2 autres protéines.

Les chercheurs confirment, avec cette recherche, que la mutation du gène P53 est nécessaire et suffisante pour générer la croissance de cellules cancéreuses (en laboratoire) et suggèrent que les statines sont efficaces pour interférer avec le développement de ces tumeurs avec un triple effet, sur la croissance cellulaire, sur la mort cellulaire et la propagation. Une étude de novembre dernier publiée dans le Journal of the National Cancer Institute avait déjà suggéré qu’une dose quotidienne de statines lipophiles comme la simvastatine, pouvait réduire considérablement le risque de récidive de cancer du sein.

Santé Log

|

|

|

|

|

|

|

|

|

Les gènes déterminent en partie notre longévité... Et qu'en est-il pour notre intelligence? La génétique aurait aussi sa part de responsabilité.

«Le temps ne fait rien à l’affaire», chantait George Brassens, s’adressant aux «petits cons de la dernière averse» et «aux vieux cons des neiges d'antan»… Les gènes seraient en partie responsables de cette situation, d’après une estimation réalisée par des chercheurs britanniques. L’équipe coordonnée par Ian Deary (Université d’Edimbourg) a voulu mesurer l’influence de la génétique sur l’évolution des capacités intellectuelles au cours de la vie. Ils estiment au final que nos gènes seraient responsables d’environ 25 % des hauts et des bas de notre intelligence au cours de notre existence.

Ces résultats suggèrent que les mêmes facteurs génétiques qui influencent l’intelligence (telle qu’elle est mesurée par des tests) chez les enfants déterminent l’intelligence des personnes âgées. La part prise par la génétique, autour de 25 %, laisse par ailleurs la plus grosse responsabilité aux facteurs environnementaux.

Cette étude s’appuie sur une cohorte de 2.000 personnes, qui ont fait partie d’une expérience assez unique menée en Ecosse : en juin 1932 et en juin 1947, des chercheurs ont fait passer des tests d’intelligence (Moray House Test) à presque tous les enfants nés en 1921 et 1936 (les enfants ont été testés à l’âge de 11 ans). Deary et ses collègues ont retrouvé 1.940 personnes qui avaient ainsi été testées enfant et ont de nouveau mesuré leurs capacités cognitives à un âge avancé. Les chercheurs ont aussi réalisé des prélèvements ADN et comparé 500.000 marqueurs génétiques (SNP, variation d’un seul nucléotide dans l’écriture des gènes).

Cette étude, publiée dans la revue Nature (19 janvier 2012) ne permet pas de déterminer précisément quels sont les gènes en cause mais de cerner leur part. Située autour de 25 %, elle signifie que leur étude plus approfondie est valable pour mieux comprendre les facteurs influençant l’évolution des fonctions cognitives. Evolution très variable d’un individu à un autre. Toute la difficulté pour les scientifiques est d’y voir clair dans les interactions entre la génétique et l’environnement, avec pour but d’améliorer le vieillissement de nos capacités intellectuelles !

Sciences et Avenir

|

|

|

|

|

|

|

|

|

Les patients atteints d'un cancer du rein métastatique en rémission complète sous inhibiteurs de tyrosine kinase pourraient interrompre leur traitement, estiment des spécialistes français du cancer du rein dans une étude publiée en ligne sur le site de la revue Journal of Clinical Oncology.

L'avènement des thérapies ciblées a révolutionné le traitement des cancers du rein métastatiques qui ne bénéficiaient d'aucune chimiothérapie efficace. Ceci est particulièrement vrai avec les inhibiteurs de tyrosine kinase, comme le sunitinib (Sutent ®) ou sorafenib (Nexavar ®), qui ont porté à plus de 2 ans la survie globale de la moitié des patients. Plusieurs cas de rémissions complètes ont même été observés, amenant les cancérologues à se poser la question de l'arrêt du traitement.

Pour approfondir cette question, les Drs Laurence Albiges et Bernard Escudier, cancérologues et spécialistes du cancer du rein et de l'immunothérapie à l'Institut de cancérologie Gustave Roussy (IGR), ont mené une étude rétrospective auprès de 64 patients en rémission complète avec des inhibiteurs de tyrosine kinase, seuls ou en complément d'une thérapie locale (chirurgie, radiothérapie ou radiologie interventionnelle).

Parmi ces patients, 36 étaient en rémission complète sous l'un des deux inhibiteurs de tyrosine kinase pré-cités, tandis que les 28 autres cas l'étaient avec un traitement local en plus :

- Sur les 28 patients uniquement sous inhibiteur de tyrosine kinase qui ont stoppé leur traitement, 17 (soir 61 %) étaient en rémission complète 255 jours après.

- Sur les 25 patients qui ont interrompu leur traitement associant un inhibiteur de tyrosine kinase et un traitement local, 12 (soit 48 %) étaient en rémission complète 322 jours après. Pour les auteurs, ces résultats montrent que "l'arrêt du traitement après rémission complète sous inhibiteurs de tyrosine kinase est une option acceptable".

Doctissimo

|

|

|

|

|

|

|

|

|

La plasticité des systèmes biologiques permet à des organismes de modifier dynamiquement leur physiologie de façon à s'adapter aux conditions environnementales existantes. Si au niveau cellulaire, ce processus est associé habituellement au système immunitaire, au niveau tissulaire, il a été caractérisé il y a plusieurs années dans le cerveau et est au coeur d'une intense recherche en neurobiologie.

Mais en dehors de ces deux systèmes qui permettent de garder en mémoire des informations à long terme, rien n'indiquait jusqu'à présent que d'autres cellules pouvaient fonctionner de façon similaire. Or une équipe de chercheurs de l'Inserm et du CNRS, dirigée par Patrice Mollard au sein de l'Institut de Génomique Fonctionnelle de Montpellier, vient de montrer chez la souris que les cellules endocrines hypophysaires qui régulent la lactation s'organisent en réseau lors d'un premier allaitement, réseau qui est alors "mémorisé" afin d'être encore plus opérationnel lors de l'allaitement d'une seconde portée.

L'originalité de cette découverte, dont les résultats ont été publiés dans la revue Nature communications datée du 3 janvier dernier, réside dans le fait que 3 mois après le sevrage, le réseau reste en place, un peu comme s'il avait été "mis en mémoire". Or Patrice Mollard précise qu'un même stimulus (tétée) effectué par la suite entraînera une réponse plus coordonnée et plus efficace. Ainsi le réseau sécrétera plus de prolactine et provoquera à nouveau un accroissement de la production tissulaire. Néanmoins, si la puissance du stimulus de tétée est réduite, la mise en réseau ne se produit pas.

Or chez les souris dont les portées sont souvent importantes, avec en moyenne 8 petits par portée, si seuls 3 de ces petits sont à la tétée, le stimulus reste trop faible pour déclencher cette mise en réseau. Cette découverte d'une forme de mémoire dans un tel système ouvre évidemment d'immenses perspectives. "Nous pensons que cette découverte pourrait notamment s'appliquer à d'autres systèmes endocriniens tels que celui des cellules bêta pancréatiques et des cellules endocrines du tractus gastro-intestinal", estiment les auteurs de l'article.

Bulletins Electroniques

|

|

|

|

|

|

|

|

|

Le groupe de recherche Advanced Scientific Research Leaders Development Unit mené par le professeur Takao IWAKI de l'Université de Gunma, a récemment développé un protocole opératoire permettant d'observer in vivo le stress oxydatif et son évolution dans les cellules de souris.

Le stress oxydatif (ou oxydant) est une agression des constituants cellulaires par une réaction d'oxydation. Elle est entraînée par l'action d'espèces réactives oxygénées (ROS) et des espèces réactives oxygénées et azotées (RONS) produites naturellement dans l'organisme. En raison de leur grande réactivité et des effets nocifs qu'elles exercent, des systèmes de défense enzymatiques ou biochimiques les éliminent ou les modifient. Cependant, ces défenses peuvent perdre de leur efficacité et devenir peu à peu submergées par les ROS et RONS. Malgré les nombreuses études réalisées sur le stress oxydatif, aucune méthode ne permettait jusqu'à maintenant de l'observer in vivo.

La stratégie développée par les scientifiques de l'Université de Gunma a été de créer des souris transgéniques nommées OKD 48 dont les cellules deviennent fluorescentes sous l'effet du stress oxydatif. L'ADN modifié de ces souris s'est vu insérer le gène de la luciférase, transcrit en conditions oxydantes par le facteur Nrf2. Après transcription et stabilisation protéique de la luciférase, une émission de lumière fluorescente se produit, témoignant de l'activation de la voie Keap1-Nrf2. La voie Keap1-Nrf2 constitue un système de défense biochimique et un mécanisme de détection du stress oxydatif. Sa défaillance est également mise en cause dans certaines maladies neurodégénératives telles que la maladie d'Alzheimer, de Parkinson, d'Huntington ou bien encore de la sclérose latérale amyotrophique. L'activation de cette voie et l'observation des cellules grâce à la luciférase apportent ainsi des informations précieuses sur le déclenchement des défenses de l'organisme et sur l'intensité du stress oxydatif proportionnel à l'intensité lumineuse.

Ces travaux publiés dans la revue Scientific Reports datée du 19 janvier 2012, pourraient aider les chercheurs à développer de nouveaux traitements permettant le renforcement des défenses cellulaires dans les conditions de stress oxydatif.

Bulletins Electroniques

|

|

|

|

|

|

|

|

|

La monnaie est une invention récente, à l'échelle de l'évolution des espèces. Alors que notre cerveau a eu le temps de s'adapter à certains dangers ou prédateurs qui le côtoient depuis des millions d'années (araignées ou serpents), on considère qu'il n'a pas eu le temps de se doter de structures innées spécifiques à la reconnaissance de l'argent.

Et pourtant, Catherine Tallon-Baudry, de l'Institut du cerveau et de la moelle, et ses collègues ont montré que le cerveau présente une activité bien particulière quand on lui présente une pièce de monnaie, et ce indépendamment du fait que cette pièce ait été ou non vue ou utilisée préalablement. Comme si le concept d'argent avait trouvé un ancrage dans certains circuits neuronaux, que l'on nomme la voie visuelle ventrale.

Dans leurs expériences, C. Tallon-Baudry et ses collègues ont présenté à des volontaires des pièces de monnaie connues, ayant ou non une valeur aujourd'hui (euros et francs), et également des pièces inconnues ayant ou non une valeur (dollars canadiens et marks finlandais). Ils ont constaté que le fait de représenter une valeur monétaire, indépendamment de la familiarité de la monnaie, active la voie visuelle ventrale. C'est le cas de l'euro et du dollar canadien. En revanche, une pièce sans valeur actuelle, qu'elle soit familière ou non, ne l'active pas : c'est le cas du franc ou du mark finlandais.

Ces expériences montrent que le cerveau s'est adapté à une donnée culturelle (économique et sociale), la monnaie, en établissant un moyen de catégorisation régulière et identique d'une personne à l'autre de cette donnée culturelle. C'est aussi ce qui s'est passé lors de l'invention de l'écriture : avant l'apparition des premiers symboles écrits, aucune zone du cerveau n'avait évolué en fonction d'une quelconque contrainte de sélection intégrant les symboles écrits. Malgré tout, le cerveau a mobilisé des zones bien précises pour traiter l'écrit, et ces aires cérébrales sont aujourd'hui bien identifiées.

D'autres symboles culturels, représentant un concept nouveau et distinct comme ce fut jadis le cas de la monnaie ou de l'écriture, pourraient à l'avenir « recruter » des zones cérébrales qui n'avaient certainement pas été « conçues » à cette fin. Cela pourrait être le cas de l'arobase qui revêt une valeur particulière dans le monde d'Internet, ou du « hashtag », symbole « dièse » sur un clavier d'ordinateur, de plus en plus utilisé sur les pages Twitter pour attribuer une fonction générique à un mot-clé lors d'une recherche. L'effet du hashtag est de transformer un mot en « mot-clic » qui entraîne l'affichage de toutes ses occurrences sur d'autres pages Twitter ou Internet. La valeur conceptuelle d'un mot-clic étant très différente d'un mot simple, il est probable que chez les internautes en faisant un usage régulier, une zone du cerveau prenne en charge ce nouveau concept. Mais il faudrait d'autres expériences pour s'en assurer.

Pour La Science

|

|

|

|

|

|

|

|

|

Dans le but de remédier au dysfonctionnement de certaines zones cérébrales affectées par une maladie, les scientifiques ont mis au point des puces électroniques qui devraient être implantées dans le cerveau et reliées au système neurologique. Une nouvelle avancée technologique qui n’a pas encore été testée sur l’homme, les essais ayant été réalisés sur des rats de laboratoire.

Des nano-électrodes sont placées dans la boite crânienne des rats et permettent une connexion entre la puce électronique et le cerveau du rongeur. Lorsque le tronc cérébral envoie un signal interne, il est réceptionné par la puce qui diffuse ensuite une information aux centres moteurs du cerveau, chargés de coordonner les différents mouvements du corps ou encore la respiration par exemple. Un intermédiaire artificiel qui permet d’acheminer le message cérébral à bon port, en se substituant aux connexions naturelles déficientes.

Cette expérience se révèle probante scientifiquement ; les rats réagissent à certains stimuli. Ils ont notamment appris à avancer à chaque stimulation. Mais pour réaliser ces expériences, il fallait disposer de rats présentant de graves lésions cérébrales et ne possédant plus de capacités motrices.

Une expérience qui suscite la colère des associations de défense des animaux, car pour qu’un rat réponde à un stimulus, c’est la puce électronique qui prend le relais et met le rongeur en mouvement. Il s’agit bien ici de remplacer la partie abîmée du cerveau afin que la puce puisse imiter les fonctions qui font défaut. Ce qui transforme les rongeurs en véritables petits robots téléguidés. Des expérimentations inadmissibles pour les défenseurs des animaux.

Malgré ces protestations, les tests s’avèrent concluants : des rongeurs privés de motricité à cause d’un cerveau endommagé retrouvent l’usage de leurs pattes et recommencent à marcher grâce à cette technique.

RTL

|

|

|

|

|

|

|

|

|

Le curcuma est une épice alimentaire, considérée dans la médecine ayurvédique comme une plante médicinale. Extrait des rhizomes du curcuma, le curcumin a montré in vitro des activités anti-oxydantes, anti-cancéreuses, anti-inflammatoires, anti-diabétogènes, anti-parasitaires, mais aussi cicatrisantes et hypocholestérolémiantes.

Malgré ses nombreuses activités pharmacologiques, il est impossible d’utiliser le curcumin comme un médicament. En effet, ses caractéristiques physico-chimiques limitent son absorption au travers de la paroi intestinale et son entrée dans les cellules. De plus, il est rapidement métabolisé en une forme inactive. Sa biodisponibilité est donc faible et incompatible avec un usage thérapeutique. Pour contourner ce problème, le curcumin peut être lié chimiquement à des molécules ligands, qui augmentent sa biodisponibilité dans l’organisme.

Une équipe de chercheurs indiens a synthétisé deux nouveaux bioconjugués de curcumin, l’un est un curcumin estérifié par l’acide nicotinique (vitamine B3) et l’autre par l’isomère de l’acide nicotinique, l’acide picolinique. Les deux bioconjugués obtenus contiennent un noyau hétérocyclique, structure souvent retrouvée dans les molécules antibiotiques.

L’activité antibactérienne de ces bioconjugués a été étudiée sur 4 agents pathogènes importants en médecine humaine : Enterococcus faecium, Klebsiella pneumoniae, Escherichia coli et Pseudomonas aeruginosa. Ont été déterminées notamment les concentrations minimales inhibitrices et les concentrations minimales bactéricides des bioconjugués pour chaque bactérie. L’activité antibactérienne des deux bioconjugués s’est révélée supérieure à celle du curcumin dans le cas de Klebsiella pneumoniae et E. coli. En revanche, leur activité antibactérienne est plus faible que celle du curcumin dans le cas de Enterococcus faecium et Pseudomonas aeruginosa. Le mécanisme responsable de cette différence est actuellement en cours d’étude.

Les deux bioconjugués sont des complexes vitaminiques, qui peuvent ainsi être facilement administrés par voie orale. Ils pourraient permettre de mettre à profit en thérapeutique les propriétés pharmacologiques du curcumin. Des essais cliniques restent à réaliser pour évaluer l’intérêt et la place de ces bioconjugués dans l’arsenal actuel des antibiotiques.

JIM

|

|

|

|

|

|

|

|

|

Les chercheurs s'en doutaient depuis quelques années déjà : un individu est plus que la somme de ses gènes ; l'architecture de ses chromosomes serait aussi un facteur clé pour le bon fonctionnement de ses cellules. Mais jusqu'ici, une réelle compréhension des principes qui organisent le repliement du génome dans le noyau échappait aux analyses. Et depuis 4 ans, une vingtaine d'équipes dans le monde tentaient de mettre au point une technique d'analyse pour étudier ce repliement.

La méthode de l'équipe CNRS dérive d'une autre développée par une équipe américaine en 2009. Une technique baptisée « capteur de la conformation des chromosomes» (Hi-C), qui permet de décrire les contacts que chaque région du génome établit avec les autres. Comme la version américaine, la méthode montpelliéraine consiste en trois grands étapes : figer les contacts dans ou entre les chromosomes avec le composé formaldéhyde ; lier les bouts des deux gènes en contact avec la molécule ADN ligase, d'origine bactérienne ; et déterminer la séquence de ces deux gènes. Mais Giacomo Cavalli et ses collègues y ont apporté d'importantes améliorations rendant possible l'étude de fragments d'ADN beaucoup plus petits (de quelques centaines de paires de bases, contre des fragments de 5-10 kilobases avant). Ce qui permet de cartographier ces contacts à haute résolution.

Avec cette technique, les chercheurs montpelliérains et leurs collègues israéliens ont analysé le génome de la mouche du vinaigre ou drosophile. Un animal avec un génome quinze fois plus petit que le nôtre. Résultat : l'équipe a pu y identifier… 118 millions de zones de contact ! L'analyse de ces zones leur a permis ensuite d'établir des cartes d'interaction très détaillées. Ces cartes montrent que les chromosomes sont organisés en domaines contenant un ou plusieurs gènes. Séparés par des régions frontières, ces domaines correspondent soit à des zones activement exprimées, soit à des régions inactives.

Grâce aux compétences en mathématiques de l'équipe israélienne de Amos Tanay, les deux équipes ont pu ensuite développer un modèle informatique capable de prédire assez fidèlement le repliement réel des chromosomes. Très puissant, cet outil a permis de décrypter les principes fondamentaux qui régissent l'organisation tridimensionnelle du génome. Notamment, il est apparu que les domaines inactifs ont tendance à former des contacts avec d'autres domaines inactifs souvent proches sur le même chromosome, alors que les domaines actifs « contactent » d'autres domaines actifs lointains ou proches et éventuellement sur d'autres chromosomes.

Cruciaux, ces travaux devraient permettre de mieux comprendre les différences de repliement chromosomiques selon les types de cellules (cellules de foie, de muscle, nerveuse, etc.) et l'importance de ce repliement dans la survenue de cancers.

CNRS

|

|

|

|

|

|

|

|

|

La protéine p53, connue pour contrôler la vie ou la mort des cellules, est un des acteurs clés de la recherche contre le cancer. Son inactivation est constatée chez 50 % des personnes atteintes de cancers. Si les chercheurs réussissaient à rétablir la présence de p53 chez les malades, ils tiendraient peut-être une piste thérapeutique prometteuse. Toutefois, p53 n’agit pas seule. Son expression est liée à celle de Mdm2. Dans un article paru dans la revue Cancer Cell, Robin Fahraeus et ses collaborateurs de l’Unité Inserm 940 "Cibles Thérapeutiques du Cancer" démontrent que la réponse cellulaire à un dommage de l’ADN nécessite l’intervention de la protéine kinase ATM pour permettre à Mdm2 de réguler positivement ou négativement la protéine p53. La protéine p53 est très étudiée dans la recherche contre le cancer. Découverte en 1979, elle régule finement la prolifération des cellules et déclenche selon les besoins la réparation de la cellule ou sa mort naturelle programmée (apoptose).

Contrairement aux cellules "normales", le cycle cellulaire des cellules tumorales s’emballe, provoquant la prolifération de cellules de manière anarchique, à l’origine du cancer. Les cellules deviennent immortelles et provoquent alors des dérégulations importantes dans l’organisme. Il y a déjà quelques années, les chercheurs ont prouvé que le gène de la protéine p53 est inactivé dans la moitié des cancers chez l'Homme. Le gène codant pour p53 a été classé comme gène suppresseur de tumeur. Les scientifiques ont émis l’hypothèse qu’en réactivant ce gène, ils pourraient empêcher cet emballement cellulaire responsable de la formation des tumeurs cancéreuses. Mais, ils découvrent plus tard, que p53 est elle-même régulée par un autre acteur : la protéine Mdm2. Ils pensaient alors avoir trouvé un moyen de réactiver p53.

Robin Farhaeus et ses collaborateurs apportent aujourd’hui un nouvel élément de compréhension des mécanismes de cancérisation : l’implication de la protéine kinase ATM dans la régulation de p53 par Mdm2. "Après un dommage sur l’ADN, Mdm2 est nécessaire pour activer p53 et cela peut se faire grâce à l’intervention de la protéine ATM kinase" explique Robin Farhaeus, directeur de recherche à l’Inserm. Pour réaliser cette démonstration, les chercheurs ont remonté la cascade d’événements qui déclenchent l’activation de p53. L’activation de Mdm2 est due à sa phosphorylation par la protéine kinase ATM, elle-même activée en cas de stress cellulaire. Cette phosphorylation de Mdm2 est cruciale pour passer d’un état de régulateur négatif à régulateur positif de p53 et favoriser ainsi son interaction avec l’ARNm de p53 pour induire sa traduction. Ceci conduit à une augmentation de la quantité de p53 dans la cellule.

Inserm

|

|

|

|

|

|

|

|

|

Les résultats de l’essai de thérapie génique de phase I pour la gamma-sarcoglycanopathie, une maladie neuromusculaire rare, ont été publiés dans la revue Brain, le 11 janvier 2012. Débuté en décembre 2006, cet essai, dont le promoteur est Généthon, le laboratoire de l’AFM-Téléthon, a été mené à l’hôpital de la Pitié-Salpêtrière (AP-HP) au sein de l’Institut de Myologie et du service de médecine interne par les Professeur Serge Herson (Chef de service, Médecine interne 1) et Olivier Benveniste (PU-PH, Médecine interne 1), investigateurs principaux. Son objectif était d’évaluer la tolérance à l’injection locale de doses croissantes d’un vecteur viral AAV portant le gène normal de la gamma-sarcoglycane (la protéine défectueuse dans cette maladie), mais aussi la réaction immunitaire locale et systémique, ainsi que la qualité du transfert de gène dans les muscles injectés, en termes d’efficacité, d’expression et de distribution.

Neuf malades non ambulatoires, âgés de 16 à 38 ans, ont été inclus de décembre 2006 à décembre 2009. Trois doses croissantes de vecteurs viraux AAV1 transportant le gène normal de la gamma-sarcoglycane ont été injectées dans un muscle de l’avant-bras. Un mois après l’injection, la zone traitée a fait l’objet d’une biopsie et a été analysée.

Cet essai livre aujourd’hui ses résultats et ils sont encourageants. Tout d’abord, les injections ont été bien tolérées, sans effets indésirables physiques ou biologiques. En outre, chez cinq malades, les analyses ont détecté la présence d’ARN du gène thérapeutique, c’est-à-dire du matériel génétique intermédiaire entre le gène et la protéine. L’analyse immunohistochimique du muscle injecté montre l’expression de la protéine γSGC chez les trois patients qui ont reçu la dose la plus forte. Par ailleurs, chez l’un de ces malades qui a reçu la plus forte dose de traitement, la protéine normale s’exprime en western blot dans les fibres musculaires. Grâce à la thérapie génique, la protéine gamma-sarcoglycane manquante est donc de nouveau produite. Pour Serge Herson, investigateur principal de l’essai : « Les résultats de cet essai vont au-delà de nos espérances : outre le constat de l’absence de toxicité du traitement qui était l’objectif principal de cette étude, nous avons pu avancer sur d’autres aspects comme l’organisation pratique d’un tel essai, l’immunologie et même la dose optimale pour traiter efficacement un ensemble de muscles. Ce résultat est d’autant plus intéressant qu’il signifie que nous avons établi la dose à partir de laquelle le traitement devient efficace. Or, là encore, c’est un fait rarissime pour un essai de phase I. »

Aujourd’hui, médecins et chercheurs de Généthon, de l’Institut de Myologie et de la Pitié-Salpêtrière (AP-HP) poursuivent leurs travaux. Ils envisagent un nouvel essai utilisant un vecteur AAV8 pour traiter un membre complet.

Genethon

|

|

|

|

|

|

|

|

|