|

|

|

|

|

| NUMERO 617 |

|

|

|

|

|

|

|

Edition du 29 Septembre 2011

|

|

|

|

|

Edito

Une nouvelle physique est-elle en train de naître ?

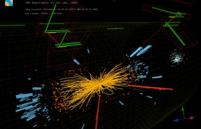

L'annonce a fait l'effet d'une bombe dans la communauté scientifique : une expérience réalisée dans le cadre du projet scientifique OPERA par une équipe de 160 chercheurs entre le CERN de Genève et le laboratoire souterrain du Gran Sasso en Italie pourrait remettre en cause l'un des principes fondamentaux de la physique, fixé depuis plus d'un siècle par la théorie de la relativité restreinte d'Einstein, qui veut que rien ne puisse dépasser la vitesse de la lumière (299.792,458 kilomètres par seconde dans le vide).

Dans cette expérience, révélée seulement le 23 septembre dernier mais dont tous les résultats ont été vérifiés pendant six mois avant publication, les physiciens ont envoyé un faisceau d'environ 15.000 neutrinos depuis le CERN de Genève en direction d'un détecteur enfoui dans un tunnel dans la région des Abruzzes près de L'Aquila, en Italie.

La vitesse de ces neutrinos a alors été mesurée à l'aide d'horloges atomiques avec une extrême précision de l'ordre de la nanoseconde et, à la stupéfaction des scientifiques, les neutrinos, après avoir parcouru 730 km, sont arrivés avec une avance de 60 nanosecondes, sur des photons virtuels qui auraient effectué le même voyage dans le vide. (Voir l'article complet « Neutrinos superluminality and Local Lorentz Invariance » et l’article du CERN). Cet écart peut sembler insignifiant mais il est réel et ne trouve aucune explication satisfaisante pour l'instant.

Il reste qu'il est beaucoup trop tôt pour affirmer, comme l'ont fait imprudemment certains médias, qu'Einstein se serait trompé et que sa théorie de la relativité est à mettre à la poubelle. Comme le souligne le directeur de la recherche au CERN, Sergio Bertolucci, il faut d'abord confirmer de manière indépendante et avec une meilleure précision, ces résultats.

Cette confirmation est programmée et prendra environ deux ans. Il faut par ailleurs souligner la méthodologie employée dans cette expérience : la vitesse des neutrinos a été calculée en divisant la distance parcourue (730 km) par le temps de parcours (2,4 millisecondes). Mais ces deux paramètres peuvent être affectés par de nombreux facteurs comme l'effet des marées de la Lune, la température du sol, la rotation de la Terre ou encore la précision du GPS de référence.

Il faut également rappeler, comme le fait le physicien Thibault Damour, que la théorie de la relativité restreinte a été parfaitement vérifiée dans tous ses aspects depuis près de 100 ans par des dizaines d'expériences rigoureuses, avec une précision inouïe, de l'ordre de 27 décimales ! Autre point important, en 1997, l'explosion d'une supernova a provoqué l'émission de neutrinos vers la Terre et ceux-ci sont arrivés exactement en même temps que la lumière de l'étoile.

Mais, même si cette mesure était confirmée, elle ne remet pas forcement en cause la relativité restreinte. Certains scientifiques soulignent en effet que les neutrinos, particules encore mal connues, ont peut-être emprunté une autre dimension et qu'il existe dans notre univers, comme le prévoit d'ailleurs la théorie des cordes, plus de quatre dimensions.

Stavros Katsanevas, directeur adjoint de l'Institut de physique nucléaire, Etienne Klein et Laurent Notale, du CNRS, soulignent de façon très pertinente qu'il est tout à fait possible que la vitesse de la lumière ne soit pas la vitesse limite mais que cela ne doit pas conduire à abandonner la théorie de la relativité restreinte mais plutôt à la compléter.

Dans cette hypothèse, il faudrait simplement admettre que le “c” de la célèbre formule "E=mc²", qui établit l'équivalence fondamentale entre matière et énergie" ne soit plus le “c” de la vitesse de la lumière mais devienne la constante d’une autre vitesse supérieure qui serait observée dans certaines situations tout à fait exceptionnelles chez une seule particule, le neutrino. Ces physiciens réputés pensent qu'il serait ainsi possible de conserver la relativité restreinte et ils soulignent que "Cette théorie ne dit pas que la constante “c” doit nécessairement être celle de la lumière".

Enfin, ces scientifiques font une remarque d'ordre épistémologique et philosophique très puissante : comme l'a magistralement montré le grand philosophe des sciences Karl Popper, il ne faut pas confondre la véracité d'une théorie scientifique et sa complétude. Le fait qu'une théorie soit "vraie" au sens où elle n'a jamais pu être mise en défaut par l'expérimentation (ce qui est absolument le cas de la relativité restreinte) ne signifie pas que cette théorie soit complète et qu'elle "épuise" la réalité. La théorie de la relativité d'Einstein n'a pas rendu fausse la théorie de la gravitation de Newton mais l'a intégrée dans un ensemble conceptuel plus vaste, plus complexe et plus heuristique.

De la même manière, si l'on admet que la complexité et la subtilité du réel sont infinies et qu'elles nous échappent encore largement, il n'y a plus aucun obstacle logique à considérer que la géniale théorie de la relativité d'Einstein n'explique pas toutes les observations et expériences que nous pouvons réaliser et doit, à son tour, être intégrée dans un nouvel ensemble théorique plus vaste, comme la théorie des cordes par exemple qui essaye, avec beaucoup de difficultés, d'articuler depuis plus de 40 ans la relativité générale et la physique quantique dans un cadre théorique d'une rare élégance.

Il est frappant de constater que cette première observation de neutrinos supraluminiques survient alors que les physiciens du CERN sont sur le point de mettre en évidence l'existence ou l'absence du fameux boson de Higgs, une particule prévue en 1964 qui constitue la clef de voûte du "Modèle standard" des physiciens, puisque son existence est nécessaire, dans le cadre théorique actuel, si l'on veut expliquer pourquoi les particules, à l'exception du photon, du gluon et de l'hypothétique graviton, ont une masse. Ce boson de Higgs déterminerait également la taille actuelle de notre univers et serait à l'origine de son expansion accélérée sous l'effet de la mystérieuse énergie sombre.

Mais si ce boson de Higgs n'existe pas, ce que nous devrions enfin savoir d'ici quelques mois, la physique connaîtrait alors un bouleversement autrement plus profond que celui qui résulterait de l'existence confirmée de neutrinos supraluminiques. Dans cette hypothèse tout à fait envisageable, certains scientifiques pensent qu'on ne pourrait plus faire l'économie d'une nouvelle théorie reposant sur un univers à plus de 4 dimensions, ce qui permettrait d'expliquer de manière cohérente le nombre, la masse et le comportement des particules mais également la structure et l'évolution en expansion accélérée de notre univers.

Ces 6 dimensions supplémentaires, prévues notamment par la théorie des supercordes, rénovée et complétée en 1995 par Witten seraient si petites (10-33 m alors qu'un atome mesure environ 10-10 m) qu'elles seraient totalement invisibles et indétectables directement, dans l'état actuel de nos outils technologiques. Cette idée d'un univers comportant des dimensions cachées n'est d'ailleurs pas nouvelle puisque le physicien polonais Theodore Kazula l'avait proposée à Einstein en 1920 et que celui-ci l'avait, semble-t-il, trouvée intéressante !

On le voit, avec ou sans les neutrinos facétieux du CERN, la physique est sans doute à l'aube d'une nouvelle révolution comparable à celle de la mécanique quantique et de la relativité, il y a un siècle. Nul ne sait quels mystères dévoilera cette nouvelle physique mais ce qui est certain, c'est qu'elle nous surprendra et nous permettra de franchir une nouvelle étape dans la connaissance émerveillée de ce monde extraordinaire qui nous a produit.

René TRÉGOUËT

Sénateur Honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

A l’origine, l’Internet mis au point par le DARPA a été conçu comme moyen de communication entre deux hôtes désirant se parler. Aujourd’hui, le modèle n’est plus valable. On le sait, à l’avenir, le réseau des réseaux doit être "user-centric". Internet aujourd’hui doit donc prendre en compte, en plus des noeuds interconnectés du réseau, l’utilisateur final et son contexte, comme une seule entité. C’est ce que des chercheurs de l’université de Singapour prônent, en proposant leur "User-Context-Module" (Module Utilisateur contextuel), à intégrer dans les architectures Internet de demain. Objectif avoué : améliorer à terme l’expérience utilisateur, ajuster les réseaux et les applications en fonction des besoins et des ressources, en fonction du terminal qu’il utilise, ou de l’endroit où il se trouve, et du réseau disponible, en bref, selon le contexte.

Les chercheurs se sont appuyés sur les sciences cognitives, qui traitent de la manière dont les informations sont représentées et traitées par le cerveau humain : la pensée humaine est "sensible" au contexte et à son environnement, et prend les bonnes décisions en fonction de ceux-ci. Pour parvenir à ce type d’intelligence, l’architecture idéale doit savoir séparer l’hôte, son adresse, le nom de l’utilisateur final, les données et les périphériques réseau, et les manipuler de manière individuelle. Le module proposé, User-Context Module, a pour but d’intégrer des informations pertinentes de contexte.

Le Module se divise en trois sous-systèmes : le Context Interface, le Context Model, et le Contrôleur. Le premier interagit directement avec l’utilisateur final et son environnement : il collecte les informations relevant du contexte (préférences, localisation, identités...). Le deuxième collecte des informations sur le modèle de contexte, données abstraites sur le statut de l’utilisateur, son comportement sur le réseau. Enfin, le système de Contrôle interagit directement avec les couches réseau et l’infrastructure, pour ajuster automatiquement les protocoles ou les paramètres capables d’optimiser les performances du réseau, et ainsi offrir une meilleure expérience à l’utilisateur.

L'Atelier

|

|

|

|

|

|

|

|

|

IBM est en train de mettre au point le plus grand système de stockage au monde : celui devrait atteindre une capacité de 120 pétaoctets. Soit l’équivalent d’environ 120 000 disques durs de 2 To ou encore 24 milliards de MP3 ! C’est une capacité presque dix fois supérieure aux plus grands systèmes actuels, capables de stocker jusqu'à 15 Po environ. Pour atteindre ce niveau de performance, IBM utilise simultanément 200 000 disques durs de 600 Go. Mais pour gérer une telle quantité de disques, IBM a imaginé des racks spéciaux, refroidis à l’eau. Autre innovation, un procédé permettant de changer un disque dur défectueux sans altérer les performances globales du système : selon Bruce Hillsberg, directeur de recherche chez d'IBM, ce procédé permettrait au système de fonctionner pendant un million d’années sans perdre de données ni diminuer ses performances…

Ce système hors norme utilise un système de fichiers qui « inscrit des fichiers individuels sur des disques multiples afin de lire et d’écrire simultanément de multiples portions d’un fichier. Ce système baptisé GPFS a permis à IBM de recenser 10 milliards de fichiers sur un système de stockage, en 43 minutes. A titre de comparaison, le précédent record était de un milliard de fichiers scannés en trois heures. Cette machine pourra gérer un million de milliards de fichiers et devrait permettre des avancées décisives dans les modélisations et simulations numériques hautement complexes, tant en physique qu'en climatologie ou en biologie.

Technology Review

|

|

|

|

|

|

|

|

|

Pour échanger dans le cadre professionnel, c'est aujourd'hui le mail qui a la faveur des salariés, en interne comme en externe. Mais on se doute que, avec la montée en puissance des réseaux sociaux et de l'ensemble des modes de communication instantanée, la situation a de fortes chances de changer. Dans une étude, Robert Half Technology le confirme : 54 % des directeurs des systèmes d'information interrogés par le cabinet estiment que dans les cinq années à venir, le temps réel devrait détrôner le mail. Cela pour trois principales raisons : la praticité tout d'abord. De nombreux services combinent messagerie instantanée, microblogging, forums, partage et gestion de documents.

Ce qui permet de ne pas avoir à naviguer d'une application à l'autre pour répondre à ses différents besoins de travail. Selon Robert Half Technology, cela devrait aussi réduire le besoin d'organiser des réunions en présentiel. En deuxième lieu, le cabinet évoque l'aspect social. Des sites de réseautage interne comme Yammer ou Chatter facilitent la collaboration et le partage d'idées et de bonnes pratiques entre les différents membres d'une compagnie. La vitesse, enfin. L'entreprise de conseil rappelle ainsi que la messagerie instantanée permet d'engager une discussion sans avoir à attendre de réponse en cas d'urgence.

L'Atelier

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

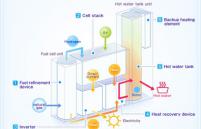

Panasonic développe depuis 1999 des piles à combustible à micro-cogénération (production combinée de chaleur et d'électricité) destinées à un usage domestique. Lancé en collaboration avec plusieurs opérateurs gaziers dont Tokyo Gas, il y a 2 ans au Japon, l'ENE FARM a d'ailleurs été le premier système de ce type au monde.

Fort du succès enregistré par Panasonic avec ces piles à combustible sur le marché japonais, le Groupe prévoit d'étendre ses activités à l'Europe. Selon lui, "ce nouveau centre de recherche situé au sein du centre européen de R&D de Panasonic en Allemagne est appelé à jouer un rôle clé dans la réalisation de cet objectif."

La chaleur produite par le système de micro-cogénération sert au chauffage des habitations et de l'eau. Ainsi, au Japon, un logement alimenté par une pile à combustible ENE FARM peut réduire ses émissions de CO2 de près d'une tonne et demie par an, par rapport à un autre alimenté en électricité à partir d'une centrale thermique et chauffé au gaz.

« Notre objectif global est de devenir la première société d'éco-innovation dans le secteur de l'électronique grand public à l'horizon 2018 », commente Laurent Abadie, PDG de Panasonic Europe. « Avec l'ouverture de notre centre de R&D consacré à la promotion de la technologie de pile à combustible en Europe, nous avons accompli un nouveau pas en direction de cet objectif de 2018 et assurons ainsi à nos clients l'accès à des technologies écologiques dans le monde entier, tout en développant le chiffre d'affaires et les activités de Panasonic en matière d'éco-énergie. »

Les piles à combustible "ENE FARM" produisent de l'électricité grâce à une réaction chimique entre l'oxygène issu de l'atmosphère et l'hydrogène extrait du gaz de ville. La chaleur générée comme sous-produit de ce processus est utilisée pour le chauffage domestique et l'eau chaude. L'électricité est générée et utilisée au même endroit, il n'y a aucune perte d'énergie dans la diffusion. "Toute la chaleur produite au cours de la production de l'électricité peut être utilisée sans gaspillage" affirme Panasonic.

Par rapport aux méthodes classiques de production de l'énergie, les piles à combustible permettent de réduire la consommation d'énergie de près de 35 % et les émissions de CO2 de près de 48 %. Les utilisateurs peuvent de fait réduire leur facture annuelle d'environ 440 à 530 euros et les émissions de CO2 d'environ 1,5 tonne par an. Toujours d'après Panasonic, "ENE FARM" offre une LHV (Lower Heating Value ou Pouvoir calorifique inférieur) de 40 %.

Il apparaît que les dernières évolutions apportées au système (puissance de production d'électricité, introduction de nouvelles technologies, de nouveaux composants) permettent de réduire la taille des piles de 30 à 40 % comparé aux anciens modèles. De plus, la configuration du système à « piles à combustible » a été simplifiée, avec une réduction de 30 % du nombre de composants et de 20 % du poids. Ces améliorations ont permis à Tokyo Gaz et Panasonic de réduire considérablement le prix du nouveau système qui est de 24 300 euros TTC (hors frais d'installation) soit une économie de 6 150 euros par rapport aux modèles précédents.

Enerzine

|

|

|

|

|

|

|

|

|

Il n'est plus innovant de parler d'applications permettant de savoir instantanément si les fenêtres de la maison sont ouvertes ou fermées. Mais celles-ci requièrent la plupart du temps l'installation de capteurs encombrants, peu ergonomiques, et gourmands en électricité. Pour résoudre le problème, des chercheurs de l'institut IMS du Fraunhofer proposent de mettre en place un système de détection qui soit sans fil, et indépendant d'un point de vue énergétique. Le système mis au point, "Wireless window contact", ne nécessite ni maintenance, ni batteries. Le principe est connu : les capteurs sont appliqués sur les fenêtres de l'habitation. Les données recueillies sont ensuite centralisées vers une sorte de transmetteur, qui les envoie lui-même au smartphone de l'utilisateur.

Mais là où le système se veut novateur, c'est au niveau de l'alimentation en énergie. En effet, le dispositif mis au point comporte, outre les capteurs, un transmetteur situé dans chacune des pièces de la maison. En plus de collecter les données du capteur, celui-ci capte les ondes radio présentes dans l'environnement, pour ensuite les transformer en énergie électrique, qu'il va transmettre aux capteurs. Par ce biais, le système atteint de fait une totale autonomie énergétique.

Pour les chercheurs, le système présente l'avantage de combiner esthétisme et efficience. Ainsi, et contrairement à une batterie solaire, l'alimentation ne dépend pas de facteurs incontrôlables (les ondes radios sont présentes à peu près partout, et en continu), et à l'inverse d'un branchement sur secteur, la place requise par l'installation du système est négligeable. Gerd Vom Boëgel, l'un des développeurs, précise que "le plus dur a été la mise au point d'un système qui respecte les normes en vigueur en terme d'émissions d'onde. Nous y sommes parvenus, et le système en question fonctionne désormais parfaitement, même sur de grandes distances". A terme, les chercheurs visent à généraliser l'emploi ce système de capteurs, afin de collecter d'autres donnée, et notamment la température.

L'Atelier

|

|

|

|

|

|

|

|

|

Jusqu’où ira la technologie des écrans LCD ? Après avoir conquis le domaine des grandes tailles, réservé auparavant à la technologie des écrans plasma, et porté la qualité d’affichage à la haute définition, la voilà prête à révolutionner à nouveau la télévision.

A l’IFA, la grande messe de l’électronique grand public qui s’est tenue à Berlin du 02 au 07 septembre 2011, Sharp a dévoilé son prototype d’écran LCD Super Hi-Vision de 85 pouces de diagonale. Sa particularité ? Il offre une résolution d’image record de 33 millions de pixels, soit 16 fois celle de la télévision à haute définition actuelle.

L’écran a été développé conjointement avec NHK, l’entreprise publique de télédiffusion au Japon, dans le cadre du projet d’évolution de la télévision de la haute définition actuelle (Hi-Vision avec 2 millions de pixels) vers la super haute définition (Super Hi-Vision avec 33 millions de pixels).

Désormais, le Japon dispose de toute la chaîne technologique nécessaire au test de cette future télévision, depuis les capteurs d’images jusqu’aux écrans de visualisation, en passant par les caméras de prises de vue ou les vidéoprojecteurs.

La prouesse de Sharp montre tout le potentiel de la technologie LCD dont la capacité à monter en définition est bien supérieure que celle des écrans plasma. Pour l'instant du moins. Il faudra attendre la réaction de Panasonic, le leader des écrans plasma.

Industrie & Technologies

|

|

|

|

|

|

|

|

|

Les physiciens y croyaient très fort, mais le verdict est tombé le 22 août dernier à la conférence Lepton-Photon de Mumbai. « Le boson de Higgs n’a toujours pas été identifié », affirme Laurent Serin, physicien et directeur scientifique adjoint de l’IN2P3 du CNRS. « Cependant les expériences du plus puissant des accélérateurs de particules, le LHC (Large Hadron Collider) au CERN à Genève, fonctionnent si bien que, s’il existe, elles nous en apporteront bientôt la preuve » ajoute-t-il confiant.

Pourtant un mois auparavant, les 700 physiciens réunis pour la conférence « Europhysics Conference on High Energy Physics » à Grenoble, étaient au comble de l’excitation : les détecteurs de deux expériences séparées sur le LHC (Atlas et CMS) avaient enregistré de manière indépendante des signaux qui pouvaient faire espérer la signature du boson de Higgs. Dans un domaine de masse autour de 140 GeV (gigaélectronvolts) les données expérimentales présentaient chacune des excès d’événements. Cependant, avec une analyse plus poussée et un nombre de collisions enregistré doublé entre les deux conférences, il semblerait que cet excès n’était dû qu’à des fluctuations statistiques.

Encore raté ! Le graal de la physique moderne qui tient en haleine les physiciens du monde entier, depuis que Peter Higgs et ses collègues ont démontré en théorie son existence, va encore garder son mystère. Depuis plus de quarante ans en effet, le boson échappe à toutes les expériences qui sont mises en place pour l’observer. Or, il est la pièce maîtresse sur laquelle repose le bel édifice théorique, appelé « Modèle Standard », qui décrit le bel ordonnancement de la matière par le jeu de quatre forces fondamentales. Si on ne trouve pas le boson, le modèle s’effondre.

Néanmoins, les physiciens restent confiants : le LHC et les expériences fonctionnent très bien et la traque va se poursuivre de plus belle. « Tout va très vite », poursuit Laurent Serin. « Les équipes d’Atlas et CMS, avec une forte contribution des groupes français, ont analysé plus de 100x1012 collisions en un temps très court et ont permis déjà d’exclure presque 50 % du domaine de masse dans lequel il pourrait exister (entre 115 et 600 GeV). Et en décidant de poursuivre l’exploitation du LHC à son niveau d’énergie actuel (7 millions d’électronvolts) jusqu’à fin 2012, nous sommes certains de prouver son existence. »

CNRS

|

|

|

|

|

|

|

|

|

Pour la première fois, une expérience de stabilisation constante d'un état quantique a été réalisée par une équipe du laboratoire Kastler Brossel (CNRS/ENS/Collège de France/UPMC-Université Pierre et Marie Curie) sous la direction de Serge Haroche.

Les chercheurs ont réussi à maintenir un nombre constant de photons au sein d'une cavité micro-onde de haute qualité. Ils décrivent les résultats de leur étude dans la revue en ligne Nature du 1er septembre 2011. Le photon, grain élémentaire de lumière, n'est usuellement observable que lorsqu'il disparaît. L'œil absorbe les photons en les détruisant et traduit cette information à mesure qu'elle est enregistrée. Malgré tout, cette destruction n'est pas indispensable. Il y a 4 ans, l'équipe du laboratoire Kastler Brossel a réussi une grande première : observer, des centaines de fois, un seul et même photon micro-onde piégé dans une boîte.

Dans leurs nouveaux travaux, les chercheurs vont encore plus loin : réussir à stabiliser un nombre de photons donné dans une « boîte à photons », cavité formée de deux miroirs supraconducteurs. C'est la première expérience complète de stabilisation quantique. Les stabilisations, en général, assurent le fonctionnement des systèmes qui nous environnent. Dans le cas d'un four, sa température de chauffe est assujettie à une valeur de consigne : lorsque la température idéale n'est pas atteinte, le four continue de chauffer puis maintient son état d'après les indications du thermostat.

Le transfert de ces concepts au monde microscopique quantique se heurte à un obstacle : la mesure -le thermomètre- change l'état du système. La stabilisation quantique consiste en une mesure réalisée par l'injection d'atomes, sondes ultrasensibles, dans la cavité. Cette mesure ne fixe pas le nombre de photons, mais donne sur celui-ci une information floue. Comme toute mesure quantique, elle modifie cependant l'état de la cavité. Un contrôleur – le thermostat –, prend en compte cette information ainsi que la perturbation de la mesure et pilote une source micro-onde classique – les résistances du four. Ainsi, la cavité est amenée ou ramenée vers un état où le nombre de photons a exactement la valeur prescrite.

Einstein avait un rêve, celui d'emprisonner un photon dans une boîte pendant un temps de l'ordre de la seconde. Cette stabilisation quantique permet aujourd'hui au groupe du LKB d'aller plus loin dans la réalisation de ce rêve en maintenant de façon permanente un nombre de photons choisi dans la boîte. Cette expérience est une étape importante vers le contrôle d'états quantiques complexes.

CNRS

|

|

|

|

|

|

|

|

|

Pour certaines industries, la mise au point de batteries rapidement rechargeables et à longue durée de vie est essentielle. Pour répondre à ce besoin, des chercheurs du Laboratoire de l'Université de Berkeley ont mis au point un nouveau composant aux propriétés extrêmement intéressantes. Synthétisé à partir de feuilles de graphène et d'étain, celui-ci pourrait s'intégrer efficacement à des batteries lithium-ion, augmentant leurs capacités ainsi que leur durée de vie.

Les chercheurs ont superposé alternativement des micro-feuilles de graphène et d'étain, à la manière d'un mille-feuille. Le produit créé est alors chauffé à plus de 300 degrés celsius. Cette opération a pour effet de faire fondre les feuilles d'étain, dont les atomes se condensent sous forme de piliers. Cette concentration augmente logiquement l'épaisseur des couches en question, accroissant par là même l'épaisseur totale du composé. Or, selon les développeurs, ce changement de volume améliore considérablement les performances du matériau lorsqu'il est intégré à l'électrode d'une batterie. Celle-ci devient plus performante, et s'use moins rapidement.

Le matériau est donc idéal pour la mise au point de batteries lithium-ion pouvant être réutilisées à de très nombreuses reprises. Or, certaines industries de pointe (et notamment celle des véhicules électriques) sont dépendantes des avancées du secteur. Ainsi, comme le souligne Yuegang Zhang, membre de l'équipe de recherche, “le développement de véhicules électriques passe par la mise au point de batteries haute-performance, pouvant être rechargées extrêmement rapidement, et dont la durée de vie ne soit pas altérée par les rechargements successifs”. Le chercheur souligne d'ailleurs que "ce "sandwich" de graphène et d'étain est un pas de plus vers une technologie de stockage d'énergie ultra-performante".

L'Atelier

|

|

| ^ Haut |

|

|

|

|

|

|

|

Espace |

|

|

Espace et Cosmologie

|

|

|

|

|

|

|

|

|

|

La traque aux étoiles primordiales est un sujet astrophysique très ancien. Au sein de l'Observatoire de Paris, une équipe de spécialistes de la composition chimique des étoiles se consacre depuis une dizaine d'années à cette question d'importance pour mieux comprendre comment notre galaxie, la Voie lactée, s'est formée et a évolué. Les modèles les plus communément admis tendent à considérer que les toutes premières étoiles de l'Univers étaient hypermassives et ont rapidement explosé en hypernovae ultralumineuses. Ensuite, sont apparues les étoiles massives ou plus modestes, comme le Soleil, que nous connaissons aujourd'hui.

C'est un nouveau spécimen de cette seconde génération d'astres que les chercheurs du laboratoire Galaxies, Etoiles, Physique et Instrumentation GEPI (Observatoire de Paris, CNRS, Université Paris Diderot), de l'Université de Picardie Jules Verne (Amiens) et du laboratoire Cassiopée (Observatoire de la Côte d'Azur, CNRS, Université de Nice-Sophia Antipolis) viennent de découvrir en collaboration avec des collègues italiens et allemands.

Ils l'ont débusqué parmi les 2 899 étoiles identifiées comme potentiellement primitives dans le recensement américain du Sloan Digital Sky Survey (SDSS). A la date de l'observation, un tiers seulement de ces objets essentiellement situés dans l'hémisphère céleste nord étaient accessibles au Very Large Telescope de l'Observatoire européen austral ESO sur le Paranal au Chili. Au final, une sélection plus restreinte de six candidats a été étudiée et l'on s'attend à ce que 5 à 50 étoiles similaires, pauvres en éléments lourds tels que carbone, magnésium, silicium, calcium, fer et strontium, puissent ainsi être identifiées.

Le meilleur des six candidats retenus, l'étoile SDSS J102915+172927, apparaît dans le ciel comme un infime point lumineux de magnitude 17, c'est-à-dire 25 000 fois trop faible pour pouvoir être aperçu à l'œil nu. Les scientifiques ont analysé son rayonnement à l'aide des instruments X-Shooter et Ultraviolet and Visual Echelle Spectrographe (UVES) installés sur Kueyen, l'un des quatre télescopes de 8 mètres de diamètre qui composent le Very Large Telescope. X-Shooter notamment est un spectrographe capable d'étudier en une seule fois toutes les gammes de lumières depuis le proche infrarouge jusqu'à l'ultraviolet. Il est équipé d'une optique à intégrale de champ qui le rend très efficace. Cet élément ainsi que le logiciel de réduction de données ont été conçus et fournis par l'Observatoire de Paris/GEPI (Observatoire de Paris, CNRS, Université Paris Diderot). X-Shooter opère régulièrement sur le ciel depuis 2009.

Surprise : les données acquises ont révélé que l'étoile primitive surnommée « étoile de Caffau » se compose presque uniquement des éléments légers hydrogène et hélium issus du big bang. Les éléments lourds synthétisés plus tard, ultraminoritaires, ne comptent que pour 0,00007 % de sa matière. C'est 20 000 fois moins que ce que l'on mesure dans l'atmosphère du Soleil. En outre, l'étoile ne présente pas d'anomalie, d'enrichissement en carbone et oxygène, contrairement à ce qui a pu être constaté jusqu'ici dans ce type d'astre.

Problème : selon les modèles les plus classiques de formation d'étoiles, de telles naines uniformément pauvres en éléments lourds ne devraient pas pouvoir exister. En effet, avec si peu d'éléments lourds, un renforcement du carbone et de l'oxygène apparaissait comme essentiel pour que le nuage de gaz géniteur se refroidisse et se condense. Il n'en est rien. Dans ce cas au moins, la théorie devra être révisée.

CNRS

|

|

|

|

|

|

|

|

|

Un télescope de la Nasa a découvert une planète gravitant autour de deux étoiles.

Elle s'appelle Kepler-16b et fait déjà rêver tous les fans de la saga Star Wars. En effet, comme sur Tatooine, la planète de Luke Skywalker, Kepler-16b gravite autour de deux soleils. Cependant, les similitudes s'arrêtent là. Kepler-16b, découverte par le télescope Kepler, est une planète gazeuse où la température ne dépasse pas les -100° Celsius. Aux antipodes de la planète tellurique, désertique et aride du célèbre Jedi. Le double couché de soleil n'est donc pas pour aujourd'hui.

Situé à 200 années lumières de notre système solaire, elle gravite autour d'une étoile, plus petite et moins chaude que notre soleil, en 229 jours (à cinq jours près comme Vénus) et ce, à une distance moyenne de 104,6 millions de kilomètres. La seconde étoile, une naine rouge, gravite elle aussi autour de l'étoile en seulement 41 jours. La nouvelle exoplanète (planète orbitant autour d'une étoile autre que le Soleil) fait à peu près la taille et la masse de Saturne, soit une centaine de fois la masse de notre Terre.

Le télescope Kepler, dédié à la recherche d'exoplanètes observe plus de 155.000 étoiles et enregistre la moindre petite variation de luminosité, la moindre petite éclipse. C'est ainsi que le télescope a détecté la présence de deux corps gravitant autour de l'étoile Kepler-16. Depuis son envoi dans l'orbite du soleil en mars 2009 de Cap Canaveral en Floride, Kepler a découvert une vingtaine d'exoplanètes. La mission initiale est de trouver des planètes similaires à la Terre (même position par rapport à son étoile) et qui pourraient abriter la vie.

France Soir

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Armés d'un scanner et d'un ordinateur, des scientifiques ont pu décoder des signaux cérébraux et reconstruire les images d'un film visionné par trois sujets, pour les convertir en modèle informatique. Shinji Nishimoto, principal auteur de cette étude parue dans la revue américaine Current Biology, et ses collègues ont regardé deux extraits de film. Pendant ce temps, un scanner mesurait les flux sanguins dans leur cortex visuel, la zone du cerveau qui traite les images. Ces mesures ont été enregistrées dans un ordinateur qui, seconde après seconde, a pu lier les images vues par les sujets à une activité cérébrale correspondante. A l'issue de l'expérience, l'ordinateur a pu reconstruire des images, floues, des extraits de films visionnés auparavant par les trois sujets.

Jusqu'à présent, cette technique, qui combine l'imagerie par résonance magnétique (IRM) et des modèles informatiques, peut seulement reconstruire des extraits de films que les volontaires de l'expérience ont déjà vus auparavant. Mais "notre expérience visuelle naturelle est similaire à la vision d'un film", relève Shinji Nishimoto. Elle ouvre donc potentiellement la voie à une technologie capable de voir des images à l'intérieur de notre tête – comme des rêves ou le "film" de la mémoire –, estiment ces scientifiques de l'université de Californie, à Berkeley, aux Etats-Unis.

"C'est un pas important vers la reconstruction de l'imagerie interne du cerveau", juge le Professeur Jack Gallant, neurologue de cette université et coauteur de ces travaux. Selon lui, "nous ouvrons une fenêtre sur les films projetés dans notre esprit".

- Dans la tête d’une personne plongée dans le coma

Cette avancée pourrait permettre un jour, parmi ses applications possibles, de communiquer avec des personnes incapables de le faire verbalement. Ou encore, de mieux comprendre ce qui se passe dans la tête de victimes d'attaque cérébrale, de personnes plongées dans le coma ou atteintes de neuro-dégénérescence, incapables de communiquer. Cette technique pourrait aussi faciliter la mise au point d'une machine capable de communiquer directement avec le cerveau, permettant à des personnes atteintes d'infirmité motrice cérébrale ou paralysées de commander un ordinateur avec la seule force de leur esprit, selon le Professeur Gallant.

Pour Shinji Nishimoto toutefois, "pour que cette technologie puisse avoir des applications étendues, nous devons comprendre le traitement de ces expériences visuelles par le cerveau". Ainsi, après cette avancée significative, il faudra encore des décennies pour qu'une telle technologie puisse lire une intention ou des sensations dans l'esprit des gens, comme cela a pu être imaginé dans des œuvres de science-fiction, soulignent ces scientifiques.

Le Monde

|

|

|

|

|

|

|

|

|

Des chercheurs suisses viennent de montrer que la prise quotidienne de sulfate de chondroïtine chez les patients souffrant d'arthrose des mains permet non seulement de réduire considérablement la douleur, mais aussi de pouvoir réutiliser ces dernières. C’est ce que révèle une étude publiée dans la revue Arthritis & Rheumatism.

Loin d’être une nouvelle molécule qui viendrait s’ajouter à la longue liste de celles qui figurent sur la pharmacopée française, le sulfate de chondroïtine est déjà vendu en officine mais n’était jusqu'alors prescrit que pour atténuer les symptômes d’arthrose du genou ou de la hanche.

Des chercheurs de l'Hôpital universitaire de Genève ont voulu vérifier si cette molécule pouvait être aussi efficace sur un autre type d’arthrose, celle qui touche les mains. Ils ont donc mené durant 6 mois une étude clinique contre placebo sur 162 patients. Ils ont d’abord constaté que la prise quotidienne de sulfate de chondroïtine n’entraînait pas a priori d’effets indésirables notables, contrairement aux anti-inflammatoires non-stéroïdiens qui sont actuellement le traitement de référence dans ce type d’affection.

Si les résultats finaux de cette étude se sont avérés encourageants, puisque les chercheurs ont observé une diminution de la douleur et une meilleur utilisation de la main, il a fallu toutefois attendre en moyenne 3 mois avant de voir les premiers effets bénéfiques du sulfate de chondroïtine sur ce type d'arthrose. Les auteurs de l’étude ont conclu leur article en recommandant donc d’utiliser pendant les premiers mois les AINS associés au sulfate de chondroïtine, avant de supprimer progressivement les premiers.

Information Hospitalière

|

|

|

|

|

|

|

|

|

Reconnaître les relations entre les relations, c'est le propre de l'analogie. Que se cache-t-il derrière cette capacité ? Est-elle uniquement humaine ? Une étude menée par Joël Fagot du laboratoire de psychologie cognitive (CNRS/Université de Provence) et Roger Tompson du Franklin & Marshall College (États-Unis) démontre que les singes sont capables de faire des analogies. Leurs résultats viennent d'être publiés dans la revue Psychological Science.

Une chatte prend soin d'un chaton, un oiseau nourrit des oisillons : si le contexte est différent, ces deux situations sont analogues et nous savons conclure qu'il s'agit de la mère et de son petit dans les deux cas. Longtemps, les chercheurs ont pensé que ce type de raisonnement analogique était impossible sans langage et qu'il serait limité à l'homme ou au mieux aux grands singes à qui l'on aurait appris un langage. Pourtant, deux scientifiques Joël Fagot au Laboratoire de psychologie cognitive (CNRS/Université de Provence) et Roger Thompson au Franklin & Marshall College aux États-Unis viennent de démontrer que les singes pouvaient produire des analogies, sans le langage.

Les deux chercheurs ont mené leur expérience auprès de 29 babouins (Papio papio) d'âges variables, pouvant librement effectuer l'exercice proposé (cela représente un grand nombre d'animaux pour ce type d'expérience). Dans un premier temps, les singes observaient deux formes géométriques sur un écran tactile, par exemple deux carrés. Après avoir touché l'une de ces formes, deux paires de formes différentes apparaissaient sur l'écran, telles que : un triangle et une étoile pour la première paire, et deux ovales identiques pour la seconde paire. Pour réussir l'exercice et être récompensé, l'animal devait toucher la paire représentant la même relation (d'identité ou de différence) que la paire initiale (ici, les deux ovales). En d'autres termes, le singe devait détecter des relations entre relations, le propre de l'analogie. Après un apprentissage intensif de plusieurs milliers d'essais, 6 babouins ont répondu correctement à la tâche, démontrant ainsi une capacité à résoudre des problèmes d'analogie. Plus encore, les chercheurs ont suspendu la tâche pendant près d'un an avant de la proposer de nouveau aux babouins. Les singes ont réappris la tâche bien plus rapidement que lors des premiers entraînements, ce qui montre qu'ils se souviennent de la situation.

Ces travaux prouvent donc que l'analogie est possible sans langage. Mais à quoi cette compétence peut-elle servir chez l'animal ? Particulièrement utile au singe et adaptative, cette capacité pourrait notamment servir au transfert de connaissances d'un domaine à l'autre.

CNRS

|

|

|

|

|

|

|

|

|

Lancée en 2005 et appelée à se poursuivre jusqu'en 2020, l'enquête AGRICAN (AGRIculture et CANcer) menée sur la santé en milieu agricole et les causes de décès en particulier par cancer, publie ses premiers résultats (basés sur la période 2006-2009) qui montrent que la santé des salariés et des exploitants agricoles est meilleure que celle du reste de la population française.

L'enquête AGRICAN suit une cohorte de 180 000 assurés agricoles actifs et retraités sur douze départements représentatifs des activités agricoles de la France métropolitaine : Calvados, Côte d'or, Doubs, Gironde, Isère, Loire-Atlantique, Manche, Bas-Rhin, Haut-Rhin, Somme, Tarn et Vendée. Cette enquête est menée par le Groupe Régional d’Etudes sur le cancer (GRECAN) de l'Université de Caen, le Centre de Lutte contre le Cancer François Baclesse, la Mutualité sociale agricole (MSA), l'Institut de santé publique d'épidémiologie et de développement (ISPED) et le réseau des registres des cancers FRANCIM.

- Une plus grande espérance de vie

Quelle que soit la cause du décès (cancers, maladies cardiovasculaires, maladies respiratoires, maladies digestives, accidents …), les résultats de l'enquête AGRICAN montrent une nette sous mortalité pour la population agricole comparativement à la population générale du même âge et du même département. Par exemple, les hommes et les femmes de la cohorte ont respectivement moins de risque de décéder d'une maladie Alzheimer ou de Parkinson (-31 % et -36 %), d'un infarctus ou d'un accident vasculaire cérébral (-29 % et -23 %) ou d'une maladie respiratoire (-34 % et -36 %).

- Une sous-mortalité pour la plupart des cancers

L'enquête AGRICAN montre que le risque de décéder d'un cancer est respectivement de -27 % et -19 % moins élevé chez les hommes et les femmes de la population agricole que pour le reste de la population française.

En particulier, elle montre une sous mortalité nette pour les cancers liés au tabagisme :

- larynx, trachée, bronches et poumons où la sous mortalité est de -50 % et -40 % pour les hommes et femmes de la cohorte.

- vessie : -42 % et -40 % de risque en moins. Par ailleurs, les femmes de la cohorte ont également moins de risque de décéder d'un cancer du col de l'utérus (-28 %), de l'utérus (-31 %), du sein (-25 %) et de l'ovaire (-11 %).

Cependant, une légère surmortalité est observée pour les mélanomes malins de la peau (+1 % chez les hommes et +6 % chez les femmes). Ce résultat s'explique, en partie, par le travail en plein air des travailleurs agricoles, exploitants et salariés. Enfin, à noter chez les femmes, une tendance à une surmortalité est aussi observée pour les cancers de l’oesophage (+ 8 %), de l’estomac (+ 5 %) et du sang (+ 2 %).

Les raisons qui peuvent expliquer les résultats de l'enquête

- Hygiène de vie : Les exploitants agricoles fument beaucoup moins que le reste de la population française, 76 % des femmes et 42 % des hommes de la cohorte AGRICAN n’ont jamais fumé. Ce facteur de risque très important dans la population générale (il est bien connu maintenant que 50 % des fumeurs réguliers vont mourir à cause de leur tabagisme, par cancers mais aussi par maladies cardiovasculaires ou encore par maladies respiratoires).

- Environnement : A contrario, les facteurs de risque (pesticides, exposition à l'ensoleillement) expliquent très certainement la légère surmortalité par mélanomes malins de la peau.

- Accès aux soins : En règle générale, une prise en charge, précoce des pathologies conditionne favorablement les chances de guérison.

- L'effet du travailleur sain : Cette dernière difficulté est très souvent rencontrée quand on compare la santé d’une population active à celle de la population générale. La population générale est en moins bon état de santé qu’une population active car elle inclue des personnes exclues du travail temporairement ou plus durablement.

Ces premiers résultats présentés le 16 septembre 2011 à Tours lors du Colloque de l'INMA sur le Cancer et Travail en agriculture, seront mis à jour annuellement jusqu'en 2020.

MSA

|

|

|

|

|

|

|

|

|

Chercher un ami dans la foule ou éviter un danger soudain sont deux actions journalières qui reposent sur la qualité de notre attention visuospatiale. Michel Thiebaut de Schotten, chercheur à l'Inserm au centre de recherche en neurosciences de la Pitié Salpêtrière (Inserm, UPMC, CNRS) et ses collaborateurs, décrivent pour la première fois des connexions cérébrales qui prédisent le degré de spécialisation de l'hémisphère droit dans le traitement des informations visuelles et spatiales. Ces données permettraient d'anticiper la récupération des fonctions visuospatiales chez les patients atteints de lésions cérébrales. Ces résultats sont accessibles dans une "brief communication" publiée dans la revue Nature Neuroscience.

Les mesures comportementales et l’imagerie cérébrale ont démontré que l’attention visuospatiale est une fonction spécialisée dans l’hémisphère cérébral droit chez les êtres humains. Néanmoins, les dommages de l'hémisphère gauche observés chez des patients souffrant d'une négligence visuospatiale suggèrent que cette fonction est bilatérale avec une dominance de l'hémisphère droit qui n'avait jusqu'alors jamais été décrite d'un point de vue anatomique.

Michel Thiebaut de Schotten, chercheur à l'Inserm et ses collaborateurs, décrivent les premières caractéristiques anatomiques de la dominance de l'hémisphère droit dans l'attention visuospatiale qui repose sur la capacité de répondre à des tâches telles que chercher quelqu'un, éviter un danger… Pour ce faire, les chercheurs ont scanné le cerveau de participants sains avec une nouvelle technique d’analyse de l’imagerie par résonance magnétique (IRM) qui permet d’explorer les connexions cérébrales. En parallèle, ils ont mesuré le degré de spécialisation de l’hémisphère cérébral droit avec des tests comportementaux.

En combinant ces deux approches, l'équipe de recherche a trouvé des connexions cérébrales dont la taille prédit le degré de spécialisation de l’hémisphère droit pour l’attention visuospatiale. "Nos résultats suggèrent également que, associé à cette spécialisation, le traitement visuospatial se fait à une vitesse différente dans chacun des deux hémisphères cérébraux, explique Michel Thiebaut de Schotten. La taille de ces connexions, ainsi que la vitesse de traitement visuospatial pourraient être des prédicteurs déterminants dans la récupération chez les patients neurolésés souffrant d’une négligence visuospatiale," conclut-il.

INSERM

|

|

|

|

|

|

|

|

|

Les recommandations édictées par le Programme National Nutrition Santé (PNNS) incitent fortement les industriels de l’alimentaire à revoir la formulation de leur produit, en particulier, à réduire les teneurs en sucre, sel et graisse. Quelles conséquences cette réduction a-t-elle sur notre perception du goût, sur nos préférences alimentaires et in fine sur notre consommation ? Les chercheurs du CSGA se sont penchés sur cette épineuse question en s’intéressant spécifiquement aux jeunes enfants. Si la diminution des teneurs en sucre et en matières grasses n’affecte pas la consommation des petits, la teneur en sel, si. Ainsi, plus il y a de sel et plus la consommation de l’enfant est importante.

Lancé en 2001, le Programme national nutrition santé est un plan de santé publique qui vise à améliorer l’état de santé de la population en agissant sur l’un de ses déterminants majeurs : la nutrition. Dans ce plan, neuf objectifs de santé prioritaires ont été définis, complétés par 10 objectifs dits « spécifiques ». Parmi eux, réduire la contribution moyenne des apports lipidiques totaux à moins de 35 % des apports énergétiques journaliers, réduire de 25 % la consommation actuelle en sucres simples, ou encore, réduire la consommation moyenne de sel à moins de 8g par personne et par jour. Si la soustraction est simple sur le papier, dans la pratique, elle implique pour les industriels de l’alimentaire, des reformulations de produits qui – en plus d’être un véritable « casse-tête » technologique – ne sont pas sans impact sur le goût du produit.

Or, pour les enfants, plus encore que pour les adultes, le goût est un facteur d’acceptabilité important. D’où les interrogations des scientifiques du CSGA sur les conséquences des variations de teneur en sel, sucre et matières grasses sur l’acceptation des aliments habituels, par les enfants (30 mois en moyenne).

Au cours d’une étude, conduite en partenariat avec trois crèches dijonnaises, 74 enfants ont consommé un menu fixe tous les 15 jours sur plusieurs semaines. D’un repas à l’autre, la teneur en sel, sucre ou matières grasses variait dans l’un des aliments du repas. Les variations de sel ajouté (0, 0.5 et 1.2 %) et de beurre ajouté (0, 2.5 et 5 %) ont été appliquées à des pâtes et à des haricots verts. Les variations de sucre ajouté (0, 5 et 10 %) ont été appliquées à une compote de fruits non sucrée. La consommation de chaque aliment a été mesurée pour chaque enfant par pesée avant et après le repas.

Les résultats indiquent un impact significatif de la teneur en sel sur la quantité consommée : par comparaison avec la teneur en sel habituelle de 0.6 %, la suppression du sel a entraîné une diminution de consommation des haricots verts, et l’augmentation de la teneur en sel a eu pour conséquence l’augmentation de la consommation de pâtes. En revanche, la modification de la teneur en matières grasses n’a pas eu d’impact sur la consommation des mêmes aliments. De même, la variation de la teneur en sucre dans la compote n’a pas modifié sa consommation.

Ce travail démontre qu’il existe une possibilité de réduction de la teneur en sucre ou matières grasses dans les aliments destinés aux enfants, sans impact négatif sur leur consommation. Concernant la réduction de la teneur en sel, sa mise en œuvre peut s’avérer plus délicate notamment dans des aliments peu appréciés des enfants comme les légumes. Dans ce cas, différentes stratégies sont envisageables : une réduction graduelle, ou une modification des autres caractéristiques sensorielles permettant de compenser la réduction de sel via un changement des matières premières, du mode de cuisson, de la recette,… Ces travaux sont poursuivis en étudiant d’une part l’impact de la teneur en sucre et en matières grasses dans d’autres aliments modèles ; et d’autre part l’impact de la teneur en sel sur la consommation chez des enfants plus âgés, et sur la préférence sensorielle immédiate. Un impact plus important du sel sur la préférence immédiate (telle qu’elle est généralement mesurée dans des études consommateurs) que sur la consommation peut conduire à des teneurs en sucre, sel ou matières grasses supérieures à celles nécessaires à la consommation de l’aliment.

INRA

|

|

|

|

|

|

|

|

|

Relativement rare, le cancer du rein, qui affecte deux fois plus les hommes que les femmes, touche en moyenne 8 500 Français par an. Le plus souvent, il est découvert de façon fortuite suite à un examen d’imagerie médicale. Son pronostic étant lié au stade auquel il est détecté, il est important d’améliorer les méthodes de diagnostic.

C’est dans ce contexte que Michel Chonchol et ses collègues de l’École de médecine de l’Université du Colorado, basée à Aurora, ont découvert que le facteur de croissance FGF-23, produit dans les fibroblastes, pourrait jouer un rôle important pour déterminer les conséquences d’un cancer du rein. En effet, plus la concentration de cette hormone dans le sang est importante, plus le patient a des risques de développer une maladie cardiovasculaire, ou de décéder d’une mort prématurée.

Selon les chercheurs, FGF-23 joue un rôle dans la régulation des produits phosphorés dans l’organisme. En temps normal, quand le rein fonctionne normalement, ces derniers sont éliminés dans l’urée. Lorsque la tumeur empêche l’organe de faire cette excrétion, le taux de produits contenant du phosphore augmente et entraîne de facto une augmentation de 30 à 40 % de l’hormone FGF-23 dans le sang. Cette découverte devrait permettre d’envisager de nouvelles pistes de traitement pour les patients atteints d’un cancer des reins. En effet, en permettant à l’organisme d’éliminer les produits phosphorés, il devrait être possible d’augmenter leur espérance de vie, estiment les chercheurs.

Information Hospitalière

|

|

|

|

|

|

|

|

|

Le bâillement est un phénomène physiologique réflexe permettant une inhalation profonde d'air et souvent associé, parfois à tort, à l'ennui ou à la fatigue. Les causes du bâillement sont encore mal connues mais ce phénomène pourrait plutôt permettre une stimulation de la vigilance. Nous baillons environ 5 à 10 fois dans une journée avec une fréquence accrue au réveil. La dernière étude sur le sujet indique que le bâillement pourrait également jouer un rôle de régulateur thermique pour le cerveau.

En effet, il semble que la fréquence des bâillements varie avec la saison et que les individus baillent moins quand la température extérieure est égale ou supérieure à la température corporelle. Pour en arriver à ces conclusions, la fréquence de bâillement a été observée chez 80 volontaires durant l'hiver (22 degrés en moyenne) et 80 autres durant l'été (37 degrés en moyenne) à Tucson en Arizona. Les résultats indiquent que les températures basses durant l'hiver sont plus favorables au bâillement (environ 50 % des volontaires baillent) par contraste avec l'été quand les températures sont équivalentes ou supérieures à celles du corps humain (moins de 25 % des participants baillent). De plus, le bâillement est associé au temps passé à l'extérieur puisque 40 % des participants baillent dans les 5 premières minutes après leur sortie puis ce pourcentage chute à 10 % ensuite en été alors qu'il augmente en hiver.

L'hypothèse avancée est que le bâillement est induit par l'augmentation de la température du cerveau et sert donc de régulateur thermique en favorisant les échanges d'air avec l'extérieur. Des températures extérieures proches de 37°C ne permettent pas au cerveau de se rafraîchir contrairement aux températures basses de l'hiver. Cette théorie est renforcée par une précédente étude qui montrait une variation de température dans le cerveau de rats avant et après un bâillement. Le refroidissement du cerveau serait alors lié à l'augmentation du flux sanguin engendré par l'étirement de la mâchoire ainsi que grâce à l'échange de chaleur avec l'air ambiant qui accompagne l'inhalation profonde.

Techno-Science

|

|

|

|

|

|

|

|

|

Des chercheurs de l'EPF Zurich ont réalisé une avancée dans la lutte contre le diabète. Ils ont identifié une molécule qui entrave la production d'insuline dans le pancréas. En la désactivant, les personnes diabétiques pourront peut-être un jour produire à nouveau de l'insuline.

Dirigés par Markus Stoffel, les spécialistes de l'Institut de biologie moléculaire des systèmes de la haute école zurichoise ont découvert la fameuse molécule dans les cellules bêta du pancréas. Responsables de la régulation du taux de sucre dans le corps, ces cellules bêta produisent de l'insuline, substance qui incite les cellules du corps à absorber le glucose.

Le diabète se déclare lorsque les cellules bêta meurent ou sont endommagées. Nommée Bace2, la molécule découverte par les chercheurs empêche leur multiplication, indique mercredi l'EPZ Zurich dans son magazine en ligne «ETH Life».

Les chercheurs ont trouvé le moyen de maîtriser la molécule Bace2. Pour cela, ils ont utilisé une substance détenue par les laboratoires du groupe pharma Roche. En utilisant cette dernière sur des souris atteintes de diabète, ils ont réussi à faire multiplier les cellules bêta. Leur taux de sucre s'est amélioré, rapportent les scientifiques dans la revue «Cell Metabolism».

Cette avancée constitue une lueur d'espoir pour les personnes atteintes de diabète. La molécule Bace2 est en effet également présente dans les cellules bêta de l'être humain. Une thérapie destinée à la neutraliser est donc imaginable un jour, même si sa mise au point n'est pas encore pour demain, estiment les chercheurs.

20 minutes

|

|

|

|

|

|

|

|

|

Des scientifiques ont synthétisé des cellules souches, à partir de cellules de peau animales récoltées sur 800 espèces du zoo de San Diego. Ces cellules souches pourraient sauver certaines espèces menacées en favorisant la reproduction assistée et la diversité génétique. Leur croissance démographique en serait démultipliée. L’étude, publiée récemment dans Nature, indique que ces cellules de synthèse permettraient également de traiter les animaux en captivité qui souffrent de diabète. Depuis 1970, Oliver Ryder, directeur du département de génétique au San Diego Zoo Institute for Conservation Research, et ses équipes collectent les cellules dermiques de plus de 800 espèces du zoo de San Diego. Ryder imaginait que cette banque de cellules, nommée « Frozen Zoo », pourrait un jour servir à relancer les processus de diversité génétique chez les espèces menacées, en ouvrant de nouvelles voies à la reproduction assistée.

En 2007, les équipes de l’université de Kyoto, au Japon, et de l’université du Wisconsin à Madison, révèlent que certaines cellules du tissu conjonctif humain, les fibroblastes, peuvent être converties en cellules souches embryonnaires (IPS). Quelques gènes à reprogrammer et le tour est joué. Cette découverte lancera le projet de Ryder, en collaboration avec Jeanne Loring, professeur de neurobiologie au Scripps Research Institute. Pour synthétiser ces cellules souches chez une espèce en voie d’extinction, les chercheurs ont reprogrammé les gènes des cellules dermiques des animaux, alors transformées en cellules souches embryonnaires (IPS). Ces dernières ont généré trois différentes sortes de tissus, qui engendreront à leur tour tous les autres tissus corporels.

Cette opération reste, pour le moment, peu rentable : une manipulation de ce type ne transforme pas suffisamment de cellules dermiques en cellules souches. Les résultats sont suffisants, estiment pourtant les chercheurs. Il suffira de répéter l’opération. “Avant tout, il faut concevoir ces cellules souches de synthèse comme une base de recherche pour les expériences à venir”, précise Jeanne Loring, de The Scripps Research Institute. Les cellules souches sont prisées, elles peuvent être transformées en n’importe quel type de cellules. Pourquoi pas en sperme ou en œufs, ingrédients essentiels pour la reproduction assistée ? Cette technique permettrait d’augmenter le nombre d’individus des espèces menacées.

Les expériences commencèrent avec deux espèces : le primate Mandrillus leucophaeus, dit Drill, et le Ceratotherium simum, connu comme le rhinocéros blanc. Toutes deux en voie d’extinction…Toutes deux désignées pour bénéficier de cette découverte dès maintenant. Le diabète du primate drill, développé en captivité, pourrait être guéri. Ces primates, génétiquement proche de l’homme, profiteraient des traitements développés à la suite des recherches sur les cellules souches humaines. Quant au rhinocéros blanc, l’espèce ne compte plus que sept individus, tous en captivité. Leur population restreinte souffre d’une diversité génétique pauvre et ces animaux ne se reproduisent plus depuis plusieurs années. Les chances de survie de l’espèce sont aujourd’hui très faibles.

“Le meilleur moyen d’enrayer l’extinction est de préserver les espèces et leur habitat, déclare Oliver Ryder, du zoo de San Diego. Mais ce procédé ne fonctionne pas tout le temps. Les cellules souches synthétiques redonnent espoir. Le rhinocéros blanc ne sera peut-être plus une espèce en voie d’extinction, bien qu’il ait complètement disparu de son habitat naturel.”

National Geographic

|

|

|

|

|

|

|

|

|

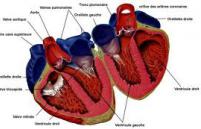

Face à une insuffisance cardiaque chronique (ICC) un tant soit peu sévère, la pharmacothérapie actuelle reste plutôt décevante. Le rapport bénéfice/risque des agents inotropes négatifs actuellement sur le marché est loin d’être optimal, même s’ils peuvent temporairement améliorer la performance systolique du ventricule gauche, mais aussi un état clinique souvent préoccupant. Le prix à payer pour ce succès relatif est une augmentation des concentrations intracellulaires du Ca2+ et de l’AMPc, avec en corollaire un risque élevé de chute tensionnelle voire de collapsus, de troubles du rythme ventriculaire ou encore de décès. Les agents inotropes positifs n’ont qu’un faible impact sur le pronostic vital.

Les activateurs de la myosine cardiaque constituent une classe pharmacologique nouvelle parmi les autres agents inotropes négatifs, en partie du fait de l’absence d’effet sur le Ca2+ et l’AMPc intracellulaires. Le premier représentant de cette classe porte le nom d’omecamtiv mecarbil (OMM). Les résultats obtenus dans les premières études précliniques et cliniques (phase I et II) sont d’ores et déjà encourageants en termes d’efficacité et d’acceptabilité.

Un essai contrôlé de phase II de type croisé mené à double insu contre placebo tend à confirmer ces données. L’OMM a été administré par voie parentérale pendant 2, 24 ou encore 72 heures chez des patients atteints d’une ICC sévère mais stable. L’efficacité a été évaluée à partir des signes cliniques, mais aussi des paramètres hémodynamiques représentatifs de la performance systolique du ventriculaire gauche mesurée au moyen de l’échocardiographie.

Au total, 45 patients ont reçu 151 perfusions d’OMM ou de placebo. Au cours de la phase thérapeutique (versus la phase placebo de l’étude qui est donc du type croisé), les paramètres échographiques (ou autres) suivants ont été améliorés de manière concentration-dépendante, mais aussi significative sur le plan statistique (p<0,0001 pour chaque variable) : temps d’éjection du ventricule gauche, volume d’éjection systolique et fréquence cardiaque. Les concentrations d’OMM les plus élevées ont été associées à des effets hémodynamiques plus marqués, notamment une diminution des volumes ventriculaires, respectivement télésystolique (p=0,0026) et télédiastolique (p=0,0096). Une ischémie myocardique aiguë a été mise en évidence chez deux patients sans doute du fait de concentrations plasmatiques très élevées, respectivement 1 750 et 1 350 ng/ml.

En bref, l’OMM est le premier représentant d’une classe pharmacologique nouvelle : celle des activateurs de la myosine cardiaque. Ce médicament a des effets cliniques et hémodynamiques encourageants, comme en témoignent les résultats de cet essai randomisé croisé mené à double insu contre placebo. Son évaluation mérite d’être poursuivie au travers des études de phase III menées chez des patients atteints d’une ICC stable.

JIM

|

|

|

|

|

|

|

|

|

Des scientifiques au Danemark et en Tanzanie ont découvert que le moustique vecteur du parasite du paludisme perd du terrain dans plusieurs villages. Mais quelle est la raison de ce déclin ? Les experts sont perplexes ; il n'existe aucune mesure de contrôle organisée pour les moustiques, alors comment se fait-il que 99 % des moustiques disparaissent ? Alors que de nombreuses théories pour expliquer ce fait émergent, le manque de données adéquates ne permet pas de déterminer si le paludisme est bel et bien éradiqué ou simplement en état de dormance jusqu'à une prochaine épidémie. L'étude, présentée dans la revue scientifique, Malaria Journal, avait été partiellement financée par l'UE.

«De nombreux autres chercheurs spécialisés dans le paludisme pensent que le déclin survenu en Tanzanie, en Erythrée, au Rwanda, au Kenya et en Zambie, montre que les programmes de contrôle fonctionnent, notamment l'utilisation de moustiquaires», expliquent l'auteur principal, le professeur Dan Meyrowitsch du Département de recherche sur les services de santé de l'université de Copenhague au Danemark.

«Mais ce n'est qu'une partie de l'histoire. Pendant plus de 10 ans, nous avons rassemblé et compté le nombre de moustiques dans les villages de Tanzanie. Le nombre de moustiques capturés est passé de 5 300 en 2004 à juste 14 en 2009, et il s'agit de villages ne disposant d'aucune moustiquaire.»

Le professeur Meyrowitsch suggère que 99 % de la diminution de la population de moustiques dans la dernière partie des années 1990 est associée à une diminution des précipitations, ajoutant qu'elle avait été déclenchée par le changement climatique. «De 2003 à 2009, le volume des précipitations était plus stable, mais les pluies étaient plus chaotiques et il pleuvait même en dehors de la saison des pluies», explique-t-il. «Cela aurait perturbé le cycle naturel du développement des moustiques. Bien évidemment, nous sommes très heureux que le nombre d'enfants victimes de la maladie ait considérablement diminué ces cinq ou six dernières années, mais nous avons besoin d'en comprendre la raison.»

L'équipe fait remarquer que l'utilisation de moustiquaires peut être interrompue, mais qu'il convient de déterminer si les moustiques ont été enrayés par une maladie ou parce que les communautés ont utilisé des pesticides ou encore si cette diminution résulte des schémas chaotiques des précipitations. «À moins de trouver la réponse, nous ne pourrons pas prévoir une prochaine apparition de moustiques», explique le professeur Meyrowitsch, «et cela pourrait rapidement être nécessaire».

L'équipe pense que l'absence d'exposition à la maladie depuis 2005 entraîne le développement d'une immunité au parasite pour les adultes et les enfants. La ré-émergence des moustiques signifierait la présence d'une épidémie de paludisme avec de nombreux décès à moins que la population et les représentants officiels n'y soient préparés.

Des scientifiques du département de santé, d'immunologie et de microbiologie internationales, du département de la santé publique et du département de biologie des maladies vétérinaires de l'université de Copenhague, ainsi que des chercheurs de l'institut national de recherche médicale en Tanzanie ont contribué à l'étude.

CORDIS

|

|

|

|

|

|

|

|

|

La revue Nature a publié les résultats d'une étude menée par des chercheurs de l'Institut de recherche de l'Hôpital d'Ottawa (IRHO), de l'Université d'Ottawa, de la firme Jennerex et d'autres partenaires. Les premiers essais sur des humains montrent que le virus JX-594 peut infecter des cellules cancéreuses et se propager aux autres cellules atteintes, sans toucher aux tissus sains. « C'est vraiment une avancée importante, et tous les gens qui ont participé à cette étude le croient fortement », confie le Docteur Jean-Simon Diallo, chercheur postdoctoral senior impliqué dans le projet.

En étant administré par intraveineuse, le virus JX-594 peut atteindre des cellules cancéreuses, peu importe leur localisation dans le corps du patient, ce qui était auparavant impossible. « Pour des gens qui ont des métastases, on peut atteindre ces métastases-là sans injecter directement dans la tumeur », explique le Docteur Diallo. Y-a-t-il, grâce à cette découverte, des espoirs de survie pour des patients qui autrement seraient condamnés ? « Absolument », croit le Docteur Diallo.

Les premiers essais ont été réalisés sur 23 patients, dont sept de l'Hôpital d'Ottawa. Leur cancer était à un stade avancé, s'était propagé à plusieurs organes et ne répondait pas aux traitements conventionnels. Pour sept des huit patients ayant reçu les plus fortes concentrations du virus, celui-ci s'est reproduit dans les tumeurs, sans toucher aux tissus sains. Pour six de ces huit mêmes patients, « les tumeurs avaient rétréci ou s'étaient stabilisées », souligne l'IRHO. Les effets secondaires ont été limités à des symptômes grippaux légers ou modérés pendant moins de 24 heures.

Scientifique principal à l'IRHO, le Docteur John Bell et son équipe effectuent des recherches sur des virus oncolytiques depuis plus de dix ans. Pour le Docteur Diallo, c'est une fierté de s'être joint à ces chercheurs. « Je suis à la fin de mes études postdoctorales, j'ai commencé à travailler sur ce projet-là il y a quatre ans, et j'ai développé la méthode de détection du virus dans les échantillons des patients, explique-t-il. Je suis heureux que ce soit grâce à ce protocole qu'on ait pu détecter le virus dans les tissus des patients. »

Cette première phase avait comme principal objectif d'évaluer la sécurité du virus et l'impact de l'administration par voie intraveineuse. Créé à partir d'une souche du virus de la vaccine (utilisé contre la variole), JX-594 doit maintenant faire l'objet de nouvelles phases d'étude, pour tester le virus sur un plus grand nombre de patients. Il est difficile, pour l'instant, de prédire à quel moment un véritable traitement pourrait être conçu grâce au JX-594, si les résultats des prochains essais sont concluants. « Pour l'instant, c'est encore relativement préliminaire, [...] mais si on se base sur les résultats qu'on a, je dirais que ça pourrait devenir réalité d'ici cinq ans », a mentionné le Docteur Diallo.

Cyberpresse

|

|

|

|

|

|

|

|

|

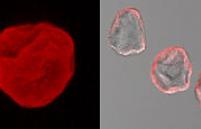

Multiplier par plus de 100 l’efficacité réelle de la transformation des cellules de peau de souris en cellules souches, tel est le résultat exceptionnel d’une équipe de recherche de l'Institut de génétique humaine de Montpellier du CNRS, à laquelle ont collaboré des chercheurs de l'Inra. Deux techniques sont couplées pour y parvenir : l'injection de quatre gènes bien spécifiques dans le noyau des cellules de peau de souris puis leur incubation dans un extrait d’œufs de grenouille Xénope. Ces résultats confirment l'intérêt des cellules souches issues de cellules différenciées pour réaliser des autogreffes et ouvrent des perspectives thérapeutiques intéressantes en termes de médecine régénératrice. Ils viennent d’être publiés dans la revue des PNAS.

En 2006, des chercheurs japonais ont fait une avancée spectaculaire : ils sont parvenus à déprogrammer des cellules différenciées de souris en cellules souches en injectant un cocktail de quatre gènes. Cependant, la production de ces cellules souches dites induites (iPS) reste peu efficace et leur déprogrammation loin d'être totale.

''Comme pour un ordinateur, si l'on veut repartir à zéro, l'idéal est de désinstaller entièrement le système avant d'en installer un nouveau'', explique Marcel Méchali, directeur de recherche à l'Institut de génétique humaine de Montpellier du CNRS. Son équipe a réussi à multiplier l'obtention de ces cellules souches iPS par un facteur de plus de 100. Pour cela, Olivier Ganier chercheur au sein de cette équipe, a fait pénétrer dans des cellules de peau de souris le cocktail de quatre gènes mais aussi des extraits d’œufs de Xénope, une grenouille africaine bien connue des chercheurs. L'intérêt de ces œufs d'amphibiens réside dans la facilité à en obtenir de grandes quantités, au contraire des ovocytes de mammifères. Avec ces deux traitements, le noyau est doublement déprogrammé, même si ce n'est pas encore total. Autre avantage : l'extrait a permis de déprogrammer d'autres voies que, seul, le cocktail de gènes ne permet pas encore. Reste maintenant à identifier les composants présents dans les extraits d’œufs capables d'effacer l'identité des cellules différenciées.

Les scientifiques ont également testé les propriétés de reprogrammation de ces cellules iPS ''doublement déprogrammées''. Ils ont injecté dans des embryons de souris blanches des cellules iPS ''doublement déprogrammées'' provenant de souris noires. Des individus au pelage métissé ont été obtenus, prouvant que ces cellules iPS se sont différenciées en cellules de la peau. Ces chimères (organisme porteur de deux ou plusieurs génotypes différents) ont par la suite donné naissance à des souriceaux entièrement blancs mais aussi entièrement noirs démontrant ainsi que certains noyaux des cellules iPS ''doublement déprogrammées'' se sont aussi différenciés en noyaux de cellules sexuelles.

Ces travaux confirment les potentialités des cellules iPS dans le domaine de la médecine régénératrice. Capables de se redifférencier dans n'importe quelle voie tissulaire, les cellules iPS pourraient demain permettre le remplacement des cellules malades ou détruites par une greffe de cellules du patient et reconstruire ainsi un organe ou tissu lésé par une maladie ou un accident, sans problème de rejet.

INRA

|

|

|

|

|

|

|

|

|

Stimuler la vascularisation du cœur en créant de nouveaux vaisseaux (angiogenèse) et en favorisant leur maturation (artériogenèse) avec l’aide de facteurs de croissance angiogéniques, représente un mode de traitement prometteur à l’essai dans les maladies cardiaques. Comme les essais cliniques fondés sur l’administration d’un seul facteur pro-angiogénique n’ont pas montré les bénéfices attendus, les chercheurs de l’unité INSERM 644 « Pharmacologie des dysfonctionnements endothéliaux et myocardiques » de Rouen ont mis au point une stratégie affinée.

Ebba Brackenhielm et ses collaborateurs ont tout d’abord déterminé une combinaison de facteurs pro-angiogéniques capables de stimuler l’artériogenèse pour aboutir à la création d’artères matures. In vitro, comparée à l’utilisation d’un seul facteur de croissance, l’association de FGF-2 et de HGF stimule davantage la migration et la prolifération de cellules animales et humaines. L’effet de cette formulation s’est confirmé in vivo chez la souris, avec la formation de vaisseaux fonctionnels et stables sur des cornées.

Les facteurs pro-angiogéniques ont ensuite été inclus dans des microcapsules de biopolymères (tels que l’alginate) permettant une libération contrôlée. « L’utilisation des microcapsules permet une diffusion locale lente et une protection des facteurs de croissance. Ils sont alors 3 à 6 fois plus actifs pour induire l’angiogenèse que des facteurs non encapsulés. »

Cette thérapie angiogénique a été mise à l’épreuve sur un modèle d’infarctus chez le rat. Les microcapsules contenant les facteurs de croissance ont été injectées dans le muscle cardiaque. On observe que cela améliore la circulation du sang, permet l’oxygénation du myocarde et prévient ses dysfonctionnements. Le remodelage ventriculaire post-infarctus est atténué.

« Notre thérapie pourrait constituer une nouvelle approche pour la prévention de l’insuffisance cardiaque. Elle pourrait s’adresser notamment aux patients atteints de maladies coronariennes qui répondent mal aux traitements classiques pharmaceutiques et chirurgicaux, ou aux patients qui développent une insuffisance cardiaque », conclut Ebba Brakenhielm.

INSERM

|

|

|

|

|

|

|

|

|

Après avoir réussi à reconstituer un épiderme à partir de cellules souches embryonnaires, les chercheurs d’I-Stem sont parvenus à lui donner sa couleur en obtenant in vitro des mélanocytes fonctionnels, ces cellules qui pigmentent la peau et la protègent des rayons UV. Des travaux financés notamment grâce aux dons du Téléthon.

En 2009, les chercheurs de l’Institut I-Stem, dirigé par Marc Peschanski, ont réussi à reconstituer un épiderme à partir de cellules souches pluripotentes d’origine embryonnaire. Forte de ces résultats, l’équipe du Docteur Christine Baldeschi (I-Stem), vient de franchir une nouvelle étape en obtenant in vitro avec la même stratégie des cellules qui pigmentent la peau et la protègent des rayons UV, les mélanocytes. Cette ressource cellulaire illimitée pourra à terme être proposée aux personnes atteintes de troubles de la pigmentation de la peau, d’origine génétique ou non, tels que le Vitiligo ou encore l’albinisme.

L’équipe du Docteur Baldeschi a obtenu des mélanocytes fonctionnels en identifiant le procédé de différenciation permettant de transformer des cellules souches d'origine embryonnaire (hES) ou induites à la pluripotence (iPS), en mélanocytes capables de produire de la mélanine et de la transférer aux kératinocytes, cellules qui constituent l’épiderme. Ainsi, ces mélanocytes fonctionnels communiquent parfaitement avec les autres cellules de l'épiderme.

AFM

|

|

|

|

|

|

|

|

|

Une équipe de l’Inserm s’est entretenue avec 7 000 personnes atteintes d’un cancer, deux ans après leur diagnostic. Objectif de l'étude : savoir comment les patients recherchent de l’information médicale, et déterminer ainsi des profils différents.

Dites-moi pourquoi vous recherchez de l'information médicale, et je vous dirai quel patient vous êtes... Voilà en résumé, l'objet d'une étude Inserm, menée en partenariat avec la Direction de la recherche, des études, de l'évaluation et des statistiques (DREES), auprès de patients atteints de cancer. Les chercheurs ont contacté environ 7 000 personnes qu'ils ont convoquées à des entretiens très détaillés.

Des centaines de questions leur ont été posées. En vrac : l'argent, le pouvoir d'achat, la santé, le soutien des proches, etc. Surtout, les chercheurs ont voulu savoir comment s'était déroulée l'annonce du diagnostic, quelles réponses ils ont obtenues de l'équipe médicale, et comment ils s'y sont pris pour se renseigner sur leur maladie, et sur leur traitement.

Les résultats ont permis de distinguer quatre profils de patients :

Les non-chercheurs d'information : C'est le plus gros contingent de patients. La tendance générale ! Ils représentent 72,6 % des patients. Et comme leur nom l'indique, ces personnes ne cherchent pas d'informations complémentaires sur Internet. Ils se contentent au mieux de ce qu'ils lisent dans la presse et les médias, au pire d'un second avis médical.

Les chercheurs typiques : Ils ont confiance en leur médecin généraliste, qui reste leur principale source d'information. Mais cela ne les empêche pas de se documenter ailleurs, notamment dans les médias, type Internet. Ils n'hésitent pas non plus à entrer en contact avec des patients ou des associations de malades du cancer. Bref, ils multiplient les sources d'informations, et peuvent parfois demander un second avis médical avant de démarrer le traitement.