|

|

|

|

|

| NUMERO 1225 |

|

|

|

|

|

|

|

Edition du 29 Septembre 2023

|

|

|

|

|

Edito

Face au changement climatique, une meilleure gestion de l'eau devient un enjeu majeur pour la planète

Notre planète, dont 97 % de l'eau est salée, produit un flux d'eau douce renouvelable de 42.800 milliards de mètres cubes par an, soit 16 200 litres par personne et par jour, près de quatre fois la consommation des habitants des Etats-Unis, selon des données de la FAO. En prélevant environ 4300 milliards de mètres cube d'eau douce en 2020, l'Humanité consommait environ le dixième des ressources renouvelables disponibles.

Les prélèvements d'eau douce destinés aux activités humaines (agriculture, industrie et usages domestiques) ont été multipliés par six au cours du siècle dernier, soit deux fois plus vite que le taux de croissance démographique, et par deux en moins de 50 ans dans le monde. Avec 648 milliards de m³, l'Inde est le pays qui prélève le plus d'eau, devant la Chine (592 milliards de m³), les États-Unis (444 milliards de m³), l'Indonésie (223 milliards de m³) et le Pakistan (200 milliards de m³).

L'Union européenne prélève quant à elle 197 milliards de m³. Dans ce classement, l'Italie arrive en tête (34 milliards de m³), devant la France (32 milliards de m³), l'Espagne (31,2 milliards de m³), et l'Allemagne (24,5 milliards de m³). Les prélèvements d'eau ont baissé d'environ 20 % en France depuis trente ans. Ils sont à comparer aux 200 milliards de m³ de pluies dites “utiles” (Sur 510 milliards de m³ de précipitations annuelles totales) qui vont finalement alimenter les réserves en eau douce du pays.

Plus de la moitié des grands plans d’eau naturels et artificiels dans le monde ont vu leur volume se réduire au cours de ces trois dernières décennies, sous l’effet du changement climatique et des activités humaines, principalement l’irrigation agricole et la production d’énergie, selon une étude parue dans Science en mai dernier. En intégrant à leur recherche les volumes stockés dans les réservoirs artificiels importants, les auteurs soulignent que les baisses nettes cumulées atteignent 21,51 gigatonnes (Gt) par an (avec une incertitude de plus ou moins 2,54 Gt), soit l’équivalent de toute la consommation en eau des USA. Ce sont donc 602 milliards de mètres cubes (m³) d'eau qui se sont évaporés, et ne sont plus allés alimenter les rivières épuisées (Voir Science Daily).

Le dernier rapport du WWF, sorti début août, montre que chaque année, le stress hydrique affecte en moyenne 20 % du territoire européen et 30 % de la population européenne. Cette étude révèle qu’en France 72 % des nappes phréatiques étaient sous les normales mensuelles. La pluie, bien qu'abondante dans certaines régions au Printemps, n’a pas permis de recharger les nappes qui soutiennent les débits de rivières et les usages (agriculture, industries...). Ce rapport montre également que, dans le sud de l'Europe, déjà soumis à un stress hydrique, les terres agricoles et les zones irriguées ont augmenté depuis dix ans (Voir WWF).

Selon les conclusions de la Conférence Mondiale de l'eau qui s'est tenue en mars dernier, le Monde fait désormais face à un risque de 40 % de déficit en eau douce d’ici 2030, avec des pénuries graves dans les régions aux ressources déjà limitées. Sous l’effet cumulé du changement climatique, de la surexploitation des ressources et du manque d’infrastructures modernes de distribution et de traitement, la pénurie d'eau touche déjà 700 millions de personnes dans 43 pays et, avant la fin de cette décennie, ce sont 1,8 milliard de personnes, soit près d’un quart de l’Humanité, qui vivront dans des pays ou régions touchés par une pénurie d'eau complète.

Parmi les pistes proposées pour surmonter cette situation alarmante, les auteurs proposent de réduire drastiquement les fuites et d’instaurer une gouvernance plus transparente et plus démocratique de l’eau, comme cela est par exemple le cas dans certaines régions de l’Espagne, qui ont su instaurer une véritable gestion collective de l’eau, pour mieux faire face à une situation chronique de stress hydrique. L’Espagne recycle déjà 15 % de son eau et en recyclera un tiers dès 2027. En Aragon, région durement touchée par une sécheresse récurrente, les agriculteurs situés sur un territoire de plus de 80 000 hectares de terres irriguées de la Communauté général du canal de Bardenas ne peuvent pas utiliser l’eau comme ils veulent. Chaque saison, ils sollicitent une autorisation d’irriguer. Un volume d’eau est attribué à chacun pour ses cultures, en fonction des capacités de prélèvements des sites.

Dans de nombreux autres pays en situation de stress hydrique, les attrape-brouillard ou collecteurs de brouillard, connus depuis des siècles, sont en plein essor. Ces systèmes ingénieux sont constitués de filet sen mailles serrées, tendu entre deux poteaux face au vent et au brouillard, sur des pentes de montagne. Par condensation, des gouttelettes se forment sur les mailles jusqu'à former un filet d'eau qui est recueilli dans des réservoirs. Un collecteur de brouillard d’une surface de collecte de 10 m², produit en moyenne 50 litres par jour tout au long de l'année. Largement utilisés dans des pays andins, comme le Chili, le collecteur de brouillard a également fait son apparition dans certaines régions du sud du Maroc. L’autre avantage de ce dispositif est son coût réduit, qui va de 100 à 1500 euros, en fonction de la taille du filet. Enfin ces systèmes nécessitent peu d’entretien.

En Israël, un pays à la pointe pour le recyclage et l’utilisation économique de l’eau, les exploitations agricoles utilisent souvent un mélange d’eaux souterraines et d’eaux usées recyclées provenant de la station d’épuration locale. Les eaux usées, utilisées à des fins domestiques, sont traitées puis transférées aux agriculteurs, ce qui permet d’entretenir une agriculture florissante en plein désert. En France, la société AWA, située à Saint-Malo, a développé une fontaine qui transforme l’air en eau potable. Le fonctionnement de cette machine est simple : un générateur aspire l’air et le fait passer dans un premier filtre afin d’éliminer les particules de poussière. L’air change ensuite d’état par le principe de la condensation et se transforme en eau. Une succession de sept filtrations élimine toutes les bactéries et impuretés. L’eau, dont le PH est neutre, est alors consommable. Plusieurs de ces fontaines ont été installées avec succès dans une école de Nairobi, au Kenya, et de nombreux pays en développement se sont montrés intéressés par cette innovation remarquable.

Une société française, basée près de Montpellier, BIO-UV, a développé une borne photovoltaïque de distribution d’eau potable baptisée Bio-Sun. Ce système utilise un panneau solaire photovoltaïque fixé sur une borne mesurant 1,20 m de haut. Celle-ci intègre un filtre, une lampe UV et une batterie reliée au panneau photovoltaïque. Il suffit de remplir la borne avec de l’eau non potable L’eau transite ensuite à travers un filtre sur zéolithe, qui permet de supprimer les matières en suspension. La lampe UV vient enfin décontaminer près de 99,9 % des bactéries présentes dans cette eau filtrée. Ce système peut traiter et rendre potable 500 litres par heure et a été conçu pour fonctionner environ 4 heures par jour. La borne Bio-Sun peut donc délivrer 2 m³ d’eau potable par jour, ce qui correspond aux besoins quotidiens de près de 80 personnes d’après l’OMS. On comprend mieux l’intérêt de ces deux innovations quand on sait qu’en Afrique, quatre habitants sur dix n’ont pas un accès correct à l’eau potable.

La France prélève en moyenne 32,3 milliards de m³ d’eau par an, qui est pour l’essentiel restituée dans les milieux aquatiques après utilisation. Au sein de ce volume, un sixième (5,3 milliards de mètres cubes d’eau), ne retourne pas dans la nature (c'est la consommation nette d'eau) et est utilisé pour l'eau courante que nous buvons, pour l'agriculture, l’élevage, l’industrie et la production d’énergie. Les deux tiers de cette eau consommée sont captés dans le sous-sol, dans des sources ou des nappes profondes. Le tiers restant est issu des eaux de surfaces, fleuves, rivières ou lacs. Au total, la consommation d’eau est d’environ 85 m³ d'eau par habitant et par an, soit 234 litres d’eau par personne et par jour.

En France, on estime qu’un milliard de m³ sont perdus chaque année. Dans les fuites du réseau de distribution, ce qui représente l’équivalent de la consommation annuelle de 18 millions de personnes. Sachant que le renouvellement d’un km de canalisation d’eau coûte entre 150.000 et 800.000 euros, il faudrait en remplacer 1,2 % au moins par an pour améliorer l’état du réseau. Or, dans la réalité, le taux de remplacement atteint 0,8 % au mieux, ce qui explique le taux de fuite élevé. Heureusement, plusieurs innovations technologiques vont permettre à l’avenir d’aller vers une gestion prédictive du réseau en détectant de manière précise et précoce ces fuites qui engendrent un énorme gaspillage de la ressource en eau. Une société corse, ACWA Robotics, a obtenu trois récompenses au dernier CES de Las Vegas en janvier dernier, dans la catégorie "Villes connectées" pour son robot explorateur. Ce cylindre articulé est capable de parcourir jusqu’à trois km par jour dans les canalisations pour vérifier leur état et établir une cartographie précise du réseau. Bientôt, le Pathfinder pourra aussi réparer les fuites de l’intérieur.

La start-up Osiris, fondée par trois fils d’agriculteurs, a développé un tracteur autonome, capable d’irriguer jusqu’à 20 hectares par jour, tout en augmentant de 10 % le rendement sur des parcelles de pommes de terre à quantité d’eau constante. Ces économies sont obtenues grâce à un système de compilation de données agronomiques au sein des parcelles, associé à un outil d’IA et à des caméras qui détectent le stade de croissance de la plante, et des capteurs qui mesurent l’humidité du sol.

Le plan annoncé récemment par le gouvernement vise à organiser une nécessaire sobriété, optimiser la disponibilité et préserver la qualité de l’eau, et pouvoir répondre aux crises comme les sécheresses de l’an passé amenées à se multiplier dans un contexte de réchauffement climatique. Premier axe de ce plan, faire des économies d’eau. Le changement climatique pourrait nous priver d’un tiers de l’eau disponible en France à l’horizon 2050. Face à cette perspective, tous les secteurs d’activités sont invités à faire des propositions visant à réduire leur consommation d’eau dans les mêmes proportions. Le deuxième axe concerne la lutte contre les fuites qui sont un véritable fléau, avec 20 % de pertes. Le plan prévoit 180 millions d’euros pour résorber les fuites de 170 points noirs et sécuriser l’approvisionnement des 2000 communes à risques de pénurie estivale. Les réseaux seront progressivement équipés de compteurs intelligents d’ici 10 ans.

Troisième axe, la réutilisation des eaux usées. Dans ce domaine, la France est le mauvais élève de l’Europe avec moins de 1 % de l’eau usée réutilisée. Le plan prévoit de passer à 10 % d’ici à 2030, soit 300 millions de m³. Pour tenir cet objectif, l’utilisation d’eau réutilisée ou d’eau de pluie récupérée doit devenir la norme partout où c’est possible. Le quatrième axe concerne la planification de l’usage de l’eau. Le secteur agricole, qui consomme 60 % de l’eau, devra programmer une baisse de sa consommation qui passera notamment par une adaptation des cultures aux nouvelles conditions climatiques et la généralisation d’une gestion numérique intelligente des ressources en eau dévolues à l’agriculture. Enfin le dernier axe vise à généraliser le principe de la tarification progressive, afin d’inciter à la sobriété : les premiers mètres cubes resteront facturés à un prix modeste, mais au-delà d’un certain niveau de consommation, qui ne correspond plus à un usage sobre de l’eau, le prix du m³ sera plus élevé.

Dans le prolongement de ce plan, un décret simplifiant les procédures de réutilisation des eaux usées traitées (REUT) a été promulgué le 30 aout dernier. Ce décret très attendu vise à permettre l’utilisation des eaux sortant des stations d'épuration pour certains usages non-domestiques, qui consomment aujourd'hui de l'eau potable, comme le nettoyage des voiries ou l'arrosage des espaces verts. Le décret supprime également l’'autorisation pour avoir recours à l’eau de pluie pour ces usages.

Par arrêté préfectoral du 31 juillet, le préfet de la Gironde, Étienne Guyot, a autorisé l’alimentation de l’usine Etex France Building Performance, producteur de plaques de plâtre à Saint-Loubès, près de Bordeaux, par les eaux traitées de la station d’épuration de la commune. Il s’agit de la première autorisation de ce type en Gironde. Ce sont ainsi 50 000 m³ d’eaux résiduaires urbaines, représentant 50 % de la consommation du site, qui se substitueront à l’eau potable actuellement utilisée dans le procédé.

D’autres solutions innovantes ont déjà été mises en place dans le département de la Haute-Loire. L’exploitation du GAEC du Lavandin sur la commune d’Auzon a mis en place un dispositif de récupération des eaux pluviales de toiture du bâtiment d’élevage de 900 m². Les eaux sont collectées pré-filtrées puis stockées dans une citerne souple de 120m³. Ces eaux sont utilisées pour abreuver les vaches allaitantes et génisses dans les pâturages extérieurs. La commune d’Yssingeaux a mis en place deux cuves enterrées pour la récupération des eaux pluviales de toitures. Cette eau de pluie stockée permet l’arrosage des massifs même lors de périodes de sécheresse. À Limoges, l'Office International de l’Eau réutilise l'eau de pluie depuis plus de dix ans. Sur la toiture du bâtiment accueillant l'organisme, une cuve de deux mètres cubes est installée. L'eau y est filtrée, désinfectée, avant de venir remplir les chasses d'eau des toilettes, pour une centaine d'utilisateurs par jour.

En Ardèche, département classé en territoire prioritaire en ce qui concerne l'économie d'eau, le Département et la Préfecture ont organisé des Assises de l'eau. : Fin juillet, Thierry Devimeux, préfet de l'Ardèche, et Olivier Amrane, président du Département, ont présenté la feuille de route des économies à venir avec un objectif : 20 % de prélèvements en moins d'ici 2030. Au total, 31 mesures ont été décidées, la Préfecture effectuera le suivi de ces politiques.

Le ministre de la Transition écologique et de la Cohésion des territoires, Christophe Béchu, a annoncé le 21 août les 50 premiers sites industriels lauréats du “Plan eau”, ce qui leur permet d'être accompagnés dans leur réduction de consommation d'eau. Parmi ces sites, on trouve celui de Seqens à Aramon, dans le Gard. Il s’agit d’un site polyvalent de production de principes actifs pour l’industrie pharmaceutique. Seqens y produit également des polymères et des lipides destinés à la production de médicaments. Il y a deux ans, un projet de construction d’un nouvel atelier de production de principes actifs hautement actifs a été lancé. Des technologies de type tours adiabatiques de refroidissement ont été installées pour réduire les consommations en eau de refroidissement sur ce nouvel atelier. Ces tours permettent de refroidir l’eau réchauffée, afin de la réinjecter dans le système de refroidissement. La nouvelle unité de fabrication est ainsi en boucle fermée et fait recirculer toujours la même eau, ce qui permet de réduire le prélèvement d’eau provenant du milieu naturel. Seqens envisage à terme d’étendre à l’ensemble de ses installations ce système de refroidissement adiabatique, utilisant uniquement des eaux recyclées. Autre exemple intéressant, les Pépinières Javoy, dans le Loiret, ont mis en place un circuit fermé, complété par deux bassins de 8000 m³, qui permet d’économiser jusqu’à 80 % d’eau.

La société parisienne Leakmited a conçu, pour sa part, un algorithme d’intelligence artificielle capable de localiser en amont les zones potentiellement sensibles aux fuites sur un réseau d’eau. Élaborée pour des collectivités et des entreprises privées, l’innovation permet de lutter contre le gaspillage de cette ressource précieuse. L’outil a déjà été testé et approuvé en France par les communes de Besançon ou encore Rouen. Une autre entreprise, Kipopluie, spécialisée dans la récupération et la gestion des eaux de pluie, propose des solutions complètes pour récolter et filtrer l’eau qui s’écoule des toitures. Ces dernières peuvent ensuite être revalorisées pour des usages non-potables (toilettes, arrosage des toitures végétalisées et espaces verts, lavage des véhicules ou le refroidissement des panneaux photovoltaïques). Ce réemploi permet de réduire sa consommation d’eau issue du réseau de 50 à 70 %.

Soulignons enfin que l’eau douce directement disponible pour les plantes, les animaux et l’homme ne représente qu’environ 1 % du total de l’eau sur Terre… Le reste de cette eau douce liquide est stockée dans le sol et le sous-sol de notre planète. Ainsi, l’eau souterraine est une eau invisible, qui est piégée dans les espaces entre les grains du sol et des roches, dans les pores, les fissures ou les fractures des roches. De nouvelles techniques de géophysique, reposant notamment sur l’analyse fine du champ électromagnétique renvoyé par le sous-sol et la détection de certaines particules subatomiques, comme les muons, vont permettre, d’ici quelques années, d’évaluer de manière précise, de manière dynamique (en 4D) ces immenses ressources en eau souterraine, encore mal connues. Il deviendra alors possible d’intégrer toutes ces données géophysiques dans de nouveaux outils de modélisation et de gestion de cette eau souterraine, ce qui constituera un formidable bond en avant dans la gestion prévisionnelle de ces gisements d’eau diffus, mais essentiels pour notre avenir.

On le voit, ces innovations et exemples récents montrent qu’il est tout à fait possible de réduire, à terme, de moitié, notre consommation nette d’eau, à efficacité économique et confort domestique équivalents. Nous y serons de toute manière contraints pour nous adapter aux conséquences inéluctables du réchauffement climatique et nous avons donc intérêt à prendre les devants et anticiper de manière concertée et intelligente, en mettant en place une nouvelle gestion prédictive, transparente et écologique de l’ensemble de nos réserves en eau, qu’il s’agisse des eaux de surface, ou des eaux souterraines, sans oublier bien sûr la réutilisation massive des eaux recyclées, qui doit devenir la règle. Mais toutes ces avancées technologiques, numériques et robotiques prometteuses ne pourront pas tout. Face à l’accélération du changement climatique dont nous avons tous pu constater l’ampleur en cette fin d’été qui a été le plus chaud jamais enregistré, nous allons également repenser de nouveaux modes de gestion et de gouvernance de l’eau plus démocratiques et plus équitables, afin de fixer des hiérarchies et priorités claires entre les différents usages et de permettre à tous de pouvoir continuer à accéder dans les générations à venir à des ressources en eau suffisantes et de qualité…

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

e-mail : tregouet@gmail.com

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

Retenez bien son nom car ce nouveau programme d'intelligence artificielle pourrait bien révolutionner la biologie et la génétique. Baptisé AlphaMissense, ce modèle d'apprentissage automatique développé par DeepMind (Google), est capable de prédire si un variant manquant du génome humain est susceptible de causer une maladie, avec une précision de 90 %. Ce type de variant est une modification d’une seule lettre du code génétique qui peut entraîner la fabrication d’un acide aminé différent au sein d’une protéine.

Les mutations dites "manquantes" sont particulièrement difficiles à étudier. En effet, il y a 71 millions de variants manquants possibles dans le génome humain et, en moyenne, chaque personne en porte plus de 9.000. Parmi les 4 millions qui ont été repérés chez l’homme, seulement 2 % ont été classés comme pathogènes ou bénins. AlphaMissense s’appuie sur AlphaFold, un autre modèle de DeepMind qui prédit les structures de protéines à partir de leur composition en acides aminés. Ce nouvel outil, en revanche, fonctionne plus comme un grand modèle linguistique, formé sur le langage de la biologie humaine et des primates. « Si nous substituons un mot dans une phrase en anglais, une personne familiarisée avec l’anglais peut immédiatement voir si ces substitutions vont changer ou non le sens de la phrase », précise Jun Cheng, co-auteur de l'étude, qui ajoute, « AphaMissense agit un peu de la même manière, mais pour les séquences d’acides aminés dans les protéines ».

AlphaMissense attribue un score de "pathogénicité" entre 0 et 1 pour chaque variant manquant possible, en fonction de ce qu’il sait sur les effets d’autres mutations étroitement liées. Ce score aide les chercheurs à prioriser les études de mutations génétiques et à accélérer la recherche dans divers domaines, de la découverte de médicaments au traitement du cancer. Le modèle pourrait également améliorer notre compréhension des zones négligées de notre code génétique. Par exemple, il inclut une « métrique d’essentialité » pour chaque gène, une mesure de son importance pour le maintien de la vie.

Le modèle pourrait en particulier aider les médecins à diagnostiquer rapidement les enfants suspectés de maladies génétiques. Ewan Birney, directeur général adjoint du Laboratoire européen de biologie moléculaire, voit AlphaMissense comme « un meilleur moyen de classer ces cas », en permettant aux professionnels de la santé de s’assurer qu’ils livrent le bon traitement. Au-delà du travail de démêlage des effets des mutations uniques, AlphaMissense confirme l'immense potentiel des modèles d’IA en biologie et en sciences du vivant.

Article rédigé par Georges Simmonds pour RT Flash

Science

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

COESA est une entreprise italienne spécialisée dans le photovoltaïque industriel. Basée à Turin, elle propose ses services non seulement aux professionnels, mais aussi aux particuliers et aux collectivités publiques. Pour favoriser l’économie circulaire dans le domaine des énergies renouvelables, elle a récemment dévoilé un prototype de tour solaire. L’infrastructure se trouve dans les locaux mêmes de la start-up et comprend une unité de stockage d’énergie à base de sable.

La particularité de cette tour photovoltaïque qui fait près de 36 m de haut est qu’elle utilise des panneaux solaires usagés. Au total, ceux-ci peuvent théoriquement générer une puissance de 250 kW. Selon les explications de COESA, le fait de les installer à la verticale procure un gain d’espace considérable. Ce gain est d’environ 90 % de plus, en comparaison avec une installation conventionnelle. Quant au choix de recourir à des panneaux solaires usagés, il découle d’une volonté de favoriser la réutilisation plutôt que le recyclage dans la mesure où de nombreux équipements sont souvent remplacés avant même qu’ils n’arrivent en fin de vie.

D’après COESA, compte tenu de son faible taux d’occupation du sol, la tour solaire serait idéale pour un système agrivoltaïque. En ce qui concerne la solution de stockage d’énergie mise en œuvre, c’est-à-dire la batterie au sable, il convient de noter qu’il ne s’agit pas réellement d’une nouveauté. L’idée consiste à utiliser l’électricité produite par les panneaux pour chauffer le sable et porter sa température à environ 500°C. Cette chaleur pourra ensuite être libérée pour le chauffage ou convertie en électricité par l’intermédiaire d’une turbine.

Avec ce système innovant, l’entreprise compte pouvoir produire de l’énergie verte à un coût relativement faible. D’ailleurs, elle a déjà construit un prototype de batterie au sable à échelle réduite, afin de mieux évaluer les performances de ce mode de stockage et fournir d’éventuelles améliorations. « Des systèmes comme celui que nous développons peuvent être intégrés directement dans les réseaux de chaleur pour stocker la chaleur et la libérer en cas de besoin. C’est une solution 10 fois moins chère qu’une batterie au lithium qui stocke la même quantité d’énergie. Cela fait de Turin l’endroit idéal pour sa mise en œuvre, car c’est la ville avec le réseau de chaleur le plus étendu d’Europe », a expliqué Matteo Stoppa, Directeur de l’Innovation chez COESA.

Article rédigé par Georges Simmonds pour RT Flash

SEN

|

|

|

|

|

|

|

|

|

Des chercheurs de l’Université de Cordoue et du Max Planck Institute for Solid State Research en Allemagne ont mis au point une batterie solaire innovante, fabriquée à partir d’un matériau abondant, non toxique et facilement synthétisé : le nitrure de carbone 2D.

Le monde connaît un essor rapide de l’énergie solaire. L’optimisation de la technologie solaire pour maximiser la capture de la lumière, sa conversion en énergie et sa mise à disposition pour répondre aux besoins énergétiques est essentielle dans la transition écologique vers une utilisation plus durable des sources d’énergie.

Dans le processus allant de la collecte de la lumière par le panneau solaire à l’utilisation à la demande de l’énergie par, par exemple, les appareils ménagers, le stockage joue un rôle crucial. L’énergie solaire est en effet intrinsèquement intermittente. Pour faciliter ce processus de stockage et répondre à des problèmes tels que l’impact environnemental de l’extraction, du recyclage ou de la rareté de certains matériaux nécessaires aux batteries conventionnelles (comme le lithium), le concept de "batterie solaire" est né.

Les batteries solaires combinent les cellules solaires qui capturent la lumière et le stockage de son énergie en un seul dispositif, permettant ainsi l’utilisation de l’énergie quand cela est nécessaire. Alberto Jiménez-Solano, chercheur au département de physique de l’Université de Cordoue, en collaboration avec une équipe du Max Planck Institute for Solid State Research (Stuttgart, Allemagne), a mené une étude où il a exploré les caractéristiques de conception d’une batterie solaire fabriquée à partir d’un matériau à base de nitrure de carbone 2D.

« Dans le groupe du Professeur Bettina V. Lotsch, à l’Institut Max Planck, ils avaient réussi à synthétiser un matériau capable d’absorber la lumière et de stocker cette énergie pour une utilisation ultérieure à la demande », explique Alberto Jiménez-Solano, « et l’idée nous est venue de l’utiliser pour créer une batterie solaire ». Pour ce faire, l’équipe a d’abord dû trouver un moyen de déposer une fine couche de ce matériau (carbonitrure de potassium 2D, poly(heptazine imide), K-PHI) pour créer une structure stable permettant de commencer la fabrication d’un dispositif photovoltaïque, ce matériau se trouvant généralement sous forme de poudre ou en suspensions aqueuses de nanoparticules.

Grâce à ce travail préliminaire, ils ont pu présenter ce design de batterie solaire où, en combinant des simulations optiques et des expériences photo-électrochimiques, ils sont en mesure d’expliquer les caractéristiques de la haute performance de ce dispositif lors de la capture de la lumière du soleil et du stockage de l’énergie. La structure physique du dispositif consiste en « un verre à haute transparence, qui possède un revêtement conducteur transparent (pour permettre le transport de charge), et une série de couches de matériaux semi-transparents (avec différentes fonctionnalités), et un autre verre conducteur qui ferme le circuit », décrit le chercheur. Il s’agit essentiellement d’une sorte de sandwich composé de différentes couches dont les épaisseurs ont été étudiées pour maximiser à la fois le niveau d’absorption de la lumière et le stockage.

Article rédigé par Georges Simmonds pour RT Flash

eseuro

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Dans de nombreuses petites communes en France, les eaux usées sont traitées grâce à des techniques sobres, souvent des filtres plantés de roseaux. Loin de l’image d’une lubie d’écologistes isolés, ces techniques équipent plus de 5 000 stations d’épuration sur le territoire.

Les pénuries d’eau de plus en plus fréquentes – et sévères – qui nous alertent sur la disponibilité des ressources en eau accentuent leur vulnérabilité aux pollutions industrielles, agricoles et domestiques. Pour protéger ces ressources indispensables, il faut adapter nos systèmes de production sur le long terme, éviter le gaspillage et réduire à la source l’émission de polluants (nitrates, phosphates et résidus médicamenteux et cosmétiques notamment).

Mais il faut aussi à plus court terme traiter les effluents générés par les activités humaines, en particulier les eaux usées domestiques provenant de nos cuisines, salles de bain et toilettes. Ces traitements sont encadrés par la loi à l’échelle européenne et nationale, accompagnée d’arrêtés qui fixent les objectifs de traitement et les seuils de rejet. Ils sont mis en place dans des stations d’épuration mettant en œuvre, selon les caractéristiques du territoire, des procédés intensifs ou plus sobres (dits également "extensifs") mais dont le principe de fonctionnement repose essentiellement sur l’activité de bactéries qui ingèrent de nombreux polluants.

L’objectif du traitement des eaux usées est de les rendre moins polluantes, mais aussi de régénérer des ressources : lorsque la réglementation le permet, l’eau traitée peut être valorisée dans des usages domestiques ou pour l’irrigation par exemple. D’autres ressources à haute valeur ajoutée peuvent être extraites, comme les nitrates et les phosphates, utilisables comme fertilisants.

Les territoires urbains densément peuplés utilisent des stations d’épuration collectives intensives de capacité de traitement élevée adaptée aux forts volumes d’eaux usées qu’ils génèrent. Leur efficacité tient à des consommations élevées en énergie, en réactifs, et en équipements compacts relativement sophistiqués.

Les territoires ruraux ou semi-ruraux ont des contraintes d’espace moindres et optent soit pour des techniques d’assainissement non collectives (fosses septiques notamment), soit pour des stations d’épuration collectives de capacité de traitement réduite adaptée au nombre d’habitations raccordées. Les stations d’épuration de capacité de traitement équivalent à 2 000 habitants ou moins, représentent plus de 80 % du nombre total de stations. Parmi celles-ci, plus de la moitié (59 %) sont des stations intensives basées sur les mêmes principes que leurs cousines des grandes villes. Le reste est représenté par des stations dites extensives, moins sophistiquées que les stations intensives et avec des coûts d’investissement et d’exploitation plus faibles, mais qui garantissent des performances d’épuration poussée. Les filtres plantés de roseaux représentent plus de 50 % du nombre de ces stations extensives, le reste étant constitué par des lagunes ou autres types de techniques.

Les systèmes d’épuration par filtres plantés de roseaux sont des « solutions basées sur la nature », c’est-à-dire que leur principe de fonctionnement est inspiré de celui d’écosystèmes naturels : les marais. Ils présentent de nombreux atouts techniques : de bonnes à très bonnes performances d’épuration, notamment vis-à-vis des matières en suspension, de la charge organique et azotée. Ce procédé écologique présente en outre un niveau de technicité modéré dont la mise en œuvre et la maintenance sont compatibles avec les moyens humains, techniques et financiers mobilisables par les petites communes. Autre avantage, une consommation énergétique et en réactifs plus faible que celle des stations intensives.

Enfin, les filtres plantés de roseaux peuvent reproduire les fonctions écosystémiques des zones humides naturelles qu’ils émulent – marais, tourbières, mares, mangroves. En effet, grâce à leur position particulière à l’interface des trois milieux physiques de la planète (eau, terre, air), ils abritent une biodiversité considérable, régulent les transferts hydriques et la température grâce au phénomène d’évapotranspiration… et contribuent à l’épuration des eaux.

L’efficacité d’épuration des filtres plantés de roseaux, leur niveau modéré de sophistication technique, leur faible coût d’exploitation et d’investissement, et leur excellente intégration paysagère, sont les atouts majeurs de ce système d’épuration extensif qui offre en outre d’autres fonctions écosystémiques au-delà de leur fonction épuratoire principale. Mais ces systèmes sont appelés à évoluer pour s’adapter aux pollutions émergentes et aux exigences croissantes d’épuration.

Article rédigé par Georges Simmonds pour RT Flash

The Conversation

|

|

|

|

|

|

|

|

|

En plein cœur de l'Iran, le thermomètre dépasse souvent les 40 degrés. Mais ces températures extrêmes restent supportables grâce aux tours à vent, les ancêtres écologiques de la climatisation, qui intéressent de nouveau les architectes. Située non loin de la Route de la soie, Yazd est l'une des villes les plus chaudes au monde. Entourée de deux déserts, ses étés sont brûlants et les pluies extrêmement rares. Ses habitants ont appris à s'y adapter. Avec des méthodes inventées il y a plus de 2.500 ans, au temps où l'empire perse dominait le Moyen-Orient.

Yazd est « le témoignage vivant de l'utilisation intelligente des ressources disponibles limitées nécessaires à la survie dans le désert », résume l'Unesco, qui l'a inscrite dès 2017 sur la liste du Patrimoine mondial. Cette cité de 530.000 habitants est « une source d'inspiration pour la nouvelle architecture confrontée aux défis de la durabilité », ajoute cette organisation de l'ONU.

Yazd est notamment réputée pour ses quelque 700 badguirs ("attrape vent" en persan), des tours traditionnelles et élégantes qui surmontent les toits plats du centre historique. « Les badguirs ont joué un rôle capital dans la prospérité de la ville. Durant des siècles, avant l'invention de l'électricité, elles ont permis de rafraîchir les logements. Grâce à elles, les gens vivaient à l'aise », explique Abdolmajid Shakeri, responsable du ministère du Patrimoine pour la province de Yazd. Similaires à des cheminées droites à quatre côtés, les badguirs sont dotées de grandes fentes verticales et de plusieurs conduits à l'intérieur. Elles laissent entrer le moindre souffle d'air frais dans le logement tandis que, sous la pression, l'air chaud est poussé à en sortir. Cette méthode de réfrigération est « totalement propre car elle n'utilise ni électricité ni matériaux polluants », souligne Majid Oloumi, directeur du jardin de Dowlat-Abad, où se situe une badguir de 33 mètres, la plus haute au monde.

Cet exemple d'architecture bioclimatique inspire un nombre croissant d'architectes dans le monde, comme le Franco-Iranien Roland Dehghan Kamaraji, basé à Paris, qui a longuement étudié le fonctionnement des badguirs. Elles « démontrent que la simplicité peut être un attribut essentiel de la durabilité, démentant l'idée répandue que les solutions durables doivent nécessairement être complexes ou high-tech », défend-il.

Parmi les projets les plus représentatifs, il cite celui de la Masdar City, aux Émirats arabes unis, dont « les bâtiments sont conçus pour tirer parti de la ventilation naturelle pour le refroidissement, à l'instar des badguirs ». A Melbourne, en Australie, le Council House 2 est aussi un immeuble au système de refroidissement passif, comme le Eastgate Centre à Harare (Zimbabwe), qui « s'inspire des termitières, une démarche similaire à celle des badguirs ».

Article rédigé par Georges Simmonds pour RT Flash

Le Figaro

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

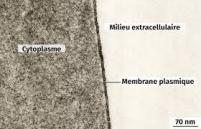

S’inspirant des systèmes sensoriels naturels, une équipe de recherche dirigée par le MIT a conçu un capteur sans équivalent, capable de reconnaître les mêmes molécules que les récepteurs cellulaires. Cette réalisation, qui conjugue plusieurs technologies de pointe, pourrait bien changer la donne dans le dépistage précoce des maladies, y compris les cancers et autres affections sévères. Une des caractéristiques remarquables de cette innovation repose sur le fait qu’elle tire son inspiration de la membrane qui entoure toutes les cellules. Au sein de ces membranes, des milliers de protéines réceptrices détectent les molécules présentes dans l’environnement.

L’équipe du MIT a modifié certaines de ces protéines pour qu’elles puissent survivre hors de la membrane, les ancrant dans une couche de protéines cristallisées au-dessus d’un réseau de transistors en graphène. Lorsque la molécule cible est détectée dans un échantillon, ces transistors transmettent l’information à un ordinateur ou à un smartphone. Ce type de capteur pourrait potentiellement être adapté pour analyser n’importe quel fluide corporel, qu’il s’agisse de sang, de larmes ou de salive, selon les chercheurs. De plus, il pourrait également être utilisé pour effectuer simultanément un dépistage de plusieurs cibles, en fonction du type de protéines réceptrices utilisées. Il s’agit d’une nouvelle étape majeure vers le développement d’un système qui pourrait être utilisé pour effectuer des dépistages réguliers de cancers ou de tumeurs métastatiques difficiles à diagnostiquer.

En 2018, les chercheurs du MIT, dont Shuguang Zhang et Rui Qing, ont dévoilé une méthode innovante pour transformer les protéines hydrophobes en protéines solubles dans l’eau. Cette approche, appelée code QTY, consiste à remplacer quelques acides aminés hydrophobes par des acides aminés hydrophiles. La capacité à rendre les protéines solubles dans l’eau et à les produire en grandes quantités à moindre coût est l’un des éléments distinctifs de leur approche. Les chercheurs, dont le professeur émérite de l’Université de Ressources Naturelles et des Sciences de la Vie de Vienne, Uwe Sleytr, ont utilisé des protéines bactériennes, connues sous le nom de protéines S-layer, pour créer une feuille très dense d’une version soluble dans l’eau d’une protéine réceptrice appelée CXCR4.

Cette protéine se lie à une molécule cible appelée CXCL12, qui joue un rôle important dans plusieurs maladies humaines, dont le cancer. La technologie de détection ainsi obtenue a été baptisée RESENSA (Receptor S-layer Electrical Nano Sensing Array). Ces couches S cristallisées peuvent être déposées sur pratiquement n’importe quelle surface. Pour cette application, les chercheurs ont fixé la couche S sur une puce comportant des réseaux de transistors à base de graphène, que le laboratoire de Tomás Palacios, du MIT, avait précédemment développés.

Mantian Xue, doctorant au MIT, a adapté la puce pour qu’elle puisse être revêtue d’une double couche de protéines – des protéines S-layer cristallisées fixées à des protéines réceptrices solubles dans l’eau. Lorsqu’une molécule cible de l’échantillon se lie à une protéine réceptrice, la charge de la cible modifie les propriétés électriques du graphène, ce qui peut être facilement quantifié et transmis à un ordinateur ou à un smartphone connecté à la puce. Grâce à l’utilisation du code QTY, il est désormais possible de modifier les protéines réceptrices naturellement existantes pour créer un éventail de capteurs dans une seule puce, capable de détecter pratiquement n’importe quelle molécule que les cellules peuvent identifier.

Les chercheurs travaillent actuellement à améliorer la stabilité des protéines, en particulier pour des conditions extrêmes de température et de pH, afin que les capteurs soient plus robustes et plus fiables dans diverses situations. De plus, ils se concentrent également sur le développement de méthodes pour produire ces capteurs en masse à un coût abordable.

Article rédigé par Georges Simmonds pour RT Flash

EurekAlert

|

|

|

|

|

|

|

Cette étude américaine réalisée en double aveugle, dirigée par la Dr Tara Sanft, professeure au Yale Cancer Center, a montré de manière claire que l'adoption d'un mode de vie sain pendant la chimiothérapie, par les femmes atteintes d'un cancer du sein, joue un rôle important dans l'amélioration des résultats des chimiothérapies.

En effet, 53 % des femmes ayant adopté le plan recommandé en matière de régime et d'exercice ont présenté une réponse pathologique complète (disparition des cellules cancéreuses invasives dans le sein), contre seulement 28 % des femmes du groupe témoin, n'ayant pas changé leurs habitudes. « Cette étude montre de manière solide que le régime alimentaire et l'exercice influencent positivement les résultats de la chimiothérapie par le biais de facteurs autres que juste l'achèvement du traitement », explique la Pr Melinda Irwin qui a supervisé les essais.

Article rédigé par Georges Simmonds pour RT Flash

Asco

|

|

|

|

|

|

|

|

|

Lorsque le cancer du sein est diagnostiqué à un stade précoce, le taux de survie est de près de 100 %. Cependant, pour les tumeurs détectées à des stades ultérieurs, il chute à environ 25 %. Pour améliorer les chances de survie des patientes, des chercheurs du MIT ont conçu un dispositif d'échographie portable pouvant détecter les tumeurs mammaires de manière précoce.

Cet échographe, qui ressemble à un patch flexible, peut être facilement attaché à un soutien-gorge. Il permet à la personne qui le porte de déplacer facilement la sonde à ultrasons sur le sein et d'obtenir des images du tissu mammaire sous différents angles. « Nous avons changé la forme de la technologie des ultrasons afin qu'elle puisse être utilisée chez vous. Il est portable et facile à utiliser, et fournit une surveillance en temps réel et conviviale du tissu mammaire », explique Canan Dagdeviren, professeur agrégé au Media Lab du MIT et auteur principal de l'étude.

Les tests réalisés ont montré que l'appareil offrait des images échographiques avec une résolution comparable à celle des sondes à ultrasons utilisées dans les centres d'imagerie médicale. Par exemple, les chercheurs ont pu détecter des kystes d'une taille aussi petite que 0,3 cm de diamètre – ce qui correspond à la taille des tumeurs à un stade précoce – chez une femme de 71 ans. Ils ont également démontré que les tissus pouvaient être échographiés jusqu'à une profondeur allant jusqu'à 8 centimètres.

L'idée de ce dispositif a été motivée par une expérience personnelle tragique du professeur Canan Dagdeviren. Alors qu'il était au chevet de sa tante Fatma Caliskanoglu, qui a reçu un diagnostic de cancer du sein à un stade avancé à 49 ans malgré des dépistages réguliers, il a pris conscience de la nécessité de développer un moyen de détecter plus précocement les tumeurs mammaires.

Sa tante est malheureusement décédée six mois plus tard, renforçant sa détermination à améliorer les chances de survie des patientes touchées par un cancer d'intervalle comme sa tante. Il s'agit des tumeurs mammaires qui se développent entre les mammographies régulières. Elles représentent 20 à 30 % des cas de cancer du sein. De plus, elles ont tendance à être plus agressives que celles trouvées lors des examens de routine. « Mon objectif est de cibler les personnes les plus susceptibles de développer un cancer d'intervalle », explique le Professeur Dagdeviren. « Avec un dépistage plus fréquent, notre objectif est d'augmenter le taux de survie jusqu'à 98 % », assure-t-il.

Article rédigé par Georges Simmonds pour RT Flash

Science Advances

|

|

|

|

|

|

|

|

|

Une étude conduite par des chercheurs du Brigham and Women's Hospital de Boston a montré sur 104 patients que le traitement de l’hypertension à l’aide d'un nouveau siRNA thérapeutique, le zilebesiran, administré par voie sous-cutanée, permettait une baisse sensible et durable de la pression artérielle, plus de six mois après la fin du traitement.

Il s’agit d’un ARN double brin. L’un des brins est couplé à un sucre, la N-acétylgalactosamine (GalNAc) qui protège ces ARN très fragiles et qui se lie avec une très forte affinité au niveau hépatique. Le deuxième brin va se fixer sur une zone particulière de l’ARN pour empêcher la synthèse du peptide précurseur de l’angiotensine, l'angiotensinogène. En découle une suppression de la production d'angiotensine I et II, ce qui entraîne une baisse de la pression artérielle durable.

Les études de phase I avec le zilebesiran ont montré un effet à long terme, avec une réduction de l'angiotensinogène circulant de >90 % pendant 6 mois après une dose sous-cutanée unique (800 mg), le pic de réduction de l'angiotensinogène circulant survenant après environ 3 semaines.

Des réductions durables de la pression artérielle (PA) ont également été observées, la PA systolique ambulatoire sur 24 heures étant réduite de >15 mm Hg huit semaines après l'administration d'une dose unique de zilebesiran (800 mg). En outre, le zilebesiran a été bien toléré, avec seulement des réactions légères à modérées au site d'injection (n=5/56) et aucun événement indésirable grave lié au traitement, pas d’hypotension ou d’altération significative de la fonction rénale ou hépatique.

« En termes de bénéfices, l’effet est continu, le zilebesiran permet de réduire les médicaments et induit moins de variabilité de la réponse tensionnelle. En revanche, l'ARN interférent agit lentement, de sorte que le zilebesiran ne serait pas adapté pour les personnes présentant une urgence hypertensive.

Article rédigé par Georges Simmonds pour RT Flash

NIH

|

|

|

|

|

|

|

|

|

La durée d'une activité physique et/ou sportive peut-elle avoir un impact sur les risques d'apparition d'un cancer ? Telle est la question que se sont posée des chercheurs australiens dans une étude publiée dans la revue JAMA Oncology. 2023. Selon ces derniers, pratiquer une activité physique d'une courte durée, de l'ordre de 4,5 minutes par jour, réduirait les risques de plusieurs cancers, foie, côlon, sein, de 32 %.

Pour arriver à ce constat, les scientifiques ont analysé les données provenant de dispositifs portables permettant de suivre l'activité quotidienne de 22.398 adultes se déclarant non sportifs. Ensuite, les chercheurs ont suivi les dossiers de santé du groupe pendant près de sept ans afin de surveiller l'apparition de cancers. Résultat ? Les auteurs de l'étude ont constaté qu'en général, une activité physique d'une durée de 3,4 à 3,6 minutes par jour a été associée à une réduction de 17 % à 18 % du risque total de cancer. De plus, une activité d'une durée de 4,5 minutes par jour était associée à une réduction de 31 % à 32 % du risque de cancer.

« Il est tout à fait remarquable de constater que l'augmentation de l'intensité des tâches quotidiennes pendant seulement quatre à cinq minutes par jour, en courtes périodes d'environ une minute chacune, est liée à une forte réduction globale du risque de cancer », explique le professeur Stamatakis, auteur principal de l'étude. Les auteurs de l'étude précisent néanmoins que d'autres recherches sont nécessaires pour confirmer le lien entre la pratique d'une activité physique et/ou sportive de courte durée et l'apparition d'un cancer. « Nous devons encore étudier ce lien dans le cadre d'essais solides, mais il semble que cela puisse être une recommandation prometteuse et gratuite pour réduire le risque de cancer chez les personnes pour qui l'exercice structuré est difficile ou peu attrayant », a déclaré le scientifique.

Article rédigé par Georges Simmonds pour RT Flash

Jama Network

|

|

|

|

|

|

|

|

|

Auparavant, les microsphères atteignaient le foie via un long tube inséré dans l'aine, ce qui nécessitait une hospitalisation d'une nuit et comportait un risque accru d'hémorragie interne. De plus, les patients devaient rester allongés pendant plusieurs heures pour prévenir les dommages aux vaisseaux sanguins de la région pelvienne.

Grâce à cette nouvelle procédure, les patients peuvent rentrer chez eux seulement deux heures après l'intervention, ce qui leur évite une convalescence douloureuse à l'hôpital. Le Docteur Pavan Najran, radiologue d'intervention consultant au Christie NHS Foundation Trust de Manchester, qui a réalisé cette intervention, espère que d'autres hôpitaux adopteront bientôt cette méthode. Environ 6 000 personnes sont diagnostiquées chaque année au Royaume-Uni avec un cancer du foie, dont la majorité a plus de 60 ans. Bien que certaines affections augmentent le risque de développer un cancer du foie, environ la moitié des cas sont liés à des facteurs liés au mode de vie, tels que l'obésité et le tabagisme.

La radiothérapie interne sélective (SIRT) est utilisée pour traiter le cancer du foie en injectant directement des microsphères dans les vaisseaux sanguins qui alimentent les tumeurs du foie. Cette méthode cible spécifiquement les cellules cancéreuses, réduisant ainsi le risque d'endommager les organes voisins. La procédure traditionnelle utilisait un cathéter inséré dans l'artère fémorale de l'aine, mais cette nouvelle technique, utilisant l'artère radiale du poignet, a démontré une réduction significative des complications possibles. Heather Norgrove, 74 ans, qui a bénéficié de cette intervention, témoigne de son succès. Ayant d'abord été traitée pour un cancer de la peau en 2013, elle a malheureusement vu la maladie réapparaître au foie. Après avoir subi la procédure traditionnelle, elle a pu expérimenter la méthode via le poignet, qui s'est avérée être une expérience beaucoup plus agréable et moins contraignante.

Article rédigé par Georges Simmonds pour RT Flash

Daily Mail

|

|

|

|

|

|

|

|

|

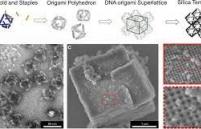

Des chercheurs de l'université du Connecticut (UConn) ont récemment mis au point un matériau extraordinairement solide et léger à partir d'ADN et de verre. Ces scientifiques rapportent qu'en construisant une structure à partir d'ADN et en la recouvrant ensuite de verre, ils ont produit un matériau très résistant doté d’une très faible densité. « Pour une densité donnée, notre matériau est le plus solide connu », a assuré Seok-Woo Lee, spécialiste des matériaux à l'UConn.

Comme il est difficile de créer de grands morceaux de verre sans défaut, les chercheurs ont commencé par de très petits morceaux sans défaut, d’une épaisseur inférieure à un micromètre. L'équipe de chercheurs a ensuite mis au point une structure d'ADN auto-assemblée et l'a recouverte d'une très fine couche de ce verre, épaisse de quelques centaines d'atomes seulement.

L'ADN a renforcé la fine couche de verre, ce qui a rendu le matériau très solide, tandis que les espaces vides constituant la majeure partie du volume l'ont rendu léger. Résultats : les experts ont obtenu des structures de nano-réseaux de verre dont la résistance est quatre fois supérieure à celle de l'acier, mais dont la densité est cinq fois inférieure.

« La possibilité de créer des nanomatériaux à structure 3D à l'aide de l'ADN et de les minéraliser ouvre d'énormes perspectives en matière d'ingénierie des propriétés mécaniques. Mais de nombreux travaux de recherche sont encore nécessaires avant que nous puissions l'utiliser en tant que technologie », a déclaré Oleg Gang, scientifique spécialiste des nanomatériaux à l'université Columbia et au Centre des nanomatériaux fonctionnels de Brookhaven, qui a participé à l'étude.

Les scientifiques prévoient maintenant de tester l’expérience avec d’autres types d’ADN afin d'explorer d'autres résultats et, éventuellement, concevoir un matériau du même genre encore plus résistant. Alors que les techniques de métallurgie traditionnelles ont atteint leurs limites ces dernières années, les matériaux légers et solides sont aujourd'hui largement plébiscités dans de nombreux domaines. Ils rendent par exemple les gilets pare-balles plus légers, les appareils médicaux plus performants et les voitures et avions plus sûrs et plus rapides.

Article rédigé par Georges Simmonds pour RT Flash

Cell

|

|

|

|

|

|

|

|

|

Les émissions mondiales de CO2 provenant de la production de pâte à papier ont atteint 168 millions de tonnes en 2020, selon International Energy Agency. Des chiffres inquiétants, qui poussent les scientifiques à chercher des modes de production moins polluants, tout en restant attractifs pour les industriels.

Une équipe de l’université de Caroline du Nord (Etats-Unis) travaille depuis 2018 sur une technique qui pourrait porter ses fruits. En modifiant génétiquement les arbres grâce à la technique Crispr, les chercheurs obtiennent une augmentation des capacités de production allant jusqu’à 40 %, tout en réduisant de 10 à 20 % le potentiel de réchauffement global de l’industrie (facteur qui permet de rendre compte de l’impact de la production sur le réchauffement climatique). Ces résultats prometteurs ont été publiés dans la revue Science. Rodolphe Barrangou, professeur à l’université de Caroline du Nord et co-auteur de l’étude, y retrace le parcours de la fibre de bois, vers un papier plus écoresponsable.

La méthode Crispr-Cas 9 est une stratégie d’édition génomique qui vise à supprimer ou corriger un gène. Aussi appelée "ciseaux moléculaires", cette méthode consiste à couper une portion d’ADN grâce à des enzymes spécifiques, puis faire muter l’ADN, pour mettre en avant certains caractères, ou en supprimer, sans ajout extérieur. La française Emmanuelle Charpentier et l'Américaine Jennifer Doudna ont reçu le prix Nobel de chimie 2020 pour avoir inventé cette méthode, aujourd’hui bénéfique à l’agriculture, la médecine et l’industrie.

« Aujourd’hui, il faut deux tonnes de bois pour produire une tonne de papier », explique l’auteur. La raison de ce déséquilibre ? « L’ingrédient qui donne au bois sa longévité à travers les siècles est aussi ce qui rend problématique sa transformation », poursuit-il. Cet ingrédient n’est autre que la lignine, une fibre particulière qui se lie à la cellulose et autres composantes du bois pour le rendre résistant aux éléments… et donc à toute transformation chimique ! Pour créer de la pâte à papier à partir de bois, il faut d’abord ramollir la fibre avec de nombreux produits chimiques polluants. La production d’une tonne de pâtes à papier génère près de sept tonnes de liqueur noire, une substance composée d’eau, de résidus de lignine et d’hémicelluloses, mais surtout de composés inorganiques utilisés lors de la dissolution, ce qui la rend particulièrement nuisible une fois rejetée dans l’environnement. En plus d’être extrêmement polluant, ce processus nécessite beaucoup d’énergie, et devient vite très coûteux pour les industriels.

« Ce qui est intéressant avec l’édition génomique, c’est qu’on peut vite passer du travail de recherche à une réalité plus tangible », se réjouit Rodolphe Barrangou, « l’appliquer aux forêts, c’est toucher tout le monde ». Grâce à une intelligence artificielle, les chercheurs ont pu déduire sept stratégies différentes de modification du génome de peuplier, parmi près de 70.000 stratégies possibles. Leur objectif est alors de modifier le génome de la lignine, et augmenter le taux de glucide, pour rendre la fibre de bois moins rigide. « Nous avons réussi à moduler la teneur en lignine tout en restant dans des valeurs naturelles », précise le chercheur, qui ne souhaite pas dénaturer les espèces. Ce travail d’édition génomique a permis de réduire jusqu’à 49,1% la teneur en lignine et augmenter le rapport glucides-lignine du bois jusqu'à 228 % par rapport au type sauvage.

« Avec une fibre plus malléable, il faut moins de bois pour produire la même quantité de pâte, moins d’énergie, moins de produits chimiques, et on libère moins de produits secondaires indésirables comme la liqueur noire, tout en augmentant le potentiel de production des usines », conclut l’auteur. Une technique prometteuse pour l’environnement et les industries, mais qui doit encore subir des tests en environnement non-contrôlé, pour une mise sur le marché d’ici… 2038. « On a l’étincelle, mais on ne peut pas faire ça tout seul, il faut l’aide d’un collectif scientifique, et surtout des institutions », insiste l’auteur face aux réticences de certains pays envers l’édition génomique. En proposant un assouplissement des règles sur les organismes génétiquement modifiés, la Commission européenne ouvre la voie aux techniques d’édition génomique sans transgenèse (transfert de génome entre espèces), comme la méthode Crispr.

Article rédigé par Georges Simmonds pour RT Flash

Science

|

|

|

|

|

|

|

|

|

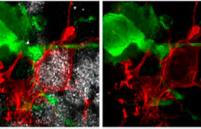

Les cellules humaines sont capables de migrer dans l’organisme. Dans l’embryon, ces migrations sont critiques pour la mise en place des organes. Chez l’adulte, seules quelques cellules gardent cette capacité de migration, comme les cellules de l’immunité qui patrouillent dans le corps pour combattre les infections. Cependant, dans la progression cancéreuse, des cellules tumorales initialement immobiles trouvent le moyen de se disséminer et d’établir des métastases à distance de la tumeur primaire. C’est à ce stade-là que les cancers deviennent particulièrement dangereux. Ils ne sont plus opérables et nécessitent des traitements par chimiothérapie.

Les scientifiques se sont intéressés à la machinerie de la migration cellulaire, c’est-à-dire à l’ensemble des machines moléculaires qui s’emboîtent grâce à des rouages et qui permettent aux cellules d’avancer. Nous savons globalement comment ces machines moléculaires permettent à la cellule de faire un pas, mais pas comment elles sont coordonnées pour lui permettre de "marcher". Or c’est la persistance du processus, c’est-à-dire la répétition des pas qui permettent aux cellules de migrer efficacement et aux cellules tumorales de se disséminer. Dans cette étude, les scientifiques ont recherché toutes les protéines se fixant à une machine moléculaire de migration essentielle, de manière différentielle quand les cellules marchent ou ne font qu’un pas. Cette approche a permis d’identifier PPP2R1A, le produit d’un gène muté dans divers cancers gynécologiques : sein, endomètre et ovaire. Ce gène est requis pour la persistance de la migration, mais il n’est pas nécessaire pour faire un pas unique.

Les scientifiques ont ainsi compris que PPP2R1A va changer un des rouages de la machine moléculaire, comme lorsqu’on embraye dans une boîte de vitesse. Lorsque le mode persistant est enclenché, la protéine active de la machine se libère d’un carcan inhibiteur pour permettre des pas successifs. Pendant ce temps-là, sa place va être occupée au sein du carcan par une protéine qui lui ressemble. Cette protéine qui lui ressemble va vraisemblablement lui permettre de retrouver sa place quand la marche est terminée.

Les scientifiques ont montré que PPP2R1A ne régule la persistance de migration que si ce mécanisme de machinerie alternative était enclenché. Sans ce mécanisme, la marche s’arrête tout de suite et la cellule n’enchaîne pas les pas. Les scientifiques ont cependant réussi à forcer la cellule à marcher sans ce mécanisme, mais dans ce cas il est nécessaire de donner une nouvelle impulsion à chaque pas. De manière importante, les mutations trouvées dans les tumeurs de patientes abrogent la capacité de PPP2R1A à réguler la persistance de migration. A l’avenir, il sera nécessaire d’en apprendre plus sur les mécanismes de régulation des machines moléculaires de migration afin d’identifier des moyens d’intervention pour empêcher la dissémination des cellules tumorales dans l’organisme.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

|

|

|

|

|

|

|

Pour la première fois, une équipe composée de chercheuses et chercheurs de l’Institut Pasteur, de l’Inserm et de l’AP-HP, avec le soutien de l’ANRS | Maladies infectieuses émergentes, a investigué et mis en évidence l’implication d’anticorps neutralisants, y compris ceux dits à large spectre, dans le contrôle du virus. Un essai clinique qui intègre l’utilisation d’anticorps neutralisants à large spectre devrait être initié en France avant fin 2023.

Connus sous le terme de ‘contrôleurs post-traitement’, de rares personnes porteuses du VIH-1 et ayant bénéficié d’un traitement précoce maintenu pendant plusieurs années ont la capacité de contrôler le virus sur le long terme à l’arrêt de leur traitement. Ces personnes ont été identifiées il y a plusieurs années grâce notamment à l’étude VISCONTI, la plus grande cohorte de personnes contrôlées post-traitement à long terme. Les mécanismes de ce contrôle permettant une rémission durable de l’infection VIH-1 sans traitement antirétroviral ne sont pas entièrement élucidés mais l’identification de ces cas offre une opportunité unique de les comprendre plus précisément.

Une étude, menée par l’unité Immunologie humorale à l’Institut Pasteur dirigée par le Docteur Hugo Mouquet, en collaboration avec l’équipe du Docteur Asier Sáez-Cirión, directeur de l’unité Réservoirs viraux et contrôle immunitaire à l’Institut Pasteur, contribue aujourd’hui à décrire davantage ces mécanismes. Comme l’explique Asier Saéz-Cirión, « En étudiant la réponse immunitaire des personnes contrôlées post-traitement en 2020, nous avions fait un premier grand pas en démontrant la mise en place chez certains de ces individus d’une réponse immunitaire efficace et robuste contre le virus qui pourrait contribuer à ce contrôle. Aujourd’hui, notre nouvelle étude fait encore progresser cette connaissance.

« En étudiant le rôle des anticorps chez un cas particulier de ‘contrôleur post-traitement’ présentant un taux particulièrement haut d’anticorps neutralisants à large spectre, nous avons découvert que la rémission était probablement possible grâce à l’intervention de ce type d’anticorps ». Hugo Mouquet détaille cette découverte : « Notre étude a permis d’identifier pour la première fois une famille d’anticorps neutralisants à large spectre (broadly neutralizing antibodies – bNAbs), dont l’anticorps EPTC112, qui cible la protéine d’enveloppe du VIH-1, est un des représentants les plus actifs de cette famille ».

En effet, l’anticorps EPTC112 neutralise environ un tiers des 200 variants viraux du VIH-1 testés in vitro, et est capable d’induire l’élimination de cellules infectées en présence de cellules Natural Killer (NK), des cellules immunitaires chargées d’éliminer les cellules anormales de l’organisme.

Cette étude fournit donc des informations importantes sur la façon dont les anticorps neutralisants modifient le cours de l’infection par le VIH-1 chez cette personne de la cohorte VISCONTI. Bien que le virus du VIH-1 circulant chez ce sujet soit résistant à EPTC112 à cause de mutations dans la région ciblée par cet anticorps, il est par ailleurs efficacement neutralisé par d’autres anticorps de type IgG isolés du plasma sanguin. L’étude suggère donc que les anticorps neutralisants de la famille EPTC112 imposent une pression de sélection sur le virus du VIH-1. Bien qu’échappant à l’action de ces bNAbs, le virus reste sensible à la neutralisation par d’autres anticorps anti-VIH-1 produits chez cette personne. Cette observation témoigne ainsi d’une forme de coopération entre les différentes populations d’anticorps neutralisants.

« Le fait de pouvoir étudier ce cas particulier et de découvrir un lien entre la production d’anticorps neutralisants y compris à large spectre et le contrôle de la circulation du VIH-1 est enthousiasmant pour affiner la compréhension des mécanismes en jeu, notamment chez les personnes contrôlées post-traitement avec des profils similaires. Nous aimerions en effet pouvoir étudier à court terme si les réponses anticorps chez d’autres "contrôleurs post-traitement" participent aussi à la rémission durable de l’infection », explique Hugo Mouquet.

Cette découverte ouvre la voie vers l’établissement de nouvelles pistes de traitement contre le VIH-1, et nourrit les espoirs pour des approches thérapeutiques favorisant une rémission sans traitement antirétroviral grâce au rôle clé des anticorps neutralisant à large spectre. A cet effet, un essai clinique qui intègre l’utilisation d’anticorps neutralisant à large spectre devrait être initié en France avant fin 2023.

Article rédigé par Georges Simmonds pour RT Flash

Institut Pasteur

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|