|

|

Edito

Le stockage massif des énergies renouvelables : un défi technique et industriel majeur...

Le 24 avril dernier, le “Sommet de la Mer du Nord” a réuni à Ostende, en Belgique, les neuf pays européens (France, Grande-Bretagne, Allemagne, Pays-Bas, Belgique, Irlande, Danemark, Luxembourg, Norvège) qui souhaitent donner à l’éolien marin une impulsion nouvelle et contribuer ainsi à atteindre plus rapidement les nouveaux objectifs européens en matière de développement des énergies propres (+ 42,5 %) et de réduction des émissions de CO2 (– 57 %) prévus pour 2030 et adoptés à une large majorité par le Parlement européen le 18 avril dernier.

A l’issue de ce sommet, il a été décidé que la capacité éolienne marine européenne serait multipliée par quinze et portée de 20 GW, fin 2023, à 300 GW en 2050, avec un objectif intermédiaire fortement revu à la hausse de 120 GW dès 2030. La France, pour sa part, très en retard dans ce domaine, a décidé d’accélérer le développement de son éolien marin et de le porter à 6 GW en 2030 (un niveau déjà dépassé aujourd'hui par nos voisins anglais et allemands), pour atteindre 40 GW, répartis sur 50 parcs éoliens, en 2050.

Pour réaliser cet effort global gigantesque en faveur de l’éolien marin, ces neuf pays vont devoir tripler dès l’année prochaine le rythme d’installation des éoliennes marines et devraient consacrer pas moins de 800 milliards d’euros à l’éolien marin, qui deviendra vraisemblablement la principale source de production d'énergie renouvelable, devant le solaire et l'éolien terrestre. Il est vrai que, même si l’on retient l’hypothèse probable d’une hausse de 40 % de la consommation électrique de l’UE (due à une forte augmentation de la part de l’électricité dans la consommation globale d’énergie), ces nouveaux objectifs dévoilés à Ostende représentent une production d’électricité marine de 1050 TWH par an en 2050, soit près de 30 % de la consommation électrique de l’UE prévue à cette échéance (environ 3 800 TWH par an).

Si l’on ajoute l’éolien terrestre, et l’électricité solaire, qui vont connaître également un essor considérable, pour atteindre au moins 25 % de la consommation électrique en 2050, on constate que les deux tiers de la production d’électricité européenne seront issus de l’éolien et du solaire, le solde étant assuré par l’hydraulique, le nucléaire et les énergies marines. Cela signifie toutefois, ce qui a peu été relevé par les médias, que les deux tiers de l’électricité européenne sera issue en 2050 de sources qui, par nature, et quels que soient les progrès qui seront réalisés en matière de prévision météorologique, sont intermittentes et soumises à d’importantes fluctuations de production.

Ill existe dans le monde environ 400 STEP, (les STEP sont des installations hydrauliques réversibles, qui permettent de remonter avec des pompes de l'eau dans un lac en hauteur puis d'utiliser sa chute pour produire de l'électricité) qui, comme dans les usines hydroélectriques classiques représentent 160 GW de stockage, ce qui ne permettra pas de stocker les quantités massives d’énergie qui proviendront demain du solaire et de l’éolien. L’électricité issue de ces deux sources renouvelables devrait en effet passer de 3500 TWH par an en 2023 (environ 12 % de la consommation mondiale d’électricité), à 27 000 TWH par an en 2050, soit une multiplication par huit… Des chercheurs de l'Université nationale australienne (ANU) ont publié récemment un atlas en ligne de tous les sites potentiels où implanter des Step. Leurs estimations reposent sur un algorithme capable de les identifier en intégrant différents facteurs, climat, topographie, volume du réservoir. Ils ont ensuite calculé le potentiel de stockage possible. Au total, 530.000 sites ont été trouvés, totalisant une capacité considérable de 22.000 TWh, soit les trois quarts de la production annuelle d’électricité, de quoi permettre d'équilibrer sans problèmes l’offre et la demande de courant…

Selon Matthew Stocks qui a dirigé le projet, « à peine 1 % des meilleurs 530.000 sites de STEP suffirait à couvrir une production à 100 % d'énergies renouvelables ». La France, pour sa part, ne dispose que de six STEP, représentant 5 GW de stockage, mais notre pays possède suffisamment de sites potentiellement exploitables pour doubler en dix ans cette capacité et la porter à 10 GW. Certes l'aménagement de ces sites représente des investissements très importants, mais largement rentables à terme, si l’on tient compte du coût de stockage dix fois moins élevé au GW, par rapport aux batteries géantes, ainsi qu’à la durée de vie très longue de ces installations.

Une autre solution de stockage de l’énergie, complémentaire de la précédente, est le recours à l’hydrogène comme “réservoir chimique”, constitué à partir de la production excédentaire d’électricité résultant des énergies renouvelables. GRTgaz, le gestionnaire du réseau gazier de France, a procédé récemment aux premières injections de cet hydrogène issu de l'électricité d'origine renouvelable dans le réseau. Pour cette entreprise, il s’agit « d’une étape majeure dans le développement de solutions de décarbonation du gaz et de ses usages, du stockage d’énergie et de synergies entre réseaux gaz et électriques ». Cette solution novatrice permet de valoriser l'excédent d'électricité renouvelable en la convertissant en hydrogène grâce à deux électrolyseurs. Autre avantage, ce procédé permet également la production de méthane de synthèse grâce à un réacteur de méthanation associé à une unité de captation du CO2.

Le réseau de distribution de gaz de GRDF expérimente également l’injection de l’hydrogène directement dans le réseau de gaz, avec le démonstrateur GRHYD, inauguré en juin 2018 à Cappelle-la-Grande, près de Dunkerque, dans le Nord. Après avoir démarré avec 6 % d’injection d’hydrogène dans le réseau, l’installation est passée en 2019 à un taux de 10 % et doit passer, à terme, à 20 %, le taux maximum compatible avec la sécurité, dans le cadre des infrastructures actuelles. D’ici 2030, ce sont plusieurs dizaines de GW, issus notamment des grands parcs éoliens marins de Mer du Nord (qui intégreront des électrolyseurs très performants), qui pourraient ainsi être stockés sous forme d’hydrogène dans les réseaux de gaz.

Le stockage généralisé et performant de l’énergie est également un enjeu de premier ordre dans le secteur du bâtiment et de la construction, qui absorbe plus de la moitié de la consommation mondiale d’électricité et représente, en France, 44 % de l'énergie consommée, loin devant le secteur des transports (31 %). Pour la première fois en Europe, une micro-unité de piles à combustible à base d'hydrogène pur a été mise en œuvre fin 2022 à Bénévent, en Italie. Cette unité issue des recherches de l’Université de Sanio, alimente en électricité, sans émettre de CO2, l’ensemble des bâtiments universitaires.

En France, une jeune société basée en Isère, Sylfen, issue du Commissariat à l'Energie Atomique (CEA), est sur le point d’industrialiser sa solution d'électrolyseur réversible. Cette technologie brevetée permet de surmonter l’obstacle que constitue l'intermittence des énergies renouvelables produites localement sur des bâtiments autonomes, en stockant le surplus sous forme d'hydrogène. Cette solution innovante permet de convertir une partie de l'énergie renouvelable, produite par des panneaux photovoltaïques, en hydrogène, par électrolyse de l'eau. L’innovation réside dans le fait que ce même dispositif permet aussi de restituer l'énergie via une pile à combustible, ce qui autorise un gain, à la fois en volume occupé, en efficacité énergétique, en maintenance et en coût d'exploitation. Cerise sur le gâteau, ce système permet aussi la cogénération, c'est-à-dire la production conjointe d’électricité et de chaleur, pour chauffer les bâtiments.

Les batteries géantes sont également appelées à jouer un grand rôle en matière de stockage massif d’énergie. En Australie, Neoen a annoncé, fin 2022, la construction d’un système de stockage d’énergie par batterie (BESS) de 850 MWh à Wallerawang, en Nouvelle-Galles du Sud. Cette batterie classique au lithium-ion, qui sera opérationnelle cette année, devrait devenir l’une des plus puissantes du monde.

Mais ces batteries géantes lithium-ion, bien que performantes, pourraient bientôt être surclassées par un autre type de stockage chimique, les batteries "redox flow", ou à flux redox. Dans ce type de batterie rechargeable, l’électrolyte circule à travers une ou plusieurs cellules électrochimiques à partir d’un ou de plusieurs réservoirs. Bien que plus coûteuses que les autres types de stockage d’énergie, ces batteries à flux présentent plusieurs avantages décisifs : une durée de vie accrue, un nombre de recharge presque illimité et une sécurité plus grande. La Chine, qui a d’immenses besoins en matière de stockage d’énergie, mise beaucoup sur ce mode de stockage d’énergie. Elle vient de mettre en service une batterie à flux géante d’une capacité de 400 MW, qui devrait permettre d’alimenter toute la ville de Dalian et ses 200 000 habitants.

Encore au stade expérimental, mais pleines de promesses, les batteries gravitaires pourraient également trouver leur place dans le futur paysage énergétique décarboné. En Suisse, la société Energy Vault a testé avec succès sa technologie gravitaire. Elle construit actuellement une installation de taille bien plus ambitieuse pour la société de gestion et de recyclage des déchets China Tianying. Cette unité de stockage prendra la forme d’un bâtiment de 120 mètres de haut et aura une capacité de stockage d'énergie qui atteindra les 100 mégawattheures, ce qui lui permettra d’alimenter en permanence 3 500 foyers qui n'auront pas besoin d'une autre source d'énergie.

Une équipe internationale de chercheurs, dirigée par l’IIASA (International Institute for Applied Systems Analysis), un institut de recherche en Autriche, propose une variante de ce système de stockage gravitaire qui consiste à valoriser des sites miniers abandonnés. La technique, appelée "Stockage Sous-Terrain d’Energie par Gravité" (UGES), utilise un arbre vertical installé à l’intérieur de la mine sur lequel sont placés des moteurs électriques qui permettent de soulever ou d’abaisser des conteneurs remplis de sable. Lorsque la production électrique est excédentaire, ce dispositif stocke l’électricité en soulevant le sable pour le déposer sur des sites de stockage supérieurs situés au sommet de la mine. En revanche, lorsqu’il faut répondre à une forte et rapide augmentation de la demande d’électricité, le système convertit l’énergie potentielle du sable en le redescendant vers un réservoir inférieur situé au fond du puits. L’énergie cinétique produite est alors transformée en électricité, pour être injectée dans le réseau. Selon ces recherches, pour une capacité de stockage d’énergie d’une mine de 4 millions de tonnes de sable et d’un dénivelé moyen de 200 mètres, le système atteint un potentiel de stockage considérable, de 1,75 GWh. Ce mode de stockage présente de nombreux avantages. Outre sa longévité de plus de 50 ans, Il est peu coûteux et performant sur le plan énergétique, avec un rendement de 80 %, équivalent à celui d’une batterie lithium ion.

La société britannique Highview Power, associée au producteur danois d’énergie Orsted, travaillent, pour leur part, sur un système de stockage de l’énergie issue des éoliennes en mer sous forme d’air liquide. Le stockage d’énergie à air liquide (LAES) consiste à stocker de l’air sous forme d’azote liquide avant de l’utiliser pour produire de l’électricité. En fonction des besoins, l’air liquide est retransformé en gaz, utilisé pour générer du courant électrique. Pour stocker l’énergie, le surplus d’électricité alimente un compresseur d’air qui va élever la température du fluide jusqu’à 400°C. Une fois comprimé, l’air est refroidi jusqu’à -160°C et devient alors liquide, ce qui permet de le stocker à basse pression dans de grands réservoirs. En cas de forte demande d’électricité, on inverse tout simplement ce processus : l’air liquide est pompé à haute pression et passe par des échangeurs de chaleur, avant de s’évaporer. Il va alors repasser à l’état gazeux et monter en température. Il suffit d’utiliser la chaleur issue de la compression pour alimenter une turbine qui produit de l’électricité. Selon Highview Power, cette solution peu coûteuse, qui peut fonctionner partout, permet de stocker l’énergie sur de longues périodes, contrairement aux batteries.

Je veux vous parler maintenant de l’innovation baptisée "Ocean Battery", proposée par Ocean Grazer. Pour simplifier l’installation de ces batteries au fond de l’eau, Ocean Battery a cherché à se passer d’une solution chimique, à base de lithium, cobalt ou de manganèse, potentiellement polluante. Ocean Battery a donc imaginé un système de stockage qui n’utilise que de l’eau. Le principe de fonctionnement est simple mais très efficace : lorsque l’électricité produite par l’éolienne en surface est excédentaire, le système va utiliser ce surplus d’énergie électrique pour pomper l’eau des réservoirs rigides vers les vessies souples posées au fond de la mer. L’énergie est alors stockée dans l’eau sous haute pression. Lorsqu’il y a une demande d’énergie électrique, il suffit d’utiliser la pression sous-marine pour que l’eau retourne des vessies souples vers les réservoirs rigides à basse pression. Ce flux d’eau entraîne alors plusieurs turbines hydroélectriques qui produisent de l’électricité. Cette batterie océanique est peu onéreuse, demande peu d’entretien et, ne contenant aucun produit chimique, elle est tout à fait inoffensive pour le milieu marin. Ce concept de batterie océanique peut être rapidement déployé dans les parcs éoliens existants ou sur de nouvelles installations. Ocean Grazer, qui a été récompensée du prix de la meilleure innovation au CES 2022 de Las Vegas, a déjà conclu des accords avec plusieurs grandes compagnies gestionnaires de parcs éoliens marins qui souhaitent mettre en œuvre cette solution ingénieuse de stockage liquide dès 2025.

Il faut bien comprendre que les différentes solutions de stockage massif de l’énergie que j’ai évoquées ne sont pas concurrentes, mais complémentaires. Toutes répondent en effet à des besoins et situations spécifiques. En combinant de manière ingénieuse et intelligente ces différents modes de stockage, et en les associant aux nouveaux outils numériques prédictifs de gestion intelligente des réseaux de distribution électrique, il devient enfin envisageable de produire la quasi-totalité de l’électricité mondiale de manière décarbonée, à partir de sources d’énergie renouvelables, aujourd’hui essentiellement le solaire et l’éolien, mais demain les énergies marines (énergie des vagues, des marées, des courants marins, énergie thermique des mers) qui recèlent un gigantesque potentiel largement sous-exploité.

Pour réussir d’ici 2050 la transition énergétique mondiale historique qui nous attend pour stabiliser le réchauffement climatique qui ne cesse de s’accélérer, nous devons donc, parallèlement au développement considérable des énergies renouvelables, déployer rapidement, et à très grande échelle, ces nouveaux moyens de stockage massif de l’énergie qui permettront de mettre en place un système planétaire de production et de conversion combinant de la manière la plus efficiente et la plus économique, et la plus respectueuse pour l’environnement, les différentes dimensions de l’énergie, électrique, chimique, physique et thermique…

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

e-mail : tregouet@gmail.com

|

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

C'est une première mondiale d'après la société Texep qui la développe. La cellule Aquaviva, un conteneur dont le toit est entièrement recouvert de panneaux solaires, génère elle-même l'énergie nécessaire pour dessaler l'eau de mer. Depuis quelques jours, elle est installée sur l'anse Gerbal dans le port de Port-Vendres (Pyrénées-Orientales).

Située au bord du quai, la cellule pompe directement dans le port l'eau de mer avant de la faire passer dans un coffret de dessalement. À l'intérieur, l'eau est mise sous très forte pression puis filtrée par quatre membranes qui retirent progressivement les particules de sel, mais aussi les bactéries. « L'eau qui sort est buvable » affirme André Posnanski, fondateur de la société Texep.

En 24 h, la cellule Aquaviva pompe 30.000 litres d'eau de mer afin de produire 10.000 litres d'eau douce. Les 20.000 restants sont rejetés directement dans le port avec une concentration en sel augmentée de 30 %. « Cette saumure que l'on rejette dans la mer, n'est pas trop contraignante pour le milieu » assure Serge Bosca en charge de l'ingénierie pour la société Texep. « On est quand même dans un parc naturel on ne peut pas faire n'importe quoi » prévient Serge Pallares, président du parc naturel marin du golfe du Lion. Aussi des prélèvements seront effectués "quotidiennement" assure-t-il pour évaluer l'impact de la saumure, le rejet après dessalement, sur l'écosystème méditerranéen. Des résultats sur la base desquels pourra être envisagée l'extension du dispositif.

Actuellement, le mètre cube d'eau produit par la cellule Aquaviva coûte « environ trois euros » estime André Posnanski. La cellule, elle, demande « 50.000 à 100.000 euros d'investissement selon sa dimension », estime Serge Bosca.

Une eau jugée encore « trop cher pour les usagers » par Rodrigues Furcy, préfet des Pyrénées-Orientales, présent pour l'inauguration lundi 4 avril. Aussi cette phase de test permet d'envisager une potentielle solution supplémentaire pour faire face à la sécheresse qui touche le département, si les tests d'impact environnementaux se révèlent positifs. En attendant ces résultats, Grégory Marty, maire de Port-Vendres, envisage d’utiliser l’eau douce produite pour la voirie de sa commune et celles voisines de Banyuls et Collioure. Mais surtout il pense proposer aux viticulteurs, pour qui la période traitement des vignes va débuter, de venir remplir leurs cuves directement à la sortie d’eau de la cellule Aquaviva.

Article rédigé par Georges Simmonds pour RT Flash

France Bleu

|

|

|

|

|

|

|

|

|

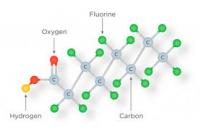

Le changement climatique stimule la recherche, notamment pour faire émerger des alternatives aux combustibles fossiles. Il en est ainsi de la conversion photocatalytique des acides gras des micro-algues en hydrocarbures, qui représente une voie prometteuse vers la production de carburants verts et autres composés à haute valeur ajoutée. En effet, comme les plantes, les micro-algues utilisent du CO2 pour finalement synthétiser leurs acides gras, ce qui rend le processus global neutre en carbone.

Dès 2017, des chercheurs du Biam découvraient chez la micro-algue Chlorella variabilis une enzyme à la propriété rare : activée par la lumière du soleil, elle permet aux micro-algues de convertir leurs acides gras directement en hydrocarbures. Depuis, cette photodécarboxylase des acides gras "FAP" mobilise la communauté scientifique internationale pour déployer tout son potentiel dans la production de carburants biosourcés de type diesel. Cependant, la faible activité supposée de cette enzyme sur les acides gras C2-C12 semblait exclure son utilisation pour la synthèse d'hydrocarbures à chaîne moyenne de type essence. Rappelons que les hydrocarbures sont des composés organiques constitués d'une chaîne carbonée (C) et d'atomes d'hydrogène (H).

Aujourd'hui, les équipes du Biam, de Joliot et de l'Institut Polytechnique de Paris révèlent que l'enzyme FAP est plus efficace sur un acide gras à huit atomes de carbone. Elles ont en effet observé in vitro qu'elle peut convertir l'acide octanoïque (C8) quatre fois plus rapidement que l'acide hexadécanoïque (C16), le substrat le plus efficace identifié à ce jour. Cette performance a aussi été observée in vivo, tel que l'explique Pavel Müller, chercheur au CEA-Joliot qui a eu recours à la spectroscopie résolue en temps : « lorsque la FAP décarboxyle l'acide octanoïque (C8) dans une réaction qui produit du n-heptane, ce n-heptane reste dans la poche de liaison et imite la partie manquante de la chaîne longue, contribuant ainsi à augmenter le rendement quantique. Cet effet autocatalytique rend la photodécarboxylation des acides gras à chaîne moyenne (tels que C8) presque aussi efficace que celle des substrats longs natifs. En outre, le remplacement du produit par un nouveau substrat s'avère plus rapide pour les chaînes moyennes que pour les longues ». Cela se traduit par un taux de production de FAP dix fois plus élevé pour n-heptane (C7H16), qui est un hydrocarbure de type essence, que pour n-pentadécane (C15H32).

« Ces résultats représentent une étape importante vers la production d'hydrocarbures similaires à l'essence à partir d'une source biologique et de lumière. Nous restons pleinement mobilisés pour continuer à optimiser l'enzyme FAP qui n'a pas fini de dévoiler tous ses secrets », conclut le chercheur.

Article rédigé par Georges Simmonds pour RT Flash

CEA

|

|

|

|

|

|

|

|

|

Lorsque l’on évoque Marseille, on pense à la chaleur du sud, la plage, la mer et… le soleil ! C’est pourquoi la cité phocéenne aurait décidé de se tourner vers l’énergie solaire. Solarvia, la filiale de Vinci autoroutes, développe un projet de panneaux solaires au-dessus de l’autoroute. Baptisé "canopée solaire", le projet pourrait devenir le premier à aboutir en France. Plusieurs hypothèses sont étudiées. Avant d’avoir un toit de panneaux solaires au-dessus de leur tête, les automobilistes vont voir fleurir ci et là des champs de panneaux solaires.

Concrètement, Vinci autoroutes veut investir dans des "délaissés autoroutiers". Son directeur marketing explique qu’installer un parc photovoltaïque de 1.000 hectares produit 1.000 mégawatts. Toutefois, pour s’en doter, il faut compter 1 milliard d’euros pour chaque parc créé. Outre le coût de tels projets, d’autres obstacles peuvent se dresser sur le chemin de l’entreprise française. Certains "délaissés autoroutiers" ne sont pas exploitables, des espèces protégées y vivant.

Pour Sébastien Barles, adjoint à la transition écologique du maire de Marseille, l’investissement est en effet important : « Ça vaut très cher évidemment, mais le retour sur investissement prend huit à dix ans. Ensuite, on peut faire de grosses économies ». L’élu marseillais veut que cette énergie profite aux plus précaires : « Les quartiers populaires qui ont été victimes de cette pollution routière bénéficieront de cette énergie. On appelle ça l'autoconsommation ».

Article rédigé par Georges Simmonds pour RT Flash

Capital

|

|

|

|

|

|

|

|

|

L’hydrogène a été présenté comme un véritable couteau suisse de la transition énergétique, ce qui a donné lieu à une sorte de "battage médiatique", explique Brice Lalonde, ancien dirigeant du parti des Verts en France et aujourd’hui président du groupe de réflexion Équilibre des Énergies rassemblant des entreprises telles qu’Airbus et Total Energies. Cependant, « on ne peut pas l’utiliser pour tout », a souligné M. Lalonde.

Alors que l’hydrogène est déjà largement répandu dans la production de plastiques et d’engrais ainsi que dans les processus chimiques, M. Lalonde pense que la demande supplémentaire de gaz sera limitée. Le président du groupe de réflexion estime que l’hydrogène « devrait probablement être utilisé uniquement comme carburant pour les transports, en particulier pour l’aviation ». Et pour ces applications, il serait crucial d’avoir du CO2 à portée de main. « L’intérêt principal de l’hydrogène sera d’être un composant à mélanger avec le carbone », a déclaré M. Lalonde, qui était également ambassadeur de France pour les négociations sur le climat de 2007 à 2010.

Le mélange de CO2 et d’hydrogène permet de produire des carburants de synthèse qui, à l’instar des carburants fossiles classiques, sont riches en énergie et adaptés à l’aviation et au transport maritime. La grande différence est que ces carburants de synthèse peuvent être climatiquement neutres. Pour ce faire, l’hydrogène utilisé dans le processus doit être vert — c’est-à-dire qu’il doit provenir d’électricité renouvelable — et du CO2 issu de processus industriels déjà existants ou capturé dans l’air doit être utilisé.

La Commission européenne a perçu le potentiel du CO2 en tant que matière première pour l’industrie. En octobre dernier, elle a annoncé qu’elle travaillait sur une stratégie de captage, stockage et utilisation du carbone (CCUS), qui devrait être publiée avant la fin de l’année. « Le CO2 est le deuxième pilier de l’économie des molécules » explique Chris Bolesta, chef d’équipe à la DG Énergie de l’UE, en charge de la CCUS. « Nous n’avons pas encore de stratégie CCUS, mais nous y travaillons », ajoute-t-il, précisant que cette stratégie « suit la voie de l’hydrogène ».

À l’instar de la stratégie de l’UE sur l’hydrogène présentée en 2020, la stratégie CCUS viserait à donner aux entreprises une perspective claire. « Nous voulons en fait imposer à certains marchés l’obligation de fournir une capacité de stockage du CO2, afin que le marché ait la certitude qu’il y aura un stockage et qu’il puisse investir dans la capture et le transport », a expliqué M. Bolesta. « La priorité doit être d’empêcher que les émissions soient relâchées dans l’atmosphère », déclare Jonas Helseth, directeur du groupe de réflexion Bellona Europe. « Le stockage du CO2 est manifestement nécessaire à cette fin », a-t-il ajouté.

Toutefois, la capacité de stockage de CO2 nécessaire à cette fin peut sembler impressionnante. En mars, la Commission européenne a fixé un objectif de 50 millions de tonnes de capacité annuelle d’injection de CO2 d’ici 2030, pour atteindre 550 millions de tonnes de CO2 par an d’ici 2050. Or, pour l’ensemble de la planète, la capacité de stockage devrait atteindre une gigatonne par an, a déclaré Gabrielle Gauthey, responsable des affaires européennes chez le géant de l’énergie Total Energies, qui s’est exprimée lors de l’événement. « Il serait bon d’avoir sept gigatonnes par an, ce qui est énorme », a déclaré Mme Gauthey. Toutefois, même cela ne suffirait pas. Selon M. Bolesta, le nombre de projets ayant exprimé leur intérêt pour l’injection de CO2 en Europe « représente plus de 80 millions de tonnes par an ».

Article rédigé par Georges Simmonds pour RT Flash

Euractiv

|

|

|

|

|

|

|

|

|

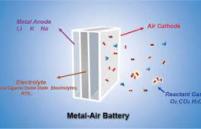

Pourra-t-on bientôt remplacer les centrales au gaz et à charbon par une production d'énergie renouvelable, stockée sur d'immenses batteries. Oui, si l’on en croit la société américaine Form Energy, qui a décidé de miser sur le stockage par batteries fer-air (Fe-air). « Nous développons une nouvelle catégorie de systèmes de stockage de l'énergie rentables et fonctionnant sur plusieurs jours, qui permettront de disposer d'un réseau électrique fiable et entièrement renouvelable tout au long de l'année », promet l’entreprise, fondée en 2017 par Mateo Jaramillo, un ingénieur autrefois vice-président de Tesla.

Sa technologie se base sur trois ingrédients pour stocker de l’électricité : l'air, l'eau salée et le fer. Des matériaux qui ont le bénéfice d’être bon marché et abondants dans la croûte terrestre. Pour fonctionner, le système fer-air met à profit l’oxydation du fer. En clair : la rouille. Lorsqu’elle se décharge, la batterie aspire l'oxygène de l'air, ce qui a pour conséquence de faire rouiller le fer. A l’inverse, quand elle se recharge, la batterie libère l'oxygène qu’elle a précédemment absorbé et le fer recouvre son état antérieur. Ce processus de "rouille réversible" peut être répété des milliers de fois pour accumuler et injecter de l'électricité sur le réseau électrique.

Les batteries lithium-ion, qui sont les plus fréquentes actuellement, utilisent des métaux rares et chers tels que le nickel et le cobalt, dont l’extraction pose des problèmes environnementaux. Par ailleurs, les batteries lithium-ion ne fournissent environ que quatre heures de capacité de stockage d’énergie, alors que les batteries fer-air, dix fois moins chères, pourraient fournir jusqu’à cent heures de stockage, soit environ quatre jours. Par conséquent, les batteries fer-air, en dépit d’un temps de charge plus lent, sont bien adaptées au stockage de l’énergie issue du solaire et de l’éolien.

Article rédigé par Georges Simmonds pour RT Flash

AZO

|

|

| ^ Haut |

|

|

|

|

|

|

|

Espace |

|

|

Espace et Cosmologie

|

|

|

|

|

|

|

|

|

|

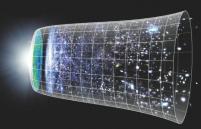

L’Univers est en expansion croissante. Mais à quelle vitesse se dilate-t-il exactement ? Depuis quelques années, la question fait débat au sein de la communauté mondiale des astrophysiciens et cosmologues. Car leurs calculs diffèrent selon qu’ils estiment le taux d'expansion cosmique en se basant sur l'écho du Big Bang (le fond diffus cosmologique) ou sur les étoiles et les galaxies d'aujourd'hui. C’est ce qu’on appelle la tension de Hubble. Or, une étude de l’EPFL publiée dans la revue Astronomy & Astrophysics apporte un nouvel élément à la discussion.

L’équipe de Richard Anderson, qui dirige l'unité de recherche Stellar Standard Candles and Distances à l’Institut de Physique de l’École, a réalisé l’étalonnage le plus précis à ce jour des céphéides, des étoiles dont la luminosité fluctue sur une période définie. Si elles sont communément utilisées en cosmologie comme outil de mesure des distances astronomiques, les chercheurs en ont ainsi considérablement amélioré la fiabilité. En l’appliquant ensuite aux données recueillies par le satellite Gaia de l'Agence spatiale européenne (ESA), ils sont parvenus à calculer la vitesse d’expansion de l’Univers avec une précision inédite. Appelée constante de Hubble – ou H0 –, cette vitesse d’expansion s’écrit en km/s/Mpc, soit en kilomètres par seconde par mégaparsec – un mégaparsec représentant environ 3,26 millions d'années-lumière.

L’étude a utilisé une "échelle des distances cosmiques". Fondée sur les principes de la trigonométrie, cette méthode permet des mesures par échelons. L’étalonnage absolu de la luminosité des Céphéides en est le premier. Il sert ensuite de repère pour calculer la distance d’objets plus éloignés, comme les supernovae, puissantes explosions d'étoiles en fin de vie. Grâce à cette technique, les chercheurs ont ainsi confirmé les résultats obtenus préalablement par l'équipe SH0ES (pour Supernovae H0 for the Equation of State of dark energy) dirigée par le lauréat du prix Nobel Adam Riess (physique, 2011), qui place la constante de Hubble à 73,0 +/- 1,0 km/s/Mpc.

Or, ce n’est pas la seule méthode de calcul possible. La constante de Hubble peut également être déterminée en analysant le fonds diffus cosmologique, soit une représentation spectrale de la toute première lumière émise par l’Univers après le Big Bang, il y a plus de 13 milliards d’années, dont le satellite européen Planck a pu fournir des données plus complètes. Avec ce procédé, les calculs donnent une vitesse d’expansion de 67.4 +/- 0.5 km/s/Mpc.

Il existe donc une divergence de près de six kilomètres par seconde et par mégaparsec (5.6 km/s/Mpc) selon que l’on calcule à partir du fond diffus cosmologique (Univers primordial) ou de la méthode de l’échelle cosmique (Univers récent). Et c’est ce qui est donc appelé et fonde la "tension de Hubble". Or, en partant du principe que les résultats des deux méthodes ont été éprouvés et sont justes, cela signifie que c’est notre compréhension de l'Univers et des lois physiques qui le régissent qui n’est pas exacte. Un enjeu de taille, qui rend donc d’autant plus cruciale l’infaillibilité des méthodes employées.

Dans ce contexte, la nouvelle étude de l'EPFL est importante car elle renforce la fiabilité du premier échelon de l'échelle des distances. En améliorant la calibration des Céphéides en tant que traceurs de distance astronomique, elle porte la précision de cet outil à +/- 0,9%, confirmant également la pertinence des mesures réalisées à partir de l'Univers récent. De plus, en collaboration avec l'équipe SH0ES, les résultats obtenus à l'EPFL ont permis d'affiner la mesure de la constante de Hubble.

« Nous n’avons pas seulement confirmé un taux d’expansion de 73 km par seconde et mégaparsec, nous avons surtout fourni les mesures les plus précises et les plus fiables jamais réalisées à ce jour », commente Richard Anderson. « Nous avons obtenu ces résultats en recherchant les céphéides appartenant à des amas stellaires composés de plusieurs centaines d'étoiles et en regardant si elles se déplaçaient de manière coordonnée dans la Voie lactée. Grâce à cette astuce, nous avons pu tirer le meilleur parti des données du satellite Gaia et des mesures de parallaxes, tout en bénéficiant du gain de précision apporté par les nombreuses étoiles membres de l'amas. Cela nous a permis de fournir la base la plus solide sur laquelle l'échelle des distances peut s'appuyer ».

Pourquoi une différence de quelques kilomètres à la seconde par mégaparsec, qui peut sembler futile à l’échelle de l’Univers, est-elle si importante ? « Cet écart est capital », explique Richard Anderson. « Imaginez que vous vouliez réaliser un tunnel en creusant de deux côtés différents de la montagne. Si vous avez bien compris la nature de la roche et que vos calculs sont justes, les deux machines se rejoindront. Si non, c’est qu’il y a un hic, soit dans les mesures, soit dans la compréhension de la montagne elle-même. C’est un peu ce qu’il se passe avec la constante de Hubble. Plus nos calculs sont fiables, plus cette différence de résultats indique que nous n'avons pas compris ce qu’est l’Univers, qu’il n’est pas tout à fait tel que nous le pensions ».

Cette différence a de nombreuses implications. Elle remet en question certaines bases, comme ce qu’est, exactement, la nature de l'énergie noire, de l'espace-temps, de la gravitation. « Elle nous oblige à revisiter des notions fondamentales, dont dépend notre compréhension générale de la physique », relève encore le chercheur.

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

|

|

|

|

|

|

|

Les astronomes s'intéressent aux trous noirs primordiaux, une forme de trou noir dont on sait peu de choses et qui pourrait avoir la taille d'un atome, mais une masse de plusieurs milliards de tonnes. Leur existence n'a pas encore été prouvée, mais elle pourrait potentiellement apporter une explication à la matière noire de l'univers qui constituerait ce dernier à 27 %. Les trous noirs primordiaux sont des trous noirs hypothétiques de la taille d’un atome. Ils se seraient formés durant l’époque de l’univers primordial. Un moment, où notre univers ne contenait aucune structure telle que les étoiles et les galaxies.

Ces trous noirs primordiaux font partie de la famille des trous noirs. Leur existence a été prédite entre 1907 et 1915, par le célèbre physicien Albert Einstein et sa loi de la relativité générale. Lorsqu’une étoile très massive a transformé tout son carburant nucléaire, elle expulse ses couches externes dans l’espace lors d’une explosion qu’on appelle supernova. Quant à son noyau, il s’effondre sur lui-même. Ce qui crée une région infiniment petite appelée singularité. Le champ gravitationnel d’un trou noir est tellement fort qu’il "avale" tout ce qui passe à sa portée. Même la lumière qui est absorbée par un trou noir ne peut s’en échapper. On qualifie un tel objet de noir, car il n’émet pas et ne diffuse pas de lumière. Un trou noir se caractérise par un horizon des événements, une sorte de zone de non-retour en quelque sorte.

Il existe plusieurs sortes de trous noirs. Les plus massifs, qu’on appelle trous noirs supermassifs, peuvent avoir une masse qui peut atteindre des milliards de fois la masse du soleil. Sagittarius A* est un trou noir supermassif qui se trouve au centre de la Voie lactée. On estime sa masse à 4,152 millions de masses solaires. Situé à 13,1 milliers d’années-lumière de la Terre, J1342+0928 est un quasar qui pèse 800 millions de masses solaires. Un quasar est un trou noir supermassif. Il s’entoure d’un amas de galaxies très lumineuses et qui émet un puissant rayonnement. Les trous noirs stellaires sont des trous noirs plus communs dont la masse est de 10 à 20 fois la masse du soleil. Il existerait aussi des trous noirs de masses intermédiaires de quelques milliers de masses solaires.

Les astronomes pensent également qu’il existerait un autre type de trous noirs. Ils se seraient formés dans l’univers primitif à cause des variations de densité de la matière dans un environnement où la température et la pression étaient extrêmement élevées. Ces trous noirs primordiaux sont toujours actuellement une hypothèse. Ils peuvent avoir n’importe quelle masse. Quant à leur taille, elle peut aller de la taille d’une particule atomique à plusieurs dizaines ou centaines de kilomètres. Un tel objet pourrait par exemple avoir la taille d’un atome et une masse de plusieurs centaines de milliards de tonnes !

Les trous noirs s’évaporent au fur et à mesure du temps qui passe en émettant un rayonnement de Hawking jusqu’à ce qu’ils aient disparu. En réalité, la "durée de vie" d’un trou noir est proportionnelle au cube de sa masse. Les plus massifs sont ceux qui subsistent le plus longtemps. Comme ses homologues, un trou noir primordial perd de la masse à grande vitesse et finit par s’évaporer rapidement. Jusqu’à présent, les astronomes n’ont jamais été en mesure de détecter ces trous noirs primordiaux. Les scientifiques travaillent pourtant avec acharnement sur ce sujet. En effet, certains pensent que les trous noirs primordiaux pourraient faire partie de la mystérieuse matière noire de l’univers. Elle aurait une masse six fois supérieure à celle de la matière visible et pourrait constituer jusqu’à 27 % de l’univers.

Article rédigé par Georges Simmonds pour RT Flash

Science & Vie

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Selon l’Agence nationale de sécurité sanitaire de l'alimentation, de l'environnement et du travail (Anses), « la toxicité de per- et polyfluoroalkyléeces, ou PFAS, est multiple : ils provoquent une augmentation du taux de cholestérol, peuvent entraîner des cancers, causer des effets sur la fertilité et le développement du fœtus. Ils sont également suspectés d’interférer avec le système endocrinien (thyroïde) et immunitaire ».

Des chercheurs de l’Université de la Colombie-Britannique, à Vancouver, ont développé un matériau qui, grâce à un procédé électrochimique, peut absorber et détruire les PFAS dans l’eau. Selon le Docteur Madjid Mohseni, biologiste qui a développé la technologie, « nos supports adsorbants capturent jusqu'à 99 % des particules de PFAS et peuvent (...) potentiellement être réutilisés, explique-t-il. « Cela signifie que lorsque nous éliminons les PFAS, cela ne génère pas des déchets solides plus toxiques encore qui constituent un autre défi environnemental majeur ».

Pour les chercheurs, ce nouveau matériau pourrait être très important pour les pays les moins développés, notamment les zones où l’eau potable peut être contaminée. Ils citent en exemple les populations des communautés rurales, éloignées et autochtones du Canada. Ainsi, cette technologie pourrait être une solution facile à utiliser pour réduire les risques sanitaires.

En 2023, les scientifiques doivent tester leur technologie en Colombie-Britannique, une province à l’ouest du Canada. « Les résultats que nous obtenons de ces études de terrain, dans le monde réel, nous permettent de mieux optimiser la technologie et de mieux la préparer pour qu’elle soit un produit pouvant [être adapté aux besoins] des municipalités, de l’industrie mais aussi des particuliers ».

Article rédigé par Georges Simmonds pour RT Flash

Science Direct

|

|

|

|

|

|

|

|

|

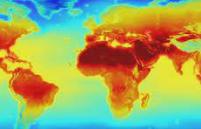

Les vagues de chaleur extrême sont rares, mais ont des conséquences importantes sur les êtres vivants et leur environnement. Anticiper leur arrivée est un enjeu majeur. Une équipe interdisciplinaire de scientifiques français, du CNRS, du CEA et de l’Université Claude Bernard Lyon 1, dévoile une intelligence artificielle capable de prévoir les canicules. Basée sur le "deep learning", elle s’appuie sur des modèles statistiques englobant de nombreux paramètres et s’enrichit de multiples données.

Cette approche probabiliste diffère des prévisions traditionnelles, basées sur les lois de la physique, et utilisées notamment pour les bulletins météorologiques. À partir des conditions environnementales, telles que l’humidité des sols et l’état de l’atmosphère, l’IA associe une probabilité à l’arrivée d’une vague de chaleur extrême, jusqu’à un mois avant son apparition. L’équipe de recherche a entraîné cette technologie sur 8 000 ans, simulés grâce au modèle climatique PlaSim de l’Université Hambourg.

L’IA a également l’avantage de fournir un modèle statistique qui fait une prédiction en quelques secondes, et d’avoir un usage complémentaire aux prévisions météorologiques classiques ou aux modèles climatiques, dans la prévision des phénomènes rares. Néanmoins, l’étude insiste sur un point : pour que l’IA soit fiable, elle a besoin d’un grand nombre de données pour s’enrichir. Ces événements étant rares, peu d’informations sont disponibles. Pour pallier cette faiblesse, les scientifiques vont/comptent conjuguer cette IA avec des algorithmes de simulations d’événements rares, conçus par eux il y a cinq ans, afin d’obtenir une prévision optimale.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

L’immunothérapie consiste à activer des cellules immunitaires - principalement les lymphocytes T - pour qu’elles reconnaissent et détruisent les cellules cancéreuses. Si ce traitement fonctionne très bien chez certains malades, pour qui les résultats vont parfois au-delà des espérances, il reste malheureusement peu efficace dans la majorité des cas. « Les raisons de ces échecs restent encore bien mystérieuses, c’est pourquoi il est essentiel de décrypter les composants immunitaires impliqués afin de développer des traitements encore plus pointus. Sans cela, il ne sera pas possible de faire des immunothérapies une vraie révolution thérapeutique », indique Mikaël Pittet, professeur ordinaire à la Faculté de médecine de l’UNIGE, titulaire de la chaire ISREC en immuno-oncologie, directeur du Centre de recherche translationnelle en onco-hématologie et membre du Ludwig Cancer Center, qui a dirigé ces travaux.

Les neutrophiles sont les cellules immunitaires les plus abondantes dans le sang, très utiles lors d’infections ou de blessures car rapidement mobilisables sur la zone touchée où ils libèrent des facteurs antimicrobiens. En revanche, dans le contexte du cancer, leur présence est en général une mauvaise nouvelle car ils favorisent la vascularisation et la progression des tumeurs.

Afin de comprendre le rôle exact des neutrophiles dans le cancer, les scientifiques ont observé ces cellules lors de l’administration de traitements antitumoraux à des souris porteuses de cancer du poumon et de cancer colorectal. Or, dans les tumeurs réagissant bien aux traitements, le nombre de neutrophiles augmentait significativement.

« Ces premiers résultats étant en contradiction avec ce que l’on savait du rôle des neutrophiles dans le cancer, nous avons voulu aller plus loin pour comprendre pourquoi », détaille Allon Klein, professeur associé en biologie des systèmes à la Harvard Medical School, qui a co-dirigé ces travaux. Les scientifiques genevois-es et américain-es ont alors mis au point des protocoles expérimentaux inédits permettant de comparer les traitements anticancéreux réussis et ceux qui ne le sont pas, puis d’analyser individuellement les cellules d’intérêt dans leurs plus fins détails. « Nous avons alors découvert que les neutrophiles sont en fait beaucoup plus diversifiés qu’on ne le pensait auparavant : ceux que nous observons lors de la réponse de l’organisme aux immunothérapies, très différents de ceux détectés dans des tumeurs en progression, sont en effet porteurs de marqueurs distincts. Et si nous bloquons la réponse de ces neutrophiles particuliers, les bénéfices du traitement disparaissent ».

Ces résultats sont d’autant plus surprenants que les traitements administrés ne visaient pas directement les neutrophiles ; il s’agit donc d’un effet indirect encore insoupçonné. Ainsi, les neutrophiles ne constituent pas une population homogène mais peuvent être, selon les circonstances, pro- ou anti-tumoraux. De plus, les neutrophiles luttant contre une infection bactérienne ou une blessure sont connus pour leur fort pouvoir cytotoxique, c’est-à-dire capable de détruire des cellules. C’est également le cas des neutrophiles anti-tumoraux qui peuvent générer des molécules pour les relâcher ensuite au cœur de la tumeur, d’où leur intérêt thérapeutique.

Les neutrophiles sont produits dans la moelle osseuse avant de circuler dans le sang puis dans les tissus. « Il semblerait que le destin des neutrophiles pro- ou anti-tumoraux se dessine déjà dans la moelle osseuse. Serait-il possible d’influer sur ce destin pour mieux lutter contre les tumeurs ? Nous poursuivons nos recherches en ce sens », explique Mikaël Pittet. Ces résultats prometteurs, qui démontrent que les neutrophiles peuvent être mobilisés pour lutter contre le cancer, ouvrent la voie à de nouvelles approches thérapeutiques qui pourraient rendre les immunothérapies actuelles beaucoup plus efficaces.

Article rédigé par Georges Simmonds pour RT Flash

UNIGE

|

|

|

|

|

|

|

|

|

Apprendre est une caractéristique primordiale de la vie. De l’humain au ver le plus minuscule, la majorité des êtres vivants disposent de cette capacité, à divers degrés. S’il suffit à certains des organismes les plus basiques d’être exposés au même stimulus pour apprendre de manière non associative (qui se manifeste soit par l’atténuation, soit par l’augmentation d’une réponse comportementale suite à la répétition d’un stimulus), d’autres apprennent de manière plus sophistiquée.

Par exemple, chez des animaux dotés d’une grande puissance cérébrale, comme les humains, il est plus facile de lier un stimulus et la réponse qu’il faut y donner. Cette même réponse est d’ailleurs modifiée en fonction de l’expérience du cerveau, de ce qu’il a appris et mémorisé au fil du temps. La douleur que ressent un enfant après avoir touché une casserole chaude peut par exemple être enregistrée par le cerveau, qui modifie en conséquence le comportement de cet enfant afin qu’à l’avenir, il ne reproduise pas ce geste.

Un exemple qui démontre l’importance du cerveau, véritable chef d’orchestre de tout animal. Pourtant, selon une étude, certains animaux n’ont pas besoin d’un cerveau pour apprendre. C’est le cas des cnidaires, un groupe d’animaux aquatiques dans lequel on peut retrouver les méduses, les anémones et les coraux. Pendant longtemps, nous avons été convaincus qu’en raison de leur système nerveux très limité, les cnidaires sont, au maximum, capables d’avoir des réflexes. Mais, selon cette étude de l’Université Columbia de New York, réalisée par le professeur Simon Sprecher, cette supposition est fausse.

Au contraire, en étudiant particulièrement le cas des anémones étoilées, les chercheurs ont pu constater que cette espèce marine est dotée d’une mémoire grâce à laquelle elle est capable d’apprendre par association. Pour arriver à cette conclusion, le groupe de recherche mené par Simon Sprecher a soumis les animaux à des stimulus lumineux et électriques, soit simultanément pour créer une association, soit avec un intervalle entre les deux pour que les animaux ne fassent pas de lien entre les deux stimulus. Le test, répété plusieurs fois, a fait réagir les anémones.

Au fil de l’expérience, celles qui avaient reçu les deux stimulus en simultané rétractaient leur corps dès l’émission de l’impulsion lumineuse. Une réaction qui montre qu’elles ont emmagasiné dans leur mémoire le fait qu’un flash lumineux pouvait être accompagné d’un choc électrique et qu’elles sont capables d’adapter leur comportement en conséquence. Selon le Docteur Sprecher, « c’est exactement ce que l’on appelle l’apprentissage associatif, preuve que même les animaux dépourvus de cerveau sont capables d’adopter un comportement complexe grâce à leur système nerveux ». Une découverte qui ouvre la porte à d’autres questions, notamment sur ce processus qui leur permet de réagir même sans cerveau : « Nous savons très peu de choses sur le fonctionnement du processus d’apprentissage chez les animaux dotés d’un système nerveux moins développé. Notre hypothèse est que certaines synapses sont renforcées chez eux aussi ».

Dans le même temps, les résultats de cette étude soulèvent d’autres questions, particulièrement sur l’émergence de la capacité d’apprendre chez certains êtres vivants. Selon le Docteur Sprecher, l’ancêtre commun à tous les animaux qui possèdent un cerveau a vécu il y a 560 millions d’années. On va donc encore plus loin que le plus ancien cerveau découvert, vieux de 525 millions d’années. Mais les premiers animaux dotés d’un système nerveux sont arrivés avant même cet ancêtre, « 100 à 150 millions d’années » plus tôt. Autrement dit, il y a encore beaucoup à apprendre sur l’origine de notre habileté à apprendre, aussi bien chez nous que chez d’autres animaux.

Article rédigé par Georges Simmonds pour RT Flash

Numérama

|

|

|

|

|

|

|

|

|

Des chercheurs chinois de l’Université de Pékin ont réalisé une méta-analyse reprenant les études consacrées aux effets de la photothérapie sur la démence. Ils constatent que cette thérapie par la lumière présente des résultats prometteurs : elle améliore la fonction cognitive, avec un faible risque d'effets secondaires. « Cette étude avait pour but d’étudier l'efficacité d’une intervention à base de photothérapie sur la fonction cognitive chez des patients adultes âgés atteints de démence », rappellent les auteurs en préambule. Cette pathologie est caractérisée par des troubles cognitifs progressifs, mais aussi moteurs et comportementaux. Ces différents symptômes rendent les personnes atteintes dépendantes. « Avec le vieillissement de la population mondiale, la démence est devenue un problème de santé publique important et il y a un besoin désespéré de trouver un traitement efficace et peu coûteux », expliquent-ils.

Or les traitements actuels présentent plusieurs limites : une efficacité limitée, des effets secondaires ou encore des contre-indications médicales. Selon eux, l’un des avantages de la photothérapie réside justement dans sa sécurité. C’est aussi une technique non-invasive et peu chère avec un risque limité d’effets secondaires.

Dans ces nouveaux travaux, les auteurs ont réalisé une méta-analyse de 12 études consacrées aux effets de la photothérapie, qui rassemblaient un total de 766 patients. Ils ont utilisé un indicateur appelé Mini-Mental State Examination (MMSE) pour évaluer la fonction cognitive des participants, mais ils se sont aussi intéressés aux effets psychologiques de la démence et au sommeil. « Les interventions de photothérapie ont significativement amélioré les scores MMSE », constatent-ils. En revanche, ces séances de lumière artificielle n’ont pas eu d’effet sur la dépression liée à la démence ou sur les troubles du sommeil. Seulement quatre patients ont signalé des effets secondaires légers.

« Notre revue systématique et notre méta-analyse ont montré que la photothérapie améliorait significativement la fonction cognitive chez les patients atteints de démence », concluent-ils. En revanche, ils estiment que des recherches complémentaires sont nécessaires pour mieux déterminer quelles sont les « conditions cliniques de mise en oeuvre les plus efficaces » : soit le type d’appareil, sa puissance, la durée des séances ou encore leur fréquence.

Article rédigé par Georges Simmonds pour RT Flash

Wiley

|

|

|

|

|

|

|

|

|

Lorsque l’on prend de l’âge, notre système immunitaire s'affaiblit. « Cependant, de nombreux centenaires retardent l'apparition de maladies liées au vieillissement, ce qui suggère la présence d'une immunité unique qui reste hautement fonctionnelle à un âge très avancé », ont indiqué des chercheurs de l’Université de Boston (États-Unis).

Pour vérifier cette hypothèse, ils ont recruté sept centenaires, puis ont procédé au séquençage de cellules uniques provenant des cellules mononucléaires du sang périphérique (à savoir une vaste catégorie de cellules immunitaires circulant dans le sang) prélevées auprès des participants. Ensuite, l’équipe a intégré ces informations à deux ensembles de données de séquençage d'ARN unicellulaire accessibles au public, comprenant sept centenaires supplémentaires ainsi que 52 personnes âgées de 20 à 89 ans. Leur objectif ? Étudier les changements de composition et de transcription dans les profils immunitaires au cours de la vie et de l'extrême vieillesse.

Selon les résultats, les centenaires présentent une composition et une activité distinctes des types de cellules immunitaires et possèdent un “système immunitaire hautement fonctionnel” qui s’est adapté à série de maladies et s’en est remis, ce qui leur a permis d'atteindre une longévité exceptionnelle. « Les profils immunitaires que nous avons observés chez les centenaires confirment une longue histoire d'exposition aux infections, et étayent l'hypothèse selon laquelle les centenaires sont enrichis en facteurs de protection qui augmentent leur capacité à se remettre des infections », a déclaré Paola Sebastiani, auteur des recherches.

D’après les auteurs, ces résultats fournissent une base pour étudier les mécanismes de résilience immunitaire, contribuant probablement à l'extrême longévité, en tant que cible pour les thérapies de vieillissement en bonne santé. « Les centenaires, et leur longévité exceptionnelle, constituent un 'modèle' pour la façon dont nous pourrions vivre des vies plus productives et plus saines. Nous espérons continuer à apprendre tout ce que nous pouvons sur la résilience contre les maladies et l'allongement de la durée de vie », a conclu George J. Murphy, co-auteur de l’étude.

Article rédigé par Georges Simmonds pour RT Flash

The Lancet

|

|

|

|

|

|

|

|

|

Les vaccins utilisés actuellement contre cette infection respiratoire permettent de prévenir l’apparition des symptômes mais n’empêchent pas la transmission bactérienne entre individus, ni l’infection qui en résulte. Ainsi, malgré les taux élevés de vaccination, les épidémies de coqueluche persistent partout dans le monde. Pour pallier cela, un nouveau vaccin appelé BPZE1 a été développé et breveté par une équipe de l’Inserm et de l’Institut Pasteur de Lille. Son efficacité et sa tolérance chez l’adulte viennent d’être démontrées dans un essai clinique de phase 2.

BPZE1 est un vaccin vivant atténué ayant pour particularité de s’administrer par voie nasale. Cela permet de mimer les modes de transmission et de colonisation naturels de Bordetella pertussis au niveau des muqueuses respiratoires, ce qui pourrait empêcher la colonisation bactérienne des voies respiratoires et ainsi permettre de briser les chaînes de transmission.

L’essai clinique de phase 2 qui vient d’être publié a inclus 300 Américains adultes en bonne santé qui ont été répartis en 2 groupes : le premier a reçu une dose de BPZE1 par voie nasale et un placebo par voie intramusculaire, le second une injection intramusculaire du vaccin dCaT (diphtérie, coqueluche acellulaire et tétanos) et un placebo par voie nasale. Trois mois plus tard, la moitié des participants de chacun des deux groupes s’est vue administrer une dose de BPZE1 (afin de simuler une infection naturelle de manière atténuée), tandis que l’autre moitié a reçu le placebo intranasal.

L'étude montre que l’injection du vaccin dCaT par voie intramusculaire induit une sécrétion de marqueurs de l’immunité contre Bordetella pertussis uniquement au niveau sanguin tandis qu’avec BPZE1 par voie nasale on observe, en plus de l’immunité sanguine, une immunité consistante au niveau de la muqueuse nasale.

Dans les 28 jours suivant la simulation d’une infection naturelle, 90 % des participants ayant initialement reçu BPZE1 n’avaient aucune colonie bactérienne au niveau nasal et 10 % avaient une colonisation faible (moins de 260 colonies par mL de mucus). En comparaison, 70 % des patients vaccinés avec dCaT présentaient une colonisation bactérienne nasale importante (près de 14.325 colonies par mL). Concernant la tolérance, il n’a été constaté aucun effet secondaire notable dû à la vaccination pendant la durée de l’étude. Ce nouveau vaccin semble donc protéger les muqueuses d’une colonisation par Bordetella pertussis, ce qui pourrait être essentiel dans la prévention des épidémies de coqueluche.

Article rédigé par Georges Simmonds pour RT Flash

The Lancet

|

|

|

|

|

|

|

|

|

Des scientifiques de l’Université de Tel Aviv, en Israël, ont développé un robot microscopique inspiré des « nageurs » biologiques comme les bactéries et les spermatozoïdes. De la taille d’une cellule biologique d’environ 10 microns de diamètre, le micro-robot peut se déplacer automatiquement dans le corps ou être contrôlé par un opérateur.

Selon les informations, cette nouvelle technologie serait capable d’identifier et de capturer une seule cellule. Elle utilise à la fois l’électricité et les champs magnétiques pour aller d’une zone à une autre. Grâce au champ magnétique, le micro-robot n’a pas besoin de carburant ou de contact direct entre l’aimant et les tissus du corps. Cela lui permet également d’être dirigé avec précision et de fonctionner dans une large gamme de températures et de conductivités. Appelé également "micro-moteur", le robot ouvre la porte à de nombreuses applications. Par exemple, il pourrait assurer le chargement, le transport et le largage sélectifs d’une cargaison ou encore déformer certaines cellules en utilisant l’électricité.

Gilad Yossifon, co-auteur de l’étude, explique que jusqu’ici, les micro-robots fonctionnaient grâce à un mécanisme de guidage électrique. Toutefois, ces robots n’étaient pas efficaces dans certains environnements avec une conductivité électrique relativement élevée. La propulsion électrique est par conséquent moins efficace dans un environnement physiologique. C’est la raison pour laquelle ils ont choisi de combiner l’électricité avec le mécanisme magnétique qui est très efficace, peu importe la conductivité électrique du milieu.

Lorsque les chercheurs ont fini l’assemblage du système de propulsion hybride, ils ont utilisé le micro-robot pour capturer un globule rouge, une bactérie et des cellules cancéreuses. Ces expériences ont démontré la capacité du robot à distinguer une cellule saine d’une cellule mourante ou d’une cellule endommagée. Après la capture de la cellule, celle-ci peut être transportée vers un instrument externe pour des analyses plus approfondies. « Le micro-robot a une capacité améliorée pour identifier et capturer une seule cellule, sans avoir besoin de marquage, afin de procéder à des tests locaux ou à une récupération et un transport vers un instrument externe », a déclaré Yossifon.

Jusqu’ici, les tests ont été effectués en dehors du corps humain, mais dans le futur, les auteurs de l’étude espèrent tester le micro-robot in vivo. Pour Yossifon, cette technologie a un potentiel d’action à grande échelle. De nombreux domaines pourraient en effet bénéficier des capacités du micro-robot, à savoir les diagnostics médicaux au niveau d’une cellule unique, l’édition génétique, l’introduction de gènes ou de médicaments dans des cellules, ou encore le transport de médicaments vers certains organes. Le micro-robot pourrait aussi contribuer au nettoyage des particules polluantes qui se trouvent à l’intérieur du corps ou encore au développement de nouveaux médicaments.

Article rédigé par Georges Simmonds pour RT Flash

New Atlas

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|