|

|

|

|

|

| NUMERO 1162 |

|

|

|

|

|

|

|

Edition du 01 Juillet 2022

|

|

|

|

|

Edito

Le potentiel réel de notre Pays en énergies renouvelables est important mais la France traîne...

L’Union européenne, comme la France, ont décidé, dans le cadre du tout nouveau "paquet énergie-climat", et du nouvel agenda “Fit for 55”, de réduire d’au moins 55 % les émissions de gaz à effet de serre de l’Union Européenne, par rapport à 1990 qui est toujours l’année de référence. Il y a un mois, la Commission européenne a annoncé un vaste plan – REPpowerUE – qui va mobiliser 300 milliards d'euros d'ici 2030, essentiellement consacrés à l'accélération de la transition écologique. Concrètement, la Commission propose de fixer un objectif de réduction de 13 % de la consommation d'énergie d'ici 2030, contre 9 % fixés dans un précédent projet de directive. Elle propose aussi un plan d'économies d'énergie et souhaite relever les objectifs de la consommation d'énergie renouvelable à 45 % d'ici 2030, contre 40 % fixés en 2021. Ce plan fixe l'objectif d'installer 300 GW d'énergie solaire d'ici 2028, ce qui est plus du double du niveau actuel. Il recommande aussi d'accélérer le développement de l'hydrogène et de la biomasse. En outre, l’exécutif européen envisage de rendre l’installation de panneaux solaires sur les toits obligatoire pour tous les nouveaux bâtiments, ce qui va permettre un formidable coup d’accélérateur pour le solaire photovoltaïque, surtout avec l'arrivée prochaine d'une nouvelle génération de cellules à très haut rendement (30 %).

La France, en cohérence avec les nouveaux objectifs européens, envisage de réduire très fortement la consommation d’énergie finale et ce dans tous les secteurs mais plus particulièrement dans le secteur des transports et celui de l’habitat. Les scénarios du Réseau de Transport d'Electricité (RTE) prévoient par exemple que l’énergie finale consommée en France passerait de 1600 TWh (1 TWh = 1 milliard de kWh) en 2019 à 930 TWh en 2050, soit une réduction de 40 % de l’énergie finale consommée. Mais dans le même temps, EDF et Enedis prévoient une forte montée en puissance de l’électrification des usages énergétiques : l’électricité, qui représente aujourd’hui 25 % de la consommation d’énergie finale, devrait atteindre 55 % en 2050. Le problème, c’est que la part des énergies renouvelables intermittentes (solaire et éolien) va considérablement s’accroître d’ici 30 ans, ce qui va nécessiter une refonte complète du tryptique production, distribution et stockage d’énergie, pour parvenir à ajuster en temps réel l’offre et la demande d’électricité.

La part des énergies renouvelables dans la consommation d'énergie de la France représente 19,3 % de la consommation finale brute d'énergie, selon les dernières données gouvernementales publiées le 20 juin, soit une hausse de 10 points par rapport à 2005. Ce développement a notamment été tiré par l'éolien, les pompes à chaleur et les biocarburants. Entre 2019 et 2021, la part des énergies renouvelables a même augmenté de deux points, la reprise économique ayant stimulé la demande dans des secteurs comme les transports, l'industrie et le tertiaire. En parallèle, la consommation finale brute d'énergie a diminué, à un rythme d'environ 0,5 % par an.

Reste que notre pays doit atteindre 33 % d'énergies renouvelables en 2030 pour respecter les objectifs de la loi Climat. En 2020, la France avait été le seul pays de l'Union européenne à ne pas se conformer à son objectif européen de 23 %. Aujourd'hui, la biomasse reste la première des énergies renouvelables avec 7,1 % de la consommation énergétique finale, suivie de l'hydraulique (3,4 %) et des pompes à chaleur (2,4 %). L'éolien fournit 2,2 % du total, les biocarburants 2,1 % et le solaire 1,5 %.

Selon le groupe de travail “éolien”, réunissant parlementaires, associations d’élus, ONG, professionnels de l’éolien et de l’électricité, juristes et enfin administrations des ministères concernés, il faut deux fois plus de temps pour faire aboutir un projet d’énergie renouvelable en France que chez nos voisins européens, pas moins de huit ans, en moyenne, contre quatre ans en Allemagne, en Italie ou en Espagne. Cette exception française s’explique notamment par un taux de contestations en justice de 70 % des projets d’installations éoliennes. Autre facteur qui explique cet allongement excessif des délais d’installation, le régime d’autorisations complexes qui allonge considérablement les délais d’instruction des dossiers éoliens.

Pendant ce temps, la société chinoise MingYang Smart Energy travaille sur la mise au point de la plus grande éolienne marine au monde. Selon le constructeur, elle sera opérationnelle en 2024 et aurait une puissance de 16 MW, supérieure à celle de ses concurrentes directes, la Haliade-X de General Electric et la Gamesa de Siemens. Cette machine chinoise mesurera 242 mètres de haut et sera équipée de trois pales de 118 m chacune, qui seront capables de balayer une surface équivalente à 6 terrains de foot (46000 m²). Chaque éolienne de ce type produira annuellement pas moins de 80 millions de kWh, de quoi alimenter environ 20 000 foyers. Ces machines ont été conçues pour pouvoir résister aux typhons, de plus en plus nombreux et violents dans cette région du globe. Pour l’instant, c’est toujours General Electric qui possède la plus grande éolienne du monde, l’ Haliade X, qui atteint 14 MW de puissance. Son concurrent, Siemens Gamesa, n’entend pas se laisser distancer et va commercialiser une éolienne géante de 15 MW annuels. Certes, l’éolien marin reste deux fois plus cher que l’éolien terrestre, mais selon une étude réalisée par le réputé Laboratoire Lawrence, à Berkeley (Californie), les coûts de production de l’éolien marin devraient baisser de 49 % d’ici 2050 (Voir Nature Energy).

En France, l’énergie éolienne représente plus de 8 % de la production nette d’électricité et, après une bonne décennie de retard sur ses principaux voisins, notre pays vient enfin de produire ses premiers kWh marins, issus de la centrale située au large de Saint-Nazaire, qui comptera à terme 80 éoliennes. Cinq autres parcs éoliens en mer sont en cours de construction en France, dont trois sur la façade atlantique (Fécamp, Saint-Brieuc et Courseulles-sur-Mer), et deux en Méditerranée (Port-la-Nouvelle et Fos-sur-Mer). Le constructeur danois Vestas vient également d’installer cinq éoliennes flottantes de 9,5 MW à 15 km au large des côtes écossaises. Ces machines de 190 mètres de haut formeront le parc de Kincardine au large d’Aberdeen et fourniront de l’électricité propre à 55.000 foyers en électricité.

Une étude de l'Université de Fribourg montre qu'en dépit du changement climatique qui diminue globalement les ressources éoliennes, les avancées techniques des machines devaient permettre une amélioration de 23,5 % de leur efficacité énergétique moyenne d'ici 2035 (Voir EurekAlert). A partir de 2025, on devrait également voir arriver de nouvelles éoliennes marines géantes de 20 MW, capables chacune de produire 100 millions de KWh par an (de quoi alimenter 25 000 foyers en électricité), en exploitant des vents au large plus forts et plus réguliers. Le grand défi sera toutefois de parvenir à stocker massivement, et à un coût acceptable, l'électricité excédentaire ainsi produite, pour pouvoir ajuster en temps réel l'offre et la demande. Cela passera sans doute par des électrolyseurs à hydrogène directement couplés à ces éoliennes et par le recours à l'IA pour anticiper les capacités de production et les besoins de consommation...

Du côté du solaire, les progrès techniques ne sont pas moins impressionnants. Des scientifiques de l’EPFL ont mis au point un nouveau type de cellule solaire tandem capable de fournir une efficacité certifiée de 29,2 %. Cette prouesse a été possible en combinant une cellule solaire en pérovskite à une cellule solaire en silicium texturé. Les actuelles cellules solaires en silicium sont intrinsèquement limitées à des rendements de 27 % en raison des contraintes thermodynamiques propres à leur fabrication. Mais l’EPFL a montré que ces limites du rendement peuvent être surmontées en utilisant des matériaux comme les pérovskites à base d’halogénure et en associant le silicium à une deuxième cellule solaire qui absorbe les radiations bleues et vertes du spectre solaire.

En 2018, Pierre Escudié a accueilli sur son domaine de Tresserre, près de Perpignan, une centrale agrivoltaïque dynamique, développée par l’entreprise Sun’Agri. Étendue sur près de cinq hectares de parcelle, soit 17 310 plants de vigne, cette centrale d’une puissance de 2,1 MW est composée de panneaux solaires mobiles et contrôlables à distance, appelés "persiennes" solaires. Cette installation a été conçue pour amortir les effets du changement climatique tel que le gel, mais surtout les fortes chaleurs estivales. Grâce à une batterie de capteurs intelligents et au pilotage informatique sophistiqué, ces panneaux solaires s’adaptent et pivotent en fonction des conditions météo, de manière à produire de l’ombre pour les vignes en été, ce qui les protège des canicules et augmente les qualités organoleptiques du raisin. Cette centrale agrivoltaïque de Tresserre permet aussi de produire une énergie électrique verte. Une énergie qui correspondrait à la consommation de plus de 650 foyers, et qui permet, une fois vendue, d’auto-amortir le coût de l’installation. Et les perspectives de développement de l’agrivoltaïsme sont tout simplement phénoménales en France, à condition toutefois de bien associer en amont élus locaux, agriculteurs, associations et habitants, de façon à ne jamais perdre de vue la dimension essentielle de développement local qui doit porter ces projets qui modifient les modes de production agricole et supposent une intégration numérique complète sur toute la chaine de valeur. En se basant uniquement sur les technologies actuellement disponibles, il serait possible, dans l’hypothèse où seulement 10 % des superficies dévolues à la vigne et aux fruits en France (soit 1000 km2 environ) seraient équipées en agrivoltaïsme, de produire suffisamment d’électricité (plus de 50 TWh, ou 10 % de la production nationale d’électricité) verte pour alimenter 13 millions de foyers, soit 45 % de l’ensemble des ménages de notre pays… Et ces hypothèses de production sont appelées à augmenter sensiblement dans les années qui viennent, avec l’arrivée prochaine de cellules à haut rendement, capables de délivrer uniquement les parties du spectre lumineux utiles à la croissance des plantes, sans parler des panneaux bi-faciaux, qui utilisent la lumière des deux côtés et vont bientôt apparaître dans nos campagnes, sous la forme de "haies solaires"…

Une autre rupture technique va considérablement étendre l’utilisation de l’énergie solaire, il s’agit des cellules hybrides, qui permettent de rationnaliser l’utilisation de l’espace sur les toitures en produisant à la fois chaleur et électricité. Cette solution est particulièrement adaptée aux bâtiments qui ont besoin à la fois d’eau chaude sanitaire et d’électricité : logements collectifs, maisons, hôtels, industrie. La chaleur produite peut également être utilisée par des capteurs solaires thermiques basse température comme évaporateur des pompes à chaleur. Il est aussi possible d’associer capteurs thermiques comme évaporateurs et capteurs photovoltaïques en autoconsommation pour alimenter la Pac.

Une autre société, Airthium, a développé une pompe à chaleur révolutionnaire, capable de restituer l'électricité en quelques heures, comme sur plusieurs mois. Pour parvenir à restituer avec un haut rendement l'énergie stockée, la pompe développée par Airthium brûle de l'ammoniaque liquide. « Le surplus d'énergie obtenu est utilisé pour produire ce carburant de synthèse. Et puis plus tard, on peut le brûler sans produire de CO2 », précise Guillaume Maurin, cofondateur de cette société.

Cette nouvelle génération de pompes à chaleur à haut rendement capables de stocker et restituer l'électricité sur de courtes ou longues périodes va révolutionner le chauffage et la climatisation des bâtiments, sachant que ce secteur est le plus gourmand en énergie, et le plus émetteur en CO2. Il y 15 ans déjà, une remarquable étude d'EDF (publiée dans l'excellente revue Futuribles) montrait déjà qu’en combinant de manière intelligente bâtiment bioclimatique, pompes à chaleur et énergies renouvelables, il était possible, même sans ruptures techniques majeures, de se passer complètement des énergies fossiles d'ici 2050, pour les besoins énergétiques des bâtiments....

Si l’on prend en compte l’ensemble de ces innovations, on est amené à constater que l’actuelle feuille de route du Gouvernement qui vise, par un développement massif des énergies renouvelables, à produire environ 500 TWH en 2050, soit 70 % de la production électrique prévue à cette échéance (de l’ordre de 700 TWH par an, pour une consommation nette de 507 TWH par an), pourrait en fait être atteinte dès 2035, ce qui permettrait à la fois de sortir complètement des énergies fossiles dans 13 ans, comme vient de le décider l’Union européenne, de réduire progressivement, de manière souple et concertée, la part du nucléaire de fission (qu’il faut bien distinguer du nucléaire de fusion contrôlé qui devrait être opérationnel plus vite que prévu) à environ 30 % de notre mix énergétique d’ici le milieu du siècle, et enfin d’assurer l’indépendance énergétique de la France dans un monde turbulent et instable où il est à craindre que d’autres conflits comme celui de l’Ukraine ne viennent bouleverser le paysage énergétique mondial. Cette transition énergétique de grande ampleur est aussi, on l’oublie souvent, fortement créatrice d’emplois pérennes : au niveau mondial, au moins 10 millions d’emplois nouveaux seront créés dans ce secteur d’ici 2030 et en France, se sont 50 000 personnes qui pourraient travailler dans les énergies renouvelables à la fin de la décennie, contre 20 000 aujourd’hui.

Notre pays, qui a la chance de posséder à la fois un cadre géoclimatique exceptionnellement favorable aux énergies vertes, et des compétences scientifiques et technique de premier plan, doit lever sans tarder les obstacles juridiques, administratifs et culturels incompréhensibles qui freinent, de manière très dommageable pour son avenir, l’essor des énergies propres sur notre territoire. Parallèlement, la France doit investir massivement dans la recherche visant à rendre ces énergies renouvelables encore plus performantes et moins coûteuses, pour que demain, nos enfants et petits enfants puissent encore avoir la chance de continuer à vivre partout sur la planète dans des conditions dignes et acceptables…

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

e-mail : tregouet@gmail.com

|

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Une première mondiale ! Le staff d’ID Logistics ne cachait pas sa satisfaction, dans son entrepôt de Berre-L’Étang (Bouches-du-Rhône), que le logisticien a dédié à son client Panzani, lors de la présentation de l’Autonomous Stock Taking Robot by ID Logistics. Ce robot, appelé plus simplement Astrid, est le résultat de trois ans et demi de développement. Il est censé révolutionner la vie des gestionnaires de stock (GDS) ces personnels qui, dans les entrepôts logistiques, sont tenus de connaître à l’unité près les millions de produits présents dans les bâtiments, afin de les expédier aux clients de leurs clients mais aussi pour des motifs de comptabilité et d’inventaires fiscaux.

Sa fonction consiste à identifier, à haute vitesse, et de façon complètement automatique - donc sans intervention humaine -, les dizaines de milliers de palettes présentes dans les racks, en photographiant les codes-barres présents sur leurs faces. Développé avec E-dentic, qui s’est consacré à la partie reconnaissance-identification desdits codes-barres et par Wyca qui a géré la partie mobile, soit concrètement le chariot sur lequel il repose, Astrid répond à un besoin quotidien des entrepôts. Astrid déploie deux séries de deux appareils photos à focale fixe qui, positionnées d’une part et d’autre d’un mat télescopique de 11,5 mètres de haut, scrutent les pallettiers lors du passage de l’appareil dans les allées des entrepôts.

L’utilisation de la vision pour reconnaître les codes-barres, y compris en conditions difficiles, c’est-à-dire dans de mauvaises conditions de lumière, n’est pas nouvelle en soi. Ni d’ailleurs le fait de la réaliser en hauteur…. L’homme d’une part, et les drones d’autre part, en sont capables. Mais il s’agit d’opérations dangereuses dans le premier cas - car l’opérateur doit se hisser sur des nacelles - ou consommatrices de main d’œuvre car, pour ce qui concerne les drones, un pilote est toujours nécessaire et, de plus, il faut bloquer les allées.

Face aux technologies concurrentes, le robot inventoriste d’ID Logistics se distingue pour son degré élevé d’automatisation et sa vitesse d’exécution. Concernant le premier aspect, Wyca met en avant un robot mobile de type AMR très rapidement opérationnel, qui n’a besoin ni de tracés ni de déflecteurs pour se mouvoir dans l’entrepôt. En quelques heures seulement, l’appareil effectue une cartographie de son environnement grâce à deux Lidars 3D qui équipent sa base et est prêt à opérer. Il suffit d'appuyer sur un bouton pour l'envoyer faire son tour... Toute présence humaine est immédiatement détectée grâce à une deuxième paire de scrutateurs ; en cas de danger, le robot ralentit et, le cas échéant, il s’arrête.

Ainsi, l’appareil peut travailler de nuit comme de jour en complète autonomie, y compris en coactivité, c’est-à-dire avec du personnel ou des caristes tout autour, répondant aux problèmes prégnants de manque de personnel dans le secteur de la logistique. Concernant le deuxième aspect, Astrid est capable d’identifier 5000 palettes par heure, ce qui équivaut à dire qu’il est peut passer au peigne fin un entrepôt de 100 000 m² en une nuit. En comparaison, un homme est capable de scanner 100 palettes par heure et un drone 250 palettes par heure.

Pour améliorer la vitesse d’analyse des images, E-dentic a eu recours à l’intelligence artificielle (IA). Sans entrer dans les détails, l’appareil est capable de comprendre quand une palette est présente, quand elle ne l’est pas, si c’est la bonne palette, si elle possède les bonnes dimensions, et d’assimiler toutes les informations logistiques présentes sur les étiquettes grâce aux codes-barres correspondants.

Dès qu’elles sont acquises, les données sont immédiatement comparées avec celles qui sont présentes dans le WMS, l’outil de base de tout entrepôt, censé donné un cadre fidèle de l’état des stocks. C’est à ce moment-là que sont relevées les erreurs; « Si des discordances sont détectées, l’interface ne les corrige pas mais demande au gestionnaire de stock de le faire » - souligne Stéphane Jupin, directeur technique de E-dentic – « la décision finale revient toujours à l’homme qui peut ainsi comprendre pourquoi une palette se retrouve au mauvais endroit et prendre les mesures pour faire en sorte que cela ne se reproduise plus ».

La production en série d’Astrid sera assurée par Usitech, un spécialiste des machines spéciales basé à Brens, dans le Tarn, partenaire de Wyca. Une dizaine d’exemplaires seront fabriqués dans les semaines qui viennent, l’objectif étant d’équiper autant de sites chez ID Logistics en France. En septembre, le robot sera commercialisé à plus large échelle, y compris auprès de logisticiens concurrents, et, à partir de 2023 à l’étranger, dans les autres filiales d’ID Logistics. E-Dentic assumera le rôle d’intégrateur et prendra en charge la commercialisation et les services. Le robot sera proposé à la location, dans le cadre d’un contrat de service à partir de 3000 euros mensuels.

Article rédigé par Georges Simmonds pour RT Flash

L'Usine Nouvelle

|

|

|

|

|

|

|

|

|

Depuis son arrivée en février au centre hospitalier de Cholet (Maine-et-Loire), Wall-e est devenu indispensable à bon nombre de personnels médicaux et paramédicaux. Le robot ainsi surnommé par le personnel transporte, d’étage en étage, de services en services, des prélèvements sanguins, médicaments et poches de chimiothérapie. « L’objectif est de gagner le temps que le personnel dépensait dans les allers-retours entre les services pour le redépenser dans leur mission principale, le soin », explique Eric Lemonnier, responsable logistique du centre hospitalier de Cholet.

XuP-Med a pour mission de rationaliser les flux des échantillons par une distribution automatisée des tubes vers les secteurs spécialisés et les différentes équipes du laboratoire.

Après avoir entré un code d’identification, le laborantin dépose les échantillons à analyser dans l’armoire du XuP-Med. Via l’interface tactile présente sur le robot mobile, le laborantin choisit les destinations de livraison. Une fois les portes refermées, XuP-Med part effectuer ses livraisons en toute autonomie. A l’approche d’un point de livraison le robot mobile signale sa présence en émettant un son et en allumant la verrine lumineuse de la pièce concernée. Après s’être identifié sur l’interface, le destinataire récupère ses échantillons et le robot mobile reprend sa tournée.

XuP-Med effectue des livraisons de biens médicaux à travers les différents services de l’Hôpital. « Pendant-ce temps-là… », le personnel peut rester physiquement auprès des patients et se concentrer sur son cœur de métier. Les patients sont alors plus en sécurité avec un personnel soignant toujours à proximité. La qualité et la précision de la prestation des soins de santé sont maximisées. En automatisant les transports, XuP-Med participe à la réduction des déplacements du personnel soignant d’environ 9 km par robot et par jour. Cette limitation des déplacements énergivores participe à la réduction des RPS (Risques Psycho-Sociaux) et des troubles musculo-squelettiques du personnel.

Ce robot effectue ses livraisons de façon sécuritaire et autonome dans un environnement complexe en présence de brancardiers, patients, enfants… (Prise autonome d’ascenseur, ouverture automatique des portes, signalisation de présence etc.).

Article rédigé par Georges Simmonds pour RT Flash

Meanwhile

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Des ingénieurs de l’Université de Californie à Berkeley décrivent une avancée majeure dans la conception d’un composant des transistors – les minuscules commutateurs électriques qui constituent les éléments de base des ordinateurs – qui pourrait réduire considérablement leur consommation d’énergie sans sacrifier la vitesse, la taille ou les performances. Ce composant, appelé oxyde de grille, joue un rôle essentiel dans la mise en marche et l’arrêt du transistor. « Nous avons pu montrer que notre technologie d’oxyde de grille est meilleure que les transistors disponibles dans le commerce : Ce que l’industrie des semi-conducteurs, qui vaut des milliards de dollars, peut faire aujourd’hui, nous pouvons essentiellement le battre », a déclaré l’auteur principal de l’étude, Sayeef Salahuddin, professeur distingué de TSMC en génie électrique et informatique à l’Université de Berkeley.

Cette augmentation de l’efficacité est rendue possible par un effet appelé capacité négative, qui permet de réduire la quantité de tension nécessaire pour stocker une charge dans un matériau. Salahuddin a prédit théoriquement l’existence de la capacité négative en 2008 et a démontré pour la première fois cet effet dans un cristal ferroélectrique en 2011. La nouvelle étude montre comment une capacité négative peut être obtenue dans un cristal artificiel composé d’un empilement de couches d’oxyde de hafnium et d’oxyde de zirconium, qui est facilement compatible avec les transistors en silicium avancés. En incorporant le matériau dans des transistors modèles, l’étude démontre comment l’effet de capacité négative peut réduire de manière significative la quantité de tension nécessaire pour contrôler les transistors et, par conséquent, la quantité d’énergie consommée par un ordinateur.

« Au cours des dix dernières années, l’énergie utilisée pour l’informatique a augmenté de façon exponentielle, représentant déjà des pourcentages significatifs de la production mondiale d’énergie, qui ne croît que linéairement, sans qu’une fin soit en vue », a déclaré Salahuddin. « Habituellement, lorsque nous utilisons nos ordinateurs et nos téléphones portables, nous ne pensons pas à la quantité d’énergie que nous utilisons. Mais c’est une quantité énorme, et elle ne va faire qu’augmenter. Notre objectif est de réduire les besoins énergétiques de cet élément de base de l’informatique, car cela permet de réduire les besoins énergétiques de l’ensemble du système ».

Les ordinateurs portables et les téléphones intelligents de pointe contiennent des dizaines de milliards de minuscules transistors en silicium, dont chacun doit être contrôlé par l’application d’une tension. L’oxyde de grille est une fine couche de matériau qui convertit la tension appliquée en une charge électrique, laquelle commute ensuite le transistor.

Une capacité négative peut améliorer les performances de l’oxyde de grille en réduisant la quantité de tension nécessaire pour obtenir une charge électrique donnée. Mais cet effet ne peut pas être obtenu avec n’importe quel matériau. La création d’une capacité négative nécessite une manipulation minutieuse d’une propriété matérielle appelée ferroélectricité, qui se produit lorsqu’un matériau présente un champ électrique spontané. Auparavant, cet effet n’avait été obtenu que dans des matériaux ferroélectriques appelés pérovskites, dont la structure cristalline n’est pas compatible avec le silicium.

Dans l’étude, l’équipe a montré qu’il est également possible d’obtenir une capacité négative en combinant l’oxyde de hafnium et l’oxyde de zirconium dans une structure cristalline artificielle appelée super-réseau, ce qui entraîne une ferroélectricité et une antiferroélectricité simultanées.

Les chercheurs ont découvert qu’une structure en super-réseau composée de trois couches atomiques d’oxyde de zirconium prises en sandwich entre deux couches atomiques uniques d’oxyde de hafnium, totalisant moins de deux nanomètres d’épaisseur, fournissait le meilleur effet de capacité négative. Étant donné que la plupart des transistors au silicium les plus modernes utilisent déjà un oxyde de grille de 2 nanomètres composé d’oxyde de hafnium sur du dioxyde de silicium, et que l’oxyde de zirconium est également utilisé dans les technologies au silicium, ces structures en super-réseau peuvent facilement être intégrées dans des transistors avancés.

Pour tester les performances de la structure en super-réseau en tant qu’oxyde de grille, l’équipe a fabriqué des transistors à canal court et testé leurs capacités. Ces transistors nécessiteraient une tension inférieure d’environ 30 % tout en respectant les critères de référence de l’industrie des semi-conducteurs et sans perte de fiabilité, par rapport aux transistors à canal court.

Article rédigé par Georges Simmonds pour RT Flash

PW

|

|

|

|

|

|

|

|

|

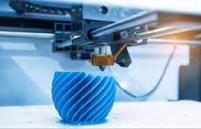

En 2017, les scientifiques du laboratoire de dispositifs photoniques appliqués de l’EPFL ont confectionné une imprimante 3D qui crée des objets de manière instantanée. Cinq ans plus tard, ils ont amélioré leur machine ainsi que leur méthode de fabrication et sont désormais capables d’imprimer dans des résines opaques, ce qui n’était pas le cas jusqu’à présent.

L’imprimante 3D conçue à l’EPFL est l’une des plus rapides du monde. Les imprimantes classiques recourent à un processus d’impression couche par couche tandis que celle de l’EPFL utilise le concept d’impression volumétrique. « On met de la résine dans un récipient que l’on fait tourner sur lui-même. Puis, on projette de la lumière sous différents angles, ce qui conduit à la solidification de la résine uniquement là où l’énergie accumulée dépasse un certain seuil. Cette technique s’avère très précise et peut façonner des objets d’une résolution équivalente aux méthodes d’impression actuelles », explique Christophe Moser, professeur. Les scientifiques peuvent confectionner n’importe quelle forme, ils se sont même amusés à fabriquer un Yoda miniature. À titre d’exemple, il leur a fallu seulement 20 secondes pour solidifier l’objet contre une dizaine de minutes avec une imprimante 3D classique.

Afin que la lumière fabrique l’objet voulu, elle doit interagir avec une molécule photosensible présente dans la résine et qui initie sa solidification. « Pour que le processus fonctionne, la lumière doit traverser la résine en ligne droite sans être déviée. Nous avons jusqu’à présent toujours utilisé de la résine transparente, mais nous souhaitions aussi être capables d’imprimer dans des résines opaques, utilisées dans le domaine biomédical », explique Antoine Boniface, post doctorant.

Mais, en employant de la résine opaque avec les techniques d’impression volumétrique, la propagation de la lumière est perturbée et la dose d’énergie résultante ne permet plus d’imprimer l’objet voulu. « Nous constatons une perte de résolution importante. Nous avons dès lors voulu chercher une méthode pour imprimer avec de la résine opaque sans perdre les atouts de notre imprimante » indique Jorge Madrid-Wolff, doctorant.

La technique mise en œuvre par les scientifiques s’avère plutôt simple. Ils ont observé la trajectoire de la lumière dans la résine à l’aide d’une caméra et ont compensé la distorsion par des calculs sur ordinateur. Ils ont ensuite implémenté sur l’imprimante la correction de la lumière envoyée. Ceci permet à cette dernière d’atteindre la bonne dose d’énergie lumineuse dans la résine et de créer l’objet. En réévaluant les calculs, les chercheurs sont alors capables d’imprimer des objets avec un degré de précision quasiment équivalent entre une résine transparente et opaque. Ce qui n’était pas le cas avant.

Ces résultats se montrent utiles pour fabriquer des objets en trois dimensions destinés à la biologie tels que des artères artificielles. À l’avenir, les chercheurs souhaitent aussi trouver un moyen d’imprimer dans plusieurs matériaux en même temps et de pousser la résolution de l’impression du dixième de millimètre au micromètre.

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

|

|

|

|

|

|

|

Westport Fuel Systems a mis au point un nouveau système de carburant capable de brûler de l'hydrogène dans les moteurs de poids lourds à combustion interne. Adaptable à partir d’un système HDI, il présente l’avantage de permettre facilement la conversion de moteurs thermiques existants.

Dans le développement des usages de l’hydrogène, la pile à combustible (qui permet de produire de l’électricité à partir d’hydrogène), tient le devant de la scène médiatique. Pour autant, l’injection directe d’hydrogène dans des moteurs classiques à combustion se développe de manière significative et offre des perspectives particulièrement intéressantes.

Parmi celles-ci, le nouveau système de Westport, baptisé H2 HPDI, offre de nombreux avantages soulignés par Scott Baker, vice-président, : « la puissance, le couple et le rendement dépassent largement ceux du moteur diesel de base car la combustion HPDI (système notamment développé par Westport pour de l’injection de gaz naturel à haute pression) conserve le taux de compression élevé du moteur diesel de base et ne souffre pas de cognement du moteur ; l’hydrogène étant injecté vers la fin de la course de compression, juste après l'allumage pilote et le début de la combustion ». Un véhicule de démonstration entièrement fonctionnel est d’ores et déjà opérationnel et a été présenté lors de l'ACT Expo 2022 à Long Beach (Californie). Objectif pour Westport : montrer la facilité avec laquelle un système HPDI, fonctionnant notamment au GNL, peut être converti à l’hydrogène.

DAF s'active aussi dans la motorisation à l'hydrogène. Le constructeur fait tourner depuis plusieurs mois à Eindhoven (Pays-Bas) un prototype de tracteur de semi-remorque original qui fonctionne avec un moteur thermique alimenté en hydrogène. DAF envisage de commercialiser son camion thermique à hydrogène dans cinq ans, en souhaitant le ravitailler avec de l’hydrogène renouvelable.

Article rédigé par Georges Simmonds pour RT Flash

H2

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Le constructeur Australien Aviation H2 compte convertir, d’ici l’année prochaine, ses carburéacteurs Jet-A standard en des versions à l’ammoniac vert, afin d’assainir ses vols commerciaux. Habituellement utilisé dans l’agriculture, ce produit serait notamment plus abondant industriellement et naturellement, mais aussi plus facile et moins coûteux à convertir en énergie que d’autres carburants « décarbonés » tels que l’hydrogène gazeux ou liquide.

Bien que loin derrière les voitures, le secteur aéronautique fait partie des plus grands émetteurs de gaz à effet de serre dans l’atmosphère. Un vol de Paris à New York à bord d’un Airbus A380, par exemple, consomme près de 111 000 litres de kérosène et génère 88 tonnes de CO2. Or, on enregistre plus de 30 millions de vols par an dans le monde, soit environ un vol par seconde.

Pour contribuer à la lutte contre le changement climatique, les sociétés aéronautiques cherchent depuis quelques années à réduire leur dépendance des carburants fossiles. L’hydrogène fait partie des alternatives les plus adoptées pour remplacer ces carburants. Cependant, l’hydrogène nécessite beaucoup d’investissements pour être exploité, car étant très léger, il doit être stocké en très grandes quantités pour pouvoir produire assez d’énergie pour alimenter des moteurs d’avions. Les réservoirs de stockage de carburant doivent donc être convertis en versions beaucoup plus grandes, pour pouvoir contenir l’hydrogène nécessaire. « L’hydrogène gazeux est très léger pour l’énergie qu’il contient, et l’hydrogène liquide est encore plus léger, mais les réservoirs sont grands et lourds », explique le directeur d’Aviation H2, Christof Mayer.

L’ammoniac pourrait alors être une source d’hydrogène, ou inversement, l’hydrogène pourrait être mélangé à de l’azote pour produire de l’ammoniac : dans les deux cas, le transport et le stockage seraient plus faciles, en intégrant l’ammoniac dans le cycle de production.

D’un autre côté, l’ammoniac est le deuxième composé chimique le plus produit au monde, avec plus de 160 millions de tonnes par an. De plus, de nombreuses sources potentielles et naturelles existent sur Terre, comme le fumier, le purin ou les eaux usées domestiques. Des gisements de sels d’ammoniac seraient également présents dans les couches terrestres profondes, ainsi que dans certaines roches et matières organiques fossilisées.

Aviation H2 considère ainsi cette abondante ressource comme vecteur énergétique prometteur et aisément exploitable. Bien que la société reste apparemment ouverte à l’utilisation de l’hydrogène, elle précise qu’elle va « simplement utiliser l’ammoniac pour l’instant. C’est la conversion la plus simple, et cela en fera intrinsèquement le plus fiable, ce qui en soi le rend intrinsèquement le plus sûr [des deux] », explique Christof Mayer. Pour réduire encore les répercussions possibles sur l’environnement, la société australienne compte d’ailleurs utiliser de l’ammoniac vert, produit par le biais de ressources renouvelables.

Pour alimenter les moteurs de ses avions, Aviation H2 compte utiliser la combustion de l’ammoniac. Les moteurs ordinaires seront modifiés pour pouvoir fonctionner à l’ammoniac et ainsi éliminer toute émission de CO2. « Ses principaux avantages incluent une densité d’hydrogène gravimétrique et volumétrique élevée qui le rend plus léger et plus facile à transporter, tout en offrant un taux de conversion d’énergie plus élevé », explique Helmut Mayer, co-directeur d’Aviation H2. Cette opération serait ainsi beaucoup plus rapide et moins coûteuse que la conversion d’une batterie fonctionnant à l’hydrogène.

« Nous devons modifier le système de stockage de carburant en quelque chose qui ressemble fondamentalement à un réservoir de GPL », explique Christof Mayer. Les nouveaux éléments à développer sont donc le stockage de carburant, le moteur lui-même et son système de contrôle, d’après l’expert, mais la conception de base du moteur resterait plus ou moins inchangée.

Article rédigé par Georges Simmonds pour RT Flash

AH2

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Des scientifiques du Max Planck Institute for Plant Breeding Research (MPIPZ) et de l’Université de Cologne, en Allemagne, ont découvert un nouveau mécanisme biochimique expliquant comment les protéines immunitaires défendent les plantes contre les micro-organismes envahisseurs.

Nous, les humains, comptons sur notre système immunitaire pour nous protéger des maladies causées par des micro-organismes nuisibles. De la même manière, les plantes développent également des réponses immunitaires lorsqu’elles sont envahies par des microbes nuisibles. Les acteurs clés de ces réponses immunitaires végétales sont les soi-disant récepteurs immunitaires, qui détectent la présence de molécules délivrées par des micro-organismes étrangers et déclenchent des réponses protectrices pour repousser les envahisseurs.

Un sous-ensemble de ces récepteurs immunitaires abrite des régions spécialisées appelées domaines du récepteur toll-interleukine-1 (TIR) et fonctionne comme des enzymes, des protéines spéciales qui décomposent la molécule nicotinamide adénine dinucléotide (NAD+), une petite molécule multifonctionnelle très abondante présente dans toutes les cellules vivantes. Répartition du NAD+, à son tour, active des protéines immunitaires supplémentaires, aboutissant finalement à la soi-disant "réponse hypersensible", un mécanisme de protection qui conduit à la mort des cellules végétales sur les sites de tentative d’infection comme moyen efficace de protéger la plante dans son ensemble. Cependant, des études ont montré que la dégradation du NAD+ bien qu’essentiel, n’est pas suffisant pour la protection des végétaux, ce qui suggère que des mécanismes supplémentaires doivent être impliqués.

Les auteurs, dirigés par les auteurs correspondants, Jijie Chai, affilié au MPIPZ, à l’Université de Cologne et à l’Université Tsinghua de Pékin, en Chine, Paul Schulze-Lefert du MPIPZ et Bin Wu de l’École des sciences biologiques de Nanyang et de l’Université technologique de Singapour ont examiné la fonction des protéines TIR et ont pu montrer que ces récepteurs non seulement décomposaient le NAD+, mais possèdent curieusement une fonction supplémentaire – les domaines TIR traitaient également des molécules avec des liaisons phosphodiester, généralement présentes dans l’ARN et l’ADN, qui sont présentes dans les cellules principalement sous forme de grandes molécules linéaires à simple ou double brin.

En utilisant l’analyse structurelle, les auteurs ont pu montrer que les protéines TIR forment différentes structures multiprotéiques pour la dégradation du NAD+ ou ARN/ADN, expliquant comment une même protéine peut remplir deux rôles. Pour cliver les molécules d’ARN/ADN, les protéines TIR suivent les contours des brins d’ARN/ADN et s’enroulent étroitement autour d’eux comme des perles sur un fil.

La capacité des protéines TIR à former deux complexes moléculaires alternatifs est une caractéristique de toute la famille des récepteurs immunitaires. La forme exacte des protéines TIR dicte ainsi l’activité enzymatique respective. Les auteurs ont ensuite montré que cette fonction elle-même n’était pas suffisante pour la mort cellulaire, suggérant que de petites molécules spécifiques générées par la dégradation de l’ARN et de l’ADN en étaient responsables. En utilisant la chimie analytique, les scientifiques ont pu identifier les molécules comme cAMP/cGMP (adénosine monophosphate cyclique/guanosine monophosphate cyclique), des nucléotides dits cycliques qui sont présents dans tous les règnes de la vie.

Si le 2′,3′-AMPc/GMPc favorise la mort cellulaire chez les plantes en réponse à une infection, il va de soi que leurs niveaux soient étroitement contrôlés. En effet, les auteurs ont découvert qu’un régulateur négatif connu de la fonction TIR chez les plantes, NUDT7, agit en appauvrissant le 2′,3′-cAMP/cGMP. Des régulateurs négatifs similaires sont libérés par certains micro-organismes pathogènes lors de l’infection à l’intérieur des cellules végétales, et les scientifiques pourraient montrer que ces protéines pathogènes appauvrissent également le 2′,3′-AMPc/GMPc. Cela suggère que les micro-organismes envahisseurs ont développé des stratégies intelligentes pour désarmer le mécanisme de défense des plantes dépendant du 2′,3′-AMPc/GMPc à leur propre avantage.

Dongli Yu, l’un des trois co-premiers auteurs de cette étude, avec Wen Song et Eddie Yong Jun Tan, résume ainsi l’importance de son étude : « Nous avons identifié un nouveau rôle pour le domaine TIR des récepteurs immunitaires dans la protection des plantes contre les infections. À l’avenir, l’identification et la caractérisation des cibles du 2′,3′-AMPc/cGMP suggéreront de nouvelles stratégies pour rendre les plantes plus résistantes aux microbes nocifs et ainsi contribuer à la sécurité alimentaire ».

Article rédigé par Georges Simmonds pour RT Flash

MPI

|

|

|

|

|

|

|

|

|

Née de travaux menés à l’Institut lumière matière, la start-up MexBrain développe des biopolymères capables de capter et retenir des métaux hors de la circulation sanguine. Ces molécules sont utilisées dans des appareils d’hémodialyse, dans l’espoir de soigner des pathologies associées à des dérégulations de l’homéostasie métallique.

Qu’ils soient naturellement présents dans l’organisme ou non, l’excès de métaux libres dans le sang est lié à différentes pathologies. Ces dérégulations de l’homéostasie métallique sont généralement abordées par phlébotomie, c’est-à-dire par saignées, ou par une thérapie de chélation, qui consiste à injecter dans la circulation des molécules qui capturent et éliminent les surplus de métaux dans le sang. Ce traitement, bien que très courant, souffre d’effets secondaires pouvant aggraver certains symptômes.

La quête pour des solutions thérapeutiques originales a franchi une nouvelle étape grâce à la start up lyonnaise MexBrain. Fondée en 2017, MexBrain est issue de travaux de chercheurs de l’Institut lumière matière (ILM), avec l’aide de chimistes, biologistes, vétérinaires et cliniciens du laboratoire Ingénierie des matériaux polymères et de l’école VetAgro Sup. Signe de l’intérêt suscité par MexBrain, une première levée de fonds lui a permis de récolter six millions d’euros en 2021.

« Les dérégulations de l’homéostasie métallique concernent à la fois des métaux endogènes essentiels à la vie, comme le cuivre et le fer, et des composés exogènes toxiques, tels que le plomb ou le cadmium », précise François Lux, maître de conférences à l’Université Claude Bernard de Lyon et cofondateur de MexBrain. Nous développons des traitements dans le cadre de la maladie de Wilson, mais les excès de métaux dans le sang sont plus généralement liés à des problèmes de stress oxydant et d’inflammation ». La maladie de Wilson est une pathologie génétique marquée par l’accumulation de cuivre dans l’organisme. Elle s’en prend aussi bien au foie qu’au cerveau.

MexBrain s’intéresse de plus aux hémochromatoses secondaires, une famille d’atteintes où un excès de fer, souvent lié à de multiples transfusions sanguines, provoque des lésions au foie, au pancréas, au cœur ou encore à la glande pituitaire. Les dérégulations de l’homéostasie métallique sont également liées à la formation des plaques amyloïdes impliquées dans les maladies de Parkinson ou d’Alzheimer, et accentuent la neurodégénérescence causée par le stress oxydant. La présence de fer ou de cuivre catalytique dans le sang, même en faibles quantités, peut également avoir un impact négatif pour les patients en unité de soin intensif, notamment dans les cas de sepsis, de pathologies du foie ou du rein. Ces dernières pathologies sont des indications de choix pour la start-up MexBrain, les praticiens ayant souvent recours à la dialyse.

Pour mieux traiter la maladie de Wilson, MexBrain a combiné des appareils d’hémodialyse, la dialyse du sang, avec des polymères chélatants. Principalement associée aux insuffisances rénales dans l’inconscient collectif, la dialyse est en effet une technique plus générale de purification de solutions à travers une membrane. Dans le système de MexBrain, le sang passe dans l’appareil où les métaux excédentaires sont éliminés grâce à l’action de biopolymères chélatants, qui n’entrent jamais dans la circulation sanguine.

D’un point de vue physico-chimique, la chélation est un phénomène où un ligand s’attache, par au moins deux liaisons de coordination, à un cation métallique, formant ainsi un complexe. Les biopolymères chélatants utilisés ici sont basés sur du chitosane, un polymère lui-même obtenu à partir de la chitine, une molécule naturelle que l’on retrouve dans la carapace des crabes et des crevettes, ainsi que dans les champignons. En plus d’être biocompatible, le chitosane a l’avantage d’être abondant et bon marché, car issu de déchets de l’industrie agroalimentaire.

Les chercheurs ont donné au chitosane un pouvoir chélatant en le fonctionnalisant avec du Dotaga, un ligand utilisé dans la conception d’agents de contraste employés pour des examens comme les IRM. La masse de l’ensemble l’empêche de traverser la membrane de l’hémodialyse. Une autre opération chimique, une acétylation, a permis de rendre le tout soluble à pH physiologique afin de remplir son rôle au contact du sang. Le biopolymère ainsi obtenu est déployé dans un système d’hémodialyse, qui parvient alors à capter spécifiquement certains métaux à l’extérieur de la membrane, ce qui signifie qu’ils ne peuvent ensuite plus repartir dans le sang.

Le polymère chélatant reste lui aussi à l’extérieur de la circulation sanguine, qu’il ne rejoint jamais. L’équipe de MexBrain a cependant bien vérifié que si cela arrivait par accident, le produit n’était pas toxique. Ce système d’hémodialyse a également été testé avec succès sur des moutons et trois membranes de dialyse commerciales différentes, là encore sans problèmes de toxicité. En deux cessions de quatre heures, plusieurs centaines de microgrammes de cuivre et de fer ont pu être extraites.

Un essai clinique pour le traitement de la maladie de Wilson est prévu pour 2022, puis MexBrain se penchera sur d’autres pathologies liées à des taux anormaux de métaux dans le sang. Le système de MexBrain pourrait par exemple aider les patients souffrant de sepsis, car un taux élevé de fer dans le sérum est associé à un mauvais pronostic vital, ou d’atteintes chroniques du foie ou des reins.

Article rédigé par Georges Simmonds pour RT Flash

ANR

|

|

|

|

|

|

|

|

|

C’est une première mondiale très prometteuse ! Des scientifiques UCLouvain sont parvenus à identifier et à actionner la clé qui permet au virus du covid de s’attaquer aux cellules. Malgré l’efficacité des campagnes de vaccination partout à travers le monde, la menace que représente la COVID-19 n’est pas encore totalement éloignée. Premièrement, nous ne sommes pas à l’abri de l’apparition d’un nouveau variant du SARS-CoV-2 contre lequel les vaccins actuels ne seraient pas efficaces. Ensuite, l’efficacité des vaccins sur le long terme reste inconnue. Enfin, des cas d’infection aiguë sont toujours rapportés. Or, à ce jour, aucun traitement efficace n’existe.

Afin de développer un antiviral empêchant l’infection, il est d’abord nécessaire de comprendre les mécanismes précis (au niveau moléculaire) utilisés par le virus pour infecter une cellule. C’est la tâche à laquelle s’attèle depuis 2 ans l’équipe de David Alsteens, chercheur à l’Institut des sciences et technologies biomoléculaires de l’UCLouvain. Ces chercheurs ont investigué l’interaction entre les acides sialiques (AS), sortes de résidus de sucre présents à la surface des cellules, et la protéine spike (S) du SARS-CoV-2 (à l’aide de la microscopie à force atomique). L’objectif ? Elucider son rôle dans le processus d’infection.

Toutes les cellules sont décorées avec des résidus de sucres. Le job de ces sucres ? Favoriser la reconnaissance des cellules, ce qui permet notamment aux virus d’identifier plus facilement leurs cibles. Mais également, faciliter leur point d’accroche pour leur permettre d’entrer dans leur cellule hôte et d’ainsi initier leur infection.

Les chercheurs UCLouvain ont mis en évidence une variante de ces sucres (9-O-acétylés) interagissant de manière plus forte avec la protéine S que les autres sucres. En clair, ils ont trouvé le trousseau de clés qui permet aux virus d’ouvrir la porte des cellules. Pourquoi un trousseau ? Le virus est composé d’une série de protéines spike, sortes de ventouses qui lui permettent de s’accrocher à la cellule et in fine d’entrer. Plus le virus trouve de clés, meilleure sera l’interaction avec la cellule et plus grand s’ouvrira la porte. D’où l’importance de trouver comment le virus parvient à démultiplier les clés d’entrée.

C’est là qu’intervient la 2e découverte des chercheurs UCLouvain : ils ont décidé de prendre le virus à son propre piège, en l’empêchant de s’accrocher à sa cellule hôte. Comment ? En bloquant les points d’accroche de la protéine S et donc en supprimant toute interaction avec la surface cellulaire. Comme si un cadenas bloquait la serrure de la porte d’entrée de la cellule. Pour ce faire, une des conditions est que l’interaction entre le virus et l’agent bloquant soit plus forte que celle entre le virus et la cellule.

Dans ce cas précis, les scientifiques ont démontré que des structures multivalentes (ou glycoclusters) présentant de multiples acides sialiques 9-O-acétylés à leur surface (la fameuse variante de sucre mise à jour par l’équipe UCLouvain) sont capables de bloquer aussi bien la liaison que l’infection du SARS-CoV-2. Si le virus ne s’attache pas aux cellules, il ne sait plus entrer et donc il meurt (temps de vie 1h à 5h). Grâce à ce blocage, on empêche l’infection.

Dans le cadre de la pandémie de COVID-19, les différents vaccins se sont attaqués principalement aux mutations du SARS-CoV-2, mais pas au virus dans son ensemble. Cette découverte UCLouvain a l’avantage d’agir sur le virus, indépendamment des mutations. La suite ? L’équipe UCLouvain va réaliser des tests sur la souris afin d’appliquer ce blocage des liaisons du virus et observer si cela fonctionne sur l’organisme. Les résultats ne devraient pas tarder et devraient permettre de mettre au point un antiviral à partir de ces sucres, administré par aérosol, en cas d’infection ou de contact à risque.

Article rédigé par Georges Simmonds pour RT Flash

UCL

|

|

|

|

|

|

|

|

|

La moitié des cancers chez l’enfant prennent leur origine lors du développement de l’embryon, ce qui rend la recherche particulièrement complexe. L’équipe de Valérie Castellani, directrice de recherche CNRS au laboratoire Mécanismes en sciences de la vie intégrative (CNRS/Inserm/Université Claude Bernard Lyon 1), a donc développé un modèle permettant de reconstituer au mieux cet environnement embryonnaire : une greffe de cellules cancéreuses dans un embryon de poulet.

Cette nouvelle méthode, qui lui a valu en 2018 la médaille de l’innovation du CNRS, ouvre la possibilité d’explorer les mécanismes qui permettent aux cellules cancéreuses de se répandre dans l’organisme, engendrant des métastases, et d’interroger l’impact des cellules saines sur le comportement de cellules malignes. C’est avec ce modèle que l’équipe de Valérie Castellani, en partenariat avec le laboratoire Biosanté (CEA/Inserm/Université Grenoble Alpes) et l’Institut d’hématologie et d’oncologie pédiatrique du Centre Léon Bérard1 a plus spécifiquement étudié le neuroblastome - un cancer pédiatrique qui prend naissance dans les cellules nerveuses encore immatures, et dont la forme métastatique est extrêmement agressive.

Les résultats de cette étude conduite par Dounia Ben Amar, doctorante co-encadrée par Céline Delloye-Bourgeois, chercheuse CNRS dans l’équipe, indiquent que le comportement des cellules de neuroblastome est influencé par certaines cellules nerveuses saines en développement. Au contact de ces dernières, les cellules cancéreuses acquièrent un comportement de dissémination métastatique.

Cette étude révèle donc que des cellules, pourtant saines, peuvent influencer la progression de tumeurs lors du développement de l’embryon. Elle illustre également l'importance de mieux comprendre le contexte singulier d'un organisme en développement dans ces cancers d'origine embryonnaire.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

|

|

|

|

|

|

|

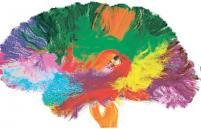

Plusieurs travaux ont montré des corrélations entre taille du cerveau et environnement social. Des chercheurs de l’Inserm (Institut national de la santé et de la recherche médicale), de l’Université Claude Bernard Lyon 1 et de l’Université de Pennsylvanie, se sont associés pour les compléter en travaillant sur une espèce de primates dont les caractéristiques cérébrales sont très proches de celles des humains : les macaques rhésus. Ils ont observé 68 adultes et 21 jeunes de moins de 6 ans, en milieu naturel, en notant l’intensité de leurs interactions sociales (par exemple, le toilettage, comportement relationnel très important chez ces singes) et leurs positions hiérarchiques dans le groupe. Puis ils ont soumis les macaques à des scanners cérébraux.

Plus les animaux adultes avaient un nombre important de compagnons, plus certaines régions de leur cerveau – l’insula antérieur et la partie médiane du sillon temporal supérieur – étaient de taille importante. Ces zones sont considérées comme primordiales pour se représenter les émotions et les comportements d’autrui.

Chez les jeunes macaques, ils ont montré qu’il n’y avait aucune corrélation entre la taille de leur réseau social et le volume de leur cerveau. Pour Jérôme Sallet, un des chercheurs, la signification de cette observation est claire : « Si nous avions observé la même corrélation chez les jeunes macaques que chez les adultes, cela aurait pu signifier que naître d’une mère très populaire (ayant beaucoup d’interactions avec le groupe), aurait pu prédisposer le nouveau-né à devenir à son tour populaire. Au contraire, nos données suggèrent que les différences que nous observons chez l’adulte seraient fortement déterminées par nos environnements sociaux, peut-être plus que par notre prédisposition innée ». Autrement dit, les modifications cérébrales ne seraient pas héritées génétiquement, mais par l’intensité des relations sociales pendant l’enfance, favorisée ou non par le comportement maternel.

Article rédigé par Georges Simmonds pour RT Flash

Inserm

|

|

|

|

|

|

|

|

|

Une imagerie cérébrale spécialisée pourrait percer les mystères de la maladie d'Alzheimer et d'autres problèmes de santé, croient des chercheurs canadiens. L'imagerie à résonance magnétique sensible à la neuromélanine, une méthode d'imagerie à haute résolution, pourrait potentiellement être utilisée pour le dépistage à grande échelle de la maladie d'Alzheimer. Elle pourrait également fournir des renseignements sur les stades précoces de la maladie des décennies avant que les premiers symptômes se manifestent.

Cette technique, a expliqué le Docteur Clifford Cassidy, de la Faculté de médecine de l'Université d'Ottawa, permet de voir des groupes de cellules qui se terrent dans les tréfonds du cerveau.

Avec cette nouvelle imagerie, on peut les trouver, on peut les observer et on peut voir si elles ont été endommagées, a-t-il résumé. Les chercheurs ont constaté une corrélation directe entre les dommages subis par ces cellules, appelées neuromodulateurs, la gravité de la maladie d'Alzheimer et certains symptômes comme l'agressivité et l'agitation qui peuvent être très problématiques, a dit le Docteur Cassidy.

Ces structures pourraient aussi être les toutes premières à être affectées par la maladie, plusieurs années avant que les premières manifestations deviennent apparentes. « Si on peut inspecter ces portions du cerveau au tout début de la maladie avec cette méthode, on pourrait espérer détecter qui est le plus à risque, et peut-être qu'à ce moment une intervention serait plus efficace ».

Les médecins ont à leur disposition des médicaments qui agissent sur ces neuromodulateurs. Cependant, tous les patients n'y répondent pas de la même manière et certains pourront ressentir des effets secondaires importants. La technique d'imagerie pourrait permettre de déterminer d'emblée quels patients sont le plus susceptibles de profiter de ces médicaments, espère le Docteur Cassidy, ce qui correspond à l'approche de la médecine personnalisée, qui retient beaucoup l'attention. L'imagerie à résonance magnétique sensible à la neuromélanine pourrait également se révéler utile avec des troubles comme la schizophrénie, le TDAH et le trouble bipolaire, a-t-il ajouté. Chez certains patients, même si ces neuromodulateurs semblent intacts, le signal qu'ils émettent a changé, et cela a été associé à certains symptômes ou à certains troubles psychiatriques.

Article rédigé par Georges Simmonds pour RT Flash

ITN

|

|

|

|

|

|

|

|

|

Une équipe de scientifiques internationaux de l'Université Anglia Ruskin (ARU) a mis au point un nouveau médicament anti-cataracte - testé sur des souris - qui améliorerait considérablement l’état du cristallin qui a tendance à s’opacifier avec l’âge. La cataracte est une opacification naturelle du cristallin de l'œil, principalement liée au vieillissement. Elle survient lorsque la lentille naturelle à l'intérieur de l’œil - le cristallin - développe des plaques nuageuses de protéines, entraînant une perte de vision et/ou une cécité. Le seul traitement actuel repose sur la chirurgie.

Ce médicament composé d'oxystérol VP1-001 aurait en effet montré des résultats extrêmement positifs lors de tests optiques. En clair, le traitement aurait montré une amélioration des profils d'indice de réfraction - un paramètre optique nécessaire pour maintenir une capacité de focalisation élevée - dans 61 % des lentilles. Les rongeurs ayant reçu ce médicament « ont eu une amélioration optique remarquable », puisque quasiment la moitié (46 %) ont vu leurs nuages de protéines diminuer. Ce qui signifie que l'organisation protéique du cristallin a été restaurée, que ce dernier a pu mieux se concentrer.

« Cette étude a montré les effets positifs d'un composé qui avait été proposé comme médicament anti-cataracte mais jamais testé auparavant sur l'optique de la lentille. C'est la première recherche de ce genre dans le monde », révèle le professeur Pierscionek, également membre du Medical Technology Research Center de l'Anglia Ruskin University (ARU). Néanmoins, « des améliorations se sont produites dans certains types de cataractes, mais pas dans toutes, ce qui indique qu'il peut s'agir d'un traitement pour des cataractes spécifiques ».

Les scientifiques devront ainsi distinguer les différents types de cataracte avant de proposer, à terme, des médicaments adaptés.

Article rédigé par Georges Simmonds pour RT Flash

ARU

|

|

|

|

|

|

|

|

|

Grâce à son cycle de vie, chaque cellule grandit pour atteindre la taille qui lui convient, acquiert les éléments nécessaires pour mener à bien ses fonctions, avant finalement de se diviser en deux nouvelles cellules. Le cycle des cellules est essentiel car il assure la perpétuation de la population cellulaire et, par extension, de la plus grande structure dont elles font partie, par exemple un tissu dans l’organisme.

Le cycle cellulaire lui-même est strictement régulé par des points de contrôle qui évitent que les erreurs telles que les mutations ou les dommages de l’ADN soient transmises aux générations suivantes de cellules. Chaque point de contrôle agit comme une sorte de moniteur de contrôle de la qualité (une "liste de contrôle" biologique) qui assure l’ordre, l’intégrité et la fidélité du cycle cellulaire. Mais les points de contrôle eux-mêmes sont souvent défaillants ou contournés après un arrêt prolongé du cycle cellulaire. Dans le corps humain, la conséquence pourrait en être une division et une croissance cellulaires anarchiques, comme cela se produit dans le cas du cancer.

« Les points de contrôle surveillent les cellules ou les organismes entiers et interrompent le cycle cellulaire, voire le développement de l’organisme, lorsqu’ils détectent un problème », explique Sahand Jamal Rahi, de la Faculté des sciences de base de l’EPFL. « Mais si les cellules ou les organismes sont bloqués par une erreur pendant une très longue période, il arrive souvent que les cellules continuent tout de même à se diviser ou à croître ; elles ne s’arrêtent pas indéfiniment. Le risque de mort est réel si les points de contrôle n’interrompent pas du tout le processus, mais l’attente permanente est aussi équivalente à la mort ».

Alors, comment la cellule jauge-t-elle le risque par rapport à la vitesse lorsqu’elle se divise ? Malgré son importance cruciale, le contournement du point de contrôle est un processus encore mal compris, autant du point de vue théorique que du point de vue expérimental. Mais dans un nouvel article, Sahand Jamal Rahi et ses collègues ont mis en avant la première théorie mathématique qui décrit le processus de contournement du point de contrôle. « Beaucoup d’organismes doivent prévoir ce qui va se passer », déclare-t-il. « Vous avez un problème et vous devez évaluer à quel point ce problème peut être néfaste, car ses conséquences ne sont pas certaines. Vous pourriez y survivre ou en mourir. La cellule doit donc de toute façon faire un pari sur l’avenir. Et dans cette étude, nous analysons les probabilités liées à ce pari ».

Comme organisme modèle de vie réelle, les chercheurs ont choisi d’observer la levure de bière Saccharomyces cerevisiae, utilisée depuis des siècles dans la fabrication du vin, en boulangerie et en brasserie. « Il existe des systèmes qui surveillent les organismes, et le point de contrôle des dommages de l’ADN dans la levure, qui en fait partie, est l’un des plus étudiés », indique Sahand Jamal Rahi. « Nous avons donc décidé de l’observer pour voir si nous pouvions trouver la logique derrière les contournements du point de contrôle. Nous avons commencé par une analyse mathématique sous-tendue par une question très simple : se pourrait-il que ces organismes jaugent le risque par rapport à la vitesse parce qu’ils doivent prévoir l’avenir ? »

Ce compromis entre risque et vitesse s’apparente au système de contrôle de qualité d’une chaîne d’assemblage en usine : jusqu’à quelle vitesse la production peut-elle aller sans altérer la qualité ? Comment atteindre l’équilibre entre qualité et efficacité ? « Ce compromis entre risque et vitesse des points de contrôle a déjà été évoqué par le passé, mais uniquement du point de vue qualitatif », estime Sahand Jamal Rahi. « Ce phénomène n’a jamais vraiment été pris au sérieux ou analysé. Je suppose que nous pouvons donc revendiquer la paternité de cette idée !»

Les chercheurs ont étudié la relation entre risque et vitesse. « La théorie consiste simplement à peser les différentes probabilités, nous calculons donc l’évolution des aptitudes de la cellule en comparant l’attente à la poursuite de l’autoréplication », explique Sahand Jamal Rahi. « L’organisme doit élaborer une stratégie qui implique de décider constamment s’il faut attendre ou poursuivre en fonction de la gravité de la situation de l’organisme à ce moment-là. Bien sûr, le fait d’attendre implique une progéniture de moins en moins importante. L’autre option consiste à prendre un risque, dans ce cas la cellule se divise et il existe une probabilité qu’elle survive et une autre probabilité qu’elle meure ». La théorie calcule à quel moment le risque et la vitesse s’équilibrent, déterminant ainsi le "moment" optimal. « Nous avons obtenu comme résultat une équation très simple », continue Sahand Jamal Rahi.

Même si elle a été développée pour la levure, cette théorie s’applique plus largement qu'aux seules cellules car elle ne prend en compte que le risque et la vitesse, des facteurs qui concernent tous les organismes. « La correspondance entre ce qui se passe chez la levure et ce qui se passe dans les cellules de mammifères n’est pas parfaite, car l’optimisation de leur croissance n’est pas la seule contrainte à laquelle les cellules de mammifères sont soumises », explique Sahand Jamal Rahi. « En revanche, quand les cellules deviennent cancéreuses, elles dissocient leurs propres aptitudes de celles de leur hôte. La théorie de l’évolution darwinienne suggère en outre qu’elles devraient remodeler leurs points de contrôle pour optimiser la croissance. Nous nous intéressons particulièrement à ce point et l’une de nos prochaines étapes consistera à étudier si les cellules modifient les connexions de leurs points de contrôle de manière optimale lorsqu’elles deviennent cancéreuses ».

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

|

|

|

|

|

|

|

Les arythmies cardiaques sont l’une des principales causes de mortalité dans le monde occidental. Pour les cardiologues, mieux comprendre ces processus et pouvoir localiser l’endroit précis où se situe le problème dans le cœur est donc primordial. « Avec MusiCardio, nous allons pouvoir partir d’IRM envoyées par des radiologues et créer des maillages, c’est-à-dire des représentations 3D du cœur ou d’une partie du cœur, afin de créer des simulations précises de ce qui se passe dans cet organe » explique Pauline Migerditichan. Ce processus permet aux personnels de santé de passer d’une vision 2D (avec les IRM) à une vision 3D du problème.

À l’heure actuelle, lorsqu’un patient souffre d’un problème cardiaque, les médecins peuvent insérer un cathéter qui va parcourir les parois internes du cœur pour cartographier son activité électrique. Cependant, cette technique permet uniquement une analyse en surface et le temps d'intervention est très long pour les patients. « Le but de notre recherche, c’est de donner aux cardiologues toutes les informations dont ils ont besoin sur ce qui se passe dans le cœur à un instant-T sans qu’ils aient besoin d’opérer pour aller voir par eux-mêmes » précise Pauline Migerditichan. Pour cela, les chercheurs et les chercheuses développent une méthodologie basée sur un "problème inverse" (des équations difficiles à résoudre) : grâce à des collaborations avec des médecins de l’IHU Liryc, les scientifiques vont analyser les électrocardiogrammes réalisés par des médecins et vont essayer de reconstruire, grâce à la construction de maillages et la résolution numérique du problème inverse, ce qui se passe au niveau de l’épicarde (surface du cœur) ou de l’endocarde (l’intérieur).

« Une fois que nous avons réalisé un maillage, il faut vérifier qu’il soit bien conforme à la réalité clinique » éclaire la jeune ingénieure. Pour cela, les scientifiques de l’équipe-projet Carmen sont en étroite collaboration avec les personnels de santé de l’IHU Liryc. Ainsi, les scientifiques vont pouvoir confronter leur reconstruction, réalisée grâce à des techniques mathématiques et informatiques, aux données recueillies lors des opérations à l’aide de cathéters ainsi qu’aux informations recueillies sur les électrocardiogrammes. Et cela dans le but de définir une méthode non invasive qui corresponde au mieux à la réalité clinique.

Article rédigé par Georges Simmonds pour RT Flash

Inria

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|