|

|

Edito

En 2040, chacun aura son jumeau numérique virtuel et ses médicaments totalement personnalisés

Une extraordinaire mutation scientifique et médicale est en route. Elle va permettre, bien plus vite qu’on ne le pense, de proposer aux patients des médicaments entièrement conçus sur mesure et fabriqués la demande. Parallèlement, chacun d’entre nous disposera dans quelques années, dès sa naissance, d’un véritable "jumeau numérique" qui permettra de tester virtuellement les innombrables combinaisons thérapeutiques qui seront utilisées pour prendre en charge de la façon la plus efficace possible les différentes pathologies.

Le premier médicament commercialisé imprimé en 3D a été approuvé aux Etats-Unis par la FDA en 2015. Sa substance active est le lévétiracétam. Le choix de l’impression 3D pour ce médicament a permis d’obtenir un comprimé qui se dissout plus facilement et convient mieux aux patients souffrant de troubles de la déglutition. Partout dans le monde, des équipes de recherche travaillent sur la conception et la production personnalisées de médicaments et les progrès dans ce domaine sont impressionnants. Des pharmacologues et des bioingénieurs de l’University of East Anglia (UEA, Norwich) développent par exemple une technologie permettant d'imprimer des pilules en 3D (Voir Science Direct). Cette nouvelle technique de fabrication par impression 3D de médicaments, sous forme de structures poreuses, permet de contrôler la vitesse de libération de l’agent actif, une fois le médicament absorbé par voie orale.

L’objectif des chercheurs est d’optimiser les différents paramètres qui contribuent à l’efficacité d’un médicament, porosité, dose, durée de libération. Cette approche permet également de simplifier sensiblement la posologie, en intégrant plusieurs médicaments dans une poly-pilule unique, pour les patients qui sont obligés de prendre plusieurs molécules différentes. Cette nouvelle approche thérapeutique et pharmacologique est bien mieux adaptée aux patients âgés, de plus en plus nombreux, qui prennent souvent de nombreux médicaments chaque jour, ainsi qu’aux patients souffrant de maladies graves, comme le cancer, ou les maladies neurodégénératives.

Une autre équipe britannique, dirigée par Lee Cronin (Cronin Lab de l’Université de Glasgow), a mis au point une plate-forme de laboratoire robotique qui produit molécules et médicaments. Fin 2018, ces chercheurs avaient publié une étude remarquée sur le "chemputer", une plate-forme de laboratoire robotique capable de synthétiser des composés organiques à partir de méthodes standardisées et d’un outil logiciel de description chimique, nommé XDL (Voir Science). En octobre 2020, ces chercheurs ont franchi une étape supplémentaire vers l’ingénierie chimique numérique, grâce à un nouveau logiciel qui sait traduire les articles universitaires en programmes exécutables directement par le "chemputer". Le système traduit les instructions en XDL ; celles-ci sont alors transmises au chemputer qui exécute les actions mécaniques correspondantes (Voir Science).

L’équipe de Lee Cronin voit cette plate-forme comme le «Spotify de la chimie» et l’a mise à disposition de la communauté scientifique qui peut y puiser des formules chimiques utilisables dans ses propres robots chimistes. Ce système ouvert, coopératif et cumulatif, vise, entre autre, à permettre aux pays en développement de produire plus facilement, et à moindre coût, des médicaments, en développant leurs propres robots grâce aux instructions mises à disposition gratuitement sur internet. Mais ce chemputer fait également merveille en recherche fondamentale. En juin dernier, des chercheurs l’ont utilisé sans instructions précises pour produire une molécule particulière. Le robot a alors combiné des molécules simples, puis il a observé le résultat et a décidé, dans certains cas, d’ajouter d’autres molécules, ce qui a abouti, au bout d’un mois, à la découverte de molécules complexes à partir de précurseurs simples.

Il y a quelques semaines, Le Centre anticancéreux Gustave Roussy a également annoncé, par la voix de son nouveau directeur général, Fabrice Barlési, une nouvelle stratégie ambitieuse visant à accélérer la généralisation des traitements sur mesure, entièrement personnalisée pour chaque patient, à l’horizon 2030. « Face aux immenses défis que pose le cancer à notre société et la nécessité d’aider les adultes et les enfants vivant avec cette maladie, nous allons transformer profondément notre approche scientifique, médicale et technologique, au bénéficie des patients mais aussi de toute la société », a précisé le Professeur Barlesi. Cet oncologue thoracique, bouillonnant d’idées, a également présenté un autre projet pour le moins stupéfiant porté par les équipes de Gustave Roussy : la création d’avatars de patients, destinés à tester de manière virtuelle les traitements anti-cancers afin de vérifier leur niveau d’efficacité sur le malade. L’objectif ambitieux du Centre Gustave Roussy est de proposer d’ici 2030, à tous les patients en échec thérapeutique, un traitement personnalisé, testé et ajusté sur des organoïdes, reproduisant fidèlement toutes les spécificités génétiques et moléculaires de leur tumeur.

Ce Centre anticancéreux réputé va également produire des médicaments sur-mesure, en ayant recours à l’impression 3D. Un projet, mené en collaboration avec la société FabRX, vise par exemple, dans le domaine du cancer du sein localisé, à produire un seul comprimé associant la molécule anti-cancéreuse et le traitement destiné à lutter contre les effets secondaires. Il s’agit, selon les chercheurs, de faciliter le suivi du traitement par les patientes, un objectif-clé, quand on sait, grâce à l’analyse de la cohorte CANTO, que jusqu’à 50 % des patientes ont une observance irrégulière en hormonothérapie, ce qui augmente leur risque de décès. Ces comprimés composites seront imprimés à l'aide de l'imprimante 3D pharmaceutique de FabRx, M3DIMAKER, et seront ensuite testés dans une étude clinique rassemblant 200 patientes, qui permettra d’évaluer l’efficacité et l'adhésion au traitement par rapport à la prise en charge actuelle. Comme le soulignent Maxime Annereau, pharmacien responsable de ce projet à Gustave Roussy et la Docteure Barbara Pistilli, oncologue, « de nombreuses femmes atteintes d'un cancer du sein localisé sont traitées par hormonothérapie pendant cinq ans. Elles doivent souvent prendre d'autres traitements pour gérer les effets secondaires. C’est pourquoi la possibilité de pouvoir prendre tous ces traitements dans un seul comprimé imprimé en 3D avec un dosage personnalisé devrait améliorer l'adhésion au traitement, en proposant à nos patientes un médicament sur-mesure ».

Il y a quelques jours, une étude internationale intitulée "Produire rapidement de nouveaux médicaments grâce à l’impression 3D" (Voir Science Direct) est venue confirmer l’immense potentiel des nouvelles techniques d’impression 3D en matière de production de médicaments. Ces recherches, dirigées par le Professeur Abdul Basit, du Collège universitaire de Londres, ont montré qu’il était possible d’imprimer en moins de 20 secondes un médicament, en ayant notamment recours à la technique de photopolymérisation en cuve qui ne requiert pas de chaleur élevée et repose sur la dissolution du médicament dans une solution chimique photoréactive. Il suffit ensuite d’exposer à la lumière cette substance pour la solidifier et obtenir, in fine, une tablette de médicaments. Toute la subtilité de ce procédé repose sur un contrôle en temps réel extrêmement fin de la variation rapide des angles d’exposition à la lumière, afin de parvenir à une parfaite homogénéisation de la solidification du médicament final.

En France, Dassault Systèmes et l’Inria ont annoncé, il y a quelques semaines, une alliance stratégique dans le domaine des jumeaux numériques appliqués au secteur de la santé. A l’occasion du CES 2022, qui s’est tenu début janvier à Las Vegas, Dassault Systèmes a présenté ses dernières avancées dans ce domaine, et elles sont impressionnantes. Sa plate-forme 3DExperience permet en effet de recréer une expérience globale de jumeau virtuel sur le corps humain et de disposer d’un espace virtuel d’expérimentation pour intégrer la modélisation, la simulation, les données et la collaboration des différents acteurs. Au cours de sa présentation, Dassault Systèmes a insisté sur le fait que les modèles virtuels du coeur, du cerveau et des poumons, ont à présent suffisamment progressé pour qu’il soit possible de réaliser un jumeau virtuel complet du corps humain. « L’industrie, les chercheurs, les médecins et même les patients vont pouvoir visualiser, tester, comprendre et prédire ce qui ne peut être vu, avant que le patient ne soit traité, qu’il s’agisse de la façon dont les médicaments agissent sur une maladie, ou des résultats attendus d’une intervention chirurgicale », a précisé le groupe français.

L’Inria est également fortement engagé dans plusieurs projets de recherche concernant la personnalisation des traitements, et les patients virtuels numériques. Parmi ces projets, on peut évoquer SIMBIOTX, lancé en mars 2021 par Dirk Drasdo, spécialiste de la bio-informatique au niveau cellulaire et Irene Vignon-Clementel, chercheuse en ingénierie biomédicale in silico. En additionnant leurs compétences, ces deux scientifiques ont développé à la fois de nouveaux modèles dynamiques, capables de suivre l’évolution spatiotemporelle de systèmes in vitro et in vivo, de la cellule individuelle aux tissus et organes, et des outils macroscopiques de simulation du flux sanguin. Cette double approche a ainsi permis d’articuler les différents niveaux de connaissance et d’action, entre les mécanismes et processus qui s’effectuent à l’échelle microscopique et cellulaire, et les conséquences systémiques qui en découlent au niveau des tissus et organes.

Ce projet SIMBIOTX a déjà permis de démontrer qu’on pouvait rapprocher des coupes de tissus tumoraux et des données issues des différents outils d’imagerie. À terme, ces nouveaux outils seront des aides précieuses pour établir de manière plus rapide, plus fiable et moins invasive, les diagnostics en cancérologie, mieux suivre et anticiper la progression de la maladie, et adapter les traitements en temps réel. Ce projet vise également à mieux évaluer, grâce à de nouveaux modèles "hémodynamiques", les risques chirurgicaux, notamment dans le domaine cardiaque et hépatique. L’un des objectifs, en partenariat avec l’équipe d’Eric Vibert, professeur de chirurgie à l’Université Paris-Saclay, est de prédire la réaction du foie d’un malade particulier à une ablation partielle, en fonction de la redistribution du débit et de la pression sanguine. « En utilisant ces nouveaux modèles et la puissance de calcul dont nous disposons à présent pour analyser le réel sans le simplifier, cette collaboration a permis d’améliorer notre compréhension de l’hémodynamique. Concrètement, cela permet une meilleure anticipation des conséquences de nos actes chirurgicaux, et une meilleure sélection des malades opérables », souligne le Pofesseur Vibert.

Cette révolution scientifique et médicale en cours passe également par la conception numérique de médicaments "sur mesure", grâce aux extraordinaires progrès de l’intelligence artificielle. Et le moins qu’on puisse dire, c’est que dans ce domaine également, une véritable révolution est en marche. Celle-ci a connu une accélération décisive fin 2020, quand le laboratoire d'intelligence artificielle de Google, DeepMind, a sidéré la communauté scientifique internationale en présentant AlphaFold 2, un outil prodigieux, qui s’est avéré capable de prédire en quelque jours (contre parfois plusieurs décennies avec les méthodes classiques de cristallographie par rayons X), avec une précision presque parfaite, 90 % de la structures tridimensionnelle de nombreuses protéines, à partir de leur séquence primaire. Ce fantastique outil devrait enfin permettre de connaître dans un proche avenir la structure tridimensionnelle des deux millions de protéines identifiées à ce jour, un enjeu décisif, quand on sait que c’est cette structure qui détermine les propriétés thérapeutiques de ces protéines… La dernière prouesse connue, celle d’AlphaFold 2 ne remonte qu’à quelques semaines, quand cet outil d’IA a permis à des chercheurs de l'Université Tsinghua à Pékin, de l'Université de l'Illinois à Urbana-Champaign et du Massachusetts Institute of Technology (MIT), de modifier un anticorps connu contre la Covid-19, mais qui n'avait aucune efficacité contre ce virus, de manière à renforcer considérablement son efficacité contre tous les variants de la maladie (Voir PNAS).

Evoquons enfin la nouvelle plate-forme bioinformatique présentée il y a quelques jours par des chercheurs de l'excellent Centre Anderson contre le Cancer (Université du Texas). Cet outil est capable de prédire les meilleures combinaisons de traitement pour un patient donné, en fonction des altérations génétiques et des caractéristiques moléculaires spécifiques de chaque tumeur. Il a déjà fait la preuve de son utilité, en améliorant l'efficacité thérapeutique des traitements personnalisés proposés aux malades (Voir aussi MDAnderson) et il ne fait pas de doute qu’il est appelé à se généraliser rapidement et à devenir un auxiliaire absolument indispensable dans le choix des multiples combinaisons thérapeutiques personnalisées proposées à chaque malade.

On le voit, l’avenir appartient à la conception et la production sur mesure de nouveaux médicaments, et l’expérimentation personnalisées de ces nouvelles thérapies sur un "double numérique" qui aura une capacité prédictive de plus en plus grande, à mesure que la puissance informatique disponible grandira. Nous allons donc, en moins d’une génération, passer dans l’ère de la médecine prévisionnelle et virtuelle qui sera capable de nous traiter avant même que nous ne soyons atteints par la maladie, ou que nous n’en ressentions les premiers symptômes. Cette révolution en cours va non seulement bouleverser le rôle du médecin et complètement transformer la finalité de nos structures de soins, mais elle va encore plus largement modifier notre conception même de la santé et du bien-être, ce qui aura de profondes conséquences économiques, sociales et politiques, qu’il nous faut dès à présent anticiper, pour que cette médecine prédictive et ubiquitaire soit accessible à tous et reste guidée par une éthique collective puissante…

René TRÉGOUET

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

e-mail : tregouet@gmail.com

|

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

L’hydrogène est l’élément chimique le plus simple : son noyau se compose d’un unique proton et son atome ne compte qu’un électron. La molécule de dihydrogène (H2) est constituée de deux atomes d’hydrogène. On parle donc communément d’hydrogène pour désigner en fait le dihydrogène. Il est également l’élément chimique le plus abondant dans l’univers, mais pas à l’état pur. Il est toujours lié à d’autres éléments chimiques, dans des molécules comme l’eau (H2O) ou les hydrocarbures. Potentiellement inépuisable, non-émetteur de gaz à effet de serre, acteur de la combustion et facile à transporter, l’énergie hydrogène est considérée comme la "source d’énergie" propre idéale. Or, l’hydrogène n’est pas une source d’énergie mais un "vecteur énergétique" : il doit être produit puis stocké avant d’être utilisé. Il pourrait jouer à l’avenir un rôle essentiel dans la transition énergétique en permettant de réguler la production d’électricité générée par les énergies renouvelables intermittentes (solaire et éolien).

Actuellement, la production industrielle d’hydrogène se fait essentiellement à partir de combustibles fossiles, bien que ces techniques ne soient pas toujours respectueuses de l’environnement. L’avancement des techniques électrochimiques de génération d’hydrogène est essentiel pour résoudre les problèmes de durabilité et d’énergie. Parmi les différentes manières de produire de l’hydrogène, l’électrolyse de l’eau est une approche facile et écologique, utilisée depuis plus de deux siècles. Il s’agit de séparer la molécule d’eau en ses deux éléments (hydrogène et oxygène) à l’aide d’un courant électrique.

La réaction de l’aluminium et du gallium avec l’eau est connue depuis les années 1970. L’aluminium est un métal très réactif, capable d’arracher l’oxygène des molécules d’eau pour générer de l’hydrogène. Son utilisation, notamment pour contenir des produits de type liquides — comme les canettes, ne présente aucun danger, car l’aluminium réagit instantanément avec l’air pour former une couche d’oxyde d’aluminium. Ce bouclier empêche toute réaction ultérieure. Le gallium est un élément chimique de la famille des métaux pauvres, présentant la plage d’état liquide (c’est-à-dire la différence entre point de fusion et point d’ébullition) la plus importante de tous les éléments. En effet, sa température de fusion est de 29,76 degrés Celsius, ce qui le fait presque instantanément fondre dans la main. Il est principalement utilisé en alliage avec l’arsenic dans l’arséniure de gallium GaAs, un semi-conducteur très utilisé en optoélectronique. Cet élément permet également d’obtenir des images de sites d’inflammation par scintigraphie, en imagerie médicale. Dans le cas présent, c’est son interaction avec l’aluminium qui nous intéresse. Il permet d’éliminer le revêtement passif d’oxyde d’aluminium de ce dernier, le mettant en contact direct avec l’eau.

Un des auteurs de l’article, B. Singaram, a déclaré que l’idée est née d’une conversation qu’il a eue avec un étudiant, le co-auteur Isai Lopez. Ce dernier avait vu des vidéos sur l’interaction galium-aluminium-eau et commencé à expérimenter la génération d’hydrogène dans sa cuisine. B. Singaram explique dans un communiqué : « Il ne le faisait pas de manière scientifique, alors je l’ai mis en contact avec un étudiant diplômé pour faire une étude systématique. J’ai pensé que cela ferait une bonne thèse pour lui de mesurer la production d’hydrogène à partir de différents rapports de gallium et d’aluminium ».

En testant plusieurs types de compositions d’alliages, contenant plus ou moins de gallium par rapport à l’aluminium, l’équipe de recherche s’est rendu compte que les taux de production d’hydrogène étaient étonnamment élevés. Le plus grand rendement provenait d’un composite gallium-aluminium (Ga – Al) 3:1. Ces observations ont conduit les chercheurs à s’interroger sur les caractéristiques fondamentales, et obligatoirement différentes, de cet alliage riche en gallium. Le gallium reste intact et a été facilement récupéré pour être réutilisé après la réaction. Ceci donne 90 % de l’hydrogène pouvant, théoriquement, être produit à partir de la dégradation de tout l’aluminium dans le composite. S. Oliver a déclaré : « Nous n’avons besoin d’aucun apport d’énergie, et l’hydrogène bouillonne. Je n’ai jamais rien vu de tel ». Le gallium pourrait donc être collecté et réutilisé indéfiniment. Enfin, le composite peut être stocké pendant au moins 3 mois, en le recouvrant de cyclohexane pour le protéger de l’humidité.

Outre l’intérêt majeur en matière de quantité d’hydrogène produite, un second point positif apparaît : n’importe quel type d’aluminium et d’eau peut être utilisé. Effectivement, la synthèse du composite Ga-Al se produit sans avoir besoin d’une atmosphère inerte ou d’une aide mécanique. L’aluminium commercial peut être utilisé, y compris le papier d’aluminium usagé, généralement jeté. Toute source d’eau disponible peut être utilisée, comprenant les eaux usées, les boissons commerciales ou même l’eau de mer, sans génération de chlore gazeux.

Il ne reste plus qu’à attendre l’approbation du brevet, puis la mise en œuvre sur le marché industriel de cette procédure, notamment pour les batteries à hydrogène. L’hydrogène soutiendra également les énergies solaires et éoliennes, en tant que vecteur d’énergie. En effet, les énergies renouvelables sont une solution efficace par rapport aux enjeux énergétiques et écologiques d’aujourd’hui, mais leur intermittence peut parfois compliquer la gestion de leur distribution.

Article rédigé par Georges Simmonds pour RT Flash

UCSC

|

|

|

|

|

|

|

|

|

Un gradiomètre de gravité quantique est un appareil destiné à mesurer dans l'espace le gradient d'une grandeur physique. Un gradiomètre de gravité mesure donc les variations de la gravité. Et dans le cas d'un gradiomètre de gravité quantique, la mesure se fait en exploitant les principes de la physique quantique. Grâce à un capteur qui mesure les changements de gravité lorsqu'un nuage d'atomes tombe. Les vibrations, l'inclinaison des instruments et les perturbations causées par les champs magnétiques et thermiques extérieurs ont longtemps confiné la technologie au laboratoire. Mais aujourd'hui, des chercheurs de l’Université de Birmingham (Royaume-Uni) annoncent être parvenus à atténuer ces différents bruits et avoir trouvé au gradiomètre de gravité quantique une application pratique. Avec son aide, ils ont détecté un tunnel enterré à un mètre sous la surface en mesurant des variations de microgravité.

Les chercheurs estiment que leur gradiomètre de gravité quantique permettra à l'avenir de réaliser des relevés moins coûteux et dix fois plus rapidement qu'avec les capteurs classiques. Le tout avec une précision et une fiabilité accrues. Les applications envisagées sont nombreuses. Des applications de défense et de sécurité, par exemple. Puisque de telles mesures de microgravité pourraient permettre de révéler l'indétectable et ainsi, de se déplacer sereinement, y compris dans des environnements difficiles. Le gradiomètre de gravité quantique pourrait aussi révolutionner notre façon de concevoir, de construire et d'entretenir nos logements et nos infrastructures. Il pourrait aider à identifier des ressources naturelles -- ou des structures bâties cachées sous terre -- ou même, améliorer la prédiction des phénomènes de type éruptions volcaniques.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Des scientifiques de l’Université de Cambridge avaient déjà montré que des catalyseurs biologiques, des enzymes, peuvent produire des carburants de façon propre, en utilisant des sources d’énergie renouvelables, mais avec une faible efficacité. Cette fois, ils ont réussi à améliorer l’efficacité de la production de carburant par un facteur 18 dans des conditions de laboratoire, ouvrant ainsi la voie vers une transformation industrielle du CO2 en carburants propres.

La plupart des méthodes de conversion du CO2 en carburant vont aussi mener à la création de sous-produits, comme de l’hydrogène. Les scientifiques peuvent modifier les conditions chimiques pour minimiser la production de ce gaz, mais cela réduit aussi la performance pour la conservation de CO2. Il est donc possible de créer du carburant plus propre, mais au prix d’une efficacité moindre. La preuve de concept de l’Université Cambridge s’appuie sur des enzymes isolées dans des bactéries pour alimenter les réactions chimiques qui convertissent le CO2 en carburant, dans le cadre d’un processus appelé électrolyse. Les enzymes sont plus efficaces que d’autres catalyseurs, comme l’or, mais elles sont très sensibles à leur environnement chimique. Si celui-ci n’est pas parfait, les enzymes se désorganisent et les réactions chimiques sont lentes.

Les chercheurs universitaires ont ainsi mis au point une méthode pour améliorer l’efficacité de l’électrolyse en peaufinant les conditions pour modifier l’environnement des enzymes.

« Les enzymes ont évolué pendant des millions d’années pour devenir extrêmement efficaces et pointilleux, et ils sont très utiles pour produire du carburant, parce qu’ils ne mènent pas à la création de sous-produits », mentionne Esther Edwardes, l’autrice principale de l’étude. « Cependant, la sensibilité des enzymes vient avec ses propres défis. Notre méthode tient compte de cette particularité, pour que l’environnement local soit modifié pour correspondre aux conditions idéales des enzymes ». Les scientifiques ont utilisé des méthodes informatiques pour concevoir un système pour améliorer l’électrolyse du CO2. En utilisant le système s’appuyant sur des enzymes, le niveau de production de carburant a augmenté par un facteur de 18, comparativement à la solution témoin.

Pour améliorer encore un peu plus l’environnement où se produit la réaction chimique, l’équipe a été en mesure de démontrer que deux enzymes peuvent travailler de concert, l’une pour produire le carburant, tandis que l’autre contrôle l’environnement. De fait, ajouter cette deuxième enzyme a permis d’accélérer les réactions, améliorer l’efficacité du procédé, mais aussi de réduire les sous-produits indésirables. « Nous nous sommes retrouvés avec le carburant que nous voulions, sans sous-produits, et avec seulement des pertes d’énergie marginales », mentionne le Docteur Sam Cobb, l’un des auteurs de l’étude. « En nous inspirant du monde de la biologie, cela nous aidera à développer de meilleurs systèmes de catalyseurs synthétiques, ce qui est nécessaire si nous voulons déployer l’électrolyse du CO2 à grande échelle ».

Aux yeux du professeur Erwin Reisner, « l’électrolyse a un grand rôle à jouer pour réduire les émissions carbone. Plutôt que de capter et stocker le CO2, ce qui est extrêmement énergivore, nous avons démontré l’existence d’un nouveau concept pour capter le carbone et en faire quelque chose d’utile, le tout en étant écoénergétique ». Selon les chercheurs, le secret d’une électrolyse plus efficace du CO2 se trouve du côté des catalyseurs ; leur déclinaison artificielle s’est améliorée avec les années, mais n’est pas encore aussi efficace que les enzymes.

Article rédigé par Georges Simmonds pour RT Flash

University of Cambridge

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Dans le cerveau des mammifères, l’activité électrique des neurones répond à des rythmes oscillatoires détectables par électroencéphalogrammes (EEG). L’activation coordonnée de ces différentes ondes, qui régit par exemple le traitement des stimuli sensoriels ou la consolidation des souvenirs, permet au cerveau de fonctionner correctement. « Nous soupçonnions le rôle déterminant des ondes gamma, la fréquence la plus élevée des rythmes cérébraux, dans l’apparition des symptômes de la schizophrénie », indiquent Stephan Eliez, professeur au Département de psychiatrie, et Christoph Michel, professeur au Département de neuroscience fondamentale, qui ont codirigé ces travaux. « Nous devions cependant encore confirmer que cette anomalie de synchronisation des voies de communication neuronale observées chez la souris existait bien chez l’humain ».

Les personnes porteuses d’une microdélétion chromosomique 22q11 ont entre 25 % et 30 % de risques de développer une schizophrénie à l’âge adulte. « Elles constituent donc une population à risque particulièrement pertinente pour étudier le développement cérébral de cette maladie », indique Valentina Mancini, doctorante dans le laboratoire de Stephan Eliez et première auteure de cette étude. Les personnes schizophrènes souffrent souvent de capacités réduites de traitement des informations auditives; afin de détecter d’éventuelles perturbations de la communication cérébrale, les scientifiques ont donc mesuré l’activation des ondes gamma suite à un stimulus auditif chez des patient-es 22q11 de tous âges, et chez des personnes sans cette microdélétion.

« Les enfants et adolescent-es à risque génétique de troubles schizophrènes mais sans symptômes visibles présentaient les mêmes schémas de perturbation des ondes gamma que les patient-es souffrant effectivement de la maladie », détaille Vincent Rochas, collaborateur scientifique au laboratoire de Christoph Michel. En outre, une croissance linéaire des oscillations de la bande gamma était observable chez les personnes sans prédisposition génétique à la schizophrénie, montrant une maturation progressive de la communication entre les aires cérébrales lorsque l’on grandit. « Or, cette maturation est absente chez les patient-es 22q11, quel que soit leur âge, ce qui suggère un développement anormal des circuits sous-tendant les oscillations neuronales durant l’adolescence », souligne Valentina Mancini.

L’équipe de recherche a également identifié une forte corrélation entre le déficit de l’activation des ondes gamma et la sévérité des symptômes psychotiques, tels que les hallucinations auditives, confirmant ainsi l’existence d’une progression neurobiologique de la maladie. « Ces résultats confirment que ce dysfonctionnement apparaît très tôt », soulignent les auteur-es. « Reste maintenant à identifier le meilleur moment lors du développement de l’enfant pour intervenir en fonction de ce virage pathologique ».

Les études sur des souris montrent par ailleurs que des traitements neuroleptiques ciblés parviennent à corriger les dysfonctions neuronales ; de plus, les défauts des oscillations gamma identifiés ici pourraient être corrigés grâce à des techniques de neurostimulation non invasives ciblant les régions cérébrales concernées, ouvrant ainsi la voie à de toutes nouvelles perspectives thérapeutiques pour traiter cette maladie souvent dévastatrice.

Article rédigé par Georges Simmonds pour RT Flash

UNIGE

|

|

|

|

|

|

|

|

|

Le rôle de la protéine APOE4 dans l’apparition de l'Alzheimer, dont le lien avec la forme tardive de la maladie était connu, est maintenant mieux cerné grâce aux travaux de scientifiques suisses. La chercheuse Karina Lindner et ses collègues des universités de Genève et de Zurich ont montré comment cette protéine modifie le transport des lipides et contribue à l'émergence de la maladie neurodégénérative.

Le bon fonctionnement des neurones dans le cerveau dépend de nombreux autres types de cellules, dont les astrocytes. Ces cellules en forme d’étoile, présentes en très grand nombre dans le cerveau, assurent la survie des neurones en les nourrissant et en les détoxifiant à l’aide de la protéine APOE qu’elles sécrètent. Cette protéine assure la détoxification des neurones en les débarrassant de leurs déchets lipidiques, qui peuvent devenir nocifs. Comme les neurones sont incapables d’éliminer seuls ces déchets, l'APOE entre en jeu pour les collecter et les ramener aux astrocytes, où ils sont détruits. Environ 15 % des personnes possèdent la forme APOE4 de la protéine, ce qui multiplie par dix leur risque de développer un jour la maladie.

Jusqu’à aujourd’hui, aucune étude n’avait réussi à établir clairement les mécanismes qui lient l’APOE4 à l'Alzheimer, mais certains chercheurs avançaient que la protéine cessait de fonctionner correctement. Les présents travaux montrent que c’est tout le contraire, et qu'elle est en fait trop efficace. Cette protéine, en déclenchant la sécrétion lipidique des astrocytes, provoque l’accumulation de lipides néfastes pour les neurones, ce qui contribue à l'apparition de la maladie, notent les auteurs de ces travaux. Des travaux qui ont permis d’identifier de nouveaux mécanismes moléculaires qui expliquent comment l'APOE se lie aux membranes des astrocytes pour y détecter et en extraire les lipides dont elle a besoin.

Des expériences in vitro menées sur des lignées cellulaires humaines porteuses des différentes variantes de l’APOE ont aussi montré que cette protéine est extrêmement efficace pour transporter les lipides potentiellement nocifs produits dans les neurones. « À notre grande surprise, l'APOE4 s’est avérée encore plus efficace que les autres formes de la protéine. Ainsi, contrairement à ce que l’on pensait jusqu’ici, le problème n’est pas que l’APOE4 cesse de fonctionner, mais l’inverse : le mécanisme s’emballe ». Lorsque les astrocytes vieillissent, ils deviennent moins efficaces et se mettent à accumuler les lipides plutôt que de les détruire, expliquent les chercheurs. « Nous avons expérimentalement modélisé ce processus et observé les molécules sécrétées par les astrocytes », explique Karina Lindner, également co-première auteure de ces travaux.

Cette expérience a permis aux chercheurs d'observer comment le vieillissement cellulaire détourne l'APOE de sa fonction première, c’est-à-dire le transport de lipides vers les neurones et la récupération des déchets lipidiques, vers la sécrétion de triglycérides, des lipides qui peuvent devenir néfastes s’ils ne sont pas détruits. De plus, les chercheurs ont déterminé que ce phénomène est exacerbé avec l'APOE4, qui stimule la sécrétion de triglycérides, entraînant leur accumulation incontrôlée. Cette accumulation pourrait, selon les chercheurs, contribuer à la mort des neurones, l’une des caractéristiques de la maladie d’Alzheimer. L’équipe va maintenant travailler à mieux détailler l’action de l’APOE et surtout de son variant E4. Son objectif est de savoir comment la sécrétion de ces lipides potentiellement nocifs est régulée et si cette sécrétion peut être détectée chez des personnes souffrant de la maladie d’Alzheimer.

Article rédigé par Georges Simmonds pour RT Flash

Cell

|

|

|

|

|

|

|

|

|

Des bioingénieurs de l’Université de Duke (Caroline du Nord) ont réussi, en utilisant des gènes bactériens modifiés, à exciter les cellules cardiaques chez des souris modèles d’arythmie. Ces travaux illustrent les avancées de ces thérapies géniques minimalement invasives et très ciblées. L’équipe de Durham rappelle que les arythmies cardiaques surviennent lorsque les cellules du muscle cardiaque ne transmettent plus uniformément les signaux électriques qui induisent le pompage du sang de manière cohérente et régulière. La nouvelle thérapie génique à base de gènes bactériens modifiés qui codent pour les canaux ioniques sodium - qui transmettent les charges électriques dans la cellule - apparaît ici prometteuse pour traiter une grande variété de troubles cardiaques « électriques ». Les ingénieurs de la Duke apportent ici une première preuve de concept en montrant, chez la souris modèle d’arythmie, que la nouvelle thérapie génique induit bien les cellules du muscle cardiaque à s'activer électriquement.

Les canaux ioniques sodium sont des protéines dans les membranes externes des cellules électriquement excitables, telles que les cellules cardiaques ou cérébrales, qui transmettent des charges électriques dans la cellule. Dans le cœur, ces canaux indiquent aux cellules musculaires quand se contracter et transmettent l'instruction afin que l'organe pompe le sang telle une unité cohésive. Cependant, les cellules cardiaques endommagées, que ce soit par une maladie ou un traumatisme, perdent souvent tout ou partie de leur capacité à transmettre ces signaux et à se joindre à cet effort collectif.

En délivrant des gènes qui codent pour les canaux ioniques sodium dans les cellules musculaires cardiaques, les chercheurs renforcent la production de canaux ioniques dans les cellules malades, ce qui contribue à rétablir leur activité. Chez la souris, la thérapie génique permet bien d'améliorer la capacité collective des cellules musculaires cardiaques à initier et à propager l'activité électrique et donc la capacité du muscle cardiaque à pomper. « Ce qui est extrêmement difficile à accomplir avec des médicaments ou d'autres thérapies », relève l’auteur principal, Nenad Bursac, professeur de génie biomédical à la Duke. De plus, les effets de cette thérapie génique délivrée aux cellules musculaires cardiaques persistent pendant une longue période, ce qui suggère une solution efficace et durable pour les patients souffrant d’arythmie cardiaque.

Chez les mammifères, les gènes des canaux sodiques sont très volumineux et trop grands pour tenir dans les virus actuellement utilisés comme vecteurs dans les thérapies géniques chez l'Homme. La solution adoptée pour contourner le problème est d’utiliser des gènes plus petits qui codent pour des canaux ioniques sodium similaires dans les bactéries. Si ces gènes bactériens sont différents de leurs homologues humains, l'évolution a conservé de nombreuses similitudes dans la conception des canaux. En faisant muter ces gènes bactériens, il est possible qu’ils deviennent actifs dans les cellules humaines.

in vitro, les chercheurs montrent que ces gènes modifiés ne pénètrent que dans les cellules musculaires actives du cœur dans les oreillettes et les ventricules et fabriquent des protéines tout en flottant librement dans la cellule, en utilisant la machinerie biochimique existante ; de précédentes recherches menées sur cette approche de délivrance de gènes viraux avaient déjà confirmé que les gènes transplantés restent actifs pendant de nombreuses années ; ici, in vitro, la thérapie améliore suffisamment l'excitabilité électrique des cellules cardiaques, pour prévenir les anomalies humaines telles que les arythmies ; enfin, in vivo chez la souris, les canaux ioniques sodium sont bien actifs dans le cœur, montrant des tendances vers une excitabilité améliorée.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

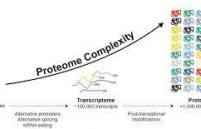

Une équipe de recherche du Laboratoire de biologie computationnelle et quantitative (Sorbonne Université, CNRS), en collaboration avec le laboratoire Biologie du chloroplaste et perception de la lumière chez les microalgues (Sorbonne Université, CNRS), a développé une approche computationnelle inédite pour la classification fonctionnelle de familles protéiques.

Cette approche nouvelle vise à permettre la découverte de protéines jouant des rôles fonctionnels clés dans des domaines très variés tels que la biologie, la santé humaine ou les biotechnologies. Le défi est de classer des milliers de séquences de protéines provenant du même ancêtre, possiblement très divergentes, qui sont impliquées dans l'interaction avec les acides nucléiques, les acides aminés et les petites molécules, et dont les fonctions doivent être découvertes ou caractérisées plus précisément. L’enjeu pour les chercheuses et chercheurs est de "lire" les différentes caractéristiques fonctionnelles directement à partir de leur séquence dans les génomes.

ProfileView (ou "Point de vue des profils") est une approche computationnelle innovante, développée au Laboratoire de biologie computationnelle et quantitative (Sorbonne Université, CNRS) qui permet d'apprendre les différences fonctionnelles entre protéines et de découvrir de nouvelles séquences naturelles ayant des fonctions potentiellement intéressantes en biotechnologie. ProfileView est conçue pour classer des milliers de séquences ayant un ancêtre commun par fonction. Cette approche, et le logiciel qui en découle, s'appuient sur deux idées principales : d’abord, l'utilisation de multiples modèles probabilistes, appelés "profils", pour explorer et extraire de façon novatrice des informations évolutives de l'immense espace des séquences ; ensuite, une nouvelle définition d'espace de représentation des séquences où l'on regarde les séquences du point de vue des motifs fonctionnels encodés dans les profils.

ProfileView a été validée sur plusieurs familles de protéines, connues pour être difficilement annotées fonctionnellement. Il s'agit de classes de protéines très répandues dans l’environnement, présentant une grande variété de fonctions, et une forte divergence de séquences. Une de ces familles protéiques est celle des Cryptochrome-Photolyases dont les membres sont impliqués dans divers mécanismes biologiques activés par la lumière et étudiés au laboratoire Biologie du chloroplaste et perception de la lumière chez les microalgues (Sorbonne Université, CNRS). Des membres de cette famille de protéines sont extrêmement importants en médecine et biologie en raison de leur rôle clé dans la stabilité du génome, la biologie du cancer, la régulation des rythmes circadiens ou encore les méthodologies optogénétiques. Les résultats de ProfileView appuient un vaste ensemble de connaissances correspondant aux travaux expérimentaux existants et résolvent des classifications fonctionnelles encore non définies.

Ce retour d'expérience montre que ProfileView permet une approche puissante pour collecter des informations sur la diversité fonctionnelle des protéines, de sélectionner des séquences en vue de la conception d'expériences fonctionnelles ciblées, et de découvrir de nouvelles fonctions biologiques. ProfileView offre un regard computationnel totalement nouveau sur les processus évolutifs et sur l'espace complexe des séquences naturelles. Cette approche permet une classification très générale et précise des membres des familles de protéines, mettant en évidence les motifs fonctionnels d'interaction avec d'autres protéines, l'ADN et les petites molécules, et ouvrant la voie à des analyses à grande échelle. Ses propriétés visent ainsi à permettre la découverte de protéines jouant des rôles fonctionnels clés dans des domaines très variés tels que la biologie, la santé humaine ou les biotechnologies.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

|

|

|

|

|

|

|

L’endoprothèse a révolutionné le traitement des anévrismes aortiques : au lieu de pratiquer un geste chirurgical enlevant l’anévrisme, il s’agit d’exclure celui-ci en posant un stent, qui l’élimine de la circulation sanguine générale. Cette pose est effectuée par voie endovasculaire, avec un risque de mortalité nettement plus faible que celui de la chirurgie. Néanmoins, cette technique impose une surveillance à vie des patients pour repérer l’apparition d’éventuelles complications comportant un risque de rupture de l’anévrisme (endofuites, migration de la prothèse, perméabilité ou déformation du squelette métallique, plicatures, présence d’anévrismes au-dessus ou en dessous de la zone traitée, etc).

Le plus souvent, cette surveillance est effectuée par scanner, évaluant plusieurs paramètres, comme le diamètre de l’aorte ou la présence de fuites. L’équipe du Professeur Michel Alain Bartoli (Hôpital Marie Lannelongue, Marseille – groupe Hospitalier Paris Saint-Joseph) et la société INCEPTO ont développé une solution d’intelligence artificielle (ARVA) qui fournit des mesures automatiques du diamètre anévrismal en scanner. La solution a été développée pour fournir des mesures du diamètre de l’aorte dans la totalité de son trajet, avec reconstitution 3D. L’énorme avantage de cette technique est de pouvoir comparer les images au fil du temps.

Elle a été rendue possible grâce aux 3.500 scanners interprétés, datés et classifiés de l’équipe marseillaise. En effet, les performances de l’intelligence artificielle reposent d’abord sur la quantité de données exploitables. Elles seront accrues prochainement par de nouvelles fonctionnalités. Les données des patients sont obtenues avec leur consentement et anonymisées.

Article rédigé par Georges Simmonds pour RT Flash

AP-HM

|

|

|

|

|

|

|

|

|

Partout dans le monde, les scientifiques essayent d’utiliser des enzymes pour accélérer le recyclage et la dégradation des déchets plastiques. La technologie de recyclage enzymatique du PET développée par la société française Carbios, pionnière dans le développement de solutions enzymatiques dédiées à la fin de vie des polymères plastiques et textiles, en est le meilleur exemple. Une équipe de chercheurs de l’Université suédoise Chalmers a démontré une corrélation entre la présence d’enzymes capables de dégrader les plastiques et le niveau de pollution des océans. Ils ont ainsi identifié 30 000 enzymes homologues capables de dégrader 10 types de plastiques.

Si de nombreux pays développés font des efforts en matière de recyclage et de valorisation, ces efforts doivent encore être accentués pour donner des résultats tangibles. En outre, toutes les zones du globe ne disposent pas des mêmes moyens et la mise en place de filières organisées est aussi complexe que coûteuse. Or, c’est un fait : plus des trois quarts des déchets plastiques s’amoncellent sur les sites d’enfouissement du monde entier, ce qui contribue à alimenter une pollution plastique qui continue de se propager dans tous les océans du monde.

Pour explorer la capacité des micro-organismes à dégrader les plastiques, ces chercheurs ont d’abord compilé un ensemble de données concernant les 30 000 enzymes dont cette capacité a été démontrée avec des preuves expérimentales basées sur du séquençage. Ceci leur a permis de construire une vaste base de données biologiques à l’échelle mondiale couvrant une collection variée d’océans, de mers et d’habitats terrestres.

Les résultats obtenus indiquent clairement une corrélation entre la présence d’enzymes et le taux de pollution. Aleksej Zelezniak, professeur associé en biologie des systèmes de l’Université Chalmers, explique : « À l’aide de nos modèles, nous avons trouvé de nombreux éléments de preuve qui confirment que le potentiel de dégradation des plastiques du microbiome mondial est en forte corrélation avec les mesures de la pollution plastique environnementale – une démonstration notable de la façon dont l’environnement répond aux pressions que nous lui imposons ». Jan Zrimec, auteur principal de l’étude, ajoute : « Nous ne pensions pas trouver de telles quantités de ces enzymes dans des habitats microbiens et environnementaux aussi variés. Il s’agit d’une découverte surprenante qui illustre bien l’ampleur du problème ».

Parmi ces nombreux types d’enzymes, quelles sont celles qui sont potentiellement exploitables dans des procédés industriels de recyclage enzymatique ? C’est la question à laquelle l’équipe de chercheurs espère répondre dans de prochains travaux. Aleksej Zelezniak l’affirme : « L’étape suivante consisterait à tester les candidats enzymes les plus prometteurs en laboratoire afin d’étudier de près leurs propriétés et le taux de dégradation des plastiques qu’ils peuvent atteindre. À partir de là, vous pourriez créer des communautés microbiennes dotées de fonctions de dégradation ciblées pour des types de polymères spécifiques ».

Article rédigé par Georges Simmonds pour RT Flash

ASM

|

|

|

|

|

|

|

|

|

À l'adolescence, de nombreux diagnostics de maladies psychiatriques (troubles de l'humeur, schizophrénie ou troubles obsessionnels compulsifs) sont posés. Or les raisons de cette vulnérabilité à l'adolescence restent mal comprises. Des études d'imagerie cérébrale récentes ont montré que le cerveau poursuit sa maturation et son développement au-delà de l'enfance jusqu'à 20, voire 30 ans. Or ces changements – plus importants dans certaines régions du cerveau que dans d'autres, en particulier dans celles qui hébergent les fonctions cognitives supérieures comme le langage ou la conscience – sont directement reliés à l'évolution de la santé mentale.

Pour en savoir plus, des chercheurs de Joliot ont utilisé les données d'une cohorte développementale en libre accès (Healthy Brain Network, HBN) pour analyser les associations entre des marqueurs de surface corticaux et les scores d'irritabilité et d'anxiété mesurés par les parents et par auto-évaluation – l'irritabilité et l'anxiété étant associées à un risque plus élevé de survenue de troubles de l'humeur à l'âge adulte.

Ils ont isolé un échantillon de 718 sujets pour lesquels la qualité des images IRM acquises dans le cadre de HBN était jugée satisfaisante et ils ont mesuré pour chacun d'eux l'épaisseur et la surface corticales et l'« indice de gyrification locale », caractérisant la formation des plis caractéristiques du cortex cérébral. Ces trois marqueurs de maturation cérébrale ont ensuite été confrontés aux rapports parentaux d'irritabilité et d'anxiété chez 658 jeunes d'un âge moyen de 11,6 ans. L'irritabilité est associée à une diminution de la surface du cortex préfrontal bilatéral et du précuneus (zone située à l'arrière de notre cerveau, sur la face interne du lobe pariétal du cortex cérébral). L'anxiété est associée à une diminution de l'indice de gyrification locale dans le cortex cingulaire antérieur et le cortex préfrontal dorsomédial. Ces résultats sont cohérents avec les modèles actuels de la maturation du réseau de régulation des émotions. Ils font ainsi apparaître, chez des enfants à risque de troubles de l'humeur, des modifications anatomiques dans les régions dysfonctionnelles.

Article rédigé par Georges Simmonds pour RT Flash

CEA

|

|

|

|

|

|

|

|

|

Actuellement mené au CHU de Lille, DIVE est un essai clinique révolutionnaire sur la maladie de Parkinson. Il repose sur le développement et l’évaluation d’un nouveau système d’administration du traitement de la maladie consistant à injecter directement dans le cerveau la dopamine manquante chez les malades, afin de limiter les effets indésirables des traitements conventionnels.

Un procédé de fabrication original est ainsi produit pour la première fois au CHU de Lille. Cette nouvelle technologie a été développée par InBrain Pharma, start-up créée pour exploiter le concept initial issu de la recherche académique du CHU de Lille, de l’Université de Lille et du laboratoire Lille Neuroscience & cognition UMR-S 1172 Inserm. Le transfert de technologie a été réalisé par la SATT Nord avec une incubation à Eurasanté.

La maladie de Parkinson touche actuellement 200 000 personnes en France, dont 22 000 cas dans la région Hauts-de-France. Cette maladie entraîne une carence en dopamine dans le cerveau. Pour pallier ce manque, le traitement actuel repose sur la prise orale répétée d’une molécule qui se transforme en dopamine, avec une durée d’action limitée et entraînant des complications motrice invalidantes chez de nombreux patients.

L’essai clinique, en cours au CHU de Lille, prévoit une comparaison entre la nouvelle solution appelée « DIVE » et le traitement conventionnel des patients. La solution « DIVE » semble également moins invasive que la stimulation cérébrale profonde pourtant plébiscitée par les patients. Elle est également plus simple et moins risquée. Les premiers résultats cliniques confirment une meilleure ergonomie que les traitements actuels par pompe, une grande sécurité et un effet clinique très prometteur. Une source d’espoir pour de très nombreux malades !

Article rédigé par Georges Simmonds pour RT Flash

CHU Lille

|

|

|

|

|

|

|

|

|

Les découvertes scientifiques sont souvent sectorisées : des études épidémiologiques d’un côté et des études de laboratoire et des modélisations de l’autre. L’article qui a paru dans Science décrit une étude translationnelle intégrant un ensemble de données usuellement déconnectées les unes des autres. Une étude épidémiologique (SELMA) basée sur une cohorte de 1800 femmes enceintes / enfants en Suède a permis de corréler des effets sur des enfants de 30 mois avec une exposition à un mélange de produits chimiques, subie in utero. Ces résultats ont ensuite été testés dans plusieurs laboratoires européens et nord-américains. Ce travail collectif démontre qu’un mélange de huit produits chimiques composé de phtalates, de bisphénol A et de composés perfluorés, mesurés pendant la grossesse dans le sang ou l’urine des futures mères, affecte le nombre de mots que leurs enfants sont capables de prononcer à l’âge de 30 mois.

Ce mélange de produits chimiques a ensuite été recréé afin d’en décortiquer les modes d’actions en laboratoire : des effets de perturbations hormonales (thyroïdienne, oestrogénique, cortico stéroïde) ont été démontrés à l’aide de cellules souches neurales humaines et de modèles aquatiques. L'hormone thyroïdienne est l'une des clés des voies hormonales affectées. Des niveaux optimaux d'hormones thyroïdiennes maternelles sont nécessaires en début de grossesse pour la croissance et le développement du cerveau. « Il n'est donc pas surprenant que l’on retrouve une association entre un retard de langage et une exposition prénatale » commentent Barbara Demeneix et Jean-Baptiste Fini, tous deux auteurs seniors et professeurs du Muséum national d’Histoire naturelle à Paris.

C’est la première fois que l’utilisation conjointe de modèles cellulaires et aquatiques permet de valider le mode d’action supposé de la perturbation hormonale. Une reconstruction des réseaux de gènes modifiés par cette exposition au mélange, effectuée par la Docteur Michelle Leemans, co-première auteure, permet d’apprécier la complexité des modifications engendrées au niveau cellulaire par ce mélange de produits chimiques.

En reliant ainsi différentes disciplines, les scientifiques ont pu montrer que l’utilisation de ces nouvelles méthodes aurait confirmé que 54 % des enfants inclus dans l'étude SELMA avaient un risque du retard de langage car exposés avant la naissance à ce mélange de substances chimiques. Cette étude propose ainsi une nouvelle approche d’évaluation du risque et montre la nécessité d'élaborer de nouveaux principes pour la mise en place de seuils de sécurité face aux mélanges de produits.

Certains produits chimiques auxquels la population est exposée ont, en effet, des propriétés de perturbation endocrinienne, et peuvent être dangereux pour la santé humaine et animale. Si les niveaux d'exposition aux produits chimiques pris individuellement sont souvent inférieurs aux valeurs limites autorisées, cela n’implique pas une absence de conséquences à long terme, d’autant que femmes et hommes sont constamment exposés à des mélanges complexes de produits chimiques qui, jusqu’à présent, font l’objet uniquement d’évaluations séparées.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

|

|

|

|

|

|

|

Par définition, les microbes sont censés être si petits qu'ils ne peuvent être vus qu'au microscope. Mais une bactérie nouvellement décrite vivant dans les mangroves des Caraïbes vient de remettre en cause ce dogme. Sa cellule unique filiforme est visible à l'œil nu, mesurant jusqu'à 2 centimètres - aussi longue qu'une cacahuète - et 5000 fois plus grosse que de nombreux autres microbes. De plus, ce géant possède un énorme génome qui ne flotte pas librement à l'intérieur de la cellule comme dans d'autres bactéries, mais est plutôt enfermé dans une membrane, une innovation caractéristique de cellules beaucoup plus complexes, comme celles du corps humain.

Cette bactérie totalement hors norme a stupéfié les chercheurs. « En ce qui concerne les bactéries, je m’attendais à tout, mais la taille de celle-ci repousse à coup sûr ce que nous pensions être la limite supérieure imaginable d’un tel organisme », déclare Verena Carvalho, microbiologiste à l'Université du Massachusetts, Amherst. « Cette bactérie pourrait être un chaînon manquant dans l'évolution des cellules complexes », déclare Kazuhiro Takemoto, biologiste informatique à l'Institut de technologie de Kyushu.

Les chercheurs ont longtemps divisé la vie en deux groupes : les procaryotes, qui comprennent des bactéries et des microbes unicellulaires appelés archées, et les eucaryotes, qui comprennent la plupart des formes de vie multicellulaire, y compris les humains. Les procaryotes ont un ADN flottant, tandis que les eucaryotes emballent leur ADN dans un noyau. Les eucaryotes compartimentent également diverses fonctions cellulaires dans des vésicules appelées organites et peuvent déplacer des molécules d'un compartiment à un autre, ce que les procaryotes ne peuvent pas faire.

Mais ce gigantesque microbe brouille la frontière entre les procaryotes et les eucaryotes. Il comprend deux sacs membranaires, dont l'un contient tout l'ADN de la cellule, ce qui montre que les deux grandes branches du vivant ne sont sans doute pas aussi différentes qu'on le pensait auparavant.

En 1999, une autre équipe avait déjà découvert un microbe géant mangeur de soufre, de la taille d'une graine de pavot au large de la côte namibienne. Comme son prédécesseur, cette nouvelle bactérie de la mangrove possède également un énorme sac - vraisemblablement rempli d'eau - qui occupe 73 % de son volume total. Cette similitude et une analyse génétique ont conduit l'équipe de recherche à le placer dans le même genre que la plupart des autres géants microbiens et à le baptiser du nom de Thiomargarita magnifica.

Sans surprise, ces chercheurs ont découvert que le génome de cette bactérie était lui aussi énorme, avec 11 millions de paires de bases abritant quelque 11 000 gènes clairement identifiables. En règle générale, les génomes bactériens comptent en moyenne environ 4 millions de bases et environ 3900 gènes…

Si le génome de la bactérie est si grand, c’est, selon les chercheurs, parce qu'il y a plus de 500 000 copies des mêmes segments d'ADN. Des usines de production de protéines, appelées ribosomes, se trouvent également à l'intérieur du sac rempli d'ADN, ce qui permettrait aux gènes de produire plus facilement des protéines. « Trop souvent, les bactéries sont considérées comme des formes de vie simples et peu évoluées. Mais celle-ci démontre que ce n’est pas toujours le cas et que nous avons encore beaucoup à apprendre du vivant, en étudiant ces microorganismes », souligne l’étude…

Article rédigé par Georges Simmonds pour RT Flash

Science

|

|

|

|

|

|

|

|

|

Lorsque les scientifiques ont annoncé le séquençage complet du génome humain en 2003, ils sont allés un peu vite en besogne. En réalité, jusqu’à présent, environ 8 % du génome n'avaient jamais pu être entièrement séquencés, notamment parce que le génome se compose de portions d'ADN très répétitives et très difficiles à décrypter. Mais une équipe internationale d’une centaine de chercheurs vient de relever ce défi et a publié la première cartographie réellement complète et sans erreur de génome humain.

Ce génome complété, baptisé T2T-CHM13, révèle enfin comment sont organisés de nombreux chromosomes et confirme que notre génome se compose de 3 055 milliards de paires de bases, les unités à partir desquelles les chromosomes et nos gènes sont construits, et de 19 969 gènes codant pour les protéines. Parmi les gènes codant pour les protéines, les chercheurs en ont identifié environ 2 000 nouveaux, pour la plupart inactifs, mais dont 115 peuvent encore être exprimés et méritent une étude approfondie.

Ce nouveau génome de référence a révélé près de 200 millions de paires de bases de nouvelles séquences d'ADN. « A l'avenir, lorsqu'une personne verra son génome séquencé, nous serons en mesure d'identifier toutes les variantes de son ADN et d'utiliser toute cette information nouvelle pour mieux personnaliser son parcours médical et ses thérapies », a déclaré Adam Phillippy, l'un des chercheurs au National Human Genome Research Institute (NHGRI).

Article rédigé par Georges Simmonds pour RT Flash

UCSC

|

|

| ^ Haut |

|

|

|

|

|

|

|

Recherche |

|

|

Recherche & Innovation, Technologies, Transports

|

|

|

|

|

|

|

|

|

|

Fabriquer un véhicule léger, capable de rouler aussi bien sur la route que sur les rails, c’est le défi que la SNCF a lancé à Milla, start-up francilienne de la voiture autonome. Ce projet a été annoncé par l’entreprise le 21 février 2022. Son objectif est de redonner de la mobilité dans certaines des zones rurales les moins bien desservies. Nommée Flexy, la navette doit pouvoir aller chercher les voyageurs à leurs porte, avant de les emmener à la gare la plus proche en utilisant l’une des nombreuses voies désaffectées qui sillonnent la France. « La SNCF a estimé qu’il y avait pas loin de 90 lignes exploitables, soit 5000 kilomètres de rails. Si l’on voulait rouvrir ces lignes aux trains, les coûts seraient faramineux. À la place, des navettes capables de rouler sur ces rails permettraient d’en bénéficier sans investissements faramineux », résume Frédéric Mathis, co-fondateur et PDG de Milla. Pour répondre à cette demande, Milla va adapter l’un de ses trois véhicules autonomes, le Milla Pod.

Premier changement : la roue. Conçue par Michelin, elle devra permettre à Flexy de rouler facilement sur les deux terrains. Un système de guidage automatique embarqué doit être ajouté pour faciliter les transitions entre la route et les rails, ainsi que pour garder la roue bien positionnée sur la voie ferrée. « Il y a un enjeu de liaison au sol plus important que pour nos autres véhicules », détaille le PDG. Selon l’entreprise, 80 % du trajet seront effectués sur les lignes désaffectées.

Le nombre de sièges dans l’habitacle passera également de six à neuf – permettant donc le transport de huit passagers. Car si le Milla Pod roule expérimentalement depuis 2019 de manière 100 % autonome dans quelques villes comme Aix, pas question pour l’heure d’envisager le Flexy sans conducteur. « Peut-être qu’à terme ce véhicule pourra être autonome, mais pour l’instant il y aura un chauffeur de bout en bout », admet Frédéric Mathis. Le premier démonstrateur de cette navette est prévu pour rouler – à une vitesse maximum de 60 km/h – sur une ligne pilote d’ici 2024.

Article rédigé par Georges Simmonds pour RT Flash

Industrie & Technologies

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|