|

|

|

|

|

| NUMERO 1127 |

|

|

|

|

|

|

|

Edition du 29 Octobre 2021

|

|

|

|

|

Edito

Energie sombre, matière noire : faut-il revoir le cadre théorique qui explique l’Univers ?

APPEL aux DONS pour PERMETTRE A RT FLASH de CONTINUER A ÊTRE PUBLIÉ GRATUITEMENT CHAQUE SEMAINE.

Je ressens votre fatigue. Vous n'avez plus envie de lire mon avant-propos que je mets en tête de mon édito pendant la campagne de dons.

Dorénavant, je vous préciserai la somme collectée en 2021 depuis le début de la campagne et le nombre de donateurs.

Sachant qu'il faut que notre Association ADIST, qui gère RT Flash, perçoive globalement 15.000 € pour les 11 mois de parution (pas de parution en Août) soit 1360 € par mois, je vous indiquerai pendant la période de collecte des dons :

La somme perçue de puis le début de la campagne : 3.067 euros

Nombre de donateurs : 43

Avec cette somme, jusqu'à quelle date pourra paraître gratuitement, RT Flash chaque semaine, sans publicité : 7 Mars 2022

Si vous voulez aider RT Flash, lettre d'informations scientifiques, gratuite et sans publicité depuis 1998, appuyez sur le lien suivant :

Adhérez à notre Association ou faites un DON pour sauver RT Flash, vous bénéficierez d'une réduction fiscale de 66 %.

EDITORIAL :

Depuis plusieurs décennies, astrophysiciens et cosmologistes buttent sur deux écueils considérables qui rendent impossible l’édification d’une théorie cohérente et globale de l’Univers : quelle est la véritable nature de la matière noire et de l’énergie noire, qui constituent ensemble 95 % du Cosmos (le reste étant fait de matière baryonique, celle qui forme notre monde matériel et que nous pouvons directement observer) ?

Il y a presque 90 ans, en 1933, l’astronome suisse Fritz Zwicky fut le premier à avoir envisagé la matière noire, qui fut formellement découverte en 1970 par l’astronome américaine Vera Rubin. En observant l’amas de galaxie « de la Chevelure de Bérénice », Fritz Zwicky observa que la masse gravitationnelle totale des galaxies était bien plus importante que celle observable par leur luminosité. Il en déduisit qu’il devait exister une matière invisible, exerçant une attraction gravitationnelle suffisamment forte pour assurer la cohésion des amas galactiques et empêcher leur éclatement.

Aujourd’hui, on considère que notre Univers serait composé, pour 68,3 % d'énergie noire, de nature inconnue, pour 26, 8 % de cette fameuse matière noire, dont on ne sait pas grand-chose et seulement pour 4,9 % de matière ordinaire (dite baryonique), dont est fait le monde qui nous entoure. Selon la théorie dominante, la matière noire serait composée de particules inconnues, appelées WIMP (Weakly Interacting Massive Particles ou particules massives à faible interaction), qui pourraient être des variétés inconnues de neutrinos, d’axons ou de quarks.

Pour essayer d’en savoir plus sur cette matière noire introuvable, une équipe de recherche internationale, regroupant des chercheurs du Laboratoire de physique de l’École normale supérieure et des scientifiques du CNRS, a récemment réalisé la plus grande carte de la matière noire dressée à ce jour (La plus grande carte de la matière noire jamais réalisée | INSU (cnrs.fr). Pour réussir cette prouesse, les chercheurs ont utilisé le phénomène de cisaillement gravitationnel qui provoque une déviation de la lumière en présence d’un champ gravitationnel. La matière noire entraîne en effet, à cause de la puissante gravitation qu’elle exerce, une déformation des images que nous recevons des galaxies, car les rayons lumineux sont déviés par ce phénomène. Grâce à un traitement informatique puissant des images recueillies, les scientifiques ont pu cartographier la présence de matière noire.

La grande nouveauté de cette carte est sa surface bien plus grande que celle des cartes précédentes : en exploitant les images provenant du Chili, dans le cadre du programme Dark Energy Survey, les chercheurs ont pu reconstituer le panorama global, dans les spectres du visible et de l’infrarouge, de plusieurs centaines de millions de galaxies. Le résultat est saisissant car il montre que cette matière noire couvre un quart du ciel de l’hémisphère sud. Mais dans une dizaine d’années, le futur télescope spatial Euclid permettra d’aller encore plus loin et de photographier des milliards de milliards de galaxies, ce qui permettra d’établir une cartographie de la matière noire à l’échelle de l’Univers tout entier.

En avril dernier, une étude réalisée par une équipe composée de chercheurs anglais, américains et australiens avec le télescope spatial européen Gaia, sur un courant d’étoiles baptisé Hercule, qui tournent autour de la Voie lactée, a montré que la rotation de la barre d’étoiles qui traverse le noyau de la Voie lactée, à la vitesse d’environ 240 km par seconde, connaît un ralentissement d’au moins 24 % depuis sa formation (Voir Nature astronomy). « Nous avons pour la première fois des preuves de ce ralentissement », souligne Ralph Schoenrich, cosignataire de l’étude. Selon cette étude, la cause de cet important ralentissement de la rotation de la Voie lactée est très probablement la matière noire.

Il y a quelques semaines, une autre étude menée par des chercheurs de l’Université de Californie à Riverside est venue poser l’hypothèse très intéressante que la matière noire pourrait se trouver dans une autre dimension de l’espace-temps. Une quatrième dimension « que seules les forces obscures connaissent », selon les chercheurs (Voir UC Riverside). La matière noire, comme son nom l’indique, n’émet aucune lumière visible ni aucun autre type de rayonnement électromagnétique, ce qui la rend très difficile à détecter. « Ce qui est déroutant avec la matière noire, c’est que nous savons qu’elle existe, mais que nous ne savons pas comment la rechercher, ni pourquoi elle ne s’est pas présentée là où nous l’attendions », souligne Philippe Tanedo, auteur principal de l’étude.

Selon cette étude, il se pourrait que notre Univers comporte, non pas trois dimensions d’espace, mais quatre et ce serait dans cette dimension supplémentaire cachée que se trouverait la matière noire. Cette nouvelle théorie expliquerait pourquoi, en dépit de décennies d’observations, cette matière noire est restée indétectable. L’étude rappelle que l’hypothèse de dimensions supplémentaires est déjà présente en mathématiques pour décrire les « théories conformes des champs » — une théorie quantique des champs qui décrit l’évolution de particules lors d’interaction. Pour rendre leur théorie cohérente, ces scientifiques ont utilisé le principe holographique du physicien américain Leonard Susskind qui postule que la quantité d'information contenue dans un volume d’espace dépend de son aire et non pas de son volume, et que toute cette information peut être décrite par une théorie qui se situe sur les bords de cette région. Dans cette étude, ces chercheurs ont notamment pu montrer que la force exercée par la matière noire pouvait expliquer les mouvements stellaires observés. « Notre modèle va plus loin et postule l’existence d’une quatrième dimension d’espace, qui permet de mieux expliquer que les hypothèses actuelles l’origine cosmique de la matière noire », souligne Philippe Tanedo.

Mais les physiciens ne sont pas seulement confrontés à ce mystère de la matière noire ; ils doivent également faire face, depuis la fin du siècle dernier, à la présence d’une toute aussi étrange énergie noire (ou sombre) qui semble remplir tout notre Univers et exerce une pression négative qui vient s’opposer à la gravitation. L'existence de l'énergie noire est nécessaire pour expliquer pourquoi l’expansion de l’Univers ne semble pas constante et s’est accélérée au cours des 6 derniers milliards d’années, comme l’ont montré en 1998 les chercheurs Saul Perlmutter et Adam Riess, qui se sont partagés le prix Nobel de physique 2011. Bien que possédant une densité très faible (de l'ordre de 10−29 g/cm3), l'énergie noire, découverte en 1998 par Dragan Huterer and Michael S. Turner, est à présent considérée comme une force fondamentale de l’Univers.

Pour certains physiciens, l'énergie sombre ne serait autre que l’énergie du vide quantique, représentée par la fameuse « constante cosmologique », une valeur imaginée, puis rejetée, par Albert Einstein. Cette constante cosmologique suppose que la densité de l'énergie sombre est à la fois constante – elle ne varie pas dans le temps – et uniforme dans tout l'Univers. Elle présente l’avantage de bien rendre compte des observations cosmologiques. Mais pour d’autres physiciens, l’énergie sombre aurait une intensité qui varierait dans le temps et sa nature réelle resterait donc à découvrir.

Un nouvel outil installé dans l’observatoire de Kitt Peak, en Arizona, pourrait bien permettre de trancher enfin entre ces deux hypothèses. Cet instrument sur lequel les cosmologistes fondent beaucoup d’espoirs s’appelle Desi (Dark energy spectroscopic instrument). Depuis sa naissance il y a 13,8 milliards d'années, nous savons que notre Univers est en expansion. Mais ce que nous avons appris, c’est que la vitesse de cette expansion n’est pas la même depuis le Big Bang. Dans une première phase de 7,6 milliards d’années, cette vitesse a d'abord diminué, sous l'effet de la matière ordinaire, mais aussi de la matière noire, contenues dans l’Univers. Pourtant, il y a 6,2 milliards d'années, ce processus s’est inversé, pourquoi ? Parce que, selon la théorie dominante, la quantité totale de matière dans l’Univers (quantité fixe depuis le Big Bang) ne cesse de se diluer à mesure que le volume de l'Univers grandit. A contrario, la puissance de l'énergie noire, dont l'effet répulsif accélère l'expansion, est proportionnelle à l'espace. Or, il y a 6,2 milliards d'années, l'Univers est devenu assez grand pour que la force répulsive de l'énergie noire l’emporte sur celle, attractive, de la matière, ce qui a provoqué une accélération croissante de l’expansion de l’Univers.

Desi, qui rassemble 500 chercheurs issus de 13 pays différents, s’est fixé comme objectif d’élucider les causes réelles de cette accélération continue, en œuvre depuis six milliards d’années. Dans notre Univers en expansion, les galaxies s'éloignent les unes des autres de plus en plus vite, ce qui se manifeste par un phénomène bien connu, appelé vitesse de récession, par lequel la lumière émise par ces galaxies est de plus en plus décalée vers les grandes longueurs d'onde (en l’occurrence le rouge) par effet Doppler, de la même manière que le son d’une sirène d'ambulance nous semble de plus en plus grave, à mesure que cette ambulance nous a dépassés et s’éloigne de nous.

Pour observer et mesurer ce décalage (les redshifts galactiques), Desi est équipé de 5000 capteurs à fibre optique, capables, grâce à un système unique de commande robotisé, de pointer en même temps dans 5.000 directions différentes. Les signaux lumineux ainsi recueillis sont ensuite acheminés par fibre optique à dix spectrographes -fabriqués par la société française Winlight System, basée dans le Vaucluse. Cet extraordinaire système d’analyse spectral est capable de décomposer la lumière de 5.000 objets célestes en moins d’une demi-heure et Desi devrait être en mesure, d’ici 2026, de passer au crible 35 millions de galaxies et 2,5 millions de quasars, ce qui permettra d’établir la carte 3D de l'Univers la plus précise jamais réalisée !

En analysant la lumière de quasars distants, et donc vieux de plus de douze milliards d’années, les scientifiques espèrent que Desi sera enfin en mesure de trancher de manière nette entre les deux grandes théories en compétition quant à la nature de l'énergie noire. Si les chercheurs mettent en évidence un rapport de pression constante sur densité variable, il faudra en déduire qu’il existe bien une nouvelle forme d’énergie de nature physique. Mais si les chercheurs observent au contraire un rapport de pression constante sur une densité fixe, cela voudra dire que l'énergie noire est bien la manifestation de cette fameuse constante cosmologique qu’Einstein avait pressentie…

Le problème est qu’actuellement les scientifiques s’opposent sur la vitesse exacte de l’expansion cosmique - la fameuse constante de Planck -, car celle-ci est sensiblement différente, selon la méthode utilisée. Si l’on utilise la technique basée sur l’analyse de la luminosité d'étoiles servant de repères (céphéides, supernovae de type Ia), on obtient une valeur d’expansion de 74 km par seconde et par mégaparsec (un parsec est une unité astronomique égale à 3,26 années-lumière, un mégaparsec correspond donc à 3, 26 millions d’années-lumière). Mais si l’on utilise l’autre méthode, reposant sur l’analyse par le satellite Planck des fluctuations de l'Univers primordial, on obtient une valeur nettement inférieure de 67 km par seconde et par mégaparsec. En fonction de la valeur d’expansion que trouvera Desi, les scientifiques devraient donc être en mesure de savoir si cette énergie noire est bien la constante cosmologique d’Einstein ou la manifestation d’une nouvelle force encore inconnue…

Reste que certains astrophysiciens commencent à se dire que, si au terme de décennies d’efforts, ils n’ont toujours pas réussi à découvrir la véritable nature de la matière et de l’énergie noire, cela est peut-être le signe qu’il faut changer d’approche conceptuelle et revoir radicalement le rôle et la place de la gravité, comme force fondamentale dans notre Univers, ce qui permettrait également d’articuler enfin de manière cohérente la relativité générale (théorie de la gravitation) et la physique quantique (qui régit le monde des atomes et des particules).

En 1995, le physicien Eric Verlinde a proposé une nouvelle théorie très audacieuse qui continue à alimenter des débats passionnés au sein de la communauté scientifique. Selon cet éminent théoricien, la gravité ne serait pas une force fondamentale de la nature, mais devrait être considérée comme un phénomène émergent, à l’instar de la chaleur qui résulte du mouvement de particules microscopiques. Verlinde souligne que si l’on accepte de considérer la gravitation comme un effet secondaire dans l’Univers et non comme une force fondamentale, il n’est plus nécessaire de trouver la nature de la matière noire, car on peut alors expliquer le comportement des galaxies sans cette dernière. « Nous avons des preuves que cette nouvelle vision de la gravité est en accord avec les observations et à de très grandes échelles, il semblerait que la gravité ne se comporte pas de la manière dont elle est décrite dans la théorie d’Einstein ».

Verlinde est persuadé que le nœud du problème réside dans la façon dont la gravité émerge au niveau microscopique. Il postule que la gravité est un phénomène émergent qui naît de l’entropie de l’Univers, c’est-à-dire de la déperdition inévitable et croissante d’énergie sous forme de chaleur prévue par le second principe de la thermodynamique. Poursuivant son raisonnement, Verlinde pense qu’il est possible de mesurer cette entropie par la quantité d’information qu’il faut pour décrire un système : plus celui-ci sera désordonné (donc entropique), plus il faudra une grande quantité d’informations pour le décrire. La théorie de Verlinde relie également l’entropie à ce que l’on appelle le principe holographique, théorisé par les physiciens Gerard 't Hooft et Leonard Susskind à la fin du siècle dernier. Selon ce principe, il existerait des informations fondamentales stockées dans le tissu spatio-temporel et toute l'information contenue dans un volume d'espace pourrait être décrite par une théorie qui se situe sur les bords de cette région. Pour Verlinde, comme pour Susskind, l’application de ce principe holographique permet de concevoir une force entropique qui agit, in fine (du fait de l’évolution statistique des degrés de libertés des composantes d'un système sur une surface holographique), comme la gravité.

Il y a quatre ans, une équipe de chercheurs de l’Université de Leiden, aux Pays-Bas, dirigée par Margot Brouwer, a testé la théorie de Verlinde en mesurant la répartition des forces gravitationnelles dans un échantillon de 33 000 galaxies en utilisant l’effet de lentille gravitationnelle prédite par la théorie de la relativité générale d’Einstein. Ces scientifiques ont effectivement montré qu’en appliquant les calculs de la théorie de la gravité émergente de Verlinde, ils pouvaient parvenir aux mêmes résultats sans avoir à recourir à l’idée de matière noire. Ces travaux semblent donc établir que, au moins pour ces observations, la théorie de la relativité générale d’Einstein et celle de Verlinde avaient la même efficacité (Voir Oxford Academic).

Le physicien français Aurélien Barrau souligne que la théorie proposée par Verlinde lui semble très féconde, dans la mesure où elle permet de développer une conception thermodynamique de la gravitation et d’articuler d’une manière nouvelle les trois grandes théories de la physique, la physique quantique, la thermodynamique, avec son fameux second principe d’entropie (élaborée entre 1820 et 1865 par Carnot, Kelvin et Clausius) et la relativité générale d’Einstein. Barrau souligne, par ailleurs, que dans la théorie de la gravité entropique de Verlinde, les équations d’Einstein peuvent rester valables, mais deviennent de simples équations d’état.

On le voit, la cosmologie est à la croisée des chemins et devra sans doute, pour dépasser les écueils redoutables que constitue la nature de la matière et de l’énergie noire, revoir la nature et le rôle de la gravitation, comme force fondamentale de l’Univers, mais aussi de l’information, qui pourrait bien être une composante essentielle du Cosmos. Les nouveaux outils d’observation et d’analyse qui seront prochainement opérationnels devraient permettre d’accomplir de nouvelles avancées décisives dans la connaissance de la nature profonde de notre Univers et dans la compréhension des forces et des principes qui en régissent son fonctionnement et son évolution.

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

e-mail : tregouet@gmail.com

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

Afin d’optimiser les interventions de maintenance, l’Institut de recherche en informatique de Toulouse (IRIT) vient de développer un nouvel outil numérique pour aider Enedis à prédire les risques de panne sur ses lignes électriques aériennes. Ce nouveau modèle de maintenance préventive s’appuie sur l’intelligence artificielle, et plus précisément sur des techniques d’apprentissage de type machine learning. « L’idée est de créer un modèle de prédiction, non pas à partir de connaissances expertes, mais en se basant sur l’historique des pannes déjà survenues », explique Mathieu Serrurier, chercheur à l’IRIT.

Pour mener à bien ce projet, plusieurs difficultés ont dû être surmontées. La principale étant le fait que les pannes sont des événements rares rapportés à une section de câble. Les chercheurs ont également dû travailler à partir d’un nombre de données limitées dans le temps puisque seules quatre années d’incidents étaient archivées.

Enfin, ils ont dû faire face à ce que les statisticiens appellent des données censurées. Il s’agit de données incomplètes liées à l’absence de panne observée sur certaines sections de câbles durant les quatre années. « Cela signifie que l’on ne connaît pas la distance de la prochaine panne, on sait juste qu’elle est supérieure à quatre ans », explique le chercheur. « Il s’agit d’un paramètre très important à prendre en compte, car cela ne veut surtout pas dire que la section ne tombera jamais en panne ».

Le nouvel outil développé fonctionne de la même manière que les modèles probabilistes. Il ne prédit pas la date à laquelle une panne va se produire, mais la probabilité qu’elle se produise dans les 2 ans, 4 ans, 10 ans… à venir. Pour traiter les données censurées, l’équipe de recherche s’est inspirée de modèles déjà existants, notamment ceux utilisés pour réaliser des prédictions de taux de survie en médecine. Étant donné qu’ils reposaient sur des modèles de statistiques linéaires, les chercheurs les ont développés pour les intégrer dans des réseaux de neurones. Au final, ce modèle se révèle plus élaboré et surtout capable de gérer des informations plus complexes comme des images ou du texte.

À l’avenir, le système pourra également intégrer des images satellites et ainsi identifier des problèmes d’élagage d’arbre pour ensuite prédire un risque de panne sur des sections. « Pour l’instant, l’outil intègre des paramètres plus simples comme l’âge de la ligne, le type de matériaux et des informations géographiques telles que la présence d’un bois le long d’une route », précise Mathieu Serrurier.

Les premiers tests du système ont donné des résultats probants. Les chercheurs n’ont pas pu comparer ce nouvel outil avec ceux actuellement utilisés par Enedis, car ces derniers doivent rester dans le domaine du secret industriel. Ces tests ont été réalisés sur des pannes déjà survenues en utilisant les trois premières années d’historiques de données pour prédire les pannes sur la quatrième année.

L’outil a aussi été testé dans un tout autre domaine, celui de la médecine, afin de prédire des taux de survie de patients recevant des traitements pour lutter contre des cancers. « Il s’agit de données avec lesquelles les chercheurs comparent régulièrement leurs algorithmes entre eux et qui sont publiques », ajoute le chercheur. « Nous avons donc réentraîné notre réseau de neurones à partir d’une nouvelle base de données et nous avons démontré qu’il améliorait de manière significative la qualité de la prédiction ». La connaissance d’un taux d’espérance de vie en médecine a pour but de donner des indications sur le type de thérapie à privilégier en fonction des caractéristiques des patients. Elle permet d’identifier des groupes de patients pour lesquels certaines thérapies fonctionnent mieux que d’autres.

Pour l’heure, ce nouvel outil a été fourni à Enedis, qui va poursuivre son développement, car l’entreprise dispose des connaissances lui permettant d’améliorer encore ses prédictions. « Elle pourra par exemple intégrer des images satellites, mais aussi d’autres données telles que la pluviométrie, le vent, les températures, le gel, l’altitude… Souvent, lorsque l’on développe des nouveaux modèles d’intelligence artificielle pour le secteur industriel, on s’aperçoit qu’ils fonctionnent bien, mais que nous manquons de données pour faire des prédictions de qualité.», conclut Mathieu Serrurier.

Article rédigé par Georges Simmonds pour RT Flash

Techniques de l'Ingénieur

|

|

| ^ Haut |

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

En mai 2020, les autorités de Singapour s’étaient déjà illustrées en déployant un robot-chien, Spot, de Boston Dynamics, dans le cadre d’un programme-pilote visant à faire respecter les règles de distanciation sociale pendant la pandémie de Covid-19. L’utilisation de ce robot, qui patrouillait dans le parc de Bishan-Ang Mo Kio, avait alors donné lieu à certaines publications sur les réseaux sociaux reliant cette approche à un épisode de la série futuriste et dystopique Black Mirror.

Plus récemment, la Home Team Science and Technology Agency (HTSTA) de Singapour a déployé deux autres robots autonomes baptisés Xavier. Ils seront chargés de traquer les incivilités commises par les habitants de la ville. Les robots sont notamment programmés pour détecter plusieurs violations telles que les vélos mal garés, le tabagisme en public, ou encore la détection des violations du protocole COVID. Une technologie de reconnaissance faciale intégrée leur permet en effet de repérer le non-port du masque sur les visages humains. À terme, il est prévu que ces robots appuient les forces de l’ordre.

« Xavier peut potentiellement augmenter notre présence en matière d’application de la loi et dissuader les comportements de mobilité active errants sur les sentiers », a déclaré Calvin Ng, directeur de l’application et de la gestion de la conformité de l’Autorité des transports terrestres. Là encore, ces robots n’ont pas vocation à remplacer les policiers, mais à les seconder. Tandis que les humains se chargeront des emplois à haute valeur ajoutée, les robots peuvent assurer ceux nécessitant peu de compétences. Et ce n’est qu’un début. L’entreprise singapourienne affirme en effet que ses robots pourraient représenter un quart des effectifs de la police de Dubaï d’ici 2030.

Article rédigé par Georges Simmonds pour RT Flash

Science Post

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Situées sur les communes de Torxé et Chantemerle-sur-la-Soie en Charente-Maritime (17), les 6 éoliennes de 3 MW se distinguent par leur facteur de charge exceptionnel : 40 %, un niveau proche de celui de l’éolien en mer. Développeur, constructeur et exploitant d’énergies renouvelables, BayWa r.e. a achevé la construction du parc éolien de Tout Vent après 11 mois de travaux et 10 ans de développement.

Ce parc se compose de 6 éoliennes Nordex N131 de 3 MW, soit une puissance totale de 18 MW qui permet de répondre à la consommation électrique annuelle de 10 000 foyers (chauffage inclus), et évite l'émission de 18 000 tonnes de CO2 chaque année. Les éoliennes de Tout-Vent sont équipées de rotor d’un diamètre de 131 m. Du fait de l’importante surface balayée par le rotor de chaque éolienne (13 500 m² par éolienne, soit l’équivalent de 8 terrains de football pour l’ensemble des 6 éoliennes), elles fonctionnent plus régulièrement, et atteignent plus rapidement leur puissance nominale de fonctionnement (3 MW). Le facteur de charge de ce parc éolien est ainsi particulièrement élevé : 40 %, contre 26 % en moyenne en France en 2020.

Les éoliennes du parc de Tout-Vent produisent 95 % du temps à des niveaux variables, et l’équivalent de 40 % du temps à leur puissance maximale. Leur production d’énergie représente le double des éoliennes qui auraient pu être installées sur ce même site il y a 10 ans (telle que des Enercon E82, éolienne la plus installée à l’époque).

« Les éoliennes qui sont installées aujourd’hui n’ont plus rien à voir avec celles des générations passées » explique Corentin Sivy, Directeur du développement de BayWa r.e. France. « La production d’énergie par mât installé a doublé en 10 ans, et l’énergie produite est plus régulière, ce qui facilite son intégration sur le réseau. Alors que son coût baisse régulièrement, moins de 60€ / MWh lors de l’appel d’offres de février 2021, contre plus de 80€ en 2010 cela en fait une source renouvelable de plus en plus pertinente. L’éolien a définitivement tenu ses promesses en France, où il vient d’ailleurs de supplanter le gaz comme troisième source d’énergie en France ».

L’énergie éolienne couvre désormais 9 % de la consommation d’électricité en France. Avec un objectif de 33 GW à l’horizon 2028, elle connaît une progression régulière du fait de la maturité de cette technologie et de son faible coût de production. Le dernier appel d’offres pour l’éolien terrestre, en établissant un prix moyen à 59,5 €/MWh en février 2021, confirme la baisse du coût de cette énergie.

Article rédigé par Georges Simmonds pour RT Flash

Enerzine

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Réserver une place sur un voilier comme on achète un billet d’avion ne sera bientôt plus une fantaisie. Il suffira de se rendre sur le site internet de Sailcoop et de choisir parmi les destinations. D’abord la Corse, dès l’automne 2021, promet la coopérative bretonne. Elle proposera ensuite des traversées nettement plus longues vers les États-Unis, les Antilles, l’Afrique et le Brésil.

À bord des navires, vous ne devriez pas trouver de businessmen pressés. Se déplacer en voilier nécessite en effet de redéfinir le concept du voyage, loin de celui dont l’avion nous a habitué. « Le but n’est pas le but, c’est la voie » disait Lao-Tseu. Vous pourrez vous répéter la célèbre phrase du sage chinois pendant les 24 à 36 heures de traversée entre la Corse et le continent. Il faudra prévoir un peu plus de divertissements pour les trois à quatre semaines de mer jusqu’à New-York.

Tous ceux pour qui le temps n’est pas un impératif pourront embarquer. Certains pourront même en profiter pour travailler puisqu’ils se verront proposer une connexion wifi, explique Sailcoop. Côté tarifs, la société prévoit entre 50 et 120 € par jour de navigation sur les lignes régulières vers la Corse et 80 à 110 €/jour sur les traversées transatlantiques. À 360 € l’aller-retour pour l’île de Beauté, ses voiliers devraient a priori transporter un public assez aisé. Une traversée qu’il faut toutefois percevoir comme une expérience intégrée au voyage dans son ensemble, au même titre que les activités et hébergements à destination.

Si l’idée est très originale, la demande existerait bel et bien selon Maxime de Rostolan, un des trois fondateurs de Sailcoop. L’homme, qui estime que « plus personne ne prendra l’avion pour son loisir » d’ici quelques années, planche sur une flotte de 500 navires pour 30 000 passagers en 2024. Selon la coopérative, 300 personnes ont déjà pré-réservé des traversées méditerranéennes et transatlantiques prévues en 2021 et 2022.

Article rédigé par Georges Simmonds pour RT Flash

Révolution Energétique

|

|

|

|

|

|

|

|

|

Une équipe internationale, associant des chercheurs allemands, italiens et israéliens, a montré que produire des aliments microbiens, à l'aide de CO2 et d'énergie solaire, pourrait être plus efficace que la culture de plantes, non seulement en matière de rendement calorique et protéique, mais également en matière de surfaces agricoles nécessaires. Cette méthode de production pourrait donc permettre de produire plus de nourriture, avec moins de ressources et moins de terres cultivées, ce qui préserverait bien mieux les écosystèmes.

La production d’aliments issus de la biomasse microbienne est déjà une réalité, puisque des entreprises produisent des protéines unicellulaires à partir d’algues, de champignons ou de bactéries. Toutefois, ces bactéries sont généralement cultivées à partir de produits dérivés de l’agriculture comme le glucose, ou de gaz, comme le méthane.

Dans cette étude, les chercheurs se sont focalisés sur la production de protéines unicellulaires à l’aide de l’énergie solaire. Ils ont imaginé un processus en quatre phases : en premier lieu, l'énergie solaire est captée et convertie en électricité par des panneaux photovoltaïques ; ensuite cette énergie électrique est convertie en énergie chimique par conversion électrochimique et stockée dans un donneur d’électrons ou une source de carbone ; troisième temps, cette énergie alimente la croissance microbienne ; dernière phase, le substrat ainsi obtenu est filtré, afin de séparer, d'une part, les nucléotides, acides gras et glucides, et d'autre part, les protéines à haute valeur nutritive.

Selon ces recherches, cette solution permet, pour une quantité de protéines équivalente, d’utiliser seulement 10 % de la surface au sol occupée par des plantations de soja, le type de culture végétale actuellement le plus efficace. Dorian Léger, qui a dirigé cette étude, souligne que « les protéines microbiennes seront également bénéfiques en tant que complément à nos régimes alimentaires, car elles constituent une source de protéines de haute qualité composée de tous les acides aminés essentiels, ainsi que de vitamines et de minéraux ».

Cette nouvelle et prometteuse voie de production durable de protéines est déjà suivie par la firme finlandaise Solar Foods, basée à Helsinki. Celle-ci mettra sur le marché l'année prochaine un nouveau produit appelé Solein. Il s'agit d'une protéine qui se présente sous la forme d'une farine déshydratée, et qui est obtenue à partir de microbes vivants, de CO2, d’eau et d’électricité renouvelable. Conçu à l'origine pour l'alimentation des astronautes, la Solein sera proposée au grand public sous forme de produits transformés.

Article rédigé par Georges Simmonds pour RT Flash

PNAS

|

|

|

|

|

|

|

Selon un étude internationale associant des chercheurs américains, chinois, norvégiens et néerlandais, une éruption volcanique en Sibérie aurait provoqué, il y a 252 millions d'années, une augmentation considérable des émissions de CO2, une hausse des températures de 15°C et une acidification des océans qui aurait déclenché l'extinction de l'ère du Permien-Trias, la 3ème du genre, considérée comme la pire catastrophe qu'ait connue la Terre.

Ce cataclysme inimaginable, qui aurait provoqué des émissions de 36 000 milliards de tonnes de CO2 dans l'atmosphère, aurait entraîné, en moins de 100 000 ans, la disparition de 96 % des espèces marines et de 75 % des espèces terrestres.

Article rédigé par Georges Simmonds pour RT Flash

PNAS

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

En Europe, les maladies cardiovasculaires sont toujours la principale cause de décès chez les adultes et les facteurs génétiques qui aggravent les risques cardiovasculaires restent mal pris en compte. Une équipe de cardiologues et de biologistes du Baylor College of Medicine (Texas), qui utilise des tests génétiques pour guider les soins cliniques, a présenté sa recherche qui permet de préciser et réaffirmer le risque génétique des maladies cardiovasculaires.

Selon ces chercheurs de Houston, la génétique d'un patient peut, en effet, détenir la clé d'une intervention précoce dans les maladies cardiovasculaires, avec de meilleurs résultats cliniques. Avec des experts du centre de séquençage du génome humain, les cardiologues de Baylor mènent ainsi cette étude pilote pour démontrer l’intérêt des tests génétiques pour les patients suivis pour troubles cardiovasculaires, le tout dans une optique de médecine de précision. L’étude pilote met en évidence les implications de tels tests sur le déroulement du traitement d’environ un tiers des participants.

Les chercheurs ont donc développé un panel « HeartCare » qui a permis d’identifier 158 gènes de vulnérabilité cardiovasculaire médicalement exploitables ainsi qu'un score de risque génétique pour le développement de maladies cardiovasculaires et des données génétiques sur les interactions médicamenteuses. 709 patients ont été inscrits dans les cliniques de cardiologie du Baylor College of Medicine et ont passé un test génétique gratuit dans le cadre de leurs soins de routine. L’analyse des données de tests montre que pour 32 % des participants testés, les résultats au test génétique ont eu un impact sur leur gestion clinique ; ces patients à scores de risque génétique élevés pourraient être traités avec des médicaments, un régime alimentaire et d'autres changements de mode de vie, concluent les auteurs.

L’étude suggère donc qu'une grande partie des patients souffrant de troubles cardiovasculaires et suivis en ambulatoire pourraient bénéficier de ces tests génétiques, conclut l’auteur principal, le Docteur. Richard Gibbs, directeur du Centre de séquençage du génome humain et professeur de génétique moléculaire et humaine à Baylor.

Article rédigé par Georges Simmonds pour RT Flash

GIM

|

|

|

|

|

|

|

|

|

Des chercheurs suisses de l'Université de Lausanne ont montré que l’acide lactique, ou lactate, une molécule produite par l’organisme pendant l’effort physique, agirait directement sur le cerveau et jouerait le rôle d’antidépresseur. Selon eux, cette molécule pourrait permettre de mieux traiter la maladie, que ce soit par des programmes d’exercice mais également en utilisant une molécule, aux propriétés antioxydantes, dérivée du métabolisme du lactate, le NAHD. Il s'agit de la forme active du nicotinamide, ou vitamine B3, connue pour son effet antidépresseur.

Ces résultats sont importants puisque, comme le relève l’auteur principal de l’étude, Jean-Luc Martin, « environ 30 % des personnes souffrant de dépression ne répondent pas aux antidépresseurs ». Il est donc essentiel de trouver d’autres moyens pour aider ces patients alors que la dépression touche plus de 260 millions de personnes dans le monde et plus de 3 millions en France.

Pour l’étude, les chercheurs ont administré à des souris des doses comparables de lactate à celles produites lors de l’activité physique. Ils ont constaté que cela permet de diminuer l’anhédonie, l'un des principaux symptômes de la dépression, qui consiste en une perte d'intérêt ou de plaisir pour toutes les activités qui, avant la dépression, étaient considérées comme agréables.

De plus, le lactate favorise la neurogenèse dans l'hippocampe, une zone du cerveau impliquée dans la mémoire mais aussi dans la dépression. Or, ce processus, qui permet de remplacer les neurones, se trouve altéré chez les patients dépressifs, pouvant amener à une réduction du volume de l'hippocampe. En restaurant ce mécanisme, l’acide lactique a permis de réduire le comportement dépressif chez la souris.

Les chercheurs doivent désormais confirmer ces résultats chez l'humain mais estiment qu'ils offrent de nouvelles pistes de traitement de la dépression. « Ces mécanismes contribuent à expliquer un des liens au moins entre le sport et ses effets contre la dépression, et suggèrent des cibles possibles pour de futurs traitements : faire du sport ou relancer la neurogenèse par une molécule antioxydante comme le NADH », ont conclu les chercheurs.

Article rédigé par Georges Simmonds pour RT Flash

MD

|

|

|

|

|

|

|

|

|

Les immunothérapies, ces nouveaux traitements contre le cancer, s’avèrent si puissantes qu’elles en deviennent nocives pour le corps humain. Leur principe est simple. Des substances chimiques, notamment des protéines telles que des anticorps et des cytokines, fabriquées ou modifiées en laboratoire, sont injectées au malade. Ces protéines viennent aider et activer les cellules immunitaires — dont les lymphocytes ou cellules T font partie — à combattre les tumeurs.

L’immunothérapie peut se résumer à un cocktail ultra boostant qui stimule notre système défensif. « Lorsqu’un médecin prescrit ce type de traitement à un patient, on le lui transmet par voie intraveineuse et il se diffuse partout, pas seulement là où se trouvent la tumeur ou les métastases. Les protéines utilisées sont tellement fortes qu’elles endommagent des tissus sains », explique Li Tang, directeur du Laboratoire de biomatériaux pour l’immuno-ingénierie de la faculté des Sciences et techniques de l’ingénieur. « La plupart des immunothérapies développées en phase préclinique se montrent très puissantes pour lutter contre le cancer. Mais, elles ne peuvent pas être utilisées sur des patients, car trop dangereuses pour le reste du corps. Du coup, les thérapies administrées aujourd’hui sont moins intenses et par conséquent moins efficaces pour ne pas être trop néfastes.

À l’EPFL, l’équipe du professeur Li Tang a donc travaillé sur un moyen d’activer le traitement d’immunothérapie uniquement quand les protéines qui le composent se trouvent en contact avec les tissus tumoraux. Elle est pionnière dans le développement de ce type de technologie basée sur la chimie. « Nous y sommes arrivés grâce à l’interdisciplinarité du laboratoire : un mélange de chimie et d’immuno-ingénierie », déclare Li Tang. L’étude est publiée dans la revue Science Advances.

Yu Zhao, postdoctorant, s’est tout d’abord intéressé à l’environnement chimique des cellules cancéreuses. « Ce dernier demeure très différent du reste du corps. Par exemple, le pH, soit l’acidité, est plus faible, de même que l’intérieur de la cellule cancéreuse se caractérise par un état de réduction chimique », explique-t-il. À partir de ces données déjà bien connues, le chercheur a construit une enveloppe, composée de polymère, entourant la protéine médicamenteuse afin qu’elle puisse voyager jusqu’à la tumeur sans répandre sa toxicité dans les tissus et organes sains.

Comment a-t-il procédé ? « J'ai d'abord développé des liaisons chimiques sensibles aux stimuli qui se fixent à la surface des molécules de protéines, comme de petits crochets. À ces liens, j’ai ajouté des polymères qui sont de très longues molécules et les ai "accrochés" aux liens des protéines. Ils viennent complètement recouvrir la surface de la protéine et agissent comme un bouclier », indique Yu Zhao.

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

|

|

|

|

|

|

|

Un individu sur trois est concerné par l’hypertension artérielle, mais moins de la moitié des patients atteints se traitent, selon l’OMS. Il s’agit de la pathologie chronique la plus fréquente en France. On parle d’hypertension artérielle lorsque ces chiffres dépassent 140/90. Selon l’Inserm, l’hypertension artérielle est la première cause d’accident vasculaire cérébral (AVC) évitable. Autrement dit, si l’hypertension artérielle de ces personnes avait été prise en charge, ils n’auraient certainement pas fait d’AVC. Les traitements proposés sont médicamenteux, avec une prise généralement quotidienne.

Selon une étude américano-australienne, manger du yaourt pourrait abaisser la tension artérielle des personnes âgées qui souffrent d’hypertension artérielle. Pour parvenir à cette conclusion, les chercheurs ont analysé les données de 915 adultes, âgés en moyenne de 62 ans. Environ 62 % des participants avaient une pression artérielle élevée définie, c’est-à-dire supérieure à 140/90.

Pour cette majorité, la consommation de yaourt diminuait la pression artérielle. En revanche, ce n’était pas le cas pour ceux qui avaient une tension artérielle normale. Ces résultats étaient observables aussi quand les chercheurs ont enlevé d’autres variables comme l’âge, le sexe, le diabète, l’indice de masse corporelle, le cholestérol, la glycémie, l'exercice ainsi que d'autres variables alimentaires.

Article rédigé par Georges Simmonds pour RT Flash

Science Direct

|

|

|

|

|

|

|

|

|

En 2019, les analgésiques opioïdes auraient été responsables de plus de 70 000 décès aux États-Unis, un bilan humain catastrophique. En Europe et en France, le phénomène est moindre mais suscite également des inquiétudes.

Les effets secondaires des médicaments sont souvent dus à des interactions involontaires avec de mauvaises cibles dans notre organisme. Aujourd’hui, les traitements médicamenteux dont nous disposons sont de plus en plus spécifiques à leurs cibles, grâce aux efforts considérables de la recherche pour réduire les effets secondaires. Toutefois, l’action des médicaments, même sur leur cible, peut encore produire des effets secondaires, parfois graves.

Ainsi, les médicaments opioïdes agissent sur nos récepteurs opioïdes, qui contrôlent non seulement la douleur, mais aussi la récompense, la dépendance, l’humeur et encore d’autres fonctions. S’ils réduisent la douleur, ces médicaments peuvent également produire une sensation d’euphorie ou de plaisir et devenir addictifs. En cas de consommation abusive, une surdose peut même conduire à un arrêt respiratoire et être fatale.

Afin de développer des médicaments plus sûrs, qui agiraient uniquement sur la douleur sans les effets secondaires, l’un des enjeux de la recherche est d’identifier la zone des récepteurs opioïdes impliquée spécifiquement dans le contrôle de la douleur, en quelque sorte le « bouton anti-douleur » des récepteurs. La nouvelle étude portée par l’équipe du directeur de recherche Inserm Sébastien Granier à l’Institut de génomique fonctionnelle (Inserm/CNRS/Université de Montpellier) apporte désormais des réponses à ce sujet.

Les récepteurs opioïdes sont des récepteurs couplés aux protéines G (on parle de récepteurs RCPG). Les humains possèdent 800 types de RCPG, qui contiennent les cibles d’environ 40 % des médicaments commercialisés. Cette famille de protéines partage une même architecture tridimensionnelle et deux principales voies de signalisation à l’intérieur des cellules. Sous l’effet de stimuli (par exemple, un contact avec des médicaments), un RCPG comme les récepteurs opioïdes va adopter différentes conformations pour activer ou pour inhiber les voies de signalisation moléculaires de manière spécifique à l’intérieur des cellules, afin de déclencher différentes réponses et réactions biologiques.

En 2012, Sébastien Granier et ses collègues avaient déjà obtenu les premières structures 3D à haute résolution des récepteurs opioïdes. En 2015, son équipe était allée un peu plus loin, mettant au point une stratégie permettant d’observer les changements de conformations d’un récepteur opioïde particulier (le récepteur mu-opioïde), cible principale des analgésiques opioïdes, pendant sa réponse à ces médicaments. A présent, en comparant des opioïdes à d’autres molécules ayant peu d’effets secondaires, l’équipe vient de découvrir les rouages moléculaires qui seraient impliqués spécifiquement dans la réponse anti-douleur.

Pour parvenir à ces nouveaux résultats, les chercheurs ont combiné plusieurs méthodes innovantes en s’appuyant sur des simulations informatiques (en utilisant l’un des supercalculateurs les plus rapides de France, OCCIGEN), la spectroscopie RMN et des essais de pharmacologie sur cellules vivantes. Ils ont ainsi pu décrire dans les moindres détails la manière dont le récepteur mu-opioïdes répond aux analgésiques, pour identifier le « bouton » anti-douleur spécifique de ce récepteur.

Deux modèles 3D du récepteur mu opioïde avec des analgésiques opioïdes : la substance médicamenteuse ayant peu d’effets secondaires (oliceridine) s’insère plus profondément dans la poche du récepteur qu’un opioïde classique, et ferme un espace dans le récepteur probablement à l’origine des effets secondaires.

Les implications thérapeutiques de ces travaux sont potentiellement très importantes. « Mieux comprendre les mécanismes sous-jacents à l’inhibition ou à l’activation des voies de signalisation et identifier de manière plus précise l’endroit du récepteur sur lequel agissent les médicaments opioïdes est une grande avancée pour permettre à terme de développer des nouvelles molécules plus ciblées, activant seulement les voies qui nous intéressent, sans effets secondaires », souligne le chercheur Inserm Rémy Sounier, qui a co-dirigé cette étude.

Article rédigé par Georges Simmonds pour RT Flash

Inserm

|

|

|

|

|

|

|

|

|

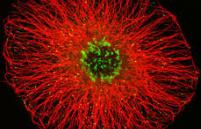

Dans notre système nerveux, la transmission de l’influx nerveux (messages nerveux) se fait par le biais des prolongements des neurones, les axones, entourés d’une gaine isolante appelée myéline. Les nœuds de Ranvier, de petits domaines intercalés entre les segments de myéline, sont indispensables pour la diffusion rapide de l’information, mais ils sont aussi une plaque tournante d’interactions cellulaires dans le cerveau.

Des études antérieures avaient déjà montré que certains types de cellules du cerveau, comme les oligodendrocytes et les astrocytes, formaient des contacts avec les neurones au niveau de ces nœuds de Ranvier. En revanche, les interactions avec un autre type de cellules essentielles du cerveau, les microglies, n’avait pas été explorées. Ces cellules immunitaires jouent pourtant un rôle clé de protection du cerveau ainsi que dans des processus régénératifs comme la remyélinisation, la reformation de la gaine de myéline, qui est atteinte dans des pathologies comme la sclérose en plaques.

Une étude conduite à l’Institut du Cerveau par la chercheuse Inserm Anne Desmazières et ses collègues Rémi Ronzano et Thomas Roux dans l’équipe de Catherine Lubetzki (AP-HP/Sorbonne Université), montre pour la première fois que des contacts et une communication existent entre les neurones et les cellules microgliales au niveau des nœuds de Ranvier.

Grâce à des études menées sur des modèles murins ex-vivo (cultures tissulaires) et in-vivo, notamment par des approches d’imagerie en temps réel permettant d’observer la dynamique de ces contacts, mais également sur du tissu humain, les chercheurs ont révélé une interaction particulièrement stable entre ces deux types de cellules, et un dialogue renforcé dans un contexte de régénération de la myéline. Ils ont également identifié les mécanismes sous-jacents à ce dialogue. C’est l’activité neuronale qui est le médiateur de l’interaction et la renforce.

Les microglies sont capables de « lire » l’information qui arrive au niveau des nœuds de Ranvier sous la forme de signal ionique, modulant ainsi leur état et leur interaction avec le neurone. Une altération de ce signal ionique peut maintenir les microglies dans un état pro-inflammatoire, les empêchant de jouer leur rôle pro-régénératif et pro-remyélinisant.

Dans le cas de la sclérose en plaques, cette découverte ouvre plusieurs pistes de recherche pour mieux comprendre la pathologie, notamment celle de l’impact des signaux inflammatoires existant dans cette maladie sur le dialogue neurone-microglie et le potentiel pro-remyélinisant de la microglie. La découverte de ce dialogue est d’autant plus intéressante que des thérapies à l’essai dans la sclérose en plaques tentent aujourd’hui d’agir sur la physiologie de ces microglies afin de favoriser leur caractère pro-régénératif.

Ce nouveau mode de communication mis en évidence pose aussi la question de l’impact de l’activité neuronale sur le comportement des microglies. En effet, de nombreuses pathologies neurologiques, dont l’épilepsie, sont associées à des altérations de l’activité des neurones, et les conséquences de cette altération sur les cellules microgliales sont encore, à ce jour, inconnues.

Article rédigé par Georges Simmonds pour RT Flash

Inserm

|

|

|

|

|

|

|

|

|

Des chercheurs de l’Université du Texas Southwestern ont développé une nouvelle immunothérapie visant à épuiser efficacement les cellules immunosuppressives (Tregs) à l'intérieur des tumeurs, ce qui permet au système immunitaire de combattre les tumeurs sans avoir besoin de devenir hyperactif.

Depuis des dizaines d’années, les chercheurs savent que le système immunitaire joue non seulement un rôle clé dans la lutte contre les cancers grâce à l'action directe des cellules T tueuses et d'autres composants, mais aussi par le biais de cellules appelées cellules T régulatrices (Treg). Ces Tregs aident à réguler la réponse immunitaire en empêchant différentes cellules immunitaires de devenir hyperactives et de provoquer des réactions auto-immunes néfastes. Cependant, ces Tregs s'accumulent également dans les tumeurs, les protégeant des attaques immunitaires.

Une molécule à deux bras ou « à 2 coups » parvient à épuiser et éliminer ces cellules protectrices du cancer et va donc permettre de nouvelles immunothérapies du cancer. « La molécule en question élimine efficacement ces cellules Tregs immunosuppressives à l'intérieur de la tumeur -plutôt que dans tout le corps-, permettant alors au système immunitaire d’attaquer la tumeur sans provoquer de réponse auto-immune nocive », résume l’auteur principal, le Docteur Yang-Xin Fu, professeur de pathologie, immunologie et radio-oncologie à UT Southwestern.

Les Tregs maintiennent un équilibre de 2 protéines de surface – CTLA-4 et CD47 – qui diffusent respectivement des signaux « mange-moi » et « ne me mange pas » aux phagocytes qui contrôlent les Tregs, expliquent les chercheurs. Des tentatives d’immunothérapie ont cherché à augmenter le signal « mangez-moi » ou à diminuer le signal « ne me mangez pas » pour réduire les Tregs dans les tumeurs. Cependant, chaque stratégie présente des inconvénients : l'augmentation du signal « mangez-moi » a des effets systémiques qui stimulent l'auto-immunité, tandis que la diminution du signal « ne me mangez pas » n’apparaît efficace que pour le traitement des cancers du sang, tels que les leucémies.

La molécule en question est dite « à deux bras » car elle peut simultanément augmenter le signal « mange-moi » et bloque le signal « ne me mange pas ». Injectée dans des souris modèles de cancer du côlon, la molécule élimine les Tregs dans les tumeurs sans affecter celles présentes dans le reste du corps, ce qui évite les réactions auto-immunes incontrôlées. La molécule finit par réduire le nombre de Tregs au point que les tumeurs sont considérablement réduites. La stratégie fait ainsi ses preuves d’efficacité chez la souris porteuse de cancer du poumon (tumeur du poumon humain), ce qui laisse espérer que cette approche se montre également efficace chez l'Homme.

Article rédigé par Georges Simmonds pour RT Flash

UTSW

|

|

|

|

|

|

|

|

|

Une étude rassemblant des chercheurs de Lyon et Saint-Étienne (Hospices Civils de Lyon, le CHU de Saint-Étienne, l’Université Claude Bernard Lyon 1, l’ENS de Lyon, l’Université Jean-Monnet de Saint-Étienne, l’Inserm, le CNRS et bioMérieux) vient de montrer qu'une primo-vaccination avec deux vaccins différents serait plus efficace qu’une vaccination avec deux vaccins identiques. L’étude a été menée sur 13 121 soignants des Hospices civils de Lyon, ayant reçu soit deux injections du vaccin Pfizer à 4 semaines d’intervalle (schéma homologue), soit le vaccin développé par AstraZeneca, suivi 12 semaines plus tard d’une injection avec le vaccin développé par Pfizer (schéma hétérologue).

Dans cette cohorte, moins de 1 % des sujets ont été contaminés par le SARS-CoV-2 après un schéma de vaccination complet. Toutefois, une protection environ deux fois plus importante vis-à-vis de l’infection a été observée dans le groupe ayant reçu la combinaison AstraZeneca/Pfizer. « Nous avons étudié les paramètres immunitaires dans un sous-groupe de sujets, et nous avons remarqué que la qualité des anticorps et des réponses cellulaires - notamment concernant les lymphocytes B mémoires - était meilleure après une vaccination hétérologue », explique le Docteur Sophie Trouillet-Assant (HCL). « Et que les anticorps générés après une vaccination hétérologue, sont plus efficaces pour neutraliser les différents variants du SARS-CoV-2, que ceux générés après une vaccination homologue », précise le Professeur Stéphane Paul (CHU de Saint-Etienne).

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

| ^ Haut |

|

|

|

|

|

|

|

Recherche |

|

|

Recherche & Innovation, Technologies, Transports

|

|

|

|

|

|

|

|

|

|

La RATP teste un bus autonome sur la ligne 393 qui relie Sucy-Bonneuil à Thiais-Carrefour de la Résistance. Pour l'instant le bus autonome circule de nuit avec un chauffeur de sécurité à son bord. L'étape suivante consistera à réaliser des tests lors des périodes creuses de la journée afin de voir comment le bus autonome s'insère sur cette ligne. Enfin, la RATP espère accueillir du public à bord à l'automne 2022. D'ici là, les essais seront multipliés afin d'améliorer le système embarqué.

La ligne de bus 393 qui relie Sucy-Bonneuil à Thiais-Carrefour de la Résistance est un peu particulière. Elle devient la première à accueillir un bus autonome à l'occasion d'une expérimentation menée par la RATP. Dans le cadre de ce projet, le bus doit parcourir la moitié de la ligne en mode autonome, soit un parcours d'environ 6 kilomètres. Le tout avec un chauffeur de sécurité à son bord.

Le bus ayant été réceptionné cet été par la RATP, ses capacités ont déjà longuement été testées, que ce soit lors de simulations ou d'essais sur circuit fermé. Le but est de s'assurer qu'il réponde bien aux caractéristiques vendues par le constructeur chinois CRRC et de l'entraîner à franchir certaines courbes ou certains passages de son futur trajet. Il s'agit aussi de s'assurer de la sécurité informatique des systèmes embarqués. Une fois ces tests réalisés, la RATP peut entrer dans la seconde phase : les essais en conditions réelles.

Dans un premier temps, le bus autonome est testé de nuit sans aucun passager à son bord afin de ne pas ralentir l'exploitation de cette ligne. Il sera ensuite testé de jour, sur les périodes creuses, toujours dans le but de ne pas gêner l'exploitation mais aussi de voir comment ce bus peut s'insérer sur cette ligne. Pour l'instant « le bus est limité à 15 km/h en courbe et 30 km/h en ligne droite », précise Côme Berbain, directeur de l'innovation à la RATP. Pour passer à la seconde phase des essais, il est nécessaire d'augmenter sa vitesse moyenne pour arriver à un temps de parcours acceptable sur ce tronçon. Le trajet doit être réalisé en 30 minutes contre 40 actuellement.

Les essais en conditions réelles permettent également de multiplier les situations rencontrées par le bus autonome : le système embarqué apprend et sait comment réagir la fois d'après. Certains réglages doivent également être réalisés. Si le bus a circulé sous de fortes averses le jour où L'Usine Digitale est monté à son bord, des freinages intempestifs, liés au passage d'un autre bus sur la voie d'en face ou à la présence de plante débordant sur la route, doivent être corrigés.

Un des points important à mettre en avant avec cette expérimentation est que la RATP cherche à « toucher le moins possible à l'infrastructure », selon Côme Berbain, puisque la mise en place d'une infrastructure pouvant communiquer avec un véhicule autonome est coûteuse. Cette ligne 393 a notamment été sélectionnée pour cela : le bus est en site propre, ce qui signifie qu'il a une ligne dédiée, séparée des voies utilisées par les autres véhicules, et qu'un système de priorité aux feux existe déjà. « La ligne 393 est l'une des plus utilisée d'Ile-de-France, elle accueille 20 000 voyageurs par jour », ajoute-t-il.

Enfin, la RATP espère accueillir du public dans ce bus autonome à l'automne 2022. La seconde partie du trajet sera-t-elle réalisée par le conducteur ? Une ligne spéciale ne faisant qu'une moitié du trajet sera-t-elle mise en place avec ce bus autonome ? La question n'est pas encore tranchée. La RATP a déjà ouvert un appel à projets dans le but de s'équiper d'un second bus autonome, provenant d'un autre constructeur, qui devrait venir rejoindre cette ligne. Et d'ici la fin de l'année, elle espère mettre en place son projet des trois gares qui consistent à relier à l'aide de navettes autonomes les gares d'Austerlitz, de Bercy et de Lyon.

Article rédigé par Georges Simmonds pour RT Flash

RATP

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|