TIC

- Information et Communication

- Informatique

Edito : L’ordinateur photonique pourrait bien concurrencer l’ordinateur quantique…

- Tweeter

-

-

8 avis :

Il y a quelques semaines, Apple a annoncé la commercialisation, pour ses stations de travail, d’une puce baptisée M1MAX, qui ne compte pas moins de 114 milliards de transistors, c’est-à-dire 50 millions de fois plus que le premier microprocesseur d’Intel, sorti en 1971, qui en intégrait…2200. En laboratoire, IBM est déjà capable de graver des puces en 2 nanomètres qui promettent une autonomie quatre fois supérieure à celle des puces actuelles. Quant à Intel, il prévoit lui aussi de passer à la gravure à 1,8 nanomètre en 2025, puis de descendre à 1,4 nanomètre en 2029, ce qui correspond à seulement cinq atomes de cuivre et à une réduction d’un facteur 100 de la finesse de gravure en 25 ans… Mais si la loi de Moore, qui prévoit que le nombre de transistors intégrés sur une puce double tous les deux ans, a été globalement respectée depuis presque 60 ans, nous allons bientôt atteindre, en descendant sous le nanomètre, les limites autorisées par les lois de la physique, en matière de miniaturisation électronique. Pour surmonter cette barrière, chercheurs et ingénieurs s’orientent principalement dans deux voies de recherche que j'ai régulièrement évoquées dans mes éditos : l’informatique quantique et l’informatique photonique, qui utilise la lumière pour aller toujours plus vite.

A l'occasion du récent « Think Boston », IBM a dévoilé sa nouvelle feuille de route pour l'informatique quantique. Celle-ci vise un processeur quantique universel à 1000 qubits en 2023, un processeur à 1386 qubits en 2024, puis des processeurs quantiques apportant une puissance de calcul de plus de 4158 qubits en 2025 (Voir IBM).

IBM entend bien rendre l’informatique quantique accessible à tous les domaines d’activités, à commencer par ceux qui ont un besoin urgent de dépasser les limites actuelles en matière de puissance de calcul, et sont prêts à payer très cher ce nouvel avantage compétitif. Selon Capgemini, 23 % des entreprises dans le monde étudient ou prévoient d'étudier l’exploitation des technologies quantiques de nouvelle génération. 43 % s’attendent à ce que les nouvelles technologies quantiques permettent d’aboutir à de premiers usages commerciaux d’ici cinq ans. Les firmes les plus demandeuses de cette rupture quantique appartiennent principalement à trois secteurs, les télécoms (41 %), les transports (36 %), et les sciences de la vie (30 %). Mais, comme l’explique fort bien Frédéric Magniez, directeur de recherche à l’Institut de recherche en informatique fondamentale, « L’informatique quantique, en raison de son mode particulier de fonctionnement, va rester cantonnée pendant plusieurs années dans des domaines d’application précis, là où elle peut vraiment apporter un avantage en terme de calcul. En outre, pour que les ordinateurs quantiques déploient toutes leurs potentialités, il faudra d’abord réécrire les programmes et déterminer pour quels types de calcul ces programmes vont vraiment apporter un avantage significatif, par rapport aux superordinateurs classiques ».

On le voit, l’ordinateur quantique universel, capable de traiter tout type de problème, n’est pas encore pour demain, et les obstacles matériels (réduction du taux d’erreur provoqué par la décohérence) et logiciels (optimisation des algorithmes) pour parvenir à une telle machine s’avèrent plus coriaces que prévu. Profitant de ces difficultés, l’ordinateur optique, ou photonique, compte bien s’imposer dans les domaines qui requièrent une très grosse puissance de calcul. Au Japon, l’équipe de Hiroyuki Tamura (société technologique japonaise NTT), travaille sur une solution optique spécialement conçue pour résoudre les problèmes d’optimisation qui consistent à trouver la meilleure solution parmi d’innombrables options possibles, par exemple dans le domaine logistique, en programmant des livraisons dans une ville, ou énergétique, en calculant en temps réel le meilleur mix énergétique, en fonction de la demande et des capacités de production des différentes sources d’énergie.

Le prototype développé génère 100 000 impulsions optiques dans une bobine de fibre optique. Chaque impulsion reçoit une valeur positive ou négative et le programme lui indique avec quelles autres impulsions elle doit interagir. Ces impulsions circulent ensuite autour de la bobine et interagissent les unes avec les autres jusqu’à ce qu’elles atteignent un état stable qui représente la meilleure solution. Après avoir construit une première version qui comprime 2000 impulsions dans une fibre d’un kilomètre de long, ces chercheurs en ont construit une autre qui permet d’insérer 100 000 impulsions dans une fibre de 5 kilomètres de long. Avec cette nouvelle machine, en cours d’expérimentation, cette équipe japonaise pense pouvoir optimiser en quelques semaines des problèmes complexes qui nécessiteraient des siècles de calcul, avec des ordinateurs conventionnels, même très puissants.

Cet ordinateur de NTT contenant une fibre d’un kilomètre de long a été testé contre le D-Wave, le premier ordinateur quantique commercial, sur une série de problèmes expérimentaux d’optimisation. Alors que le D-Wave a mieux réussi à résoudre les petits problèmes, l’appareil de NTT a fait beaucoup mieux pour les problèmes plus importants, qui nécessitent plus d'interconnexions, et sont plus proches des problèmes du monde réel (Voir Science Advances). Cette différence tient au fait que le D-Wave utilise des qubits qui sont des équivalents quantiques des bits "classiques" dans un ordinateur. En revanche, la machine optique de NTT peut relier chaque impulsion à toutes les autres, contrairement au D-Wave, qui ne peut relier qu’un nombre limité de ses qubits. C’est cette plus grande connectivité intrinsèque qui permet à l’ordinateur NTT de résoudre finalement des problèmes plus complexes. Comme le souligne le Professeur Tamura, « Les ordinateurs quantiques plus puissants sur lesquels travaillent Google et IBM finiront peut-être par surpasser notre ordinateur optique, mais sans doute pas avant des décennies. Notre ordinateur optique à 100 000 impulsions sera, lui, pleinement opérationnel dans deux ans ».

En octobre dernier, une autre équipe de recherche internationale dirigée par le Professeur Pavlos Lagoudakis, et associant Skoltech et IBM, a présenté un commutateur optique qui ne consomme pratiquement pas d’énergie et pourrait se substituer aux transistors électroniques. Ce commutateur n'a pas besoin de refroidissement et il est jusqu’à 1000 fois plus rapide que les meilleurs transistors commerciaux d’aujourd’hui (Voir Nature). « Si notre dispositif est si économe, c’est parce qu’il suffit de quelques photons pour commuter. En laboratoire, nous avons même montré qu’une commutation était possible avec un seul photon », précise le professeur Pavlos Lagoudakis.

Une équipe de recherche associant des scientifiques des universités Rochester (Etat de New York) et Friedrich-Alexander (Nuremberg) a réussi à créer des portes logiques optiques qui seraient un million de fois plus rapides que celles que l’on trouve actuellement dans nos ordinateurs (Voir University of Rochester). Le transistor, clé de voute de l’informatique, comporte 4 éléments : le canal, qui assure la circulation de l’électricité, la source et le drain, et la grille qui fait office d’interrupteur dans la circulation des électrons entre la source et le drain.

Cette nouvelle porte logique utilise l’énergie du laser pour guider le mouvement des électrons dans la matière. Concrètement, ces lasers produisent des salves d’énergie extrêmement brèves (environ une femtoseconde, c’est-à-dire un millionième de milliardième de seconde). Ces impulsions laser vont éclairer de minuscules fils à base de graphène reliant deux dispositifs en or, exciter les électrons du graphène et les guider dans une direction particulière, ce qui permet de générer un courant électrique. Ces recherches ont montré qu’en modifiant la forme de l’impulsion laser, il devenait possible de générer des courants dans lesquels seuls les porteurs de charge d’un seul type jouent un rôle, ouvrant ainsi la voie à un contrôle indépendant de ces deux types de courants. Avec de telles portes logiques, la commutation entre zéro et un peut se faire à une vitesse prodigieuse, jusqu’à un million de fois plus rapide que celle des puces actuelles. « Notre dispositif est un remarquable exemple de la façon dont la science fondamentale peut conduire à de nouvelles technologies », souligne Ignacio Franco, l’un des chercheurs qui a dirigé ces travaux.

En janvier dernier, une autre équipe de l’EPFL a également accompli un progrès majeur vers la réalisation de puces photoniques compactes et portables. Les chercheurs du laboratoire de systèmes photoniques, dirigés par la professeure Camille Brès, ont réussi à appliquer un nouveau principe pour induire de la non-linéarité optique du deuxième ordre à des puces en nitrure de silicium (Voir Nature Photonics). Ces recherches ont montré qu’il était possible d’intégrer cette fonctionnalité non-linéaire sur des puces photoniques qui peuvent être fabriquées avec les techniques standards développées pour l’électronique (CMOS), et utilisent des matériaux standards, tels que le silicium ou le nitrure de silicium.

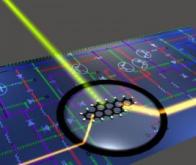

On s’en doute, dans cette vive compétition pour maîtriser la construction d’un ordinateur entièrement photonique, les grands de l’électronique et de l’informatique redoublent d’effort. Il y a quelques semaines, une équipe associant l’EPFL, les universités d’Oxford, Münster, Exeter et Pittsburgh, ainsi que le laboratoire de recherche d’IBM de Zurich, a présenté une étude montrant qu’il était possible d’utiliser de multiples longueurs d’ondes pour réaliser des calculs en parallèle. Pour atteindre ce résultat très convoité, les chercheurs ont utilisé pour la première fois un "peigne de fréquences optiques" sur puce. Ce nouveau dispositif permet en effet de produire différentes longueurs d’ondes optiques, qui peuvent être traitées séparément les unes des autres, au sein d’une même puce photonique. Comme ‘explique Wolfram Pernice, de l’Université de Münster, « Les processeurs photoniques dédiés à l’accélération des tâches dans le domaine de l’apprentissage automatique permettent de traiter des tâches mathématiques complexes à grande vitesse et avec un rendement élevé. Cette méthode est bien plus rapide qu’avec les puces conventionnelles qui reposent sur le transfert électronique des données ».

Ces chercheurs ont pu montrer l’efficacité de ces puces photoniques en les testant sur un réseau neuronal capable de reconnaître les nombres écrits à la main. Dans cette tâche qui nécessite une grosse puissance de calcul, l’utilisation du multiplexage en longueur d’onde a permis d’atteindre des vitesses de données et des densités de calcul (nombre d’opérations par zone de processeur) encore jamais atteintes. Ces puces lumineuses pourraient avoir de multiples applications dans de nombreux domaines gourmands en calcul, santé, industrie, transports, énergie, bien avant que les premiers ordinateurs quantiques ne soient opérationnels. « Ce travail est exemplaire en matière de recherche collaborative européenne, car il a su fédérer les compétences très diverses de chaque groupe de travail », souligne David Wright de l’Université d’Exeter, directeur du projet européen FunComp, qui a financé les recherches.

En décembre dernier, la jeune société française LightOn a annoncé l'intégration d'un de ses coprocesseurs photoniques dans le supercalculateur Jean Zay, l’un des supercalculateurs les plus puissants au monde, actuellement classé 105ème au Top500. Cette machine unique en son genre est désormais le premier calculateur haute performance (HPC) à disposer d'un coprocesseur photonique, qui utilise la lumière à la place d’un courant d’électrons.

Fondée en 2016, LightOn est une startup française qui a su acquérir une réputation mondiale dans le développement d’ordinateurs photoniques destinés à l’Intelligence Artificielle. Cette société est convaincue que l’avenir de l’intelligence artificielle passera par le photon, qui détrônera l’électron. LightOn a réussi une véritable rupture technologique en concevant un nouveau mode de production de matrices aléatoires, un outil issu du calcul des probabilités, devenu indispensable au développement des algorithmes d'apprentissage profond, capables de traiter un grand nombre de données.

Concrètement, cette nouvelle approche consiste à utiliser un faisceau laser qui va être dispersé et altéré à travers différents composants optiques, formant ainsi une matrice de grande dimension de points lumineux. Cette matrice est alors captée par une caméra, puis reconvertie sous forme de signal numérique. Comme cette opération se fait à la vitesse de la lumière, elle s’avère bien plus rapide et bien moins coûteuse en énergie que si elle était effectuée par des composants électroniques. Grâce à sa technologie, LightOn atteint une vitesse de calcul sur des tâches de type Transfer Learning 5 fois supérieure aux GPU du marché et 200 fois supérieure à un CPU sur une analyse de série temporelle par un réseau de neurones récurrents. Quant à la consommation d’énergie, elle est, en moyenne, 30 fois moins importante que celle des classiques GPU. Selon LightOn, le calcul effectué dans l’OPU Aurora 1.5, son premier prototype photonique, permet de multiplier l’image initiale par une matrice comportant 170 milliards de coefficients, ce qui correspond à trois millions de milliards d’opérations par seconde, pour une consommation de seulement 30 watts. Le ratio énergie/puissance représenterait donc un gain de trois ordres de grandeur, par rapport aux meilleurs processeurs actuels…

Là encore, il est important de souligner que cette première mondiale, qui intègre une nouvelle technologie de calcul au sein de l'un des superordinateurs les plus puissants du monde n'aurait pas été possible sans une coopération exemplaire d’organismes et de structures visionnaires comme GENCI (Grand Equipement National de Calcul Intensif), l'IDRIS (Institut du développement et des ressources en informatique scientifique) et le CNRS (Centre National de la Recherche National).

Equipé de cette technologie photonique, le nouveau supercalculateur Jean Zay pourrait bien permettre des avancées majeures dans les domaines de l'apprentissage automatique, le traitement du langage naturel, ou de l'analyse d'imagerie satellitaire. « La technologie Optical Processing Unit développée à LightOn est fascinante. Elle va permettre d’effectuer une série de calculs stochastiques bien plus rapidement qu’avec les GPU, sur des données de plus grande taille, et avec une consommation électrique moindre. C’est une révolution dans notre domaine », souligne le Dr Maurizio Filippone, expert en apprentissage statistique à Eurecom.

Evoquons enfin la jeune mais talentueuse société Quandela, fondée en 2017 par trois chercheurs du CNRS, qui projette la mise à disposition, dès cette année, sur le cloud, de son ordinateur quantique photonique. Quandela est l’une des seules sociétés au monde qui va proposer à ses clients un ordinateur photonique quantique à six qbits, fonctionnant à température ambiante. Cette machine sera en mesure de résoudre en un temps record certains problèmes complexes aujourd’hui hors d’atteinte des ordinateurs classiques. Airbus ne s’y est pas trompé et va collaborer avec Quandela pour mettre au point de nouveaux matériaux plus résistants et plus légers, destinés aux avions du futur.

Si Quandela ambitionne la fusion des technologies quantiques et photoniques, ces deux approches restent néanmoins majoritairement distinctes et doivent être envisagées sur des échelles de temps différentes. Si des ordinateurs photoniques complets peuvent être envisagés assez rapidement, cela est beaucoup moins sûr pour des machines quantiques universelles, tant les obstacles techniques (matériels et logiciels) à surmonter restent grands. C’est pourquoi notre pays a raison de miser fortement sur les deux approches et de soutenir les recherches dans ces deux voies d’avenir. Une fois encore, ces ruptures technologiques, il faut le rappeler inlassablement, n’auraient pas été possibles sans une étroite et féconde coopération entre la recherche théorique très fondamentale et la recherche appliquée.

Mais, me direz-vous, à quoi va bien pouvoir servir cette puissance de calcul presque inimaginable que vont nous apporter les ordinateurs photoniques, dans un premier temps, puis les machines quantiques ? Et bien, à résoudre de manière plus efficace et plus rapide des problèmes absolument cruciaux pour l’avenir de l’humanité. Je pense en premier lieu à une meilleure connaissance du fonctionnement thermodynamique de la Terre, pour être plus efficace dans notre stratégie et nos actions visant à contrer le réchauffement climatique. Mais ce bond en avant dans la puissance de calcul disponible est également indispensable pour pouvoir enfin nourrir de manière saine et respectueuse de l’environnement tous les Humains, et concevoir plus rapidement les nombreuses molécules thérapeutiques, pour faire face aux immenses besoins médicaux qui s’annoncent, tant dans nos pays riches, avec leurs populations vieillissantes, que dans les pays en développement, encore confrontés à des épidémies régulières. Plus que jamais, nos sociétés vont avoir besoin de cette « puissance des nombres » dont parlait Aristote et qui nous permettra demain de relever les grands défis de notre siècle…

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

e-mail : tregouet@gmail.com

Noter cet article :

Vous serez certainement intéressé par ces articles :

Edito : La révolution biométrique est en marche...

La biométrie est aussi vieille que notre civilisation puisqu'à Babylone, il y a 5000 ans, les commerçants utilisaient déjà l'empreinte de leur pouce comme signature, pour authentifier leur identité. ...

La première téléportation quantique entre deux processeurs

Des chercheurs de l’Université d’Oxford ont démontré pour la première fois la faisabilité du calcul quantique distribué en utilisant une interface de réseau photonique. Ils sont parvenus à connecter ...

Les skyrmions pourraient décupler la vitesse des ordinateurs

Selon une étude du CNRS, les ordinateurs de demain pourraient aller 10 fois plus vite grâce aux skyrmions. Ces recherches menées par le scientifique Olivier Boulle montrent comment les skyrmions ...

Recommander cet article :

- Nombre de consultations : 0

- Publié dans : Informatique

- Partager :