TIC

- Information et Communication

- Informatique

Edito : L’IA (Intelligence Artificielle) ouvre la voie vers une nouvelle médecine

- Tweeter

-

-

1 avis :

Avant-Propos : Commentaires sur mon édito du 25 Décembre 2020 intitulé : « L’impression 3D va bouleverser la construction, la médecine…et l’alimentation »

Chères lectrices, Chers lecteurs,

Mr Jean Claude André, Directeur de Recherche émérite au CNRS et pionnier en 1984 avec deux amis de la fabrication additive, a eu l’obligeance de nous faire part de plusieurs réflexions et remarques pertinentes, concernant mon éditorial du 25 décembre 2020, intitulé « L’impression 3D va bouleverser la construction, la médecine…et l’alimentation ». Je tiens à remercier vivement ce chercheur, et fidèle lecteur de notre lettre, pour l’ensemble des précisions utiles et enrichissantes qu’il a bien voulu nous transmettre, et dont vous trouverez ci-dessous la synthèse.

Je profite de cette occasion pour rappeler que notre modeste lettre reste un outil de vulgarisation scientifique. Elle s’adresse d’abord à un large public, même si elle est lue par de nombreux scientifiques, elle n’a ni les moyens ni la prétention de rivaliser avec des revues ou publications scientifiques spécialisées. De la même manière, mes éditoriaux, qui abordent chaque semaine un sujet différent, n’ont pas vocation à l’exhaustivité et visent essentiellement à éclairer une mutation technologique en cours. Ils ne prétendent pas se substituer aux travaux et études scientifiques très complètes que chacun peut à présent consulter facilement sur Internet, s’il souhaite approfondir sa connaissance dans un domaine scientifique particulier (malgré des absences de filtrage et nombre de mélanges entre réalité et visions des possibles, voire de science-fiction).

Nous avons essayé, depuis la création de notre lettre en 1998, d’avoir constamment le souci de l’exactitude et l’exigence de la rigueur. Nous tenons beaucoup à conserver cette éthique d’honnêteté et de crédibilité intellectuelles. C’est pourquoi, lorsqu’il nous arrive, bien involontairement, de publier des informations inexactes, incomplètes ou contestables, je vous demande de ne pas hésiter à nous le signaler, afin que nous puissions opérer les rectifications nécessaires, et continuer ainsi à améliorer sans cesse notre contenu éditorial.

Vous remerciant à nouveau pour votre fidélité

Bien cordialement

René Trégouët

Fondateur et Directeur de la publication

=================

Synthèse de l’apport de Jean Claude André, Directeur de Recherche émérite au CNRS, à propos de mon éditorial « L’impression 3D va bouleverser la construction, la médecine…et l’alimentation »

J.C. André souligne dans un courrier des imprécisions quant au chiffre d’affaires du marché mondial de l’impression 3D. Après vérification, ce chiffre d’affaires atteindrait 10,4 milliards de dollars dans le monde en 2019, selon l’étude publiée par le Cabinet SmarTech Analysis (Voir SmarTech Analysis). Toujours selon les données de ce cabinet réputé, la France serait à la 4ème place mondiale sur ce marché, derrière l’Allemagne, les États-Unis et la Chine, avec un chiffre d’affaires de 489 millions d’euros en 2019.

J.C. André pointe ensuite notre définition trop imprécise et inexacte de la stéréolithographie. La stéréolithographie a été inventée dans le but de permettre aux ingénieurs de créer rapidement des pièces prototypes. Le 16 Juillet 1984, trois semaines avant que l’américain Chuck Hull ne dépose son brevet, les français Alain Le Mehaute, Olivier de Witte et Jean Claude André ont déposé un brevet sur le processus de la stéréo-photolithographie. A l’époque, la France n’a pas su exploiter l’idée et c’est aux USA que le devenir de la fabrication additive a démarré. Le terme “stereolithography” a été développé en 1986 par Charles W. Hull, qui définit alors cette technologie comme « une méthode de création d’objets en 3D en imprimant de façon successive de fines couches durcissantes par lumière ultraviolette ». Vous pouvez voir une présentation vidéo de ce procédé par Charles W. Hull lui-même, en regardant une vidéo sur le lien suivant : YouTube.

Il souligne ensuite que les techniques d’impression 3D ne sont pas toutes entièrement respectueuses de l’environnement. En effet, tout dépend des procédés utilisés et des produits fabriqués à l’aide de cette technologie. Sur cette question importante, les travaux du professeur Gutowski ont montré que les supports d’impression 3D ne peuvent pas toujours être retraités et recyclés. D’autres études montrent par ailleurs que l’impression 3D à la demande peut conduire à une augmentation du nombre de produits de consommation jetables. Enfin, certaines techniques d’impression 3D entraînent l’émission de composés organiques volatils (COV) qui peuvent s’avérer dangereux pour la santé dans des espaces de travail fermés ou mal ventilés. Il convient donc, comme le souligne Mr André, de bien évaluer, au cas par cas, l’impact réel des technologies d’impression additive sur l’environnement et la santé.

S’agissant de l’utilisation accrue de l’impression 3D dans le domaine de la construction et des travaux publics, Mr André souligne que cette technique se heurte encore à plusieurs limites qui en freinent la généralisation, telles que la résolution spatiale, l’obligation de travailler avec un unique matériau, ou encore les installations de fluides en 3D, et qu’il convient donc de bien évaluer la rentabilité réelle de l’impression 3D dans le bâtiment pour en envisager une utilisation étendue.

Mr André souligne également les limites actuelles liées à l’utilisation de l’impression 3D dans le domaine de la médecine réparatrice et des biotechnologies. Il remarque que cette technologie se limite pour l’instant à des tissus ou structures biologiques simples, peu innervés et à faible vascularisation, et qu’un important travail de recherche reste à accomplir pour parvenir, dans un futur sans doute encore relativement lointain, à « imprimer » des structures et organes entiers complexes et fonctionnels, composés d’un grand nombre de cellules de natures et de fonctionnalités différentes.

Dans le domaine alimentaire, Mr André rappelle que, si l’impression 3D peut être utilisée de manière ponctuelle dans le domaine spécifique de la grande cuisine, pour étendre les champs de la créativité culinaire, elle conserve pour l’instant des contraintes et des coûts d’utilisation qui freinent son utilisation à grande échelle dans le secteur agroalimentaire.

Il indique qu’il est important d’évoquer le rôle des Fab-Labs, dans le développement de l’impression additive. Le concept de Fab-Lab est né à la fin des années 90 à l'université américaine du MIT (Massachusetts Institute of Technology), sous la forme d'un cours intitulé « How to make (almost) everything », sous l'impulsion du professeur Neil Gershenfeld. Le terme de Fab-Lab, issu de la contraction de Fabrication Laboratory, laboratoire de fabrication en français, est un lieu ouvert au public mettant à la disposition de ce dernier un arsenal de machines et d’outils utilisés pour la conception et la réalisation d’objets de toutes sortes. On y apprend à réaliser soi-même des objets complexes. Il existerait aujourd’hui plus de 1 500 Fab-Lab dans le monde, dont environ 380 en France, selon le site spécialisé Markery. D’ailleurs, le coût d’acquisition d’une machine FDM (l’une des deux grandes technologies d’impression utilisant le dépôt de filaments fusibles) a considérablement baissé et on peut à présent trouver ce type de machines neuves à moins de 300 euros, et parfois moitié moins cher pour les machines d’occasion ou qu’on réalise soi-même….

J.C. André tient à juste titre à souligner l’importance de l’impression 4D, une nouvelle technologie née de l'union de la fabrication additive et des matériaux qualifiés d'« intelligents », c'est-à-dire dont la structure ou les propriétés fonctionnelles sont capables de réagir à des stimuli externes. Dans cette approche technologique novatrice et très récente, un objet imprimé en 3D peut voir sa structure changer de forme ou de fonctionnalité sous impulsion d'une énergie extérieure, d’origines thermique, chimique, lumineuse ou électromagnétique. Cette technologie a fait partie du projet lancé par le Self-assembly Lab du MIT et se développe en France au CNRS et à l’INRIA.

Il est enfin important de souligner que la France, qui a joué dès l’origine de cette nouvelle technologie de l’impression additive un rôle pionnier (et qui aurait pu disposer sur son territoire d’un réel leadership), grâce aux découvertes et avancées des chercheurs, continue aujourd’hui à rester l’un des pays les plus innovants dans ce domaine, comme le rappelle un récent article de l’excellente revue "3dnatives" (Voir 3DNatives). Selon l’article cité, l’Office européen des Brevets (OEB), dans son nouveau rapport intitulé “Brevets et fabrication additive – Tendances en matière de technologies d’impression 3D”, place notre pays dans le top 3 des pays européens les plus innovants en matière d’impression 3D ! La France serait le 3e pays européen demandeur de brevets en impression 3D, après l’Allemagne et le Royaume-Uni, preuve que la France et ses excellentes équipes de recherche publiques et privées continuent d’innover et d’avancer dans ce vaste champ technologique d’avenir. Dommage que les industries françaises ne suivent qu’imparfaitement cette dynamique…

EDITORIAL :

Cette semaine, je reviens sur un sujet qui n’a pas fini de transformer nos vies et qui va faire entrer la médecine et plus largement la santé –dans une nouvelle ère : l’arrivée massive de l’IA (intelligence artificielle) en médecine et en biologie.

En octobre dernier, des chercheurs du MIT ont présenté un nouvel outil de détection du coronavirus en programmant une IA capable de reconnaître une toux caractéristique d’un malade du Covid-19. Pour parvenir à ce résultat, ces scientifiques se sont appuyés sur l’analyse de 5000 enregistrements sonores de la toux de plusieurs centaines de volontaires, malades et asymptomatiques. (Voir EMB). Résultat : l’outil d’IA du MIT atteint une sensibilité de 98,5 % ainsi qu’une spécificité de 94,2 %. Les chercheurs sont à présent en train de développer une application gratuite pour smartphone, qui pourrait devenir un outil précieux, très simple d’utilisation et peu coûteux de dépistage du coronavirus.

Il y a quelques semaines, des médecins et chercheurs de Gustave Roussy, de l'Assistance Publique-Hôpitaux de Paris, de CentraleSupélec, de l’Université de Paris, de l’Université Paris-Saclay, de l’Inserm, de l’Inria et de TheraPanacea ont défini et modélisé les biomarqueurs prédictifs de l’évolution de la Covid-19. Cette IA est capable d’identifier les patients qui risquent de développer des formes graves et de nécessiter l’assistance d’une ventilation ; elle pourrait donc aider de manière précieuse les hôpitaux à prendre en charge en priorité les malades en fonction de la gravité de leur état. (Voir Science Direct).

Ces chercheurs ont entraîné l’IA en lui fournissant les images de scanner de 478 patients de cinq cohortes indépendantes qui avaient précédemment reçu un diagnostic de Covid-19 par test RT-PCR. Parmi ces dossiers, on comptait 110 cas graves dont 6 % sont décédés de la Covid-19 et 17 % ont été intubés. Utilisant conjointement des outils d’apprentissage profond (deep learning) et des réseaux neuronaux, les chercheurs ont appris à l’IA, en lui fournissant 20 000 coupes de scanner, à reconnaîitre les régions où la maladie était présente sur les images de scanner. L'algorithme conçu a permis de définir 10 biomarqueurs traduisant l’étendue et les caractéristiques cliniques de la maladie, notamment en matière d’atteintes pulmonaires, cardiaques ou neurologiques. La dernière étape de ces recherches a consisté à corréler ces biomarqueurs à l’âge et au sexe des patients, ainsi qu’aux informations cliniques, ce qui a permis à l’IA d’évaluer rapidement et précisément la sévérité de la maladie et de poser un pronostic à court terme pour les différents patients. Il devient alors possible de repérer ceux qui risquent de développer des symptômes sévères et de se retrouver en réanimation.

Mais si l’IA a déjà pris une place de choix dans la lutte et la prévention contre le coronavirus, cette révolution de l’intelligence médicale n’en est qu’à ses prémisses et ce sont bien les sciences de la vie dans leur ensemble qui sont en train d’être bouleversées par l’arrivée de ces nouveaux outils informatiques dont la puissance et la capacité prédictive semblent sans limites.

Un exemple récent est, à cet égard, tout à fait parlant, et l’on peut s’étonner qu’il n’ait pas eu plus d’écho dans les médias : il s’agit des performances extraordinaires que vient d’atteindre le programme AlphaFold, développé par DeepMind, la filiale de Google dédiée à l’intelligence artificielle (IA) (Voir Smithsonian Mag).

Les chercheurs de Google DeepMind sont en effet parvenus à utiliser un nouveau programme d’intelligence artificielle pour prédire la structure des protéines avec une rapidité et un niveau de précision inégalée. Cette prouesse a été réalisée dans le cadre de la compétition internationale d’algorithme ”Critical Assessment of Structure Prediction“, ou CASP, créée en 1994, qui consiste, pour chaque participant, à essayer de déterminer la forme 3D d’une protéine à partir de sa séquence ADN.

Le repliement des protéines obéit à des lois physiques et mathématiques précises. Mais, compte tenu du nombre d’acides aminés et de la grande variété des positions intermédiaires que peut prendre une molécule avant de se stabiliser, il s’avère très difficile, et parfois même impossible, de déterminer la structure exacte d’une protéine - dont les replis et enchevêtrements de chaînes moléculaires peuvent être très complexes - à partir de sa composition chimique. Pour y parvenir, les chercheurs doivent avoir recours à trois outils lourds, coûteux et imparfaits. Le premier, le plus ancien, est la cristallographie par rayons X, qui consiste à transformer une solution de protéines en un cristal puis à le bombarder avec des rayons X pour parvenir à visualiser sa structure interne grâce à la diffraction de ces rayons. Mais cette méthode nécessite plusieurs mois de travail et plus de 100 000 euros de dépenses pour déchiffrer la structure d’une seule protéine. Plus récemment, deux autres techniques expérimentales sont venues compléter la cristallographie par rayon X : la résonance magnétique nucléaire et la cryo-microscopie électronique. Mais ces outils manquent encore de précision pour pouvoir révéler la structure précise de toutes les protéines.

A partir d’une base de données rassemblant quelque 170 000 protéines, le logiciel de DeepMind, grâce à son nouvel algorithme, Alphfold2, a utilisé un réseau de neurones basé sur l’attention, capable de hiérarchiser le traitement des données en exploitant notamment sur les résultats d'autres séquences proches. Cette méthode a permis à AlphaFold 2 de calculer la structure de protéines complexes en seulement quelques jours. Mais le plus étonnant est que cette avancée majeure a été réalisée avec une puissance informatique relativement modeste, seulement 128 TPU (tensor processing units) réparties sur 16 puces dédiées.

Le 30 novembre 2020, les résultats d’AlphaFold ont dépassé les prévisions les plus optimistes des experts. Le professeur John Moult, co-fondateur des CASP en 1994, explique que « L'erreur moyenne du système est d'environ 1,6 angström, “soit à peu près la largeur d'un atome”. D’une certaine façon, je crois qu’on peut dire qu’avec ce nouvel outil de DeepMind, le problème vieux de plus d’un demi-siècle de la détermination de la structure de l’ensemble des protéines humaines est en passe d’être résolu… ».

Un seul exemple suffit à illustrer l’importance de cette rupture technologique : Andrei Lupas, un chercheur à l’Institut Max Planck, essayait depuis dix ans de déterminer la forme d’une protéine difficile à analyser. A sa grande stupéfaction, il a pu, à l’aide de ce logiciel AlphaFold, résoudre son problème en moins d’une heure…

L’intelligence artificielle AlphaFold 2 a également été utilisée pour prédire avec précision la structure de la protéine ORF3 présente dans le virus SARS-CoV-2 responsable de la maladie COVID-19. En outre, cet outil informatique va considérablement accélérer la création de protéines synthétiques, et ouvre la voie à une révolution comparable à celle de l’outil d’édition CRISP-Cas, dans le domaine de la recherche génétique.

Cette percée historique pourrait permettre d’identifier bien plus rapidement que prévu la structure de toutes les protéines du corps humain, un objectif tout aussi important que la cartographie complète du génome humain, si nous voulons pouvoir concevoir les médicaments ciblés qui permettront demain de traiter efficacement les nombreuses pathologies sans solutions thérapeutiques satisfaisantes. C’est en effet la structure spatiale des protéines qui détermine leurs fonctions dans l’organisme et permet de prédire leurs potentialités thérapeutiques. Rappelons que l’organisation mondiale HUPO (pour Human Proteome Organization) a lancé le projet Protéome humain (ou HPP pour Human Proteome Project), qui vise l’objectif ambitieux de décrire l’ensemble des protéines qui correspondent aux 19 800 gènes a priori "codants" du génome humain.

Cette avancée majeure que représente l’IA de DeepMind en matière de connaissance de la structure des protéines survient alors qu’il y a quelques semaines a été publiée la première carte "haute qualité" du protéome humain, précise à plus de 90 % (Voir Nature Communications). Le protéome humain regroupe la totalité des protéines produites dans notre organisme à partir de nos gènes. Il s’agit d’une entité à la fois plus vaste, plus complexe et plus évolutive que notre génome car un même gène peut commander la synthèse de nombreuses protéines différentes (parfois plus de 1000). On estime aujourd’hui qu’il y aurait au moins un million de protéines humaines distinctes, si l'on prend en compte toutes les modifications qui peuvent intervenir au niveau d'une même protéine. Mais il se pourrait que ce nombre soit bien plus élevé, car aux protéines classiques, qui sont des macromolécules, il faut ajouter les nombreuses « micro-protéines », découvertes il y a seulement 30 ans et qui ont longtemps échappé aux outils d’analyse génomique, en raison de leur taille minuscule.

Mais il est un autre domaine qui est en train d’être révolutionné par les nouveaux outils d’IA, c’est celui des thérapies anticancéreuses. Face à la grande variété de cancers et à des tumeurs qui présentent souvent une grande hétérogénéité génétique et moléculaire, la médecine dispose aujourd’hui de centaines de molécules anti-cancéreuses, plus ou moins actives, en fonction du type de cancer, de son évolution et du profil génétique du malade. Il est devenu impossible pour un cancérologue, quelles que soient ses compétences, de connaître le meilleur choix de tous les médicaments possibles pour traiter un patient particulier.

Face à ce défi médical, une équipe finlandaise, composée de chercheurs des Universités d’Aalto d'Helsinki et de Turku, a conçu une IA qui permet de prédire quelles combinaisons de médicaments vont tuer les cellules cancéreuses chez un patient donné. Ces chercheurs ont développé un modèle d'apprentissage automatique qui prédit avec précision comment les combinaisons de différents médicaments anticancéreux tuent les différents types de cellules cancéreuses. « Nourri » par une immense quantité de données issues d'études précédentes, ce modèle utilise une fonction polynomiale « classique mais très complexe, qui lui permet d’identifier les meilleurs combinaisons cellulles-molécules », précise l’auteur principal, le professeur Juho Rousu de l'Université Aalto.

Ce nouvel outil a montré qu’il pouvait prédire avec précision comment une combinaison de médicaments inhibe sélectivement des cellules cancéreuses spécifiques via l'effet synergique de la combinaison, y compris dans les nombreux cas où la combinaison proposée sur ce type de cancer n'a jamais été testée. Ce nouvel outil qui devrait rapidement équiper tous les grands établissements hospitaliers, va aider de manière précieuse médecins et chercheurs pour prendre, dans tous les cas de figure, les meilleures options thérapeutiques pour chaque malade, parmi la multitude de combinaisons possibles. Mais cet outil va aussi trouver des applications bien au-delà de la cancérologie en proposant, par exemple, de nouvelles combinaisons d'antibiotiques pour lutter contre des infections bactériennes résistantes.

Autre exemple de cette percée fulgurante de l’IA en médecine : Google et l'Institut Curie, centre de lutte contre le cancer, viennent d'annoncer leur collaboration autour de la création de systèmes d'apprentissage automatique pour les thérapies ciblées dans le cadre d'un programme de recherche sur le traitement du cancer. Ces chercheurs, sous la direction de Jean-Philippe Vert, vont travailler sur l'hétérogénéité des tumeurs, facteur déterminant de la réponse et de la résistance au traitement du cancer. Le but est de concevoir un outil d’IA qui puisse analyser les données épigénomiques, relatives à l'ensemble des modifications épigénétiques d'une cellule pouvant être transmises lors des divisions cellulaires, et de recouper ces données avec l'ensemble des ARN présents dans une cellule à instant donné. Lorsque l’IA aura appris à prédire l’évolution particulière de ce processus pour chaque malade, les chercheurs pourront alors anticiper la résistance au traitement et adapter en permanence leur stratégie thérapeutique, en modifiant les combinaisons de médicaments constituant le traitement.

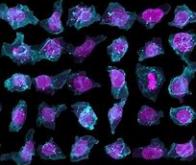

Récemment, des chercheurs américains, dirigés par Rajov Dhir, pathologiste à l’Université de Pittsburgh (UPMC), ont également présenté un nouvel outil d’IA d’une efficacité sans égal pour repérer les cancers de la prostate, le cancer le plus fréquent chez l’homme. Pour apprendre à l’IA à identifier le cancer de la prostate, Dhir et ses collègues lui ont fourni des images de plus d’un million de prélèvements de tissus colorés provenant de biopsies. Chaque image a été indexée par des pathologistes expérimentés, afin que l’IA apprenne à distinguer les tissus sains des tissus malins. L’algorithme a ensuite été testé sur un ensemble de 1 600 images de prélèvements provenant de 100 patients ayant été examinés au centre médical de l’UPMC, dans le cadre d’une suspicion de cancer de la prostate. A l’issue de ces premiers essais, cette IA a atteint le niveau remarquable de 98 % pour la sensibilité et de 97 % pour la sélectivité dans la détection de ce cancer de la prostate, qui représente pratiquement un quart de tous les cancers masculins (50 000 cas par an en France).

Enfin, il y a quelques mois, une équipe, composée de chercheurs du Collège impérial de Londres et du service national de santé de Grande-Bretagne, a présenté un remarquable outil qui peut identifier les cancers du sein, à partir de milliers de mammographies. Les prévisions ont ensuite été comparées aux résultats d'un ensemble de 25.856 mammographies réalisées au Royaume-Uni et 3.097 aux Etats-Unis. Ce système d'intelligence artificielle s’est montré capable d'identifier les cancers avec un degré de précision similaire à celui des radiologues experts, tout en réduisant le nombre de faux positifs de 5,7 % dans le groupe américain et de 1,2 % dans le groupe britannique. « Nos résultats montrent que cet outil d’IA a le potentiel de « dépasser la capacité humaine à identifier des signaux subtils que l'œil et le cerveau humains ne sont pas en mesure de percevoir », souligne Connie Lehman, chef du service d'imagerie mammaire de l'hôpital général du Massachusetts.

Toutes ces avancées et découvertes récentes confirment le rôle désormais irremplaçable et moteur que joue l’IA en matière de recherche médicale et de soins, qu’il s’agisse de la conception rapide d'un nouveau médicament ciblé, de la connaissance exhaustive de notre protéome, de la recherche de mutations génétiques individuelles, ou encore de combinaisons thérapeutiques optimales et personnalisées. Au rythme actuel de développement, les systèmes d’assistances numériques médicales utilisant l’IA seront présents partout dans moins de 5 ans, y compris dans les cabinets médicaux de nos généralistes.

Mais ces nouveaux algorithmes et outils d’IA n’exprimeront toutes leurs potentialités qu’en s’appuyant sur des calculateurs toujours plus rapides et plus puissants et dans le cadre de réseaux de communication à très haut débit sur l’ensemble du territoire, ce qui suppose notamment d’accélérer le plan d’accès à la fibre optique dans les zones les plus reculées et de déployer rapidement le nouveau réseau 5G, pour les échanges à très haut débit, via l’internet mobile. C’est pour répondre à ce défi scientifique majeur que la Commission européenne vient de proposer, il y a quelques jours, de débloquer 10 milliards d’euros sur les cinq prochaines années, pour accélérer l’arrivée de la nouvelle génération de superordinateurs « exaflopiques » (capables de calculer à la vitesse vertigineuse d’un milliard de milliards d’instructions par seconde) et favoriser l’innovation dans le domaine tout aussi capital des logiciels d’IA. Et le moins que l’on puisse dire est que cet effort exceptionnel est le bienvenu : aujourd’hui près de la moitié des 500 plus puissants ordinateurs du monde sont chinois et la Chine a dépensé en 2019 2 % de son PIB pour la recherche, soit 256 milliards de dollars (sans compter les dépenses de recherche militaire, non déclarées, mais très importantes), contre 282 milliards pour l’Europe et 397 milliards pour les USA.

Le géant chinois devrait doubler cette année l’UE en nombre de chercheurs (1,7 million) et devenir le pays au monde qui compte le plus grand nombre de scientifiques et d’ingénieurs. Autre indicateur révélateur, la Chine dépasse depuis deux ans les USA en termes de publications scientifiques. Mais l’Empire du Milieu ne compte pas s’arrêter là et devrait devenir la première économie mondiale en 2030, affirme la Banque Mondiale, avec un PIB qui atteindrait 26 000 milliards de dollars à cet horizon. Elle pourrait alors consacrer 700 milliards de dollars par an à la recherche, soit autant que les dépenses de recherche cumulées actuelles de l’Europe et des Etats-Unis…

Si nous voulons que notre pays et notre continent restent dans cette course scientifique vitale pour notre avenir, notre prospérité et notre qualité de vie, nous devons plus que jamais redoubler d’efforts pour permettre à notre recherche de rester à la pointe dans ce domaine de l’intelligence artificielle et des supercalculateurs, mais aussi, face à la déferlante asiatique, pour assurer en France et en Europe la formation en nombre suffisant des millions de chercheurs et d’ingénieurs qui feront demain la richesse de nos sociétés et nous permettront de conserver notre souveraineté et notre puissance politique.

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

e-mail : tregouet@gmail.com

Noter cet article :

Vous serez certainement intéressé par ces articles :

Edito : La révolution biométrique est en marche...

La biométrie est aussi vieille que notre civilisation puisqu'à Babylone, il y a 5000 ans, les commerçants utilisaient déjà l'empreinte de leur pouce comme signature, pour authentifier leur identité. ...

L'ordinateur quantique franchit la barre des 1000 qbits

Les chercheurs de la TU Darmstadt ont franchi une nouvelle étape vers un ordinateur quantique opérationnel en atteignant le seuil des 1000 qbits. Les processeurs quantiques basés sur des réseaux ...

Microsoft annonce une étape décisive vers l'ordinateur quantique

Microsoft a annoncé avoir conçu les qubits logiques les plus fiables jamais enregistrés. Une avancée technologique réalisée en collaboration avec Quantinuum, société créée en 2021 de la fusion entre ...

Recommander cet article :

- Nombre de consultations : 0

- Publié dans : Informatique

- Partager :