|

|

Edito

Les robots militaires vont-ils devenir autonomes ?

En moins de 10 ans, les robots sont devenus des auxiliaires militaires majeurs et irremplaçables. Dans tous les conflits et théâtres d’opérations de ces dernières années, ils ont joué un rôle d’intervention tactique et stratégique incontournable et de plus en plus efficace.

Selon l’université de Washington, en 2020 un tiers des forces armées américaines seront constituées de robots. Rien qu’en Irak et en Afghanistan, on estime que l’armée américaine a déployé plus de 6000 robots. Pour des raisons bien compréhensibles, les militaires communiquent peu sur la présence de ces soldats d’un nouveau genre. Parmi ces derniers, on peut notamment citer le « iRobot Packbot 510 », un robot autonome équipé de capteurs qui lui permettent de détecter et d’éviter les obstacles et d’évoluer dans un environnement complexe.

Ce robot, qui se décline en une dizaine de versions, est devenu un assistant précieux pour les fantassins exposés à des conflits non conventionnels de type guérilla ou insurrection. Il peut non seulement détecter et éliminer les engins explosifs mais également détecter la provenance de tirs ennemis, une qualité très appréciée quand les fantassins doivent évoluer en milieu urbain et sont exposés aux Snipers.

Autre machine étonnante, le SnakeBot, un robot serpent autonome conçu pour espionner l’ennemi. Chaque section de ce robot est autonome et possède sa propre capacité d’autonomie et d’action. Ce robot, même en partie détruit peut s’auto réparer et il est capable de progresser dans pratiquement n’importe quel type d’environnement, soit pour observer l’ennemi soit pour l’attaquer avec des charges explosives.

Un autre type de robot militaire promis à un grand avenir est l’exosquelette qui permet de démultiplier la vitesse, la puissance et la précision des fantassins sur le champ de bataille. Le robot XOS2, présenté il y a deux ans, appartient cette catégorie. Il ne pèse que 10 kg et permet à un soldat de manœuvrer des charges de près de 100 kg !

Il faut également évoquer le projet « BigDog » de robot-mule, destiné au transport d’équipement militaire. Cet étonnant robot se pilote par commande vocale (Voir article) et, après 10 ans de recherche, il peut à présent porter jusqu’à 180 kg d’équipement durant 32 km en 24 heures.

Enfin, la DARPA (le département de recherche de l’armée américaine), a présenté, en octobre 2012, le Pet-Proto, un robot humanoïde « capable de prendre certaines décisions de manière autonome en fonction du contexte » (Voir article).

L’US Air Force travaille également sur des « Micros-Engins Aériens » (MAV), pas plus gros que des insectes et pouvant être utilisés en milieu urbain et même à l’intérieur des bâtiments. Ces microrobots seront d’abord destinés à la reconnaissance à l’observation mais il est tout à fait imaginable qu’ils puissent attaquer l’ennemi, soit en utilisant une micro-charge explosive, soit en lui injectant un poisson.

Mais avant que les robots ne s’imposent aux côtés ou à la place des combattants sur le champ de bataille, on oublie souvent qu’ils sont déjà depuis quelques années omniprésents sur tous les théâtres d’opérations militaires, sous la forme de drones.

Dans tous les conflits non conventionnels qui se déroulent actuellement et qui sont de type asymétrique (c’est-à-dire opposant des armées régulières à des organisations et groupes terroristes et mafieux) les drones, qu’il s’agisse des versions d’observation ou des versions de combat, sont devenus des acteurs irremplaçables.

Que ce soit en Afghanistan, au Moyen-Orient ou plus récemment au Mali, les drones militaires ont joué un rôle déterminant dans le repérage et l’élimination des groupes terroristes. Ces « robots volants » ont complètement modifié la donne stratégique et tactique en à peine 10 ans.

Ils ont notamment permis l’élimination sélective des principaux dirigeants des groupes terroristes qui s’étaient réfugiés dans des régions inaccessibles où des interventions terrestres auraient été très complexes à mettre en œuvre et surtout très coûteuses en vies humaines.

Il y a quelques semaines, le Sénateur américain Lindsey Graham estimait que les Etats-Unis avaient tué depuis 5 ans au moins 4 700 personnes en utilisant ces drones de combat. Un chiffre résume bien la montée en puissance impressionnante de l’utilisation de ces drones sur les théâtres d’opérations militaires : en moins de 10 ans, la fréquence des frappes de drones américains est passée, en moyenne, d’une tous les 40 jours à une tous les trois jours !

Autre indicateur éclairant : l’armée américaine possédait moins d’une centaine de drones il y a 10 ans ; elle en alignerait à présent plus de 8000 et pourrait en posséder 20 000 en 2020. L'armée de l'air américaine a d’ailleurs annoncé qu’elle formait à présent plus d'opérateurs de drones qu'elle n'entraîne de pilotes pour ses avions de chasse.

Mais l’utilisation de ces systèmes d’armes redoutables ne va pas sans soulever de nombreuses questions juridiques morales et éthiques et commence à susciter un large débat aux Etats-Unis. Officiellement chaque attaque de drones fait l’objet d’une évaluation militaire et juridique précise et doit obtenir l’approbation personnelle du Président américain.

Mais le problème est qu’il y a souvent loin entre la mission parfaite programmée par ordinateur et visualisée sur un écran vidéo et les réalités des dommages constatés sur le terrain. Les drones peuvent rarement procéder à une identification visuelle directe des « cibles » à éliminer. Il n’est donc pas rare que des frappes de drones soient décidées sans que l’on puisse être absolument certain qu’elles vont bien tuer les chefs terroristes visés.

Par ailleurs, même quand une frappe de drones élimine un responsable terroriste, il est malheureusement inévitable et assez fréquent qu’elle entraîne également la mort de plusieurs dizaines de personnes innocentes qui vivaient dans l’environnement immédiat de cette «cible».

Cette question des dommages collatéraux causés par les attaques de drones a d’ailleurs pris depuis quelques mois une importance politique considérable car les états concernés, notamment le Pakistan, ont bien compris que ces frappes meurtrières, même si elles sont d’une efficacité indiscutable, exaspèrent les populations locales et alimentent un puissant sentiment antiaméricain et anti-occidental.

En outre il faut rappeler que sur un plan juridique et légal, l’utilisation des drones échappe pour l’instant aux cadres prévus par les conventions internationales en matière de guerre.

Or l’arrivée d’une prochaine génération de drones dotés d’une capacité d’autonomie, d’évaluation de la situation et de prise de décision bien plus grande, va rendre indispensable un vrai débat démocratique et moral sur les conditions d’utilisation de ces systèmes robotisés de destruction.

Actuellement, l’armée britannique expérimente un nouveau drone révolutionnaire, baptisé Taranis, en référence au dieu du tonnerre. Cet engin redoutable qui vole à plus de Mach 1, est de type furtif ; il est donc très difficilement détectable par radar. Il possède un très grand rayon d’action et une puissance de feu considérable mais surtout il est doté d’une autonomie de décision nouvelle.

À terme, Taranis sera en effet capable de suivre une trajectoire définie à l’aide des ordinateurs de bord pour atteindre sa cible mais il pourra également modifier si besoin la trajectoire initialement programmée pour s’adapter à une menace ou un changement imprévu dans son environnement. C’est seulement au stade ultime, lorsqu’il sera en mesure d’exécuter sa frappe, qu’il aura besoin d’une autorisation humaine pour déclencher son tir.

Cette nouvelle génération d’engins volants automatisés pose des problèmes légaux et moraux encore plus complexes que les appareils actuels. Le professeur Noel Sharkey, ingénieur en robotique et spécialiste des systèmes militaires autonomes à l'Université de Sheffield, souligne à ce propos que « Avec ce nouveau type d’engins volants automatisés nous faisons un saut dans l’inconnu car nous ne savons pas du tout comment les gouvernements qui vont disposer d’une telle technologie vont l’utiliser. »

Mais les Britanniques ne sont pas les seuls à développer ces nouveaux drones autonomes. L'armée américaine expérimente également son "X-47B" un drone furtif, capable, comme le Taranis, d’effectuer des missions préprogrammées en utilisant une forme d’intelligence artificielle. Ce drone d’une capacité d’emport de plus de 2 tonnes et bardé d’informatique et de capteurs, utilise des programmes sophistiqués d’intelligence artificielle. Il est capable d’apponter en toute circonstance sur un porte-avions et posséderait une autonomie et un rayon d’action considérables. De l'avis des observateurs, sa "dextérité" de pilotage serait, en toutes circonstances, supérieure à celle des pilotes les plus habiles !

En Europe, plusieurs pays dont la France se sont associés au sein du projet « Neuron » pour développer également un drone furtif et intelligent qui vient d’accomplir ses premiers vols d’essai il y a quelques mois.

Face à cette évolution technologique rapide, l’influente association Human Rights Watch a publié un rapport préconisant que des restrictions d’utilisation soient imposées à ces « robots tueurs», comme les appelle de manière flatteuse cette organisation.

Bien entendu, les responsables militaires américains ou européens ne manquent pas de souligner qu’ils ne permettront jamais à des machines de prendre la décision finale de tuer. Le problème, c’est qu’une fois qu’une technologie est disponible, il est très difficile de ne pas en exploiter toutes les potentialités.

La presse anglaise ou américaine évoque également la possibilité que de tels engins robotisés tombent entre les mains de tyrans ou de dictateurs qui pourraient, sans aucun état d’âme, les utiliser à des fins de répression interne et d’élimination de leurs opposants politiques ou de groupes ethniques particuliers.

Autre point qui ne manque pas de soulever des inquiétudes : la vulnérabilité informatique de ces systèmes robotisés. En 2011, un drone Predator a ainsi brusquement modifié son comportement après avoir été infecté par un bug informatique. Heureusement, dans ce cas précis il n’y a pas eu de conséquences graves. On imagine cependant qu’un tel incident survenant sur un drone lourdement armé et sur le point d’exécuter sa frappe, pourrait avoir des conséquences désastreuses.

Il est certain qu’avec l’arrivée prochaine de systèmes militaires robotisés terrestres et aériens utilisant massivement l’intelligence artificielle et possédant une réelle capacité d’autonomie de décision, la question de la responsabilité morale, politique et financière des dommages causés par ces engins va devenir cruciale.

Comme le souligne une analyse publiée par la presse américaine, le pire n’est jamais sûr mais l’évolution de la technologie conjuguée aux nouveaux types de conflits et de menaces qui déchirent la planète, feront qu’il sera très difficile pour les pouvoirs politiques de ne pas utiliser de manière croissante ces robots militaires autonomes.

Cette tentation sera d’autant plus grande qu’on voit bien que les opinions publiques acceptent de moins en moins l’idée de pertes militaires humaines importantes, quels que soient les enjeux invoqués. En outre, en ces temps de contraintes budgétaires et de crise financière, les armées devront faire plus et mieux avec de moins en moins d’argent et dans un tel contexte, les robots militaires autonomes représentent évidemment une solution irrésistible.

Certains analystes soulignent enfin, non sans raison, qu’aujourd’hui, l’idée qu’une machine puisse faire preuve d’une forme d’intelligence, d’une capacité de libre arbitre d’un sens moral paraît saugrenue voire absurde. Mais qu’en sera-t-il dans 20 ou 30 ans quand ces robots disposeront d’une puissance de calcul et d’une capacité d’analyse et d’évaluation que nous pouvons à peine imaginer à présent ?

Confrontés à cette évolution vertigineuse de la technologie, la question n’est plus de savoir si un jour une machine sera considérée comme intelligente et responsable de ses actes mais, dans le cas qui nous occupe, à quel moment un robot militaire sera pour la première fois considéré comme moralement et légalement responsable des dommages qu’il aura infligés…

Le grand écrivain de science-fiction et visionnaire Isaac Asimov, avait imaginé il y a plus de 70 ans des robots intelligents, pouvant faire preuve d'un comportement imprévisible. Il avait également formulé les trois fameuses lois de la robotique qui devaient donner aux robots un sens moral. Dans l'une de ses nouvelles, des magistrats sont amenés à s'interroger pour savoir si un robot peut être jugé comme un être humain et ils décident de répondre oui à cette question après s'être aperçus que le robot leur avait menti et avait donc adopté un comportement proprement humain.

Espérons que les redoutables robots militaires qui déchaîneront leur puissance de feu sur les champs de bataille du futur auront également une parcelle d'humanité !

René TRÉGOUËT

Sénateur Honoraire

Fondateur du Groupe de Prospective du Sénat

Références presse :

Slate

Atlantic

Next gov

BI

Daily Mail

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

L’entreprise japonaise Fujitsu vient de présenter un mobile capable de mesurer le pouls de son utilisateur en analysant les variations de brillance du visage provoquées par le flux sanguin.

Il suffit de pointer ce smartphone vers un visage pendant quelques secondes, pour mesurer également le taux d’hémoglobine, en exploitant la propriété de cette protéine d’absorber la lumière verte.

L'algorithme développé par Fujitsu a été conçu pour pouvoir filtrer les différents facteurs parasites et permet un calcul précis du rythme cardiaque. En outre, ce dispositif peut très bien être intégré à de multiples appareils : téléviseurs, caméra, ordinateur…

"Les applications de ce système sont multiples, non seulement en matière de santé mais également dans le domaine de la sécurité ou de la veille sanitaire, par exemple pour aider à identifier de personnes malades dans un lieu public", précise Fujitsu .

La firme japonaise prévoit de commercialiser son invention en 2014 et confirme ainsi ses ambitions sur le marché en plein développement de la biométrie, des technologies de reconnaissance et de la télémédecine.

Article rédigé par Georges Simmonds pour RT Flash

Fujitsu

|

|

|

|

|

|

|

|

|

Des chercheurs d'AT&T ont mis au point un nouveau mode de gestion du spectre électromagnétique qui permet, pour la première fois, un débit stable de 400 Gb/seconde sur des réseaux optiques à longue distance.

Dans ce système, Nyquist, une meilleure efficacité spectrale a pu être obtenue en utilisant un nouveau mode de multiplexage des fréquences par répartition et une technique de modulation à faible perte. Ces avancées ont permis de transmettre des signaux à 400 Gbits/seconde, sur une distance-record de 12 000 km.

"Ce résultat ne représente pas seulement une augmentation de la portée d'un facteur de 2,5 pour 100 GHz, il établit également un nouveau record en matière d'efficacité spectrale et de distance", explique Xiang Zhou qui dirige ces recherches.

"Par rapport aux techniques de modulation utilisées actuellement, notre méthode a la capacité unique de permettre le réglage de l'efficacité de la modulation spectrale pour correspondre à la largeur de bande disponible et maximiser la portée de transmission, tout en conservant la tolérance aux non-linéarités des fibres et au bruit de phase laser, qui sont les principaux facteurs limitant la performance des transmissions sur fibres optiques", ajoute Xiang Zhou.

Article rédigé par Georges Simmonds pour RT Flash

OFCNFOEC

|

|

|

|

|

|

|

|

|

Une équipe de chercheurs d'IBM, en collaboration avec l'Agence de Recherche de l'Armée américaine (DARPA), a mis au point un mode de transmission optique de données informatiques d'une efficacité et d'une sobriété énergétiques sans précédent. L'équipe a présenté son prototype optique, qui pulvérise le record, à l'occasion de la Conférence sur les communication par fibre optique d'Anaheim en Californie.

En combinant des puces de type SOI-CMOS, gravées en 32 nanomètres de silicium et les photodétecteurs fabriqués par Sumitomo Electric périphérique Innovations USA, ces chercheurs ont drastiquement abaissé à seulement 24 milliwatt, la consommation d'énergie nécessaire au fonctionnement d'un nœud de communication optique à 25 gigabits par seconde.

"Par rapport à nos précédents travaux, nous avons augmenté la vitesse de transmission optique de 66 %, tout en réduisant la consommation de moitié", souligne Jonathan E. Proesel qui dirige ces recherches. Celui-ci ajoute que "Face à l'augmentation exponentielle de la quantité de données numériques à traiter, nous devons absolument parvenir à augmenter le débit de transmission, tout en diminuant la consommation d'énergie".

Cette avancée sera exploitée dans les futurs ordinateurs exaflopiques, attendus vers 2018. Ces machines surpuissantes travailleront à la vitesse prodigieuse d'un milliard de milliard d'opérations à la seconde et pourront, dans un temps raisonnable, simuler l'évolution de modèles d'une extrême complexité, comme certains modèles climatiques ou biologiques. Mais de telles machines supposent des ruptures technologiques en matière de communication interne entre composants, de mémoire, de refroidissement et de consommation.

Article rédigé par Georges Simmonds pour RT Flash

Eurekalert

|

|

| ^ Haut |

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Des chercheurs de l'Université de Stanford ont mis au point une nouvelle technique très prometteuse qui consiste à injecter aux patients les cellules-souches encapsulées dans les nanoparticules de silice, ce qui permet de déterminer l'efficacité des traitements grâce à un suivi très précis du trajet de ces cellules dans l'organisme.

Ces cellules-souches, ainsi vectorisées par les nanoparticules, deviennent visibles par imagerie à ultrasons et les médecins disposent ainsi d'un moyen très fiable et très précis de suivre ces cellules dans le corps des malades pour s'assurer qu'elles atteignent bien leur but, ce qui pour l'instant était très difficile à vérifier, faute d'une méthode adéquate.

"Si nous voulons pouvoir utiliser largement les cellules-souches pour réparer et reconstruire des tissus endommagés ou malades, nous allons avoir besoin de savoir exactement où vont ces cellules pour pouvoir optimiser ces thérapies cellulaires" explique Lara Bogart, chercheuse à l'université de Liverpool.

Pour permettre une parfaite traçabilité de ces cellules après leur injection, les chercheurs ont utilisé des nanoparticules de silice, un matériau qui réfléchit les ondes sonores, ce qui lui permet d'être détecté par échographie.

Ces nanoparticules ont été couplées avec des cellules-souches mésenchymateuses, qui peuvent se différencier en de nombreux types de cellules, dont les cellules osseuses, les cellules graisseuses et les cellules cardiaques.

Des essais réalisés chez la souris ont confirmé que ce binôme cellules-souches – nanoparticules permettait de suivre avec une précision inégalée le trajet de ces cellules et leur efficacité thérapeutique.

Ces nanoparticules de silice peuvent également être détectées par IRM car elles contiennent un métal fortement magnétique, le gadolinium. Elles peuvent également être détectées par les méthodes optiques car elles sont colorées à l'aide d'un fluorescent. "Nous disposons donc de trois moyens complémentaires de suivre ces nanoparticules", précise le docteur Bogart qui ajoute : "En fonction de l'organe visé par la transplantation de cellules, nous pourrons ainsi choisir la méthode la plus appropriée pour vérifier les effets de ses thérapies cellulaires".

Article rédigé par Georges Simmonds pour RT Flash

MIT Technology Review

|

|

|

|

|

|

|

|

|

Selon une étude publiée dans les actes de l'Académie américaine des sciences, commandée par l'Institut national de la santé américain, des médicaments d'une taille 100 000 fois plus petite que le diamètre d'un cheveu humain auraient la capacité de prévenir les lésions tissulaires associées à l'athérosclérose et d'autres maladies chroniques chez la souris.

Cette étude réalisée par Zahi Fayad, au centre médical du mont Sinaï Mont Sinaï, rappelle que l'inflammation est un mécanisme de défense naturelle contre les organismes envahisseurs et les lésions tissulaires. Beaucoup de chercheurs pensent à présent que les maladies chroniques, comme les maladies cardiaques ou le diabète, sont liées à une réponse immunitaire prolongée entraînant une inflammation chronique des tissus.

"De nombreuses études ont montré que l'inflammation est à la base de nombreuses maladies chroniques et nous avons besoin de thérapies qui aident à réparer les dommages provoqués par cette inflammation chronique", souligne le professeur Fayad qui ajoute : "La nanomédecine va nous permettre de traiter et de prévenir nombre de pathologies chroniques graves d'une manière bien plus efficace qu'actuellement et sans les effets secondaires liés aux médicaments classiques."

Les chercheurs américains associés à ces recherches ont développé une molécule « à trois étages ». La première composante contrôle la libération du médicament dans les tissus enflammés, la seconde contrôle son temps d'action et la dernière dirige ce médicament vers la bonne cible, par exemple les tissus endommagés dans la paroi vasculaire.

Les essais sur la souris ont montré l'efficacité de cette nanothérapie ciblée et les chercheurs sont persuadés que ce type de nanomédicaments, déjà porteurs de grands espoirs en cancérologie, a également un grand avenir thérapeutique dans le traitement de nombreuses pathologies cardio-vasculaires et notamment l'athérosclérose.

Article rédigé par Georges Simmonds pour RT Flash

Newswise

|

|

|

|

|

|

|

|

|

Une équipe de l'Université de Saskatchewan, au Canada, vient de développer des matériaux bio polymères ayant des propriétés améliorées d'absorption. Connus dans le monde scientifique sous le nom de "matériaux intelligents", ces bio polymères de synthèse montrent un potentiel très important dans des applications variées, en particulier dans le domaine de l'assainissement de l'eau.

"Alors que le pétrole par exemple est relativement facile à séparer de l'eau, des polluants solubles tels que les colorants, les nitrates et les détergents le sont beaucoup plus difficilement" souligne Lee Wilson, l'un des superviseurs de l'étude. Les matériaux développés par ces chercheurs ont montré des capacités d'absorption remarquables des contaminants solubles.

"Nous allons manquer d'eau douce, la seule question est de savoir quand ?", souligne Lee Wilson, qui ajoute : "La possibilité de désaliniser l'eau en utilisant très peu d'énergie est devenue un enjeu scientifique, économique et humain majeur qui conditionne la question de l'accès à une eau de qualité dans le monde entier".

Dans cette perspective, les matériaux intelligents, tels que ceux développés par ces chercheurs sont particulièrement intéressants par leur capacité à "s'activer" ou "s'éteindre" en réponse à une modification de paramètre physique ou chimique, tel qu'un changement de température ou de PH. Alors que les autres méthodes de filtrations telles que l'osmose inverse nécessitent beaucoup d'énergie pour fonctionner, ce n'est pas le cas pour ce ce type de matériaux qui pourraient dépolluer à faible coût énergétique et économique l'eau contaminée, y compris dans les cas de pollution à l'arsenic que l'on retrouve dans plusieurs pays pauvres et qui posent de redoutables problèmes de santé publique.

Article rédigé par Gaël Orbois pour RT Flash

University of Saskatchewan

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Le CERN a officiellement confirmé il y a quelques jours, à l'occasion des rencontres de Moriond, que la nouvelle particule identifiée et présentée en juillet dernier avait de très fortes chances d'être le fameux boson de Higgs, le « chaînon manquant » du modèle standard de la physique indispensable pour expliquer la masse des 6 quarks et des 6 leptons, principaux constituants de la matière.

Les physiciens qui disposent à présent d'une masse de données considérable ont pu vérifier que les propriétés quantiques de cette nouvelle particule correspondent bien à celles du modèle théorique initial. La probabilité que cette particule soit bien le boson de Higgs a été évaluée à 93 %.

Les chercheurs ont néanmoins souligné pendant ce colloque qu'ils ne savaient pas encore à quelle famille appartenait le boson découvert. Il est en effet encore trop tôt pour savoir si la particule identifiée est bien le boson de Higgs du Modèle standard, ou un autre type de boson plus exotique.

"Répondre à cette question ne sera pas facile et prendra du temps", précise le CERN. Rappelons que l'existence de ce boson a été postulée il y a presque un demi-siècle par le physicien britannique Peter Higgs et ses collègues belges et français, Robert Brout et François Englert.

Article rédigé par Gaël Orbois pour RT Flash

CERN

The New York Times

|

|

|

|

|

|

|

|

|

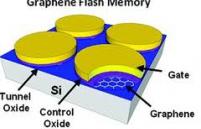

Des chercheurs de l'école polytechnique fédérale de Lausanne ont mis au point un nouveau type de mémoire flash très performante qui combine deux matériaux ayant des propriétés électroniques remarquables : le graphène et de molybdénite.

Il y a deux ans, la même équipe de recherche avait montré les propriétés électroniques prometteuses de la molybdénite (MoS2), un minerai abondant dans la nature. Ces chercheurs avaient également démontré la faisabilité d'une puce en molybdénite. Aujourd'hui, ils sont allés encore plus loin en développant un prototype de mémoire flash (un type de mémoire qui peut non seulement stocker des données, mais aussi les maintenir en l'absence d'électricité) qui combine les propriétés du graphène et de la molybdènite.

La molybdénite et le graphène ont beaucoup de choses en commun. Ces deux matériaux devraient permettre de dépasser les limites physiques des puces et transistors actuels. Leur structure chimique à deux dimensions et le fait qu'ils soient constitué d'une seule couche d'atome leur confèrent un énorme potentiel pour poursuivre la course à la miniaturisation électronique.

Bien que le graphène soit meilleur conducteur, la molybdénite possède pour sa part de remarquables propriétés semi conductrices. Celles-ci lui permettent de basculer très rapidement d'un État ouvert à un état fermé en consommant très peu d'énergie. Utilisés conjointement, les deux matériaux peuvent ainsi combiner leurs avantages uniques.

Le prototype développé par les chercheurs suisses a été conçu en utilisant « un effet de champ géométrique » . La combinaison de ces deux matériaux a finalement abouti à la mise au point de nouveaux composants aux propriétés exceptionnelles, tant en matière de vitesse que de consommation électrique et de souplesse.

Article rédigé par Georges Simmonds pour RT Flash

Science Daily

|

|

|

|

|

|

|

|

|

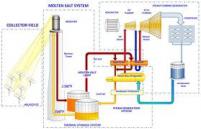

La construction de la plus grande centrale thermique solaire à concentration du monde vient de commencer dans le désert d'Abu-Dhabi.

Réalisée conjointement par les sociétés Masdar, Total et Abengoa Solar, cette centrale hors normes représente une superficie de 2,5 km2, soit pas loin de 300 terrains de football, et devrait produire suffisamment d'électricité pour satisfaire à la consommation de 20 000 foyers des Émirats arabes unis. À terme, cette centrale devrait également permettre une réduction des émissions de CO2 de 175 000 t par an, soit l'équivalent des émissions annuelles de 15 000 voitures.

Cette centrale géante n'utilise pas la technique photovoltaïque mais la technologie thermodynamique. Elle a opté pour une technique prometteuse, la voix cylindro-parabolique. Le principe consiste à récupérer la chaleur fournie par le rayonnement solaire direct vers des tuyaux remplis d'huile de synthèse.

Cette chaleur est utilisée sous forme de vapeur qui entraîne une turbine et produit ainsi de l'électricité. Mais dans cette technologie, la vapeur est compressée lorsqu'elle entre dans la turbine, ce qui accroît considérablement le rendement de conversion énergétique. Autre innovation majeure, cette centrale utilise un système de refroidissement à faible consommation d'eau, ce qui constitue un atout décisif dans cette région désertique.

Dernier avantage, la forte production électrique de cette centrale permettra aux Émirats arabes unis d'avoir recours aux générateurs gourmands en énergie nécessaires pour surmonter les périodes de pics de consommation.

Les Émirats arabes unis ont lancé un plan très ambitieux de développement des énergies renouvelables et comptent investir plus de 100 milliards de dollars d'ici 2032 pour se doter d'une capacité de production de 41 000 MW (soit un tiers de leur production électrique totale) issue de l'énergie solaire.

Article rédigé par Georges Simmonds pour RT Flash

NPR

|

|

|

|

|

|

|

|

|

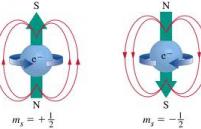

Voici une expérience qui n'a pas fini de faire parler d'elle. Des chercheurs canadiens de l'université d'Ottawa ont réussi pour la première fois à mesurer directement les états de polarisation d'un photon, c'est-à-dire les axes autour desquels oscillent les champs électromagnétiques.

Dans cette expérience, les physiciens ont pu mesurer simultanément les variables conjuguées d'une particule, ce qui remet en cause le fameux principe d'indétermination d'Heisenberg, énoncé en 1927, et qui constitue avec la fonction d'onde Schrödinger, un des piliers théoriques de la mécanique quantique.

Selon ce principe, la nature se comporterait intrinsèquement en appliquant la règle des « vases communicants ». Concrètement, cela signifie que si l'on mesure avec une grande précision l'une des propriétés d'un système quantique, on ne pourra pas mesurer l'autre avec le même degré de précision. Par exemple, on pourra mesurer avec une absolue précision la position d'une particule mais, dans ce cas, on ne connaîtra pas exactement sa vitesse ou si l'on mesure précisément sa vitesse, on ne pourra pas connaître sa position exacte.

Mais dans cette expérience, les physiciens ont montré qu'il était possible, sous certaines conditions, de mesurer directement les variables conjuguées d'un système quantique. Comme le souligne le professeur Boyd, qui dirige ces recherches, « le fait de pouvoir réaliser des mesures directes de l'état ondulatoire quantique aura des conséquences majeures pour l'avenir de l'informatique quantique ».

Toute la finesse de cette expérience réside dans la méthode utilisée pour ne pas perturber le système quantique. En fait, les physiciens procèdent d'abord à une mesure « faible » de la première propriété, puis à une mesure « forte » de la deuxième propriété.

La seule contrainte de cette méthode réside dans le fait que très peu d'informations sont obtenues à chaque mesure, ce qui oblige les physiciens à multiplier les expérimentations pour obtenir un résultat statistiquement significatif.

Dans cette expérience, les chercheurs ont exposé deux cristaux à un faisceau de lumière polarisée. Le premier, d'une épaisseur très fine, a permis d'obtenir des mesures faibles sur la polarisation verticale ou horizontale, alors que le second, beaucoup plus épais, a permis d'obtenir des mesures fortes sur la polarisation diagonale.

Grâce à ce dispositif habile, la première mesure faible perturbe si peu le système qu'elle n'invalide pas la deuxième mesure. Au final, il suffit de répéter plusieurs fois l'expérience pour obtenir un résultat statistique valide et une description physique complète des états de la lumière. L'expérience a été réalisée plusieurs fois pour permettre des statistiques précises. En ajoutant tous ces résultats, on peut caractériser complètement et directement les états de la lumière.

Article rédigé par Gaël Orbois pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

La réalisation de réseaux et d'ordinateurs quantiques est l'un des plus grands défis de la physique moderne.

Le nombre de transistors sur un microprocesseur continue à doubler tous les deux ans, conformément aux prédictions de Gordon Moore, faites il y a presque 50 ans. Mais cette course à la miniaturisation risque d'atteindre ses limites d'ici une dizaine d'années en se heurtant aux lois de la physique.

Pour surmonter ce défi, de nombreuses équipes de recherche tentent de mettre au point les composants et systèmes qui permettront de réaliser un ordinateur quantique qui ne manipulera plus des bits mais des qbits, pouvant prendre plus de deux états à la fois, ce qui permettra un bond phénoménal en termes de rapidité et de puissance de calcul.

Mais le chemin qui mène au Graal que représente l'ordinateur quantique est semé d'embûches et suppose que de nombreux obstacles mathématiques et physiques soient levés. Parmi ces freins à l'informatique quantique, on trouve le phénomène de décohérence qui se manifeste par la perte brutale, dans certaines conditions physiques, des propriétés quantiques des photons utilisés pour les calculs.

La production de qbits passe par l'émission de photons uniques et stables qui conservent leurs propriétés quantiques et n'entrent pas en décohérence. Pour relever ce défi, des chercheurs britanniques du laboratoire Cavendish à Cambridge ont mis au point une nouvelle technique pour produire des photons uniques par fluorescence de résonance.

En opérant de cette façon, la décohérence des photons peut être évitée et les chercheurs ont pu quantifier le degré de similarité de ces photons et vérifier qu'ils étaient parfaitement identiques en termes de cohérence de la fonction d'onde.

Comme le souligne le Docteur Mete Atature, qui dirige ces recherches, "Nous sommes sur le point de pouvoir produire un taux élevé de photons uniques, d'une qualité identique à ce produit par un laser mais avec l’avantage supplémentaire de présenter une fonction d'onde cohérente programmable".

Selon cette étude, la voie est à présent ouverte vers le contrôle de l'intrication et de la téléportation quantiques, ce qui devrait déboucher d'ici quelques années sur les premières machines quantiques opérationnelles.

Article rédigé par Gaël Orbois pour RT Flash

Phys org

|

|

|

|

|

|

|

|

|

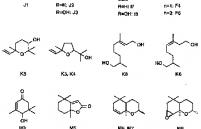

Le succès des voitures électriques passe par des innovations dans le domaine des composés constituant les batteries (électrode, anode et cathode). Les chercheurs traquent de nouveaux matériaux et alliages de plus en plus performants mais également moins chers, moins polluants et d'une grande fiabilité.

Dans cette perspective, des chercheurs de l’équipe « Design et étude de nouveaux matériaux à propriétés remarquables » de l’IMPMC, en collaboration avec le Laboratoire de Chimie et Réactivité du Solide (LRCS, Amiens) et l’EMAT (Anvers, Belgique), ont identifié une nouvelle famille de composés de formule analogue au fluorosulfate, en remplaçant l’anion F par un groupement hydroxyle OH.

Au grand étonnement de ces scientifiques, cette nouvelle classe de composés se caractérise par un arrangement des atomes totalement différent du fluorosulfate de fer. Cette structure atomique a pu être révélée en combinant des technologies de pointe : diffraction de rayons X couplées à des données de diffraction de neutrons (Institut Laue Langevin, Grenoble) pour localiser les atomes légers (Li, H).

Les atomes de métal sont entourés d’atomes d’oxygène en agencement octaédrique, qui forment des couches d’octaèdres liées par les arêtes et par les sommets. Ces couches sont ensuite empilées et les atomes de lithium s’insèrent entre elles. Un octaèdre est un polyèdre à huit faces.

Ces composés LiMSO OH, grâce à leur structure en lamelles, ont des propriétés spécifiques qui en font d'excellents matériaux de cathode. Ces matériaux pourraient en outre trouver d'autres applications dans de nombreux secteurs industriels grâce à leurs propriétés remarquables.

Article rédigé par Georges Simmonds pour RT Flash

JACS

|

|

|

|

|

|

|

|

|

Transatomic, une spin-off du MIT, travaille sur un nouveau type de "micro-réacteur nucléaire" qui pourrait réduire de moitié le coût global d'une centrale nucléaire, tout en améliorant sensiblement sa sécurité. Ce réacteur à sels fondus est particulièrement sûr et, compte tenu de ses caractéristiques physiques et de son mode de fonctionnement, il pourrait être construit à moindre coût en usine et transporté par rail, au lieu d'être construit sur site.

Les coûts élevés des centrales nucléaires classiques, ainsi que les préoccupations quant à la sécurité et à l'élimination des déchets, ont largement bloqué la construction de nouvelles centrales nucléaires aux États-Unis et dans d'autres pays du monde, surtout depuis la catastrophe de Fukushima.

Néanmoins, plusieurs entreprises tentent de résoudre la question des coûts en développant de petits réacteurs modulaires qui peuvent être construits "à la chaîne", en usine. Mais ces "Mini-réacteurs" ne peuvent pas avoir une puissance supérieure à 200 mégawatts d'électricité, alors que les réacteurs conventionnels dépassent les 1 000 mégawatts.

Transatomic assure qu'il est en mesure de construire une centrale nucléaire de 500 mégawatts pour 1,7 milliard de dollars, soit environ la moitié du coût par mégawatt des centrales conventionnelles. Russ Wilcox, directeur général de Transatomic, estime qu'il faudra huit ans et 200 millions de dollars pour construire un prototype de réacteur à sel fondu.

Ce nouveau type de réacteur est moins coûteux non seulement parce qu'il peut être construit en usine mais aussi parce qu'il est intrinsèquement sûr et fonctionne à la pression atmosphérique normale et non à haute pression, comme les réacteurs classiques.

Une centrale nucléaire classique est refroidie avec de l'eau qui bout à une température bien inférieure à celle du cœur qui peut atteindre les 2 000°C. Même après son arrêt, un réacteur classique doit être refroidi en permanence avec de l'eau et c'est cette contrainte qui a provoqué tant de problèmes à Fukushima, en raison notamment de la défaillance des pompes de secours.

L'utilisation de sel fondu comme fluide de refroidissement permet de résoudre en grande partie ces problèmes. Le sel fondu présente un point d'ébullition nettement plus élevé que l'eau et, si le réacteur commence à chauffer, le sel se dilate automatiquement et fait baisser la température.

Même en cas de panne complète d'alimention électrique, une butée au fond du réacteur permet l'écoulement du combustible et du sel fondu dans un réservoir de retenue qui entraîne l'arrêt spontané des réactions. Cette sécurité passive intrinsèque constitue l'un des points forts de ce type de réacteur nucléaire.

Transatomic a également conçu son réacteur de manière à pouvoir produire des neutrons rapides, ce qui permet de brûler plus complètement les déchets radioactifs. Alors qu'un réacteur classique produit environ 20 tonnes de déchets très radioactifs par an, qu'il faut stocker pendant 100.000 ans, le réacteur de 500 mégawatts de Transatomic produira seulement 250 kilos de déchets par an qui devront être stockés pendant seulement quelques centaines d'années.

Article rédigé par Georges Simmonds pour RT Flash

MIT Technology Review

|

|

|

|

|

|

|

|

|

Après plusieurs années de recherche, des chercheurs japonais ont annoncé avoir réussi, pour la première fois, à extraire des fonds sous-marins du gaz d'hydrates de méthane et cette avancée majeure est sans doute le signe d'une nouvelle révolution énergétique.

Le Ministre japonais de l'Industrie, Toshimitsu Motegi, a souligné : "Notre ambition est de fiabiliser ces technologies d'extraction et d'exploitation dans le but de parvenir rapidement à une exploitation commerciale, bien que, sur un plan technique, la production industrielle de gaz d'hydrates de méthane est plus complexe que celle du gaz de schiste."

Ce projet-pilote a été réalisé à environ 80 kilomètres au large de la péninsule d'Atsumi dans les eaux de la préfecture d'Aichi (centre-sud). L'expérience a eu lieu à 330 mètres sous le plancher océanique, profond de 1.000 mètres. La technique utilisée consiste à provoquer une chute de pression pour récupérer le gaz, emprisonné sous forme de glace cristallisée, grâce aux conditions de forte pression et de basse température.

Les fonds sous-marins des eaux territoriales japonaises recéleraient de grosses quantités d'hydrates de méthane car ces composés sont surtout présents dans les lieux à forte sismicité. Selon certaines estimations, au total, le Japon en détiendrait pour un siècle ou plus de consommation, alors qu'il est jusqu'à présent dépendant de l'étranger et contraint d'importer 95 % de son énergie. Les achats de gaz du Japon ont en outre augmenté ces deux dernières années, du fait de l'arrêt de la quasi intégralité de ses 50 réacteurs nucléaires après la catastrophe de Fukushima.

Cette situation est considérée comme économiquement intenable par l'actuel gouvernement qui veut relancer les centrales atomiques mais se heurte à une opposition de plus en plus vive et organisée de la part de la population. Les hydrates de méthane ont été découverts il y a plus de deux siècles mais n'ont jamais été exploités, à cause des obstacles techniques considérables à surmonter.

Mais, depuis depuis 2001, le gouvernement japonais a lancé un programme ambitieux visant à rendre possible l'exploitation massive des hydrates de méthane océaniques d'ici 2019. Le gaz extrait des hydrates de méthane est en théorie adapté au transport sur de longues distances et pourrait à terme concurrencer le gaz naturel liquéfié, mais également le gaz de schiste.

Le Ministère de l'Industrie prévoit à présent d'extraire plusieurs dizaines de milliers de mètres cubes de gaz au cours des prochaines semaines.

Les hydrates de méthane constituent la plus grande réserve d'hydrocarbures dans la croûte planétaire et représenteraient une ressource énergétique potentielle supérieure à celle constituée par l'ensemble des réserves de pétrole, de gaz et de charbon réunies. Rien que dans les eaux territoriales américaines, les hydrates de méthane représenteraient plus de 1000 ans de production gazière.

Article rédigé par Georges Simmonds pour RT Flash

CFP

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Selon une étude publiée dans les actes de l'Académie américaine des science et réalisée par Aslak Grinsted, chercheur à l'Institut Niels Bohr de Copenhague, le réchauffement prévisible de 2°C de la température mondiale pourrait multiplier par 10 d'ici la fin de ce siècle le nombre des ouragans extrêmement dévastateurs comme Katrina.

Ces travaux soulignent que, même si la température n'augmente que d'un degré, la fréquence de ce type d'ouragan sera multipliée par trois. « Concrètement, cela signifie qu'il y aura un ouragan de la puissance de Katrina tous les deux ans et non pas tous les 20 ans comme actuellement » précise Aslak Grinsted. L'ouragan Katrina qui a dévasté la Nouvelle-Orléans en 2005 a été la catastrophe naturelle la plus coûteuse dans l'histoire des États-Unis.

D'autres travaux ont montré qu'il y avait une forte corrélation entre l'augmentation de la fréquence des tempêtes tropicales et l'accélération du réchauffement climatique planétaire. « L'accélération du réchauffement de la terre au cours du siècle dernier a été telle que nous avons déjà dépassé la médiane qui sépare la moitié des ouragans entrant dans la catégorie de Katrina et attribuables au réchauffement, de l'autre moitié liée à des causes naturelles.

L'étude souligne également que le niveau des océans va monter avec le réchauffement qui entraîne une fonte accélérée des glaces polaires, surtout dans l'Antarctique. Cette augmentation du niveau des mers va alimenter une boucle de rétroaction positive qui va venir amplifier la puissance des ouragans, directement liée au niveau de chaleur présent à la surface de l'océan.

Article rédigé par Gaël Orbois pour RT Flash

PNAS

|

|

|

|

|

|

|

|

|

Les forêts tropicales représentent 1,7 milliard d'hectares au niveau mondial et jouent un rôle-clé dans la régulation du climat mondial et la lutte contre le réchauffement planétaire. Ces forêts captent chaque année au moins 20 % des émissions de CO2 dues à l'homme et stockeraient environ 470 milliards de tonnes de CO2 dans leur biomasse et leur sol, soit l'équivalent de 15 années d'émissions mondiales de CO2.

En 2009, une étude internationale avait montré qu'un tiers de la forêt amazonienne risquait de disparaître d’ici la fin du siècle si les températures mondiales augmentaient de 2°C, ce qui semble plus que probable.

Une nouvelle étude réalisée par le Centre britannique pour l’Ecologie et l’Hydrologie vient de montrer que la forêt tropicale amazonienne avait moins de risque de disparaître. Pour parvenir à cette conclusion, des scientifiques de Grande-Bretagne, des Etats-Unis, d’Australie et du Brésil, ont utilisé des simulations informatiques basées sur 22 modèles climatiques pour étudier la réaction des forêts tropicales aux Amériques, en Afrique et en Asie, au réchauffement climatique.

Un seul de ces modèles, celui du Met Office's Hadley Centre, prévoit une réduction de la biomasse des forêts tropicales d’ici la fin du siècle, mais uniquement en Amazonie.

« Ces nouveaux résultats suggèrent que les forêts tropicales pourraient être relativement résistantes au réchauffement mais il est aussi important de se souvenir que d’autres facteurs non inclus dans cette étude, tels que les incendies et la déforestation, affecteront aussi le carbone stocké dans les forêts tropicales » souligne le co-auteur de l’étude, David Galbraith.

Article rédigé par Gaël Orbois pour RT Flash

Nature

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Un traitement expérimental qui modifie génétiquement les propres cellules immunitaires du patient a permis d'obtenir des résultats très encourageants dans le traitement de la leucémie lymphoblastique aiguë, une forme de leucémie presque toujours fatale. « Nous n'aurions jamais espéré pouvoir obtenir des résultats aussi remarquables et aussi rapides » a déclaré le docteur J. Renier Brentjens qui dirige cet essai au fameux Memorial Sloan-Kettering Cancer Center.

Il s'agit d'un traitement expérimental qui n'a été pour l'instant utilisé que chez un petit nombre de patients et qui, malheureusement, ne fonctionne pas chez tous les malades. Les spécialistes s'accordent à reconnaître que cette approche est très prometteuse dans le traitement de plusieurs types de cancers, les cancers du sang mais également certaines tumeurs comme celle de la prostate.

Ce traitement expérimental est similaire à celui qui a permis de sauver récemment la vie d'une petite fille de sept ans, Emma Whitehead, et dont les médias se sont largement faits l'écho.

C'est le même type de traitement qui a été essayé pour la première fois chez des malades adultes atteints comme Emma d'une leucémie lymphoblastique aiguë. Ce type de cancer du sang est beaucoup plus grave chez les adultes que chez les enfants, avec un taux de guérison qui ne dépasse pas 40 % contre plus de 80 % pour les enfants.

Heureusement, il s'agit d'une maladie relativement rare qui touche environ 5000 personnes par an aux États-Unis. "Chez les adultes, ce type de leucémie est une maladie dévastatrice", souligne le docteur Michel Sadelain, l'auteur principal de cette étude.

En général, les patients traités par chimiothérapie rechutent au bout de quelques mois mais, sur les cinq qui ont bénéficié de ce nouveau traitement, trois sont toujours en rémission au bout de deux ans.

Le traitement mobilise les propres cellules T du patient, un type de globule blanc qui combat normalement les cellules cancéreuses. Le sang du patient est traité par une machine qui extrait les cellules T et ces cellules sont ensuite génétiquement modifiées. Ainsi reprogrammées, ces cellules T deviennent capables de reconnaître et de tuer les cellules malignes porteuses d'une protéine spécifique qui les identifie. "Je suis persuadé que cette avancée marque le début d'une révolution thérapeutique qui va transformer la vie des malades" ajoute avec enthousiasme le Docteur Sadelain.

Article rédigé par Georges Simmonds pour RT Flash

The New York Times

|

|

|

|

|

|

|

|

|

Les chercheurs britanniques du King College de Londres, dirigés par Paul Sharpe, ont mis au point une technique qui pourrait permettre à terme la production de dents transgéniques.

Les scientifiques ont réussi à isoler puis à mettre en culture des cellules épithéliales provenant des tissus constitutifs d’une gencive saine d’un de leurs patients. Ils ont ensuite combiné ces cellules épithéliales à des cellules mésenchymateuses, une famille de cellules-souches multiples présente dans l'embryon et pouvant se différencier en différents types de tissus.

Dernière étape : les chercheurs ont transplanté cette combinaison cellulaire chez des souris. Ils ont alors pu observer au bout de quelques semaines l'apparition d'excroissances similaires à des dents et intégrant les cellules humaines et des cellules de souris. Forte de ce succès, cette équipe va poursuivre ses recherches en utilisant des cellules mésenchymateuses humaines adultes pour essayer de produire des dents absolument identiques, d'un point de vue biologique, aux dents naturelles.

La possibilité de produire des dents avec leurs racines serait un grand pas en avant en matière de chirurgie dentaire et permettrait de remplacer définitivement les dents manquantes ou endommagées sans avoir recours à des implants dentaires.

Article rédigé par Georges Simmonds pour RT Flash

JDR

|

|

|

|

|

|

|

|

|

On savait déjà depuis quelques années, grâce à de multiples études convergentes, que la consommation régulière de thé vert et de café était bénéfique pour la santé, notamment en matière de prévention cardio-vasculaire, de diabète, d'hypertension et de protection contre certains cancers.

Cette fois, des chercheurs japonais, du Centre national japonais d'études cardio-vasculaires et cérébrales d'Osaka, dirigés par Yoshihiro Kokubo, ont voulu évaluer les effets protecteurs de consommation régulière de café et/ou de thé vert sur les accidents vasculaires cérébraux.

Pour réaliser cette étude, les chercheurs ont suivi pendant 13 ans plus de 80000 Japonais âgés de 45 à 69 ans et ne présentant aucune pathologie au début de l'étude. Après examen des causes de décès et de la distribution des différentes maladies apparues chez ces sujets, les scientifiques japonais, qui ont également tenu compte des différents facteurs de risque, ont montré que les sujets qui avaient consommé au moins une tasse de café par jour avaient un risque d'AVC réduit de 20 % par rapport à ceux qui buvaient rarement du café.

Ce travail a également montré que les personnes qui buvaient deux à trois tasses de thé vert par jour réduisaient leur risque d'AVC de 14 %. Quant à ceux jouant sur les deux tableaux en buvant à la fois du thé et du café, ils voyaient leur risque d'accident vasculaire cérébral diminué de 32 %.

Selon cette étude, il semble que le niveau de protection soit directement proportionnel au nombre de tasses de ces deux boissons consommées quotidiennement. Néanmoins, les chercheurs soulignent qu'il n'est pas souhaitable, dans l'état actuel des connaissances, de boire plus de six tasses par jour de thé et de café et que la consommation régulière de ces deux breuvages ne dispensait en aucun cas d'observer une bonne hygiène de vie et d'avoir de bonnes habitudes alimentaires.

Article rédigé par Georges Simmonds pour RT Flash

Shine

Stroke

|

|

|

|

|

|

|

|

|

Depuis une dizaine d'années, les biologistes du monde entier sont à la recherche des gènes qui contrôlent la longévité humaine. De nombreux gènes associés à la longévité ont déjà été identifiés et le plus étonnant c'est que la plupart de ces gènes sont communs à de nombreuses espèces vivantes.

En 2011, des chercheurs du Laboratoire de biologie moléculaire de la cellule, à Lyon ont révélé, à partir du ver nématode, l'un des mécanismes moléculaires fondamentaux impliqués dans le vieillissement et ont identifié un gène qui joue un rôle clé dans la longévité, le nhr-80.

En 2012, une étude américaine portant sur le génome d'un grand nombre de centaines de centenaires a montré que 130 gènes au moins étaient impliqués dans la longévité. Mais parmi ceux-ci, le gène APOE semble statistiquement déterminant dans la grande longévité.

Il y a quelques semaines, des chercheurs allemands de l'université Christian Albrecht et de l'Hôpital universitaire de Kiel ont montré pour leur part qu'un gène baptisé FoxO semble lui aussi jouer un rôle clé dans la longévité humaine et animale.

Pour arriver à ces conclusions, ces chercheurs ont travaillé sur des hydres d'eau douce et ont montré que celles-ci pouvaient garder pendant plusieurs décennies leur vitalité grâce à ce gène FoxO. D'autres études récentes chez des personnes centenaires ont par ailleurs montré que leur gène FoxO était particulièrement actif.

Article rédigé par Georges Simmonds pour RT Flash

Forschung und Wissen

|

|

|

|

|

|

|

|

|

Plus des trois quarts des maladies humaines nouvelles ou émergentes sont causées par des agents pathogènes provenant d'animaux, selon l'Organisation Mondiale de la Santé.

Jusqu'à présent, la théorie dominante généralement acceptée par les scientifiques était que l'augmentation de la biodiversité était corrélée avec une réduction des risques de ces agents pathogènes. Cette théorie reposait sur l'hypothèse que le risque de transmission de maladies à l'homme diminuait à mesure que la variété des espèces augmentait.

Selon cette théorie, une tique a plus de chances de transmettre à l'homme la maladie de Lyme si cet insecte a déjà eu de nombreux contacts avec d'autres animaux porteurs de la maladie de Lyme. Cette théorie postule que si la tique est en contact avec une grande variété d'espèces différentes, sa probabilité d'être infectée et de propager ensuite la maladie de Lyme, diminue.

Afin d'essayer de vérifier cette hypothèse, des chercheurs du département de la santé publique de Californie ont réalisé une méta-analyse des études qui évaluent les liens entre la biodiversité des hôtes et le risque de maladie pour les agents pathogènes qui infectent les humains. Les résultats ce travail révèlent qu'en fait il n'existe qu'un lien très faible entre l'augmentation la biodiversité et la réduction du risque de transmission de maladies de l'animal à l'homme. Les chercheurs ont constaté, qu'en réalité, les liens entre la biodiversité et la prévalence des maladies sont variables et dépendent de l'interaction de nombreux facteurs : nature de la maladie, système écologique local et situation économique et sociale des personnes concernées.

Ces recherches montrent que l'argument qui consiste à dire qu'il faut absolument préserver la biodiversité des écosystèmes naturels pour réduire le risque de transmission de maladies à l'homme est à la fois simpliste et inexacte du point de vue scientifique.

L'étude précise que "un contrôle plus efficace des «zoonoses» (maladies transmises par les animaux aux humains) passe par une compréhension plus fine des voies et mécanismes par lesquels ces agents pathogènes sont transmis". Plus précisément, les auteurs de ce travail recommandent aux chercheurs de se focaliser davantage sur la façon dont le risque de maladie évolue en fonction des caractéristiques des espèces et des mécanismes écologiques.

Cette étude invite également les scientifiques à analyser les données sur la prévalence et la densité des infections chez les animaux hôtes, de manière à mieux établir les liens de causalité entre les facteurs de risque de maladie (tels que les taux d'infection chez une espèce considérée) et les taux d'infection retrouvés au sein d'une population humaine géographiquement délimitée.

Article rédigé par Georges Simmonds pour RT Flash

Université de Stanford

|

|

|

|

|

|

|

|

|

Des chercheurs japonais, en analysant la concentration de 26 éléments se retrouvant dans le cuir chevelu de 1 967 enfants autistes (dont trois quarts de garçons et un quart de filles) âgés entre 0 et 15 ans, ont constaté que la moitié des enfants souffrant de troubles autistiques était atteints d’une déficience importante en zinc entre la naissance et l'âge de trois ans, cette déficience ayant ensuite tendance à se réduire progressivement.

Selon ces travaux, il pourrait donc y avoir un lien entre une carence précoce en zinc et le risque de développement de troubles autistiques. L'origine de ce lien serait à chercher dans la génomique : l'insuffisance de zinc pendant cette période essentielle du développement entraînerait une modification dans l'expression de certains gènes (restant à identifier) et pourrait alors augmenter sensiblement les risques d'autisme chez les enfants prédisposés génétiquement à développer cette grave pathologie mentale.

L'observation des chercheurs japonais est d'autant plus intéressante qu'elle confirme d'autres études qui avaient déjà constaté un lien troublant entre une carence en zinc dans la petite enfance et l'incidence de certains types de troubles du comportement, tels que le déficit de l’attention avec hyperactivité (TDAH).

De manière cohérente, ces études avaient également montré qu'une supplémentation appropriée en zinc avait un effet thérapeutique bénéfique dans le traitement des enfants hyperactifs, impulsifs ou souffrant de phobies sociales.

Il reste cependant à élucider le mécanisme d'action du zinc. On sait toutefois que cet élément joue un rôle important dans la synthèse de certaines protéines et qu'il intervient dans le mode d'expression de certains gènes. En outre, le zinc est également impliqué dans les processus de croissance cellulaire et de réparation des tissus.

Les résultats de ces travaux ouvrent la voie vers des nouveaux outils de prévention et de traitement pour les jeunes enfants atteints d’autisme. Il est par exemple possible qu'une supplémentation en zinc, dès l’apparition des premiers symptômes de l'autisme chez l'enfant, puisse, en association éventuelle avec la prise de certaines vitamines et hormones, ralentir ou même bloquer le développement de cette lourde pathologie du comportement.

Article rédigé par Elisa Tabord pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

Chaque année, un million de nouveaux cas de cancers du sein sont enregistrés au niveau mondial, ce qui fait de ce cancer le plus diagnostiqué au monde.

Des chercheurs de l’université d'État du Dakota du Sud, associés à des chercheurs sud-coréens, ont développé un nouvel outil utilisant la tomographie à micro-ondes (microwave tomography imaging) qui permet la détection d’une tumeur cancéreuse par radiations aux micro-ondes. Cette technologie présente notamment l'avantage de pouvoir détecter la présence de tumeurs chez des femmes ayant un forte densité de tissus mammaires. En outre, la TMI coûte vingt fois moins cher que l’imagerie par résonance magnétique (IRM).

Ces scientifiques ont réussi à améliorer les performances de la TMI en concevant un programme informatique original. Celui-ci permet la comparaison automatique des images obtenues par TMI avec plus de 100.000 images par IRM provenant des dossiers d'autres patientes atteintes par un cancer du sein. Le logiciel est capable de trouver les images IRM les plus proches de celles réalisées par micro-ondes, ce qui permet ensuite à l'équipe soignante d'accéder rapidement aux dossiers médicaux des patientes présentant une tumeur similaire et de définir une stratégie thérapeutique adaptée.

Shin souligne que l'efficacité de cette méthode dépend de la qualité de l'image produite. Actuellement, la machine TMI utilise une fréquence de trois gigahertz, ce qui expose les patientes à moins de radiations électromagnétiques qu'un téléphone mobile. D'ici l'année prochaine, les chercheurs passeront à une machine à 6 gigahertz permettant des images bien plus précises.

"La TMI représente le chaînon manquant parfait entre la mammographie et l'IRM et nous devons exploiter toutes les potentialités de cette technique à faible impact radiatif pour les malades ", souligne Wang.

Article rédigé par Georges Simmonds pour RT Flash

SDSU

|

|

|

|

|

|

|

|

|

Des chercheurs de l'Université du Maryland ont identifié une protéine, issue de la morue du Pacifique, qui possède la capacité de bloquer la formation de métastases dans un certain nombre de cancers.

"L'utilisation thérapeutique de produits naturels et diététiques ayant une activité anti-tumorale est devenue un domaine important de la recherche médicale", explique l'auteur principal de ces recherches, le professeur Hafiz Ahmed qui ajoute "Comprendre comment agissent ces composants au niveau cellulaire et moléculaire pourrait nous permettre de concevoir des préparations alimentaires qui pourraient directement être utilisées pour lutter contre le cancer et stimuler le système immunitaire".

Cette étude a démontré que le glycopeptide TFD de la morue pouvait bloquer le cancer de la prostate. Le TFD (Thomsen-Friedenreich disaccharide) antigène de la protéine du poisson est présent à la surface des cellules cancéreuses et jouerait un rôle clé dans la propagation du cancer.

Les poissons des mers froides, comme la morue, possèdent des glycoprotéines riches en antigène TFD, qui les protègent contre le gel. L'équipe de recherche a développé une forme particulière de TFD, appelé TFD100, purifiée à partir de la morue du Pacifique.

En utilisant des modèles animaux, les chercheurs ont constaté que le TFD100 se liait à la galectine-3, une protéine qui est surexprimée dans les cellules cancéreuses de la prostate. La Galectine-3 (GAL3) aide les cellules cancéreuses à échapper au système immunitaire et leur permet de se propager dans l'organisme.

"Dans la mesure où l'interaction GAL3-TFD est un facteur clé dans le déclenchement des métastases de nombreux cancers, la TFD100 constitue une voie thérapeutique prometteuse pour bloquer les métastases", conclut l'étude.

Ces recherches montrent qu'en association aux autres outils thérapeutiques, il est envisageable d'utiliser des compléments alimentaires spécifiquement élaborés pour prévenir traiter certains cancers.

Article rédigé par Georges Simmonds pour RT Flash

Eurekalert

|

|

|

|

|

|

|

|

|

Des chercheurs québécois dirigés par la professeure Nathalie Arbour du Centre de recherche du Centre hospitalier de l'Université de Montréal viennent d'élucider l'un des mécanismes fondamentaux impliqués dans la sclérose en plaques.

Ces scientifiques ont découvert, chez les malades atteints de sclérose en plaques, une concentration anormalement élevée d'un type particulier de cellules (CD4 T) qui exprime le NKG2C, une molécule qui provoque des lésions cérébrales.

Ces recherches ont mis à jour un mécanisme nouveau qui permet aux cellules CD4 T de cibler directement les cellules du cerveau spécifiquement présentes chez les malades atteints de sclérose en plaques.

Pour l'instant, il n'y a pas de traitement curatif contre cette maladie mais il existe certains médicaments qui permettent d'en ralentir l'évolution. Le problème est que ces traitements ne sont pas suffisamment ciblés et perturbent le fonctionnement du système immunitaire dans son ensemble, provoquant notamment des infections chez certains malades dont l'immunité est affaiblie.

Nathalie Arbour précise : « Nos travaux montrent qu'il est possible de surmonter ce problème car le NKG2C est spécifiquement exprimé par une catégorie de cellules CD4 T présentes uniquement chez les personnes atteintes de sclérose en plaques. Nous allons à présent tenter d'actionner de manière ciblée ce récepteur en visant uniquement les cellules impliquées dans le développement de cette pathologie neurodégénérative. »

Article rédigé par Georges Simmonds pour RT Flash

JOI

|

|

|

|

|

|

|

|

|

La vie vient-elle du fond des océans ou des profondeurs de la Terre ? Peut-être, si l'on en croit Robert Hazen, géophysicien à la Carnegie Institution à Washington et directeur d'un programme international visant à déterminer les quantités et mouvements du carbone contenu à l’intérieur de la Terre.

"Ce que j'ai appris depuis 20 ans, c'est qu'on trouve la vie partout, aussi bien à la surface du sol qu'à des kilomètres de profondeur, dans des environnements extrêmes où règnent des conditions de température et de pression peu propices au vivant. Il est vrai qu'en 4 milliards d'années, la vie a eu tout le temps de s'adapter aux pires conditions imaginables".

Depuis près de 20 ans, Robert Hazen et ses collègues débusquent inlassablement toutes sortes d'êtres vivants plus étonnants les uns que les autres. Ils ont ainsi trouvé au fond des océans, près des sources hydrothermales chaudes, d'étranges créatures souvent inclassables. Même dans les carottes provenant des forages les plus profonds réalisés, à plus de 6 km sous terre, les chercheurs ont trouvé des micro-organismes.

Selon Hazen, la vie aurait très bien pu apparaître dans les entrailles de la terre au fond des océans car on y trouve tous les composants nécessaires : eau et carbone notamment. Hazen a montré, dans une récente étude, que certains micro-organismes vivants dans des environnements extrêmes pouvaient parfaitement utiliser les sources d'hydrogène pour transformer le carbone en composants organiques.

Mais la vie n'est jamais à court d'imagination et Hazen a également découvert des micro-organismes qui savent produire du méthane pour extraire l'énergie dont ils ont besoin.

Comme le souligne Hazen « si la vie a pu se développer et se maintenir dans des environnements si hostiles, il n'est pas du tout impossible qu'elle puisse être présente dans notre système solaire, sur Mars par exemple ».

Article rédigé par Georges Simmonds pour RT Flash

Smithsonian

|

|

|

|

|

|

|

|

|

A l'occasion du 65e Congrès de l’American Academy of Neurology (San Diego), la firme pharmaceutique Orion Pharma a présenté un nouveau médicament qui semble avoir des effets protecteurs sur la mémoire dans le cas de maladie d’Alzheimer modérée.

Cette molécule, baptisée ORM-12741, cible un récepteur adrénergique (alpha-2C), impliqué dans la modulation des fonctions cérébrales en réponse au stress.

L'étude a impliqué 100 personnes atteintes de maladie d'Alzheimer à un stade modéré et qui ont reçu, soit deux doses par jour de 100 mg d' ORM-12741, soit un placebo.

A l'issue de cet essai, les chercheurs ont constaté que les patients prenant cette molécule n'avaient pas subi d'altération de leurs capacités mémorielles (une amélioration de 4 % aux tests a été enregistrée), alors que le groupe de patients sous placebo avait subi une dégradation de 33 % de ses fonctions de mémorisation.

Juha Rohou, l'un des chercheurs, a souligné l’intérêt thérapeutique de ORM-12741 qui cible une nouvelle voie de signalisation cérébrale.

Article rédigé par Georges Simmonds pour RT Flash

Alzheimer's Research

|

|

|

|

|

|

|

|

|

Des chercheurs américains de l'Université de Columbia, dirigés par Ritwij Kulkarni, ont montré que la fumée de cigarette favorise la formation de biofilms et leur adhésion aux cellules humaines.

Ces recherches ont utilisé des cultures de plusieurs souches de S. aureus à différentes concentrations de fumée de cigarette. Les chercheurs ont observé une formation de biofilm proportionnelle à la consommation de tabac des participants à cette étude. Les bactéries impliquées ont une affinité particulière avec la fibronectine humaine (une protéine de surface cellulaire qui contribue à l'adhésion cellulaire) ainsi qu'avec les cellules épithéliales pulmonaires.

Il semble donc que, sous l'effet du tabac, les bactéries sont capables d'envahir plus facilement les cellules humaines.

Ces recherches ont permis d'étudier les effets des différents composants de la fumée de cigarette sur de nombreuses espèces de bactéries isolées à partir des tissus sinusaux de patients atteints de sinusite chronique, fumeurs et non-fumeurs. Dans ce cas également, là encore, la fumée de cigarette agit comme un catalyseur pour produire la formation de biofilms pour toutes les espèces de bactéries.

Ces travaux démontrent, s'il en était besoin, que la fumée de cigarette provoque une destruction directe des cellules immunitaires et fait le lit des infections virales et bactériennes.

Article rédigé par Georges Simmonds pour RT Flash

EHP

|

|

|

|

|

|

|

|

|

Après trois ans de travail, des chercheurs français de l’Institut des neurosciences des systèmes de l’université d’Aix-Marseille (Inserm), ont mis au point une puce, dix fois plus fine qu’un cheveu, constituée de matériau organique et de transistors microscopiques, capable de capter et d’enregistrer l’activité électrique du cerveau. Cette puce, biocompatible, devrait permettre notamment d'étudier l’épilepsie et de la dépister plus facilement.

A l'origine, le but des chercheurs était de concevoir un nano-système pouvant être implanté directement dans le cerveau en perturbant le moins possible son activité, ce qui supposait notamment une avancée majeure en matière d'électrodes.

Pour relever ce défi, les chercheurs n'ont eu recours qu'à des matériaux biocompatibles et ont imaginé une puce constituée de matériaux organiques et de transistors microscopiques capables d’enregistrer les signaux électriques émis par les activités cérébrales. Comme le souligne Christophe Bernard, "Le saut technologique a été de remplacer le capteur par un amplificateur, ce qui a permis de gagner un facteur 10 en sensibilité, par rapport aux systèmes existants".

Ce nouvel outil sera très précieux pour progresser dans la recherche en neurosciences. Il devrait notamment être utilisé dans le cadre du Human Brain Project dont nous vous avons récemment parlé et pourrait également déboucher sur des interfaces cerveau-machine beaucoup plus performantes pour les personnes paralysées.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

Des chercheurs de l'Université de San Francisco ont découvert que les cellules T du système immunitaire étaient capables de communiquer leurs informations et de coordonner leur action un peu à la manière dont les abeilles partagent les informations sur les meilleures sources de miel.

"Dans la nature, chaque abeille va à la recherche d'une source de sucre, puis revient à la ruche et informe les autres abeilles des meilleurs emplacements, ce qui permet à la ruche de décider collectivement de la stratégie à adopter pour la collecte de cette précieuse denrée", souligne Matthew Krummel, qui dirige ces recherches.

Ce scientifique explique qu'il se passe à peu près la même chose dans notre organisme et que les cellules T sont capables de se rassembler et de se communiquer entre elles des informations essentielles au déclenchement d'une réponse immunitaire appropriée contre les pathogènes envahisseurs.

L'équipe du professeur Krummel a constaté que ces lymphocytes T, après avoir détecté des bactéries du virus, se "concertent" afin de se répartir les rôles et de préparer une riposte efficace.

Comme le souligne le professeur Krummel, "il s'agit d'une découverte très importante car elle éclaire d'un jour nouveau les mécanismes longtemps demeurés obscurs par lesquels les vaccins stimulent le système immunitaire. En effet, nous savions que ces vaccins étaient efficaces pendant des années mais nous ne savions pas encore pourquoi. Il semble que ce mode d'action coopérative des cellules T constitue une partie de la réponse à cette question fondamentale", ajoute le chercheur.

"Sans cette mémoire à long terme, les vaccins seraient inutiles", souligne le professeur Krummel qui ajoute que "l'organisme ne se souviendrait pas qu'il avait déjà été exposé à un agent pathogène particulier, comme la rougeole la diphtérie et serait alors incapable de le combattre".

Cette découverte fondamentale ouvre un vaste champ de recherche et de grandes perspectives thérapeutiques. On pourrait par exemple imaginer, en utilisant ce mécanisme subtil, de mieux combattre certaines maladies auto-immunes, comme le diabète ou le lupus en atténuant la réponse immunitaire excessive à l'origine de ces maladies graves.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

Selon une étude américaine, la vaccination contre la grippe saisonnière induit une population unique de cellules immunitaires appelées lymphocytes T et stimule le développement d'anticorps protecteurs contre la grippe. Bien que le vaccin antigrippal soit très ancien et concerne une large population, les biologistes n'ont toujours pas entièrement élucidé les mécanismes par lesquels cette vaccination permet une mobilisation efficace de notre système immunitaire.

Comprendre finement les cascades de réactions biologique et moléculaire qui permettent aux vaccins de stimuler la production d'anticorps permettrait de concevoir des vaccins encore plus efficaces et plus sûrs, notamment pour certaines populations à risque, comme les nourrissons et les personnes âgées.

Après avoir suivi deux groupes d'enfants et d'adultes pendant trois ans, cette équipe de recherche, dirigée par Salah Eddine Bentebibel, a découvert un sous-groupe spécifique de lymphocytes T qui apparaît dans le sang après vaccination contre la grippe. A ces cellules, qui expriment les trois marqueurs, CXCR5, CXCR3 et ICOS, se trouve associé le développement d'anticorps protecteurs contre la grippe.

Ces scientifiques ont également découvert que ces lymphocytes T agissaient en aidant les lymphocytes B à augmenter leur production d'anticorps. Le nombre de lymphocytes B dits « mémoires », contre la grippe, augmente en principe avec l'âge, sous l'effet des vaccinations et des expositions aux virus.

Ce mécanisme explique pourquoi les personnes âgées possèdent le plus souvent un réservoir important de lymphocytes B « mémoires » prêts à se mobiliser contre différents types de grippe.

Néanmoins, certaines personnes âgées sont incapables de développer une réponse anticorps protectrice après vaccination contre la grippe car elles ne parviennent pas à pouvoir produire ce groupe particulier de lymphocytes T exprimant les trois marqueurs.

Les chercheurs vont à présent essayer de comprendre le détail de ce mécanisme cellulaire subtil, de manière à pouvoir améliorer l'efficacité des vaccins existants.

Article rédigé par Georges Simmonds pour RT Flash

Science

|

|

|

|

|

|

|

|

|

Des chercheurs australiens, de l'Université de Nouvelles Galles du Sud, ont mis au point un test qui pourrait permettre dans certains cas de détecter, à l'aide d'une simple prise de sang, les tendances suicidaires chez certaines personnes.

Ce test repose sur la mesure de la concentration du taux d’acide quinoléique dans le sang. En effet, les suicidaires tendent à produire cette molécule neurotoxique - qui est déjà impliquée dans certains processus dégénératifs du cerveau, comme ceux de la maladie d’Alzheimer par exemple - de façon excessive.

Selon ces scientifiques, l'acide quinolinique perturbe la voie de signalisation des récepteurs neuronaux appelés NMDA, ce qui conduit à une excitation excessive des cellules du cerveau, se traduisant par un « débordement » émotionnel pouvant conduire à la dépression et au suicide.

Ces recherches ont montré qu'au-delà d'un certain niveau, l'acide quinolinique devient une neurotoxine pour le cerveau. « Nous avons élucidé le mécanisme et la molécule impliquée et nous devons à présent trouver un moyen simple de le tester », souligne le professeur Gilles Guillemin.

« Il y a de multiples facteurs qui influencent le comportement suicidaire et ce test sera donc plutôt un outil de confirmation de diagnostic destiné aux patients dépressifs », souligne pour sa part Bob Goldney, professeur en psychiatrie à l’université d’Adélaïde en Australie.

Article rédigé par Elisa Tabord pour RT Flash

Australian Times

|

|

|

|

|

|

|

|

|